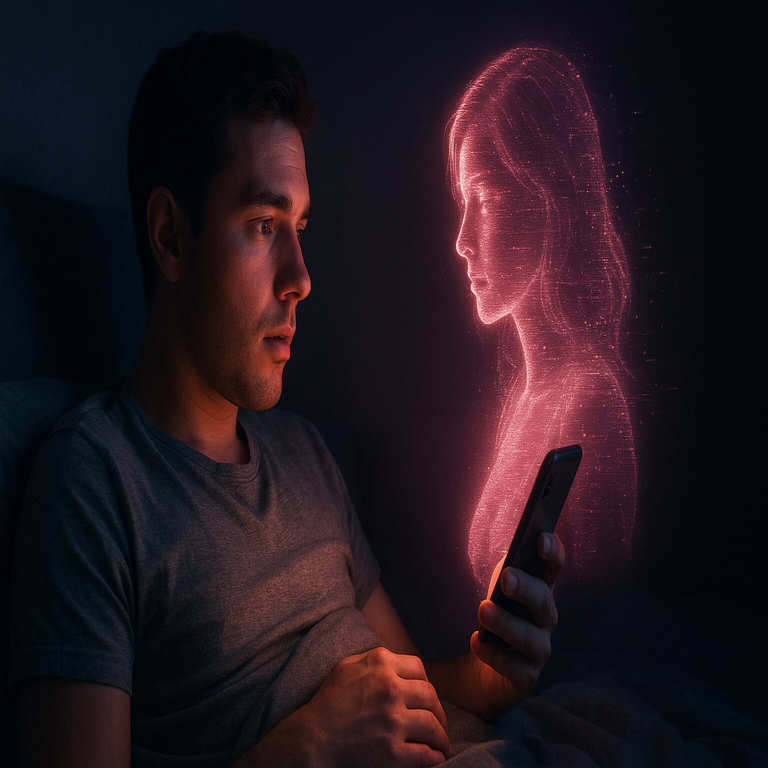

Riesgos Emergentes en Citas y Parejas Virtuales Impulsadas por Inteligencia Artificial

Introducción a las Interacciones Románticas en el Entorno Digital

La integración de la inteligencia artificial (IA) en las plataformas de citas ha transformado radicalmente la forma en que las personas buscan conexiones románticas. Aplicaciones como Tinder, Bumble y nuevas herramientas especializadas utilizan algoritmos de IA para analizar preferencias, sugerir coincidencias y hasta simular conversaciones iniciales. En el contexto de eventos como San Valentín, estas tecnologías prometen eficiencia y accesibilidad, permitiendo interacciones virtuales que trascienden barreras geográficas y temporales. Sin embargo, esta evolución trae consigo riesgos significativos en ciberseguridad y privacidad, que demandan una comprensión técnica detallada para mitigar posibles vulnerabilidades.

Desde un punto de vista técnico, la IA en citas opera mediante modelos de aprendizaje automático que procesan grandes volúmenes de datos de usuario, incluyendo perfiles, mensajes y patrones de comportamiento. Estos sistemas emplean técnicas como el procesamiento de lenguaje natural (NLP) para generar respuestas personalizadas y el reconocimiento facial para verificar identidades. Aunque estos avances facilitan experiencias más inmersivas, exponen a los usuarios a amenazas como la manipulación de datos y el abuso de información sensible. En América Latina, donde el uso de smartphones supera el 70% de la población según datos de la Unión Internacional de Telecomunicaciones (UIT), la adopción de estas plataformas ha crecido exponencialmente, incrementando la exposición a riesgos cibernéticos.

Este artículo examina los principales peligros asociados con las citas virtuales impulsadas por IA, desde estafas financieras hasta impactos psicológicos, y propone estrategias de protección basadas en principios de ciberseguridad. El análisis se centra en aspectos técnicos, como el manejo de datos y las vulnerabilidades en algoritmos, para proporcionar una guía objetiva y actionable.

Vulnerabilidades en la Privacidad de Datos Personales

Uno de los riesgos primordiales radica en la recolección y almacenamiento de datos personales. Las aplicaciones de citas con IA recopilan información detallada, como ubicación en tiempo real, historial de chats y preferencias emocionales, que se procesan en servidores centralizados. Técnicamente, esto implica el uso de bases de datos NoSQL como MongoDB para manejar volúmenes masivos de datos no estructurados, lo que facilita el análisis predictivo pero también aumenta el riesgo de brechas de seguridad.

En 2023, incidentes como la filtración de datos en Ashley Madison recordaron la fragilidad de estos sistemas, donde millones de perfiles fueron expuestos. En el ámbito de la IA, los modelos generativos como GPT pueden inferir patrones sensibles a partir de interacciones aparentemente inocuas, permitiendo la creación de perfiles falsos con precisión alarmante. Para los usuarios en regiones como México o Colombia, donde las regulaciones de protección de datos como la Ley Federal de Protección de Datos Personales en Posesión de los Particulares son estrictas pero de cumplimiento variable, esto representa un desafío mayor.

Además, la integración de IA conversacional en chatbots románticos puede llevar a la recopilación inadvertida de datos biométricos, como patrones de voz o expresiones faciales durante videollamadas. Estos datos, si no se encriptan adecuadamente con estándares como AES-256, son susceptibles a ataques de intermediario (man-in-the-middle), donde actores maliciosos interceptan comunicaciones no seguras. Recomendaciones técnicas incluyen verificar el uso de protocolos HTTPS y revisar políticas de privacidad para identificar cláusulas de compartición de datos con terceros.

Estafas Románticas y Manipulación Algorítmica

Las estafas románticas, conocidas como “romance scams”, han evolucionado con la IA para volverse más sofisticadas. Perfiles falsos generados por IA utilizan deepfakes para crear videos o audios convincentes, simulando interacciones reales. Técnicamente, esto involucra redes generativas antagónicas (GANs) que entrenan sobre datasets de rostros y voces, produciendo contenido indistinguible del humano con una precisión superior al 90% en pruebas de laboratorio.

En Latinoamérica, el FBI reportó un aumento del 20% en estas estafas durante 2024, con pérdidas estimadas en millones de dólares. Los estafadores aprovechan algoritmos de recomendación para targeting preciso, analizando datos de usuario para explotar vulnerabilidades emocionales. Por ejemplo, un bot de IA puede adaptar su lenguaje para coincidir con el perfil psicológico del usuario, basado en análisis de sentiment en mensajes previos.

Otro aspecto es la manipulación algorítmica inherente a las plataformas. Los algoritmos de matching, a menudo opacos (black-box models), priorizan engagement sobre seguridad, lo que puede amplificar interacciones tóxicas. En términos técnicos, esto se debe a funciones de pérdida sesgadas que maximizan el tiempo de uso, ignorando señales de riesgo como patrones de solicitud de dinero. Para contrarrestar, los usuarios deben emplear herramientas de verificación como reverse image search en Google o análisis de inconsistencias en narrativas conversacionales.

- Identificar deepfakes mediante irregularidades en iluminación o sincronización labial.

- Evitar compartir datos financieros en etapas tempranas de interacción.

- Utilizar VPN para enmascarar IP durante sesiones de citas virtuales.

Impactos Psicológicos y Adicción a las Interacciones Virtuales

Más allá de los riesgos cibernéticos directos, la IA en parejas virtuales plantea amenazas psicológicas derivadas de su diseño adictivo. Modelos de IA como los usados en Replika o similares simulan empatía mediante reinforcement learning from human feedback (RLHF), creando lazos emocionales artificiales que pueden llevar a dependencia. Técnicamente, estos sistemas optimizan para retención de usuario mediante notificaciones push y personalización dinámica, similar a mecánicas de gamificación en redes sociales.

Estudios de la American Psychological Association indican que el 30% de usuarios de apps de citas experimentan ansiedad post-interacción, exacerbada por la IA que genera expectativas irreales de perfección romántica. En contextos latinoamericanos, donde el aislamiento social post-pandemia ha aumentado el uso de estas herramientas, esto agrava problemas de salud mental. La adicción se modela matemáticamente como un proceso de Markov, donde estados de recompensa (coincidencias) refuerzan comportamientos repetitivos.

Desde la ciberseguridad, esta dependencia facilita phishing emocional, donde la IA extrae datos sensibles bajo pretexto de “confianza”. Medidas preventivas incluyen límites de tiempo en apps y monitoreo de patrones de uso con herramientas como screen time trackers. Además, educar sobre el sesgo en datasets de entrenamiento de IA, que a menudo perpetúan estereotipos culturales, es crucial para una interacción consciente.

Amenazas Avanzadas: Deepfakes y Suplantación de Identidad

Los deepfakes representan una de las amenazas más avanzadas en citas virtuales con IA. Estas tecnologías, basadas en autoencoders y redes neuronales convolucionales, permiten la suplantación de identidad con fines maliciosos, como el sextortion. En un escenario típico, un actor crea un avatar falso que imita a una celebridad o conocido, extrayendo datos de redes sociales públicas para mayor realismo.

Técnicamente, la detección de deepfakes requiere análisis forense digital, como examen de artefactos en píxeles o frecuencias de audio. Herramientas open-source como DeepFaceLab o detectores basados en IA contraria pueden identificar manipulaciones con tasas de precisión del 85%. En Latinoamérica, casos reportados en Brasil y Argentina destacan cómo estos deepfakes se usan para extorsión, aprovechando la brecha digital en verificación de identidades.

Las plataformas deben implementar autenticación multifactor (MFA) con biometría segura, pero muchas fallan en esto debido a costos computacionales. Usuarios pueden mitigar riesgos escaneando contenido multimedia con apps como Hive Moderation o consultando metadatos EXIF para trazabilidad.

- Verificar identidades mediante videollamadas en vivo con preguntas impredecibles.

- Emplear software de detección de IA en dispositivos móviles.

- Reportar perfiles sospechosos a moderadores de la plataforma.

Estrategias de Prevención y Mejores Prácticas en Ciberseguridad

Para navegar estos riesgos, es esencial adoptar un enfoque proactivo en ciberseguridad. En primer lugar, seleccionar plataformas con certificaciones como ISO 27001 para gestión de seguridad de la información. Técnicamente, esto asegura que los datos se procesen con controles de acceso basados en roles (RBAC) y auditorías regulares.

Actualizar software regularmente mitiga vulnerabilidades conocidas, como las explotadas en bibliotecas de IA como TensorFlow. Usar contraseñas fuertes generadas por managers como LastPass y habilitar 2FA reduce el riesgo de accesos no autorizados. En el ámbito de la IA, revisar términos de servicio para entender cómo se usan los datos en entrenamiento de modelos es fundamental, evitando plataformas que monetizen información personal sin consentimiento explícito.

Para interacciones virtuales, establecer protocolos de comunicación segura: evitar enlaces desconocidos y usar mensajería encriptada end-to-end como Signal integrada en apps de citas. En regiones con alta incidencia de ciberdelitos, como Perú o Venezuela, colaborar con autoridades locales a través de reportes a entidades como la Policía Cibernética mexicana puede prevenir escaladas.

Finalmente, la educación continua es clave. Recursos como guías de la Electronic Frontier Foundation (EFF) ofrecen insights técnicos sobre privacidad en dating apps, enfatizando el principio de minimización de datos: compartir solo lo necesario.

Consideraciones Finales sobre el Futuro de las Citas con IA

La convergencia de IA y citas virtuales ofrece oportunidades innovadoras, pero exige un equilibrio entre conveniencia y seguridad. A medida que tecnologías como la IA multimodal avanzan, integrando visión y lenguaje para experiencias más inmersivas, los riesgos evolucionarán, demandando regulaciones más robustas como el RGPD europeo adaptado a contextos latinoamericanos.

En resumen, los usuarios deben priorizar la vigilancia técnica y el escepticismo informado para disfrutar de estas herramientas sin comprometer su bienestar. La adopción de prácticas de ciberseguridad no solo protege datos individuales, sino que contribuye a un ecosistema digital más seguro en la región. Mirando hacia adelante, el desarrollo de IA ética, con transparencia algorítmica y auditorías independientes, será pivotal para mitigar estos desafíos emergentes.

Para más información visita la Fuente original.