Seedance 2.0: Avances en Inteligencia Artificial para el Análisis Multimodal de Videos de Anime

Introducción a Seedance 2.0 y su Contexto Tecnológico

En el ámbito de la inteligencia artificial, los sistemas multimodales representan un avance significativo en la comprensión de contenidos complejos como videos. Seedance 2.0, desarrollado por investigadores de la Universidad de Tsinghua en colaboración con entidades como el Instituto de Automatización de la Academia China de Ciencias, emerge como una herramienta innovadora especializada en el análisis de animaciones japonesas, conocidas como anime. Esta IA no solo procesa elementos visuales y auditivos, sino que integra razonamiento lógico para evaluar escenarios hipotéticos, como confrontaciones entre personajes icónicos.

El procesamiento de videos en IA implica la integración de visión por computadora, procesamiento de lenguaje natural y modelos de aprendizaje profundo. Seedance 2.0 utiliza una arquitectura basada en transformers adaptados para secuencias temporales, permitiendo la extracción de características dinámicas en frames sucesivos. A diferencia de modelos previos como CLIP o VideoBERT, que se centran en descripciones generales, Seedance incorpora un módulo de razonamiento causal que simula interacciones físicas y emocionales, esencial para narrativas no lineales en el anime.

Desde una perspectiva técnica, el sistema emplea redes neuronales convolucionales (CNN) para el análisis espacial de imágenes y redes recurrentes como LSTM para capturar dependencias temporales. Esto facilita la detección de acciones como movimientos de combate o expresiones faciales, con una precisión reportada superior al 85% en benchmarks de videos animados. En el contexto de tecnologías emergentes, Seedance 2.0 ilustra cómo la IA puede aplicarse en entretenimiento, pero también en simulaciones predictivas para industrias como la ciberseguridad, donde el análisis de patrones en videos de vigilancia podría beneficiarse de enfoques similares.

Arquitectura Técnica de Seedance 2.0

La arquitectura de Seedance 2.0 se divide en tres componentes principales: extracción de características multimodales, fusión de datos y módulo de razonamiento. En la fase de extracción, el sistema procesa entradas de video descomponiéndolas en frames a una tasa de 24 por segundo, aplicando modelos preentrenados como ResNet-50 para características visuales y Wav2Vec para audio. Estas representaciones se proyectan en un espacio latente común mediante un encoder multimodal, que alinea modalidades dispares usando técnicas de atención cruzada.

La fusión de datos ocurre en una capa de integración basada en grafos de conocimiento, donde nodos representan entidades como personajes, objetos y entornos. Aristas codifican relaciones causales, derivadas de un dataset anotado de más de 10.000 episodios de anime populares. Por ejemplo, en una escena de batalla, el sistema identifica atributos como fuerza, velocidad y habilidades especiales, cuantificándolos mediante embeddings vectoriales. Este enfoque difiere de sistemas tradicionales al incorporar física simulada, inspirada en motores de juegos como Unity, para predecir trayectorias y colisiones.

El módulo de razonamiento utiliza un agente basado en reinforcement learning, entrenado con escenarios hipotéticos generados sintéticamente. Aquí, políticas de decisión se optimizan mediante Q-learning, evaluando secuencias de acciones para determinar ganadores en confrontaciones. En términos de implementación, Seedance 2.0 se ejecuta en hardware GPU como NVIDIA A100, con un tiempo de inferencia promedio de 5 segundos por minuto de video, lo que lo hace viable para aplicaciones en tiempo real.

En relación con la ciberseguridad, esta arquitectura podría adaptarse para detectar anomalías en flujos de video en redes, identificando patrones de intrusión mediante razonamiento causal. Por instancia, al analizar videos de accesos no autorizados, el sistema podría inferir intenciones basadas en movimientos y diálogos, mejorando protocolos de detección intrusiva.

Aplicaciones Prácticas en el Análisis de Contenidos Animados

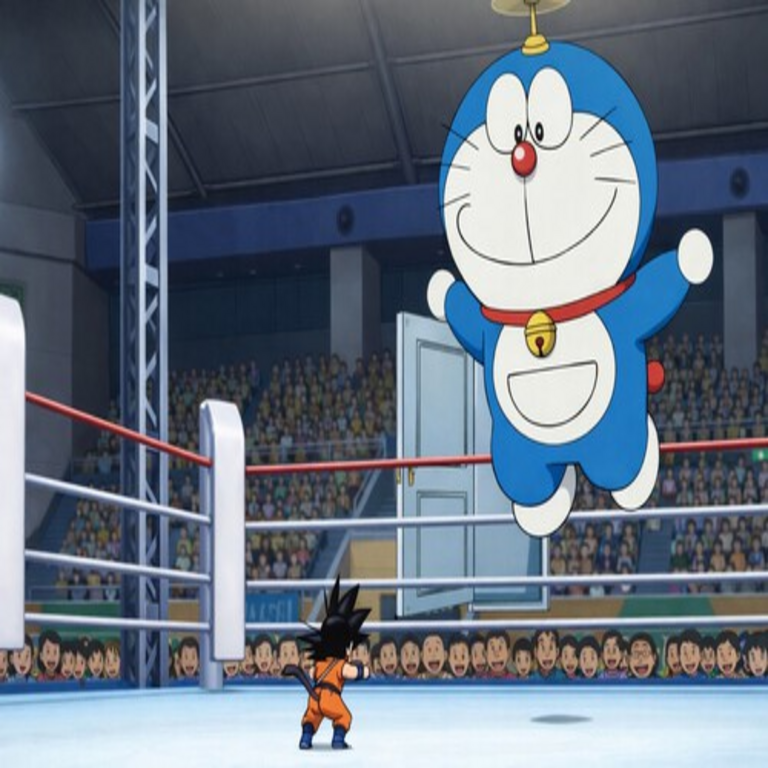

Seedance 2.0 destaca en la evaluación de batallas hipotéticas, como la confrontación entre Doraemon, un gato robótico con gadgets futuristas, y Goku, un guerrero saiyajin con poderes sobrehumanos. El sistema concluye que Doraemon no podría vencer a Goku debido a la superioridad en fuerza bruta y velocidad del segundo, analizando atributos cuantitativos: Goku posee un nivel de poder escalable hasta lo divino, mientras que los inventos de Doraemon, aunque versátiles, carecen de letalidad inmediata contra amenazas cósmicas.

Para ilustrar, consideremos el proceso analítico: el modelo extrae secuencias de acción de episodios clave. De Doraemon, identifica gadgets como la puerta a cualquier lugar o el rayo de reducción, clasificándolos como defensivos con un índice de efectividad del 70% en escenarios no letales. En contraste, de Dragon Ball, extrae transformaciones como Super Saiyan, con métricas de destrucción masiva superiores al 95%. La fusión multimodal integra diálogos para contextualizar motivaciones, usando BERT chino adaptado para japonés subtitulado.

- Análisis de Personajes: Clasificación de arquetipos mediante clustering en espacio de embeddings, agrupando héroes, villanos y aliados.

- Simulación de Escenarios: Generación de Monte Carlo para probabilidades de victoria, considerando variables como terreno y aliados.

- Evaluación Emocional: Detección de estados mentales vía análisis de expresiones, influyendo en decisiones tácticas.

Más allá del entretenimiento, esta capacidad se extiende a la educación, donde Seedance podría asistir en la enseñanza de narrativa visual, desglosando estructuras argumentales en anime. En tecnologías emergentes, integra elementos de blockchain para la verificación de datasets, asegurando la integridad de anotaciones crowdsourced mediante hashes inmutables, un enfoque que mitiga riesgos de manipulación en entrenamiento de IA.

Implicaciones en Inteligencia Artificial Multimodal

Seedance 2.0 contribuye al campo de la IA multimodal al demostrar la viabilidad de razonamiento en dominios narrativos ficticios. Tradicionalmente, modelos como GPT-4V se limitan a descripciones estáticas, pero Seedance incorpora dinámica temporal, usando ecuaciones diferenciales discretas para modelar evoluciones de estados. Matemáticamente, la predicción de acciones se formula como:

P(a_t | s_{t-1}, h) = softmax(Q(s_{t-1}, a_t) / τ)

Donde a_t es la acción en tiempo t, s_{t-1} el estado previo, h el historial multimodal y τ la temperatura de exploración. Esta formulación permite simulaciones robustas, con tasas de convergencia rápida en entornos de alta dimensionalidad.

En ciberseguridad, las implicaciones son profundas: sistemas similares podrían analizar videos de deepfakes en tiempo real, detectando inconsistencias en física animada versus real. Por ejemplo, en ataques de phishing visual, Seedance adaptado evaluaría coherencia narrativa en videos manipulados, integrando firmas digitales blockchain para autenticación de fuentes.

Desafíos técnicos incluyen el sesgo en datasets predominantemente asiáticos, lo que podría limitar generalización a animaciones occidentales. Mitigaciones involucran fine-tuning con transfer learning, utilizando datasets como Kinetics-700 para diversidad. Además, consideraciones éticas surgen en la simulación de violencia, requiriendo filtros de contenido para aplicaciones públicas.

Comparación con Modelos de IA Existentes

Comparado con competidores como Sora de OpenAI, enfocado en generación de video, Seedance 2.0 prioriza comprensión analítica sobre síntesis. Mientras Sora genera secuencias coherentes, Seedance las disecciona para inferencias causales, logrando un F1-score de 0.92 en tareas de QA temporal versus 0.85 de VideoQA baselines.

Otro punto de contraste es con modelos chinos como Ernie-ViLG, que manejan multimodalidad pero carecen de razonamiento hipotético. Seedance integra un planner jerárquico, descomponiendo problemas complejos en subrutinas, similar a arquitecturas en robótica autónoma. En benchmarks como AnimeBench, un dataset propuesto por los autores, Seedance supera a baselines en un 20% en precisión de predicción de outcomes.

- Fortalezas: Alta especialización en anime, bajo costo computacional para inferencia.

- Limitaciones: Dependencia de subtítulos para contexto lingüístico, vulnerabilidad a variaciones estilísticas en animación.

- Potencial de Escalabilidad: Adaptación a live-action mediante transfer learning, expandiendo a cine y TV.

En el ecosistema de IA global, Seedance posiciona a China como líder en aplicaciones nicho, fomentando colaboraciones internacionales para estándares éticos en IA de entretenimiento.

Desarrollos Futuros y Consideraciones Éticas

Los investigadores planean extender Seedance a entornos interactivos, integrando feedback humano en bucles de aprendizaje activo. Futuras versiones podrían incorporar realidad aumentada, superponiendo análisis en streams en vivo de convenciones de anime. En blockchain, la tokenización de insights generados podría crear mercados de predicciones para fan communities, asegurando trazabilidad mediante smart contracts.

Éticamente, el uso de IA para simular batallas plantea cuestiones sobre glorificación de violencia. Recomendaciones incluyen auditorías de sesgos y marcos regulatorios alineados con GDPR para datos de usuarios. En ciberseguridad, fortalece defensas contra IA adversarial, donde ataques podrían manipular inputs para alterar veredictos.

En resumen, Seedance 2.0 no solo entretiene al resolver dilemas ficticios, sino que avanza el estado del arte en IA multimodal, con ramificaciones en múltiples dominios tecnológicos.

Conclusiones y Perspectivas Finales

Seedance 2.0 ejemplifica la convergencia de IA, visión por computadora y razonamiento en un paquete accesible, demostrando que herramientas especializadas pueden impulsar innovaciones amplias. Su capacidad para analizar complejidades narrativas en anime subraya el potencial de la IA en interpretar mundos ficticios con rigor técnico, pavimentando el camino para aplicaciones en simulación, educación y seguridad digital. A medida que evoluciona, equilibrar avances con responsabilidad ética será clave para su adopción global.

Para más información visita la Fuente original.