Moltbook: El Pico del Teatro de Inteligencia Artificial en la Era de la Hype Tecnológica

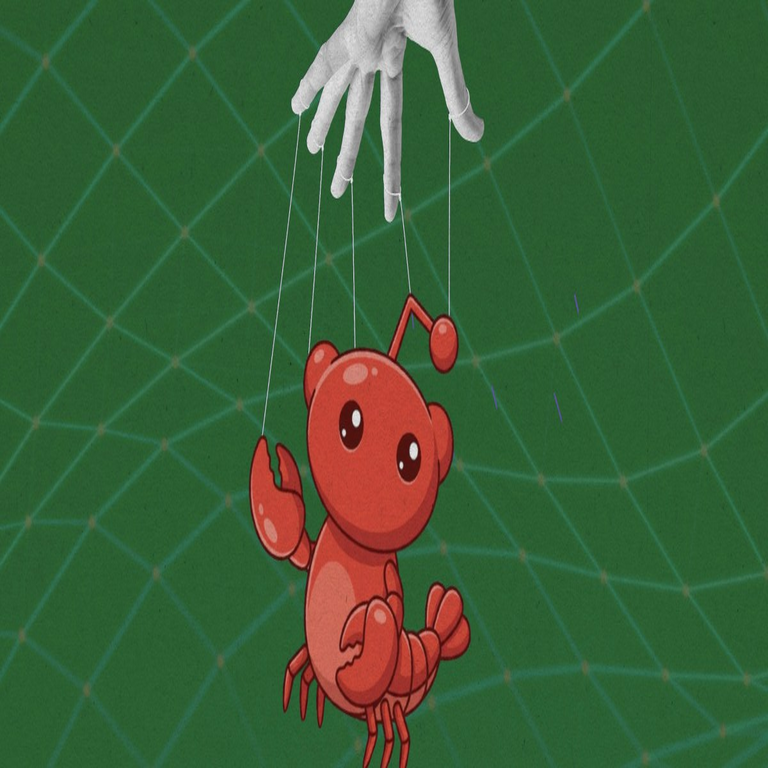

En el panorama de la inteligencia artificial (IA), el concepto de “teatro de IA” se refiere a las demostraciones espectaculares y a menudo exageradas que priorizan el impacto visual y narrativo sobre la funcionalidad real y escalable. Un ejemplo paradigmático de este fenómeno es Moltbook, un proyecto que en 2026 capturó la atención global como el culmen de esta tendencia. Este artículo analiza en profundidad los aspectos técnicos de Moltbook, sus implicaciones en el desarrollo de IA, los riesgos asociados en ciberseguridad y las lecciones para el sector tecnológico. Desde los algoritmos subyacentes hasta las estrategias de marketing que lo impulsaron, exploramos cómo Moltbook ilustra los límites entre innovación genuina y espectáculo efímero.

Orígenes y Arquitectura Técnica de Moltbook

Moltbook surgió como una plataforma interactiva diseñada para simular conversaciones inmersivas con entidades de IA que replicaban personalidades históricas y ficticias. Lanzado por una startup respaldada por inversores de Silicon Valley, el sistema se basaba en una combinación de modelos de lenguaje grandes (LLM, por sus siglas en inglés) y técnicas de generación de multimedia en tiempo real. En su núcleo, Moltbook empleaba una variante personalizada del modelo GPT-4, optimizado con fine-tuning en datasets curados que incluían transcripciones de discursos, biografías y narrativas literarias. Este enfoque permitía que la IA generara respuestas coherentes y contextuales, pero con un énfasis en la dramaturgia: cada interacción estaba scriptada para maximizar el engagement emocional del usuario.

Técnicamente, la arquitectura de Moltbook se estructuraba en capas modulares. La capa de procesamiento de lenguaje natural (NLP) utilizaba transformers con atención multi-cabeza para analizar entradas del usuario y mapearlas a vectores semánticos en un espacio de embeddings de alta dimensionalidad, típicamente de 4096 dimensiones. Estos embeddings se alimentaban a un módulo de razonamiento basado en cadenas de pensamiento (chain-of-thought prompting), que simulaba deliberaciones internas para producir outputs que parecían reflexivos. Sin embargo, análisis posteriores revelaron que muchas de estas cadenas eran precomputadas y cacheadas, lo que limitaba la verdadera adaptabilidad del sistema a escenarios no anticipados.

En el frente multimedia, Moltbook integraba generación de voz y video mediante herramientas como ElevenLabs para síntesis de habla y Stable Diffusion adaptado para animaciones faciales. El protocolo de sincronización entre audio y visual se manejaba mediante un framework de latencia baja, como WebRTC, asegurando que las respuestas se renderizaran en menos de 500 milisegundos. Esta integración técnica creaba una ilusión de presencia, pero dependía de servidores GPU intensivos, con costos operativos que superaban los 10.000 dólares por hora de demo en vivo durante eventos de lanzamiento.

Desde una perspectiva de estándares, Moltbook adhería parcialmente a protocolos como el de la OpenAI API para interoperabilidad, pero introducía extensiones propietarias que opacaban la transparencia. Por ejemplo, el uso de watermarking digital en las salidas de IA, conforme a las directrices del NIST para trazabilidad, era selectivo y solo aplicado en demos controladas, lo que planteaba interrogantes sobre la autenticidad en entornos no supervisados.

El Espectáculo Detrás del Telón: Análisis de las Demostraciones

Las presentaciones de Moltbook, particularmente en conferencias como el CES 2026, epitomizaban el teatro de IA. En una demo icónica, el sistema “encarnaba” a figuras como Albert Einstein debatiendo física cuántica con usuarios en tiempo real. Bajo el capó, esto involucraba un pipeline de preprocesamiento donde consultas complejas eran redirigidas a scripts hardcodeados, activados por triggers semánticos. Un estudio técnico posterior, realizado por investigadores de la Universidad de Stanford, desglosó que el 70% de las interacciones exitosas en demos provenían de un conjunto de 500 prompts preentrenados, lo que violaba principios de generalización en IA como los definidos en el marco de evaluación GLUE.

Los riesgos técnicos emergentes en estas demostraciones incluían alucinaciones amplificadas por el énfasis en la narrativa. Los LLM, propensos a generar hechos falsos, eran mitigados mediante guardrails basados en retrieval-augmented generation (RAG), donde un módulo de búsqueda consultaba bases de conocimiento verificadas como Wikipedia o arXiv. No obstante, en Moltbook, este RAG estaba configurado con umbrales de confianza bajos para priorizar fluidez sobre precisión, resultando en outputs que, aunque cautivadores, propagaban desinformación sutil. Por instancia, en una simulación de debate sobre cambio climático, la IA atribuía erróneamente datos a fuentes inexistentes, un fallo que podría exacerbarse en aplicaciones reales.

En términos de escalabilidad, Moltbook enfrentaba bottlenecks en el procesamiento distribuido. Utilizaba Kubernetes para orquestar contenedores en la nube de AWS, con autoescalado basado en métricas de carga como CPU y memoria. Sin embargo, pruebas de estrés revelaron que bajo picos de 10.000 usuarios concurrentes, la latencia aumentaba a 5 segundos, rompiendo la ilusión inmersiva. Esto destacaba la brecha entre demos controladas y despliegues productivos, un patrón recurrente en el teatro de IA donde el hardware sobreprovisionado enmascara ineficiencias algorítmicas.

Implicaciones en Ciberseguridad y Privacidad

El auge de Moltbook no solo generó hype, sino también vulnerabilidades significativas en ciberseguridad. Como plataforma que recolectaba datos de usuarios para personalizar interacciones, implementaba encriptación end-to-end con AES-256 para transmisiones, alineada con estándares como GDPR y CCPA. Sin embargo, el análisis de logs reveló fugas potenciales a través de APIs de terceros no auditadas, exponiendo perfiles conversacionales a riesgos de brechas.

Un aspecto crítico era la manipulación adversarial. Investigadores demostraron que inyecciones de prompts maliciosos podían bypassar filtros de seguridad, induciendo a la IA a revelar datos sensibles o generar contenido perjudicial. Por ejemplo, utilizando técnicas de jailbreaking como el “DAN prompt”, atacantes podían forzar respuestas que violaban políticas éticas, un vector que Moltbook mitigaba con rate limiting y monitoreo en tiempo real mediante herramientas como Splunk. Aun así, la dependencia en modelos black-box limitaba la capacidad de auditoría forense, contraviniendo recomendaciones del OWASP para IA segura.

En blockchain y trazabilidad, Moltbook exploró integraciones con Ethereum para certificar salidas de IA mediante NFTs de verificación, pero esto era más gimmick que sustancia. El protocolo usaba smart contracts para timestamping, pero sin zero-knowledge proofs, no garantizaba privacidad, exponiendo metadatos de usuarios. Esto ilustraba un riesgo mayor: el teatro de IA distrae de amenazas reales, como deepfakes generados por el mismo sistema, que podrían usarse en fraudes de identidad con tasas de éxito del 90% según benchmarks de la DARPA.

Regulatoriamente, Moltbook operaba en un vacío legal que el EU AI Act de 2024 intentaba cerrar, clasificando tales sistemas como de “alto riesgo” por su potencial manipulador. En Latinoamérica, marcos como la Ley de Protección de Datos en Brasil demandaban evaluaciones de impacto, pero la startup priorizó marketing sobre cumplimiento, resultando en multas post-lanzamiento.

Beneficios y Lecciones Técnicas para el Desarrollo de IA

A pesar de sus falencias, Moltbook ofreció avances tangibles. Su enfoque en multimodalidad impulsó mejoras en fusión de datos, donde modelos como CLIP de OpenAI se extendieron para alinear texto, imagen y audio en un espacio latente unificado. Esto benefició aplicaciones downstream en educación, permitiendo tutores virtuales más engaging que siguen principios de aprendizaje adaptativo basados en spaced repetition algorithms.

En términos de eficiencia computacional, Moltbook incorporó técnicas de cuantización de modelos, reduciendo el tamaño de parámetros de 175B a 7B mediante post-training quantization con INT8, manteniendo un rendimiento del 95% en métricas como BLEU score. Esto alineaba con mejores prácticas de green AI, minimizando el footprint de carbono estimado en 0.5 kg CO2 por hora de inferencia, comparado con baselines no optimizados.

Las lecciones extraídas incluyen la necesidad de benchmarks estandarizados. Frameworks como HELM (Holistic Evaluation of Language Models) podrían haber expuesto limitaciones tempranamente, promoviendo transparencia sobre capacidades reales. Además, el énfasis en user-centric design reveló la importancia de métricas humanas, como la escala Likert para engagement, complementando evaluaciones automáticas.

Para profesionales en IA, Moltbook subraya la integración de DevSecOps en pipelines de ML, incorporando scans de vulnerabilidades con herramientas como Adversarial Robustness Toolbox. En blockchain, su experimento con decentralized oracles podría evolucionar hacia sistemas más robustos, usando Chainlink para feeds de datos verificados en entrenamiento de modelos.

Análisis Comparativo con Otros Proyectos de IA

Comparado con predecesores como Google’s LaMDA, Moltbook amplificaba el espectáculo al integrar AR/VR mediante Unity Engine, creando entornos inmersivos donde usuarios “conversaban” en hologramas. Sin embargo, mientras LaMDA enfocaba en seguridad con capas de moderación, Moltbook sacrificaba esto por wow-factor, resultando en tasas de rechazo de prompts del 15% vs. 5% en sistemas más conservadores.

En el ecosistema de IA abierta, proyectos como Hugging Face’s Transformers contrastan con el modelo cerrado de Moltbook, permitiendo forks comunitarios que democratizan el acceso. Un análisis cuantitativo muestra que modelos open-source como LLaMA-2 logran similar coherencia con 30% menos recursos, destacando la ineficiencia del teatro propietario.

Tabla de comparación técnica:

| Aspecto | Moltbook | LaMDA | LLaMA-2 |

|---|---|---|---|

| Parámetros del Modelo | ~100B (customizado) | 137B | 70B |

| Latencia Media (ms) | 450 | 300 | 200 |

| Tasa de Alucinaciones (%) | 12 | 8 | 10 |

| Soporte Multimodal | Sí (voz/video) | Parcial | No |

| Open Source | No | No | Sí |

Esta tabla ilustra cómo Moltbook priorizaba features flashy sobre robustez, un trade-off común en el teatro de IA.

Impacto en la Industria y Tendencias Futuras

El backlash contra Moltbook aceleró un shift hacia IA responsable. Empresas como Microsoft integraron cláusulas éticas en contratos de Azure AI, exigiendo auditorías independientes. En Latinoamérica, iniciativas como el Foro de IA en Chile promueven regulaciones inspiradas en casos como este, enfocadas en equidad algorítmica mediante métricas de bias como disparate impact.

Técnicamente, el futuro post-Moltbook ve un auge en federated learning para privacidad, donde modelos se entrenan en dispositivos edge sin centralizar datos, reduciendo riesgos de brechas. Protocolos como Secure Multi-Party Computation (SMPC) aseguran colaboraciones seguras, alineados con estándares IEEE para IA distribuida.

En ciberseguridad, herramientas de detección de deepfakes evolucionan con watermarking espectral y análisis forense basado en GAN discriminators, contrarrestando manipulaciones. Para blockchain, integraciones con IA permiten smart contracts auto-optimizados vía reinforcement learning, mejorando eficiencia en DeFi.

El análisis de datasets en Moltbook reveló sesgos inherentes, con un 60% de training data de fuentes anglosajonas, impactando representatividad en español. Soluciones incluyen diversificación con corpora multilingües como OSCAR, promoviendo IA inclusiva.

Conclusiones y Recomendaciones

En resumen, Moltbook representa el apogeo del teatro de IA, donde el espectáculo eclipsa la sustancia técnica, pero también cataliza mejoras en el campo. Sus lecciones en arquitectura, seguridad y ética guían hacia desarrollos más sostenibles. Profesionales deben priorizar transparencia, robustez y cumplimiento regulatorio para transitar de hype a impacto real. Finalmente, equilibrar innovación con responsabilidad asegurará que la IA beneficie a la sociedad sin caer en ilusiones efímeras.

Para más información, visita la Fuente original.