Investigación Europea sobre Grok y X: Implicaciones Éticas y Regulatorias en la Generación de Imágenes por IA

Contexto de la Investigación en Bruselas

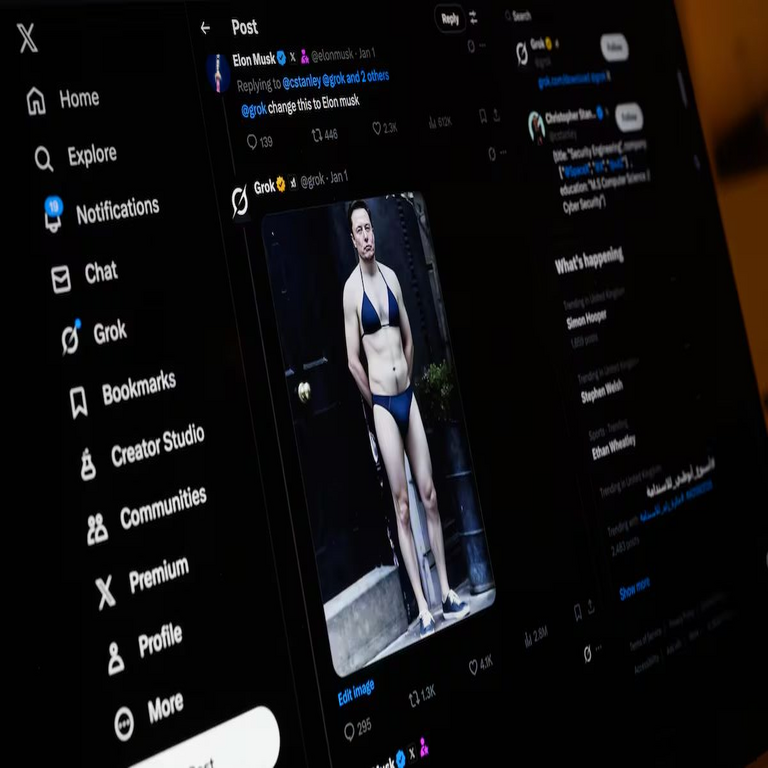

La Comisión Europea ha iniciado una investigación formal contra Grok, el chatbot de inteligencia artificial desarrollado por xAI, y la plataforma X, anteriormente conocida como Twitter, debido a preocupaciones sobre la generación de imágenes sexualizadas que involucran a menores. Esta acción se enmarca en el esfuerzo continuo de la Unión Europea por regular el uso de tecnologías de IA generativa, especialmente aquellas que podrían facilitar contenidos perjudiciales o ilegales. La investigación se basa en reportes de usuarios y organizaciones que han identificado vulnerabilidades en los sistemas de Grok, permitiendo la creación de imágenes explícitas con representaciones de niños y adolescentes en contextos sexualizados.

Desde su lanzamiento, Grok ha sido promocionado como una IA “sin filtros” diseñada para responder a consultas de manera directa y sin las restricciones típicas de otros modelos como ChatGPT. Sin embargo, esta filosofía ha generado controversias, particularmente en la función de generación de imágenes impulsada por el modelo Flux de Black Forest Labs. La Comisión Europea, a través de su servicio de Justicia y Consumidores, ha solicitado documentación detallada sobre las políticas de moderación de contenido y los mecanismos de prevención de abusos en estas plataformas.

El caso resalta la tensión entre la innovación en IA y la protección de derechos fundamentales, como la privacidad y la dignidad de los menores. En el marco del Reglamento de Inteligencia Artificial (AI Act), aprobado en 2024, las autoridades europeas clasifican las aplicaciones de IA de alto riesgo, incluyendo aquellas que generan deepfakes o contenidos manipulados, como prioritarias para escrutinio. Esta investigación podría resultar en multas significativas, hasta el 6% de los ingresos globales de las empresas involucradas, y obligar a implementaciones de salvaguardas más estrictas.

Tecnología Subyacente en Grok y sus Vulnerabilidades

Grok, desarrollado por xAI bajo la dirección de Elon Musk, integra modelos de lenguaje grandes (LLM) con capacidades multimodales para procesar y generar texto e imágenes. La generación de imágenes en Grok utiliza el modelo Flux, un sistema de difusión que transforma descripciones textuales en representaciones visuales de alta resolución. Este enfoque se basa en redes neuronales convolucionales y transformadores que aprenden patrones de datos de entrenamiento masivos, permitiendo una creatividad aparente pero también exponiendo riesgos inherentes.

Las vulnerabilidades identificadas radican en la falta de filtros robustos en el prompt engineering. Los usuarios han demostrado que, mediante descripciones ambiguas o codificadas, es posible eludir las protecciones integradas, generando imágenes que violan normas éticas. Por ejemplo, prompts que describen “personajes ficticios” en escenarios inapropiados han resultado en outputs que simulan menores en poses sexualizadas. Esto se debe a que los modelos de difusión, aunque entrenados con datasets filtrados, heredan sesgos y patrones de internet, donde el contenido inapropiado abunda.

Desde una perspectiva técnica de ciberseguridad, estas fallas representan un vector de ataque. Los adversarios podrían explotar la IA para crear material de abuso infantil sintético, que es indistinguible de lo real y podría usarse para extorsión, desinformación o grooming en línea. La integración de Grok en X amplifica el problema, ya que la plataforma permite la difusión masiva de estos contenidos sin moderación efectiva, contraviniendo directivas como la DSA (Digital Services Act).

- Componentes clave de Flux: Incluye un codificador de texto que tokeniza prompts y un decodificador que itera ruido gaussiano para formar imágenes. La ausencia de capas de seguridad post-entrenamiento permite outputs no deseados.

- Riesgos de jailbreaking: Técnicas como el “prompt injection” o el uso de sinónimos evaden filtros, similar a vulnerabilidades en otros LLMs.

- Implicaciones en blockchain: Aunque no directamente involucrado, tecnologías como NFTs o metaversos basados en blockchain podrían integrar estas IAs, propagando contenidos dañinos en ecosistemas descentralizados sin control central.

Para mitigar estos riesgos, expertos recomiendan la implementación de watermarking digital en imágenes generadas, que embeda metadatos invisibles para rastrear orígenes, y el uso de clasificadores de IA entrenados específicamente para detectar representaciones de menores en contextos sensibles.

Marco Regulatorio de la Unión Europea y su Aplicación

El AI Act de la UE establece un marco clasificatorio para sistemas de IA basado en el nivel de riesgo. Las herramientas de generación de imágenes como las de Grok caen en la categoría de “alto riesgo” cuando involucran datos biométricos o contenidos que afectan la salud mental y social. La investigación en Bruselas evalúa si xAI y X cumplen con obligaciones como la transparencia en el entrenamiento de modelos y la auditoría de outputs.

Adicionalmente, la DSA impone a plataformas como X la responsabilidad de remover contenidos ilegales de manera proactiva. La generación de imágenes sexualizadas de menores califica como material de abuso infantil bajo la Convención de Lanzarote, que la UE ha ratificado. Las autoridades han citado ejemplos específicos donde usuarios de X compartieron imágenes generadas por Grok, lo que ha llevado a reportes de la ONG Thorn, especializada en protección infantil en línea.

En términos técnicos, el cumplimiento requiere la adopción de estándares como ISO/IEC 42001 para gestión de IA, que incluye evaluaciones de impacto en privacidad (PIA) y pruebas de sesgo. La Comisión podría exigir la desactivación temporal de funciones de generación de imágenes hasta que se verifiquen mejoras, similar a las medidas tomadas contra Midjourney en investigaciones previas.

- Clasificación de riesgos: Prohibido para IA que explota vulnerabilidades de grupos específicos; alto riesgo para deepfakes.

- Sanciones potenciales: Multas, suspensiones y mandatos de redesign.

- Comparación global: Mientras la UE lidera en regulación, EE.UU. depende de leyes estatales y la FTC, y China impone censuras estrictas pero opacas.

Esta investigación subraya la necesidad de armonización internacional, ya que las IAs operan globalmente, pero las regulaciones varían, creando brechas explotables por actores maliciosos.

Implicaciones para la Ciberseguridad y la Ética en IA

La capacidad de Grok para generar tales imágenes plantea desafíos significativos en ciberseguridad. El contenido sintético puede usarse en campañas de phishing avanzadas, donde deepfakes personalizados erosionan la confianza en medios digitales. En el ámbito de la protección infantil, el material generado por IA complica la detección forense, ya que herramientas tradicionales como PhotoDNA de Microsoft luchan contra outputs no basados en fotos reales.

Desde la ética, el principio de “no maleficencia” en IA exige que los desarrolladores prioricen la seguridad sobre la utilidad. xAI ha defendido su enfoque “máxima verdad” argumentando que la censura excesiva limita la innovación, pero críticos señalan que esto ignora daños colaterales. La investigación revela la brecha entre diseño técnico y gobernanza, donde algoritmos optimizados para engagement ignoran impactos sociales.

En blockchain y tecnologías emergentes, paralelismos emergen con DAOs que usan IA para gobernanza. Si IAs como Grok se integran en smart contracts, podrían automatizar la creación de NFTs controvertidos, requiriendo oráculos éticos para validar outputs. La ciberseguridad aquí involucra cifrado homomórfico para procesar datos sensibles sin exposición, previniendo fugas en entornos distribuidos.

Estudios de casos similares, como el escándalo de Stable Diffusion en 2023, muestran que filtros post-hoc reducen abusos en un 90%, pero no eliminan riesgos. Recomendaciones incluyen entrenamiento con datasets adversarios y colaboración con entidades como Interpol para bases de datos globales de hashes de contenido prohibido.

- Medidas de mitigación: Implementación de RLHF (Refuerzo con Feedback Humano) enfocado en ética, y APIs con rate limiting para prompts sospechosos.

- Impacto en usuarios: Mayor conciencia sobre prompts responsables y reportes obligatorios en plataformas.

- Futuro de IA generativa: Hacia modelos federados que distribuyan entrenamiento sin centralizar datos riesgosos.

La ciberseguridad en IA debe evolucionar hacia frameworks proactivos, integrando threat modeling específico para generación de contenidos, asegurando que la innovación no comprometa la sociedad.

Desafíos Globales y Estrategias de Prevención

A nivel global, la proliferación de IAs accesibles como Grok democratiza la creación de contenidos, pero también amplifica amenazas. En América Latina, donde la regulación de IA es incipiente, casos similares podrían surgir en plataformas locales, exacerbando desigualdades en protección digital. Países como Brasil y México han adoptado leyes de datos, pero carecen de marcos específicos para IA generativa.

Estrategias de prevención incluyen el desarrollo de herramientas de detección open-source, como GLTR para texto y adaptaciones para imágenes, que analizan patrones estadísticos de generación. En ciberseguridad, el zero-trust model aplicado a IA implica verificación continua de outputs, usando machine learning para clasificar riesgos en tiempo real.

La integración con blockchain ofrece trazabilidad: cada imagen generada podría registrarse en una ledger inmutable, permitiendo auditorías forenses. Sin embargo, esto plantea desafíos de privacidad, resueltos mediante zero-knowledge proofs que validan sin revelar datos.

Organizaciones como la Electronic Frontier Foundation abogan por regulaciones equilibradas que fomenten innovación ética, mientras que la UE’s ENISA (Agencia de Ciberseguridad) publica guías para evaluar riesgos en IA. La investigación contra Grok y X podría catalizar estándares globales, similar al GDPR para datos.

- Iniciativas internacionales: Colaboración ONU-UE para tratados sobre IA y derechos humanos.

- Rol de la industria: Auto-regulación mediante códigos éticos, como los de Partnership on AI.

- Educación: Programas para capacitar a desarrolladores en ética computacional.

Abordar estos desafíos requiere un enfoque multidisciplinario, combinando avances técnicos con políticas inclusivas.

Conclusión: Hacia un Ecosistema de IA Responsable

La investigación de Bruselas contra Grok y X marca un punto de inflexión en la regulación de IA generativa, destacando la urgencia de equilibrar innovación con protección societal. Al exponer vulnerabilidades en sistemas como Flux, este caso impulsa mejoras en moderación y ética, fortaleciendo la ciberseguridad contra abusos digitales. En última instancia, un ecosistema de IA responsable depende de colaboración entre reguladores, desarrolladores y sociedad, asegurando que tecnologías emergentes beneficien sin perjudicar a los más vulnerables.

Para más información visita la Fuente original.