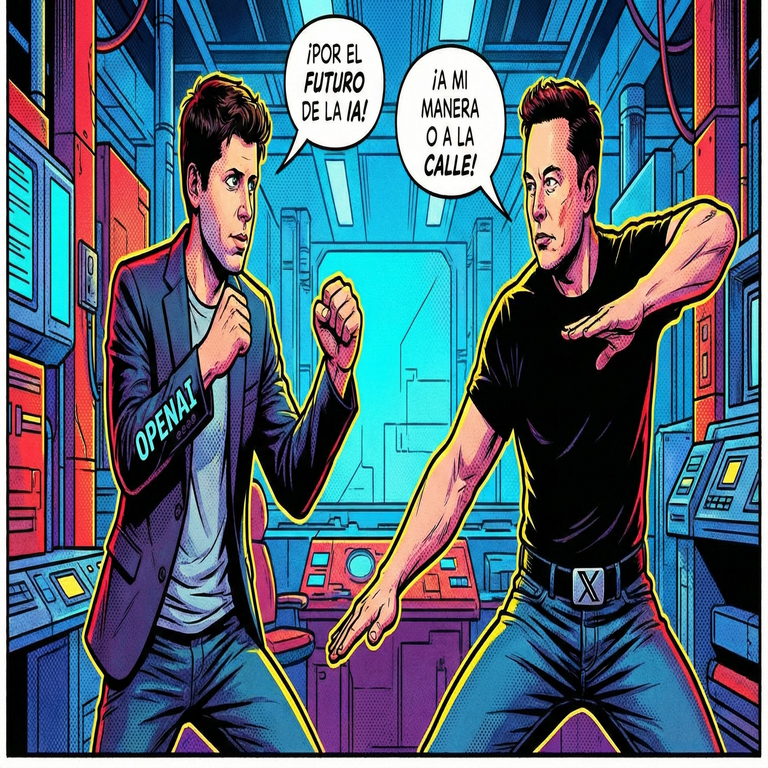

La Batalla Legal entre OpenAI y Elon Musk: Implicaciones para el Control y el Futuro de la Inteligencia Artificial

Antecedentes del Conflicto entre OpenAI y Elon Musk

La disputa legal entre OpenAI y Elon Musk representa uno de los episodios más significativos en la evolución de la inteligencia artificial (IA), destacando tensiones inherentes en la gobernanza, la propiedad intelectual y el desarrollo ético de tecnologías emergentes. OpenAI, fundada en 2015 como una organización sin fines de lucro dedicada a promover la IA de manera segura y beneficiosa para la humanidad, contó inicialmente con la participación de Musk como cofundador. Sin embargo, Musk abandonó la entidad en 2018, argumentando desacuerdos sobre la dirección estratégica, particularmente en relación con la transición hacia un modelo híbrido que incorporaba elementos comerciales.

El núcleo del litigio radica en las acusaciones de Musk de que OpenAI ha desviado su misión original al priorizar ganancias sobre el avance abierto y accesible de la IA. En marzo de 2024, Musk presentó una demanda en el Tribunal Superior de California, alegando incumplimiento de contratos fundacionales y fraude. OpenAI respondió con una contrademanda, afirmando que las acciones de Musk buscan obstaculizar su competencia a través de xAI, su propia empresa de IA. Esta batalla no solo involucra aspectos contractuales, sino que revela vulnerabilidades en la estructura de control de la IA, donde decisiones sobre datos de entrenamiento, algoritmos y despliegue pueden influir en el panorama global de la ciberseguridad.

Desde una perspectiva técnica, OpenAI ha desarrollado modelos como GPT-4, basados en arquitecturas de transformers que procesan vastos conjuntos de datos para generar respuestas coherentes. Musk, por su parte, aboga por una IA alineada con principios de transparencia, criticando el enfoque cerrado de OpenAI que limita el acceso a sus pesos de modelo. Esta controversia subraya la necesidad de marcos regulatorios que equilibren innovación y accountability en entornos donde la IA interactúa con sistemas distribuidos, como blockchain para verificación de datos.

Aspectos Legales Clave en la Demanda

La demanda de Musk se centra en tres pilares legales: el incumplimiento de la misión fundacional de OpenAI, la violación de acuerdos de confidencialidad y la competencia desleal. Según los documentos judiciales, Musk argumenta que OpenAI prometió mantener su estructura sin fines de lucro, pero en 2019 se asoció con Microsoft, recibiendo miles de millones en inversión a cambio de exclusividad en el uso comercial de sus tecnologías. Esto, sostiene Musk, transforma a OpenAI en una entidad orientada al lucro, contradiciendo el pacto inicial de democratizar la IA.

OpenAI rebate estas afirmaciones señalando que Musk mismo impulsó la búsqueda de financiamiento comercial durante su tenure, proponiendo incluso una adquisición por Tesla. La contrademanda acusa a Musk de difamación y de usar su influencia en plataformas como X (anteriormente Twitter) para desacreditar a OpenAI, lo que podría interpretarse como una táctica de interferencia competitiva. En términos de ciberseguridad, este litigio expone riesgos en la gestión de propiedad intelectual de IA: los modelos entrenados con datos públicos podrían generar disputas sobre derechos de autor, especialmente cuando se integran en aplicaciones blockchain para trazabilidad de transacciones inteligentes.

Legalmente, el caso invoca la doctrina de “buena fe” en contratos, un principio común en el derecho corporativo estadounidense. Si el tribunal falla a favor de Musk, podría obligar a OpenAI a revelar más sobre su arquitectura interna, impactando la seguridad de sus sistemas contra ataques adversarios como el envenenamiento de datos. Por el contrario, una victoria de OpenAI reforzaría el modelo de desarrollo propietario, potencialmente acelerando avances en IA generativa pero a costa de mayor opacidad en auditorías de seguridad.

- Incumplimiento contractual: Musk alega que OpenAI violó cláusulas que exigían investigación abierta, citando ejemplos como la no publicación de detalles técnicos de GPT-3.

- Confidencialidad: Documentos filtrados muestran que Musk tuvo acceso temprano a prototipos, lo que OpenAI usa para argumentar robo de ideas en xAI.

- Competencia: xAI, lanzada en 2023, compite directamente con ChatGPT, y Musk es acusado de usar datos de OpenAI para entrenar Grok.

Implicaciones Técnicas para el Desarrollo de la IA

Esta batalla legal trasciende lo contractual y penetra en las entrañas técnicas de la IA, particularmente en cómo se gestiona el control de modelos grandes de lenguaje (LLM). OpenAI utiliza técnicas de aprendizaje profundo con miles de millones de parámetros, entrenados en clústeres de GPUs que consumen energía equivalente a ciudades pequeñas. Musk critica esta escala por su huella ambiental y por centralizar el poder en pocas manos, proponiendo alternativas como IA descentralizada vía blockchain para distribuir el cómputo y mitigar riesgos de monopolio.

En ciberseguridad, el conflicto resalta vulnerabilidades en la cadena de suministro de IA. Por ejemplo, si OpenAI debe abrir su código fuente como resultado del litigio, podría exponer debilidades a exploits como jailbreaking, donde adversarios manipulan prompts para eludir salvaguardas éticas. Musk, a través de xAI, enfatiza la alineación de IA con valores humanos, integrando mecanismos de verificación basados en criptografía para asegurar que los outputs no propaguen desinformación. Esto es crucial en escenarios de tecnologías emergentes, donde la IA se integra con blockchain para contratos inteligentes autoejecutables, requiriendo robustez contra manipulaciones cuánticas futuras.

Además, el caso ilustra desafíos en la escalabilidad de la IA. Modelos como los de OpenAI dependen de datos sintéticos generados por IA misma, lo que plantea cuestiones sobre sesgos inherentes y privacidad. Si el tribunal impone transparencia, podría fomentar estándares abiertos similares a los de TensorFlow, permitiendo auditorías independientes que detecten backdoors en algoritmos. En contraste, el enfoque cerrado de OpenAI acelera iteraciones pero aumenta riesgos de ciberataques, como el robo de tokens de entrenamiento que podría replicar modelos propietarios.

Desde la óptica de blockchain, esta disputa podría inspirar híbridos: plataformas donde la IA se entrena en redes distribuidas, usando proof-of-stake para validar contribuciones de datos. Musk ha insinuado interés en tales integraciones para xAI, potencialmente resolviendo dilemas de control al tokenizar accesos a modelos, asegurando equidad en la distribución de beneficios.

Impacto en la Gobernanza y Ética de la IA

La gobernanza de la IA emerge como el eje central de esta contienda, cuestionando quién decide el rumbo de tecnologías que podrían superar la inteligencia humana. OpenAI defiende su modelo híbrido como necesario para competir con actores estatales como China, donde la IA se desarrolla sin restricciones éticas. Musk, sin embargo, advierte de un “riesgo existencial” si la IA no se alinea globalmente, citando su apoyo a regulaciones como la Directiva de IA de la Unión Europea.

Éticamente, el litigio expone dilemas en la responsabilidad por outputs de IA. Si un modelo como ChatGPT genera contenido perjudicial, ¿quién rinde cuentas: los desarrolladores o los usuarios? En ciberseguridad, esto se traduce en protocolos de mitigación, como watermarking digital en generaciones de IA para rastrear abusos. La batalla podría catalizar marcos internacionales, integrando blockchain para logs inmutables de decisiones algorítmicas, asegurando trazabilidad en entornos de alta estaca como la defensa cibernética.

El futuro de la IA depende de resolver estos conflictos: una victoria de Musk podría democratizar el acceso, fomentando innovación colaborativa; mientras que el triunfo de OpenAI consolidaría liderazgos corporativos, potencialmente estancando avances en IA abierta. En cualquier caso, urge la adopción de estándares técnicos para auditorías, como pruebas de robustez contra adversariales y evaluaciones de impacto en privacidad de datos.

- Transparencia algorítmica: Revelar pesos de modelos para escrutinio público, reduciendo riesgos de sesgos ocultos.

- Ética en entrenamiento: Incorporar datasets diversificados para mitigar discriminación cultural en IA global.

- Regulación híbrida: Combinar enfoques legales con herramientas blockchain para enforcement descentralizado.

Perspectivas Futuras en el Ecosistema de IA

Más allá del veredicto inmediato, esta disputa moldeará el ecosistema de IA para la próxima década. Con el avance de modelos multimodales que integran visión, lenguaje y acción, el control sobre estos sistemas se vuelve paramount en ciberseguridad. Imagínese IA desplegada en redes IoT: un fallo en gobernanza podría amplificar ciberataques a escala, como DDoS impulsados por bots autónomos.

En blockchain, la lección es clara: la descentralización ofrece un contrapeso al centralismo de big tech. Proyectos como SingularityNET exploran mercados de IA en cadena, donde servicios se tokenizan, alineándose con la visión de Musk de accesibilidad. OpenAI, por su parte, podría pivotar hacia alianzas con firmas de ciberseguridad para fortificar sus defensas, incorporando zero-knowledge proofs para validar integridad sin exponer datos sensibles.

El impacto en inversión es notable: startups de IA enfrentan mayor escrutinio, priorizando cláusulas de misión en fundaciones. Globalmente, esto podría influir en políticas, como la propuesta de ley de IA en EE.UU., que busca equilibrar innovación con safeguards contra misuse.

Cierre Analítico: Reflexiones sobre el Horizonte de la IA

En síntesis, la batalla legal entre OpenAI y Elon Musk no es meramente un choque personal, sino un catalizador para redefinir el control y el futuro de la inteligencia artificial. Al desentrañar tensiones entre apertura y propiedad, ética y eficiencia, este caso subraya la urgencia de marcos técnicos robustos que integren ciberseguridad y tecnologías emergentes como blockchain. Solo mediante un equilibrio informado se podrá navegar hacia una IA que beneficie a la humanidad sin comprometer su seguridad inherente.

Para más información visita la Fuente original.