El Acceso de Google a Datos Personales en Correos y Fotos para Entrenar Modelos de Inteligencia Artificial

Contexto de la Práctica de Recopilación de Datos en Plataformas Digitales

En el ecosistema de servicios digitales, las empresas tecnológicas como Google han establecido prácticas de recopilación de datos que abarcan una amplia gama de información generada por los usuarios. Estos datos incluyen correos electrónicos almacenados en Gmail y fotografías subidas a Google Photos, los cuales se utilizan no solo para funcionalidades básicas como el almacenamiento y la búsqueda, sino también para fines más avanzados como el entrenamiento de modelos de inteligencia artificial (IA). Esta aproximación permite a Google mejorar sus algoritmos de machine learning, pero genera interrogantes significativas sobre la privacidad y la seguridad de los datos personales.

La recopilación de datos en tiempo real y retrospectivo se basa en políticas de privacidad que los usuarios aceptan al registrarse en los servicios. Sin embargo, el uso de estos datos para IA implica un procesamiento automatizado que puede extraer patrones, preferencias y comportamientos individuales sin consentimiento explícito para cada aplicación específica. En términos técnicos, esto involucra técnicas de procesamiento de lenguaje natural (NLP) para analizar el contenido textual de los correos y visión por computadora para interpretar imágenes en las fotos, lo que acelera el desarrollo de herramientas como el asistente Gemini o mejoras en la búsqueda semántica.

Desde una perspectiva de ciberseguridad, esta práctica expone vulnerabilidades inherentes. Los datos almacenados en la nube de Google están protegidos por encriptación en tránsito y en reposo, utilizando estándares como AES-256. No obstante, el acceso interno de la empresa a estos datos para entrenamiento de IA representa un vector de riesgo si no se implementan controles estrictos de segmentación y anonimización. Regulaciones como el Reglamento General de Protección de Datos (RGPD) en Europa y leyes similares en Latinoamérica, como la Ley Federal de Protección de Datos Personales en Posesión de los Particulares en México, exigen transparencia y minimización de datos, pero su aplicación a gigantes tecnológicos globales sigue siendo un desafío.

Mecanismos Técnicos de Acceso y Procesamiento de Datos

Google emplea un marco técnico robusto para acceder a los datos de usuarios. En Gmail, el sistema utiliza APIs internas que permiten el escaneo de correos para personalizar anuncios y, en extensiones recientes, para alimentar modelos de IA. Este escaneo se realiza mediante algoritmos de extracción de entidades nombradas (NER) que identifican nombres, lugares y eventos en los mensajes, los cuales se agregan a datasets masivos para entrenamiento supervisado o no supervisado.

En el caso de Google Photos, el acceso involucra el análisis de metadatos EXIF y el contenido píxel a píxel de las imágenes. Herramientas de IA como TensorFlow procesan estas fotos para reconocer objetos, rostros y escenas, contribuyendo a mejoras en la categorización automática y la generación de resúmenes visuales. Técnicamente, esto se logra mediante redes neuronales convolucionales (CNN) que clasifican imágenes en categorías predefinidas, y modelos generativos como diffusion models para crear variaciones o enhancements.

El flujo de datos sigue un pipeline que incluye ingesta, preprocesamiento y entrenamiento. Durante la ingesta, los datos se anonimizan parcialmente mediante tokenización o hashing, pero informes indican que Google retiene identificadores únicos para correlacionar perfiles de usuario. En ciberseguridad, esto plantea riesgos de re-identificación: un atacante con acceso parcial podría usar técnicas de linkage attack para reconstruir perfiles completos. Para mitigar esto, Google implementa federated learning en algunos escenarios, donde el entrenamiento ocurre en dispositivos locales sin transferir datos crudos al servidor central.

- Escaneo de correos: Utiliza NLP para extraer contexto semántico y mejorar recomendaciones.

- Análisis de fotos: Emplea visión por computadora para etiquetado automático y búsqueda por similitud.

- Entrenamiento de IA: Integra datos en datasets como Common Crawl o conjuntos propietarios para fine-tuning de LLMs.

- Protecciones: Encriptación end-to-end y auditorías internas, aunque limitadas por la opacidad corporativa.

Estas mecanismos no solo optimizan el rendimiento de la IA, sino que también generan valor económico a través de servicios premium como Google Workspace o integraciones en Android. Sin embargo, la escala de los datos procesados —estimada en petabytes diarios— amplifica los impactos de cualquier brecha de seguridad.

Implicaciones en Privacidad y Seguridad Cibernética

El acceso a correos y fotos para IA plantea preocupaciones éticas y legales profundas. En primer lugar, la privacidad se ve comprometida cuando datos sensibles, como información médica en correos o fotos familiares, se utilizan sin un consentimiento granular. Estudios de organizaciones como la Electronic Frontier Foundation (EFF) destacan cómo estos datos pueden perpetuar sesgos en modelos de IA, resultando en discriminación algorítmica en aplicaciones downstream como la moderación de contenido o la publicidad dirigida.

Desde el ángulo de ciberseguridad, el almacenamiento centralizado de datos aumenta la superficie de ataque. Ataques como el ransomware o brechas de datos, como el incidente de 2018 en Google+ que expuso perfiles de 500.000 usuarios, ilustran los riesgos. En el contexto de IA, un modelo entrenado con datos comprometidos podría propagar malware o desinformación. Por ejemplo, si un dataset incluye correos phishing no detectados, el modelo podría aprender patrones falsos, reduciendo la efectividad de filtros de spam.

En Latinoamérica, donde la adopción de servicios de Google es alta pero la regulación varía, países como Brasil con la Lei Geral de Proteção de Dados (LGPD) buscan alinear con estándares globales. No obstante, la extraterritorialidad de Google complica la enforcement. Recomendaciones técnicas incluyen el uso de differential privacy, que añade ruido a los datasets para prevenir re-identificación, y zero-knowledge proofs para verificar el uso de datos sin revelar su contenido.

Además, el entrenamiento de IA consume recursos computacionales masivos, lo que indirectamente afecta la sostenibilidad y la seguridad. Data centers de Google, protegidos por firewalls avanzados y SIEM systems, enfrentan amenazas como DDoS o insider threats, donde empleados con acceso privilegiado podrían extraer datos para entrenamiento no autorizado.

- Riesgos de privacidad: Exposición de datos sensibles sin consentimiento explícito.

- Amenazas cibernéticas: Brechas que comprometen datasets de IA.

- Sesgos algorítmicos: Propagación de desigualdades en modelos entrenados.

- Regulaciones: Desafíos en la aplicación transfronteriza de leyes de datos.

Para contrarrestar estos riesgos, expertos en ciberseguridad abogan por auditorías independientes y el derecho al olvido, permitiendo a usuarios eliminar sus datos de modelos entrenados, aunque técnicamente desafiante debido a la naturaleza distribuida del aprendizaje.

Avances en IA y su Dependencia de Datos Personales

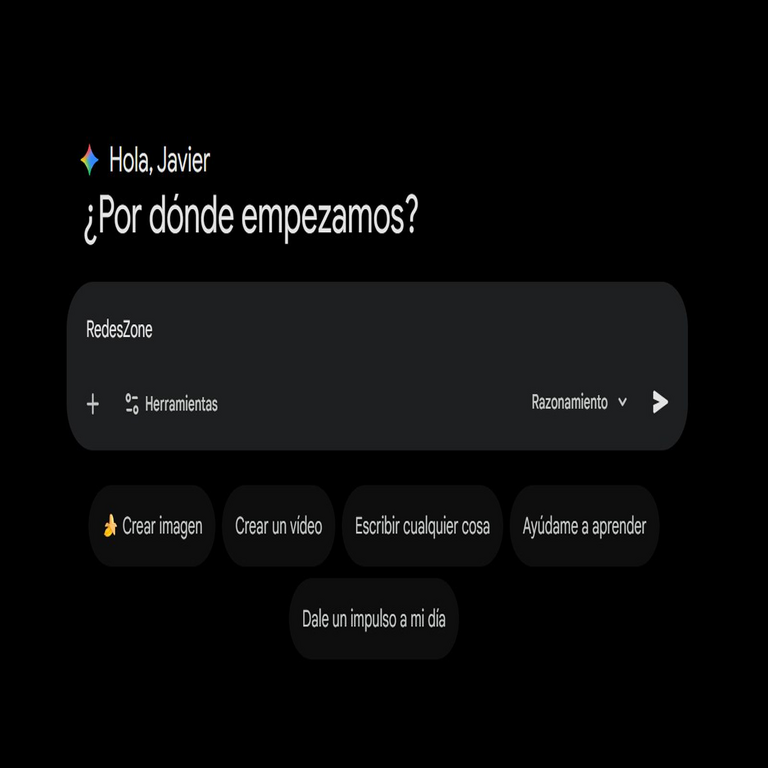

La evolución de la IA en Google depende intrínsecamente de volúmenes masivos de datos. Modelos como PaLM o Gemini se benefician de correos para entender lenguaje conversacional y de fotos para multimodalidad, integrando texto e imagen en respuestas coherentes. Técnicamente, esto involucra transformers architecture, donde atención mechanisms ponderan la relevancia de datos de entrada, incluyendo snippets de correos o descripciones de imágenes.

En blockchain y tecnologías emergentes, paralelos se observan en decentralized IA, donde plataformas como SingularityNET usan datos distribuidos sin centralización. Sin embargo, Google mantiene un enfoque centralizado, priorizando eficiencia sobre descentralización. Esto permite escalabilidad, pero sacrifica resiliencia: un solo punto de falla podría colapsar el acceso a datos críticos para IA.

En ciberseguridad, la integración de IA en detección de amenazas —usando datos de correos para identificar anomalías— es un doble filo. Mientras mejora la proactividad, depende de datos limpios; contaminación por accesos no autorizados podría generar falsos positivos masivos. Soluciones incluyen homomorphic encryption, permitiendo computaciones en datos encriptados sin descifrarlos, ideal para entrenamiento seguro de IA.

Proyecciones indican que para 2025, el 80% de las IA enterprise usarán datos personales anonimizados, según Gartner. Google lidera este shift, pero debe equilibrar innovación con responsabilidad. En Latinoamérica, iniciativas como el Marco Latinoamericano de Inteligencia Artificial promueven guías éticas, enfatizando transparencia en el uso de datos.

Estrategias de Mitigación y Mejores Prácticas para Usuarios y Empresas

Para mitigar riesgos, usuarios pueden adoptar prácticas como el uso de alias en correos y herramientas de privacidad como VPNs para enmascarar metadatos en fotos. Técnicamente, desactivar la personalización en ajustes de Google limita el escaneo, aunque no elimina el acceso base.

Empresas, por su parte, deben implementar data governance frameworks, incluyendo clasificación de datos y access controls basados en roles (RBAC). En IA, técnicas como k-anonymity aseguran que ningún individuo sea identificable en un grupo de al menos k registros. Además, auditorías regulares con herramientas como OWASP ZAP para testing de vulnerabilidades en APIs de datos son esenciales.

- Para usuarios: Configurar privacidad granular y usar almacenamiento local.

- Para empresas: Adoptar privacy-by-design en pipelines de IA.

- Tecnologías: Federated learning y encriptación homomórfica.

- Políticas: Cumplimiento con RGPD/LGPD y reportes anuales de privacidad.

En el ámbito de blockchain, smart contracts podrían automatizar consents para uso de datos en IA, asegurando trazabilidad inmutable. Esto representa un futuro donde la ciberseguridad se integra nativamente con IA ética.

Reflexiones Finales sobre el Equilibrio entre Innovación y Protección

El acceso de Google a correos y fotos para IA encapsula el dilema central de la era digital: el avance tecnológico versus la salvaguarda de derechos individuales. Mientras la innovación en IA promete transformaciones en sectores como la salud y la educación, la dependencia de datos personales exige marcos regulatorios más robustos y tecnologías de privacidad avanzadas. En última instancia, un enfoque colaborativo entre empresas, reguladores y usuarios fomentará un ecosistema digital seguro y equitativo, minimizando riesgos mientras maximiza beneficios.

La transición hacia IA responsable no es opcional; es imperativa para sostener la confianza pública. Con evoluciones en ciberseguridad y blockchain, es posible reconciliar estos mundos, asegurando que la inteligencia artificial sirva al bien común sin comprometer la autonomía individual.

Para más información visita la Fuente original.