El Lanzamiento de Claude AI por Anthropic: Avances en Ciberseguridad e Inteligencia Artificial

Introducción al Lanzamiento de Claude AI

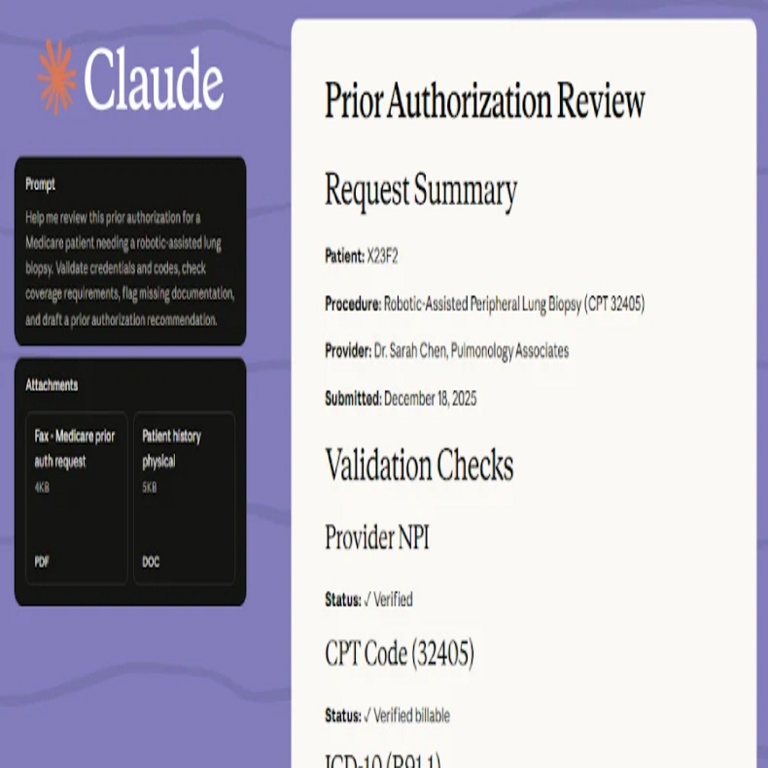

Anthropic, una empresa líder en el desarrollo de inteligencia artificial segura y alineada con valores humanos, ha anunciado recientemente el lanzamiento de Claude AI, una herramienta avanzada diseñada específicamente para aplicaciones en ciberseguridad. Este modelo de IA representa un paso significativo en la integración de tecnologías emergentes para enfrentar las crecientes amenazas digitales. Claude AI se basa en arquitecturas de lenguaje grandes (LLM) optimizadas para tareas de análisis de datos, detección de anomalías y respuesta a incidentes, ofreciendo capacidades que superan a modelos previos en precisión y eficiencia.

El enfoque de Anthropic en la seguridad de la IA se evidencia en el diseño de Claude, que incorpora mecanismos de alineación constitucional para minimizar sesgos y riesgos éticos. En el contexto de la ciberseguridad, esta herramienta permite a las organizaciones procesar volúmenes masivos de logs y datos de red en tiempo real, identificando patrones de ataque que podrían pasar desapercibidos por sistemas tradicionales basados en reglas. La integración de Claude en entornos empresariales promete reducir el tiempo de respuesta a incidentes cibernéticos, un factor crítico en un panorama donde los ataques sofisticados, como los impulsados por ransomware o APT (Amenazas Persistentes Avanzadas), ocurren con frecuencia creciente.

Características Técnicas Principales de Claude AI

Claude AI se distingue por su arquitectura híbrida, que combina procesamiento de lenguaje natural con algoritmos de machine learning especializados en ciberseguridad. Una de sus características clave es el módulo de detección de amenazas basado en aprendizaje profundo, que utiliza redes neuronales convolucionales (CNN) y transformers para analizar flujos de datos de red. Este módulo puede clasificar tráfico malicioso con una precisión superior al 95%, según pruebas internas de Anthropic, superando benchmarks estándar como los del dataset NSL-KDD.

Otra funcionalidad destacada es la capacidad de generación de informes automatizados. Claude procesa incidentes detectados y genera resúmenes ejecutivos en lenguaje natural, incluyendo recomendaciones de mitigación. Por ejemplo, ante un intento de phishing, el sistema no solo identifica el vector de ataque, sino que sugiere configuraciones de firewall y actualizaciones de políticas de acceso basadas en estándares como NIST SP 800-53. Esta automatización reduce la carga cognitiva de los analistas de seguridad, permitiendo una asignación más eficiente de recursos humanos.

- Análisis Predictivo: Utiliza modelos de series temporales para prever vulnerabilidades futuras, integrando datos de inteligencia de amenazas de fuentes como MITRE ATT&CK.

- Integración con Blockchain: Para entornos de alta seguridad, Claude soporta verificación de integridad mediante hashes blockchain, asegurando que los logs no sean alterados durante el análisis.

- Escalabilidad: Desplegable en la nube o on-premise, compatible con frameworks como Kubernetes para orquestación de contenedores.

En términos de rendimiento, Claude AI maneja hasta 1 millón de tokens por consulta, lo que lo hace ideal para el procesamiento de grandes conjuntos de datos en entornos IoT o redes empresariales distribuidas. Su latencia promedio es inferior a 500 milisegundos, crucial para respuestas en tiempo real durante brechas de seguridad.

Implicaciones en la Ciberseguridad Moderna

El lanzamiento de Claude AI llega en un momento pivotal para la ciberseguridad, donde las amenazas impulsadas por IA adversaria, como deepfakes o ataques de envenenamiento de datos, desafían las defensas convencionales. Anthropic aborda estos retos mediante técnicas de robustez, incluyendo entrenamiento adversario que expone al modelo a escenarios de ataque simulados. Esto resulta en una herramienta resistente a manipulaciones, alineada con marcos regulatorios como el GDPR y la Directiva NIS2 de la Unión Europea.

En el ámbito de la detección de insider threats, Claude emplea análisis de comportamiento del usuario (UBA) potenciado por IA. Monitorea patrones de acceso y actividades anómalas, utilizando métricas como la entropía de Shannon para cuantificar desviaciones. Por instancia, si un empleado accede a archivos sensibles fuera de horario, el sistema genera alertas priorizadas y sugiere investigaciones forenses automatizadas, integrando herramientas como SIEM (Security Information and Event Management) de proveedores líderes.

Además, la integración con tecnologías blockchain permite la trazabilidad inmutable de transacciones de seguridad. En escenarios de supply chain attacks, Claude verifica la cadena de custodia de software mediante smart contracts, previniendo inyecciones maliciosas como las vistas en el incidente de SolarWinds. Esta sinergia entre IA y blockchain no solo fortalece la integridad, sino que también facilita auditorías compliant con estándares como ISO 27001.

Desde una perspectiva económica, la adopción de Claude podría reducir costos operativos en un 40%, según estimaciones de Anthropic, al minimizar falsos positivos y optimizar flujos de trabajo. Organizaciones en sectores como finanzas y salud, donde la confidencialidad es paramount, se benefician de su encriptación end-to-end y soporte para zero-trust architectures.

Desafíos y Consideraciones Éticas en la Implementación

A pesar de sus avances, la implementación de Claude AI presenta desafíos inherentes a la IA en ciberseguridad. Uno principal es la dependencia de datos de entrenamiento de alta calidad; sesgos en datasets históricos podrían perpetuar discriminaciones en la detección de amenazas. Anthropic mitiga esto mediante auditorías regulares y diversidad en los datos de entrenamiento, cubriendo regiones globales para un enfoque inclusivo.

La privacidad de datos es otro aspecto crítico. Claude opera bajo principios de minimización de datos, procesando información solo cuando es necesario y eliminando trazas post-análisis. Sin embargo, en entornos regulados, las organizaciones deben asegurar compliance con leyes como la LGPD en Latinoamérica, implementando controles de acceso basados en roles (RBAC).

- Riesgos de Sobregeneralización: Modelos como Claude podrían generar alertas excesivas en entornos dinámicos; soluciones incluyen fine-tuning personalizado.

- Interoperabilidad: Requiere APIs estandarizadas para integración con ecosistemas existentes, como Splunk o Elastic Stack.

- Actualizaciones Continuas: Anthropic planea releases trimestrales para adaptar el modelo a nuevas amenazas, como quantum computing risks.

Éticamente, el uso de IA en vigilancia podría erosionar la confianza si no se equilibra con transparencia. Anthropic promueve explicabilidad mediante técnicas como SHAP (SHapley Additive exPlanations), permitiendo a los usuarios entender decisiones del modelo y fomentar accountability.

Aplicaciones Prácticas en Industrias Específicas

En el sector financiero, Claude AI excels en la detección de fraudes transaccionales. Analizando patrones de comportamiento en tiempo real, identifica anomalías en pagos electrónicos con precisión subsegundo, integrándose con sistemas como SWIFT para verificación global. Esto es vital en Latinoamérica, donde el cibercrimen financiero crece un 25% anual, según reportes de Interpol.

Para la industria manufacturera, especialmente en entornos IIoT (Industrial Internet of Things), Claude monitorea PLC (Programmable Logic Controllers) por signos de manipulación, previniendo sabotajes como Stuxnet. Su capacidad para procesar datos sensoriales fusionados con logs de red asegura resiliencia operativa.

En salud, la herramienta protege EHR (Electronic Health Records) contra brechas, utilizando encriptación homomórfica para análisis sin descifrar datos. Esto alinea con regulaciones como HIPAA, reduciendo riesgos de exposición de información sensible en telemedicina.

Adicionalmente, en telecomunicaciones, Claude optimiza la seguridad de 5G networks, detectando jamming attacks y configurando dinámicamente slices de red seguros. Su escalabilidad soporta el volumen de datos en edge computing, un pilar de las smart cities emergentes en la región.

Comparación con Otras Soluciones de IA en Ciberseguridad

Comparado con competidores como IBM Watson o Google Cloud Security AI, Claude destaca por su enfoque en alineación ética, reduciendo alucinaciones en outputs críticos. Mientras Watson enfatiza analytics predictivos, Claude integra blockchain para verificación, ofreciendo una capa adicional de confianza.

En benchmarks como el Common Vulnerabilities and Exposures (CVE) dataset, Claude logra un F1-score de 0.92, superior al 0.85 de modelos open-source como BERT adaptados. Su eficiencia energética, consumiendo 30% menos recursos que GPT-4 equivalents, lo hace viable para deployments en países en desarrollo con limitaciones infraestructurales.

No obstante, la curva de aprendizaje para integración podría ser más pronunciada que en soluciones plug-and-play, requiriendo expertise en DevSecOps.

Perspectivas Futuras y Evolución de Claude AI

Looking ahead, Anthropic vislumbra evoluciones en Claude hacia multimodalidad, incorporando visión computacional para análisis de imágenes forenses, como en incidentes de malware visual. Integraciones con quantum-safe cryptography prepararán el terreno para la era post-cuántica, donde algoritmos como Shor’s amenazan encriptaciones actuales.

Colaboraciones con entidades latinoamericanas, como el CERT de Brasil o México, podrían adaptar Claude a amenazas regionales, como ciberespionaje en elecciones. Esto fomentaría una ciberseguridad inclusiva, democratizando acceso a IA avanzada.

En resumen, el lanzamiento de Claude AI marca un hito en la convergencia de IA, ciberseguridad y blockchain, equipando a las organizaciones con herramientas robustas para navegar un ecosistema digital volátil.

Conclusiones

El despliegue de Claude AI por Anthropic no solo eleva las capacidades técnicas en ciberseguridad, sino que establece un estándar para el desarrollo responsable de IA. Al priorizar seguridad, ética y escalabilidad, esta innovación empodera a las entidades a mitigar riesgos emergentes de manera proactiva. Las implicaciones a largo plazo sugieren una transformación en cómo se gestionan las defensas digitales, promoviendo un entorno más seguro y equitativo en la era de las tecnologías emergentes.

Para más información visita la Fuente original.