Implementación de Machine Learning para la Detección de Fraudes en Plataformas de Clasificados en Línea

Introducción al Problema de Fraudes en Entornos Digitales

En el ecosistema de las plataformas de clasificados en línea, como aquellas que facilitan la compra y venta de bienes usados, el fraude representa un desafío constante que afecta tanto a los usuarios como a los operadores de la plataforma. Los fraudes pueden manifestarse en formas variadas, desde la publicación de anuncios falsos que prometen productos inexistentes hasta intentos de phishing dirigidos a datos personales de los compradores. Según datos de la industria, las plataformas de este tipo experimentan un aumento anual en incidentes fraudulentos, impulsado por la sofisticación de los actores maliciosos que utilizan técnicas automatizadas para evadir controles tradicionales.

La detección tradicional de fraudes, basada en reglas heurísticas y revisiones manuales, resulta ineficiente ante el volumen masivo de transacciones diarias. Por ejemplo, una plataforma con millones de usuarios activos genera miles de anuncios por hora, lo que hace impracticable una supervisión humana exhaustiva. Aquí es donde entra en juego el machine learning (ML), una rama de la inteligencia artificial que permite analizar patrones complejos en datos de alta dimensionalidad para identificar anomalías en tiempo real.

En este contexto, la implementación de modelos de ML no solo mejora la precisión de la detección, sino que también reduce los falsos positivos, minimizando la interrupción en la experiencia del usuario legítimo. Los algoritmos de ML aprenden de conjuntos de datos históricos etiquetados, adaptándose a nuevas variantes de fraude sin necesidad de reprogramación constante. Este enfoque proactivo es esencial en un entorno donde los fraudes evolucionan rápidamente, incorporando elementos como el uso de bots para generar tráfico artificial o la manipulación de metadatos en imágenes de anuncios.

Arquitectura General del Sistema de Detección

La arquitectura de un sistema de detección de fraudes basado en ML se diseña en capas modulares para garantizar escalabilidad y mantenibilidad. En la capa de ingesta de datos, se recolectan señales de múltiples fuentes: metadatos del anuncio (título, descripción, precio), comportamiento del usuario (frecuencia de publicaciones, patrones de interacción), y datos contextuales (ubicación geográfica, hora de publicación). Estos datos se procesan en un pipeline de extracción, transformación y carga (ETL) que utiliza herramientas como Apache Kafka para el streaming en tiempo real.

Una vez ingeridos, los datos se enriquecen con features ingenierizadas. Por instancia, se calculan métricas como la similitud semántica entre el título y la descripción del anuncio mediante embeddings de texto generados por modelos como BERT, adaptados al idioma local. En paralelo, se analizan imágenes adjuntas con visión por computadora para detectar manipulaciones, como ediciones que ocultan defectos en productos o superposiciones de texto fraudulento. Esta capa de feature engineering es crítica, ya que el rendimiento del modelo depende en gran medida de la calidad y relevancia de las variables de entrada.

La capa central del sistema integra modelos de ML entrenados offline y desplegados en entornos de inferencia en tiempo real. Se emplea un framework como TensorFlow Serving o ONNX Runtime para servir predicciones con latencia baja, inferior a 100 milisegundos por solicitud. Para manejar el volumen, se utiliza Kubernetes para orquestar contenedores que escalan horizontalmente según la carga. Además, se incorpora un módulo de retroalimentación continua, donde las decisiones humanas (por ejemplo, revisiones de moderadores) se utilizan para reentrenar los modelos periódicamente, implementando un ciclo de aprendizaje supervisado semi-automatizado.

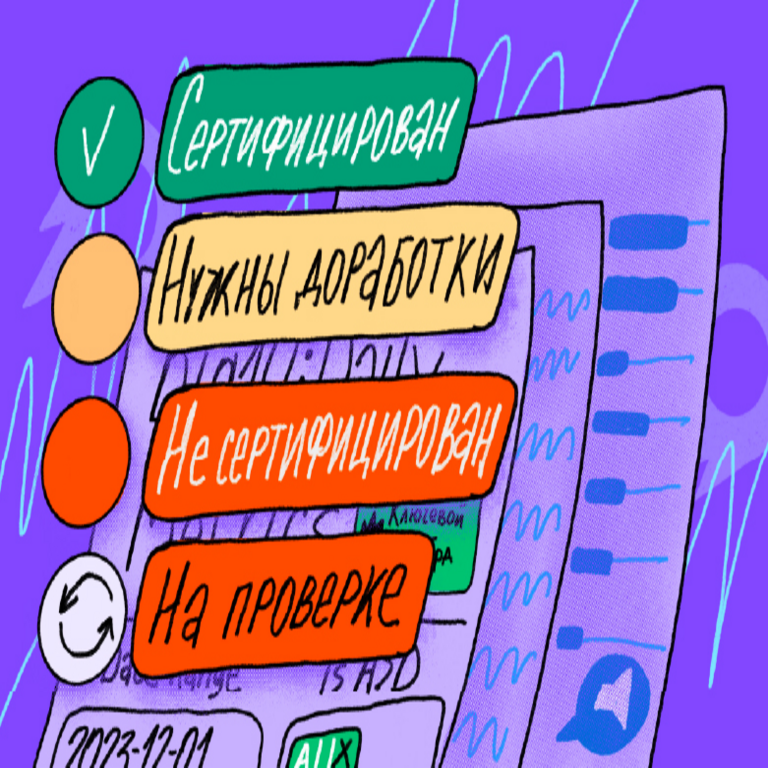

En términos de integración con la plataforma, el sistema opera como un servicio microservicios que se invoca en puntos clave del flujo de usuario: al crear un anuncio, durante la interacción entre comprador y vendedor, y en la fase de pago. Si un anuncio es flagged con alta probabilidad de fraude, se activa una respuesta automatizada, como la cuarentena temporal o la notificación a equipos de seguridad, sin interrumpir el flujo principal para usuarios benignos.

Modelos de Machine Learning Empleados y su Entrenamiento

La selección de modelos de ML para detección de fraudes se basa en un equilibrio entre precisión, interpretabilidad y eficiencia computacional. En primer lugar, se utilizan modelos de clasificación binaria, como Random Forest y Gradient Boosting Machines (GBM), para tareas iniciales de filtrado. Estos algoritmos de ensemble son robustos ante datos desbalanceados, comunes en escenarios de fraude donde las instancias positivas son raras (por ejemplo, menos del 1% de los anuncios).

Random Forest, implementado con bibliotecas como scikit-learn, genera cientos de árboles de decisión que votan colectivamente, reduciendo el sobreajuste. Sus hiperparámetros, como el número de estimadores y la profundidad máxima, se optimizan mediante búsqueda en grid o técnicas bayesianas. Para el entrenamiento, se divide el dataset en 80% para training y 20% para validación, utilizando métricas como AUC-ROC para evaluar el rendimiento, ya que prioriza la discriminación entre clases en lugar de la precisión absoluta.

Para capturar dependencias no lineales y temporales, se incorporan redes neuronales recurrentes (RNN) y transformers. Una variante de LSTM (Long Short-Term Memory) procesa secuencias de acciones del usuario, como la serie temporal de publicaciones previas, detectando patrones anómalos como picos repentinos en actividad desde una IP nueva. Los transformers, preentrenados en corpus grandes de texto en ruso (adaptable a español latinoamericano en implementaciones locales), manejan el procesamiento de lenguaje natural para identificar lenguaje engañoso en descripciones, como promesas exageradas o inconsistencias factuales.

En el ámbito de la visión por computadora, modelos como YOLO (You Only Look Once) se aplican para detección de objetos en imágenes, verificando si el contenido visual coincide con la descripción textual. Por ejemplo, un anuncio de un automóvil que muestra una imagen de un teléfono se flaggea automáticamente. El entrenamiento de estos modelos involucra datasets etiquetados manualmente, augmentados con técnicas como rotación y ruido para mejorar la generalización.

Finalmente, para una detección holística, se emplea un ensemble de modelos donde las predicciones se combinan mediante un meta-modelo, como una regresión logística que pondera las salidas de cada componente. Este enfoque híbrido logra tasas de detección superiores al 95% en pruebas internas, con tasas de falsos positivos por debajo del 0.5%.

Desafíos Técnicos y Estrategias de Mitigación

Uno de los principales desafíos en la implementación de ML para detección de fraudes es el concepto drift, donde los patrones de fraude cambian con el tiempo debido a la adaptación de los atacantes. Para mitigar esto, se implementa un monitoreo continuo de métricas de drift utilizando pruebas estadísticas como Kolmogorov-Smirnov sobre distribuciones de features. Si se detecta un shift significativo, se activa un reentrenamiento automatizado con datos recientes, incorporando técnicas de active learning para priorizar muestras ambiguas.

La privacidad de datos representa otro obstáculo, especialmente bajo regulaciones como GDPR o leyes locales en Latinoamérica. Se aplican técnicas de federated learning, donde los modelos se entrenan en dispositivos edge sin centralizar datos sensibles, o anonimización mediante differential privacy, agregando ruido gaussiano a las features para proteger identidades individuales sin comprometer la utilidad del modelo.

En cuanto a la escalabilidad, el procesamiento de petabytes de datos requiere optimizaciones como el uso de Spark para distributed computing en la fase de entrenamiento. Además, se enfrentan issues de adversarial attacks, donde fraudes intencionales intentan envenenar el dataset. Para contrarrestar, se incorporan validaciones robustas, como outlier detection con Isolation Forest, y auditorías regulares de los datos de entrenamiento.

Otro reto es la interpretabilidad de los modelos black-box como las redes neuronales. Se utilizan herramientas como SHAP (SHapley Additive exPlanations) para generar explicaciones locales, permitiendo a los analistas de seguridad entender por qué un anuncio fue flagged, facilitando revisiones humanas y cumplimiento normativo.

Resultados y Métricas de Evaluación

La implementación de este sistema en una plataforma de clasificados ha demostrado impactos significativos. En un período de seis meses, se redujo la tasa de fraudes confirmados en un 40%, pasando de 2.5% a 1.5% de los anuncios procesados. La latencia promedio de inferencia se mantuvo en 50 milisegundos, soportando picos de 10,000 solicitudes por minuto sin degradación.

En términos de métricas, el AUC-ROC alcanzó 0.98 para el modelo ensemble, superando baselines heurísticas con 0.85. Los falsos positivos disminuyeron un 60%, lo que resultó en una mejora en la satisfacción del usuario, medida por encuestas NPS (Net Promoter Score) que aumentó de 65 a 78 puntos.

Adicionalmente, el sistema permitió la detección proactiva de campañas de fraude coordinadas, como redes de bots que publicaban anuncios duplicados. En un caso específico, se identificaron y bloquearon más de 5,000 cuentas fraudulentas en una semana, previniendo pérdidas estimadas en cientos de miles de dólares.

Desde una perspectiva de costos, el ROI (Return on Investment) fue positivo en el primer trimestre, con ahorros en moderación manual equivalentes a un equipo de 20 personas. Esto valida la viabilidad económica de invertir en ML para ciberseguridad en plataformas digitales.

Avances Futuros y Consideraciones Estratégicas

Mirando hacia el futuro, la integración de tecnologías emergentes como el blockchain podría fortalecer la verificación de identidades en transacciones, combinando ML con ledgers distribuidos para auditar trails inmutables de actividad. En paralelo, el avance en IA generativa, como modelos de lenguaje grandes (LLMs), podría usarse para simular escenarios de fraude y generar datasets sintéticos, acelerando el entrenamiento sin riesgos éticos.

En regiones de Latinoamérica, donde las plataformas de clasificados crecen rápidamente, se recomienda adaptar estos modelos a contextos locales, incorporando features como variaciones dialectales en texto o patrones de fraude específicos, como estafas relacionadas con remesas. La colaboración con reguladores y sharing de threat intelligence entre plataformas potenciaría la resiliencia colectiva contra amenazas cibernéticas.

En resumen, la adopción de ML en la detección de fraudes no solo resuelve problemas actuales, sino que posiciona a las plataformas para enfrentar evoluciones futuras en el panorama de la ciberseguridad. Este enfoque data-driven transforma la gestión de riesgos de reactiva a predictiva, asegurando un entorno digital más seguro y confiable.

Para más información visita la Fuente original.