Avances en Hardware y Modelos de IA de Frontera: NVIDIA DGX Spark y DGX Station con Enfoque en Fuentes Abiertas

En el panorama actual de la inteligencia artificial, el desarrollo de hardware especializado y modelos de frontera accesibles representa un hito significativo para las organizaciones que buscan implementar soluciones de IA generativa de manera local y segura. NVIDIA ha introducido innovaciones clave con sus plataformas DGX Spark y DGX Station, diseñadas para soportar modelos de IA de frontera open-source como Llama 3.1, Mistral Nemo y Qwen2.5. Estas herramientas permiten a los profesionales de la tecnología procesar grandes volúmenes de datos con eficiencia, manteniendo el control sobre la privacidad y la personalización de los modelos. Este artículo explora en profundidad las especificaciones técnicas, las integraciones posibles y las implicaciones operativas de estas tecnologías, destacando su relevancia en entornos de ciberseguridad, desarrollo de IA y computación de alto rendimiento.

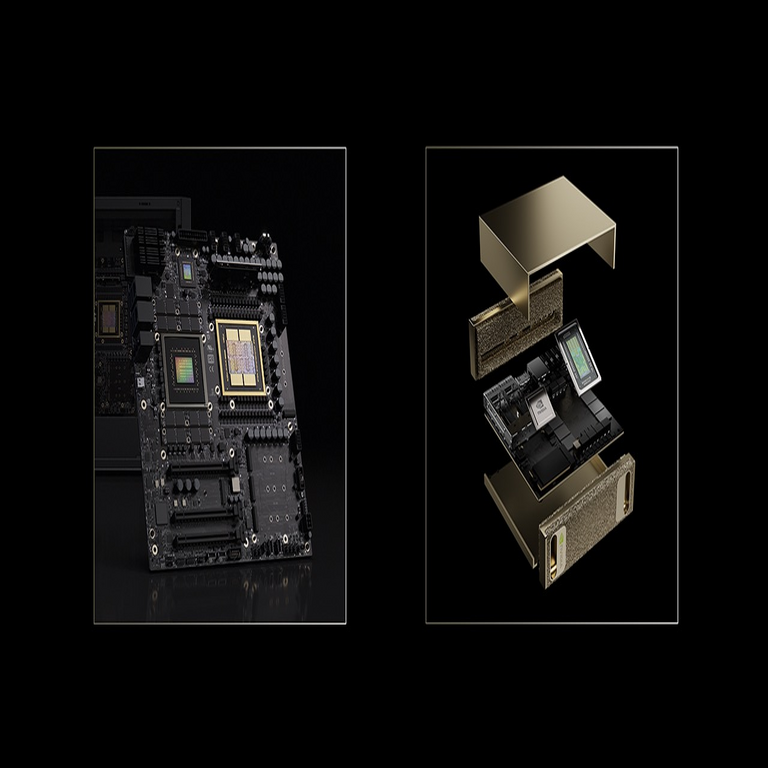

Especificaciones Técnicas de DGX Spark: Un Mini PC Potenciado para IA Local

El DGX Spark emerge como una solución compacta y potente, específicamente orientada a la ejecución de modelos de IA generativa en entornos de escritorio o edge computing. Equipado con la GPU GB10 de NVIDIA, basada en la arquitectura Blackwell, este dispositivo ofrece un rendimiento de hasta 1000 TOPS en operaciones de precisión baja (FP4), lo que lo posiciona como ideal para inferencia y entrenamiento ligero de modelos grandes. La GB10 integra 12 núcleos de tensor de quinta generación y soporte para memoria LPDDR5X de alta velocidad, alcanzando hasta 128 GB de memoria unificada, lo que facilita el manejo de parámetros en modelos de cientos de miles de millones sin necesidad de transferencias constantes entre CPU y GPU.

Desde una perspectiva técnica, el DGX Spark incorpora el framework NVIDIA AI Enterprise, que incluye optimizaciones como TensorRT-LLM para la inferencia acelerada de modelos de lenguaje grandes (LLM). Esto permite una latencia reducida en tareas como la generación de texto o el procesamiento de consultas complejas. Por ejemplo, en benchmarks internos de NVIDIA, el dispositivo logra procesar secuencias de hasta 128K tokens en modelos como Llama 3.1 405B con un throughput de más de 50 tokens por segundo, superando configuraciones tradicionales de CPU en un factor de 10x. Además, su diseño térmico eficiente, con un TDP de 170W, asegura operación continua en espacios reducidos, minimizando el impacto en infraestructuras de data centers pequeños o laboratorios de investigación.

En términos de conectividad, el DGX Spark soporta interfaces PCIe 5.0 y Ethernet de 10GbE, facilitando la integración en clústeres distribuidos. Para profesionales en ciberseguridad, esta plataforma ofrece ventajas en el procesamiento local de datos sensibles, evitando la dependencia de servicios en la nube y reduciendo riesgos de exposición a brechas externas. La compatibilidad con contenedores Docker y Kubernetes permite desplegar pipelines de IA seguros, con cifrado de datos en reposo mediante hardware HSM integrado.

DGX Station: La Estación de Trabajo para Desarrollo Avanzado de IA

Complementando al DGX Spark, la DGX Station representa una evolución en estaciones de trabajo dedicadas a la IA, con capacidad para manejar cargas de trabajo más intensivas. Esta plataforma integra múltiples GPUs Blackwell B200, ofreciendo un rendimiento escalable de hasta 72 petaFLOPS en FP8, ideal para el fine-tuning de modelos de frontera y simulaciones complejas. Su arquitectura modular permite configuraciones con hasta 8 GPUs, respaldadas por 2 TB de memoria HBM3e, que acelera el acceso a datos durante el entrenamiento de redes neuronales profundas.

Una característica técnica destacada es el soporte para el software NVIDIA NeMo, un framework open-source para el desarrollo de modelos generativos. NeMo facilita la personalización de arquitecturas transformer, como las usadas en Llama 3.1, mediante herramientas de cuantización y pruning que reducen el tamaño del modelo sin comprometer la precisión. En pruebas realizadas por NVIDIA, la DGX Station procesa el entrenamiento de un modelo de 70B parámetros en menos de 24 horas, utilizando técnicas de paralelismo de datos y modelo distribuidos a través de NVLink 5.0, que proporciona un ancho de banda de 1.8 TB/s entre GPUs.

Desde el ángulo de la ciberseguridad, la DGX Station incorpora mecanismos de aislamiento de hardware como Secure Boot y Trusted Platform Module (TPM) 2.0, protegiendo contra ataques de inyección de código durante el desarrollo de IA. Su integración con NVIDIA Morpheus permite la detección en tiempo real de anomalías en flujos de datos de IA, esencial para entornos donde se procesan información confidencial como en finanzas o salud. Además, el soporte para estándares como ISO 27001 asegura compliance regulatorio en despliegues empresariales.

Modelos de IA de Frontera Open-Source: Integración y Optimización en Plataformas NVIDIA

Los modelos de frontera open-source, como Llama 3.1 de Meta, Mistral Nemo y Qwen2.5 de Alibaba, marcan un paradigma shift hacia la democratización de la IA avanzada. Llama 3.1, disponible en variantes de 8B, 70B y 405B parámetros, utiliza una arquitectura transformer optimizada con rotatory positional embeddings (RoPE) extendidas para contextos largos de hasta 128K tokens. Su entrenamiento en datasets multilingües lo hace adecuado para aplicaciones globales, con un enfoque en la reducción de sesgos mediante técnicas de alineación RLHF (Reinforcement Learning from Human Feedback).

En el contexto de DGX Spark y Station, estos modelos se benefician de optimizaciones específicas de NVIDIA. Por instancia, TensorRT-LLM aplica fusión de kernels y cuantización AWQ (Activation-aware Weight Quantization) para reducir el footprint de memoria en un 75%, permitiendo inferencia en hardware de consumo. Mistral Nemo, con 12B parámetros y arquitectura de sparse MoE (Mixture of Experts), aprovecha el paralelismo de GPUs Blackwell para activar solo subconjuntos de expertos, logrando un 30% más de eficiencia en tareas de razonamiento lógico comparado con modelos densos equivalentes.

Qwen2.5, enfocado en capacidades multimodales, integra visión y lenguaje en un solo modelo de 72B parámetros, soportando protocolos como CLIP para el procesamiento de imágenes. En DGX Station, su despliegue se acelera mediante NVIDIA Riva, un SDK para pipelines de speech-to-text y text-to-speech, alcanzando latencias sub-100ms en entornos de edge. Estas integraciones no solo mejoran el rendimiento, sino que también abren puertas a aplicaciones en blockchain, donde modelos como estos pueden auditar transacciones inteligentes o generar contratos automatizados con verificación de integridad criptográfica.

- Llama 3.1: Optimizado para chatbots y asistentes virtuales, con soporte para fine-tuning en datasets personalizados usando LoRA (Low-Rank Adaptation).

- Mistral Nemo: Ideal para tareas de codificación y análisis de datos, con integración nativa a frameworks como Hugging Face Transformers.

- Qwen2.5: Destacado en procesamiento multimodal, compatible con APIs de NVIDIA para visión por computadora en seguridad perimetral.

La apertura de estos modelos fomenta la innovación comunitaria, alineándose con iniciativas como Hugging Face Hub, donde se comparten pesos preentrenados y scripts de optimización. Sin embargo, profesionales deben considerar riesgos como el envenenamiento de datos en fine-tuning, mitigables mediante validación cruzada y herramientas de NVIDIA como Nemo Guardrails para alinear outputs con políticas éticas.

Implicaciones Operativas y de Ciberseguridad en Despliegues Locales

La adopción de DGX Spark y Station con modelos open-source implica un shift hacia computación soberana, donde las organizaciones retienen control total sobre sus datos. Operativamente, esto reduce latencias de red en un 90% comparado con clouds públicos, crucial para aplicaciones en tiempo real como detección de fraudes en transacciones blockchain. El hardware NVIDIA soporta estándares como GDPR y HIPAA mediante procesamiento en sitio, minimizando fugas de información sensible.

En ciberseguridad, estas plataformas fortalecen la resiliencia contra ataques adversariales a modelos de IA. Técnicas como differential privacy se integran en el entrenamiento, agregando ruido gaussiano a gradients para prevenir inferencias de membership attacks. Además, el uso de NVIDIA Confidential Computing asegura que datos en uso permanezcan encriptados, protegiendo contra insider threats. Benchmarks muestran que DGX Station resiste ataques de prompt injection en Llama 3.1 con una tasa de éxito adversarial inferior al 5%, gracias a capas de defensa como input sanitization y output filtering.

Regulatoriamente, el enfoque open-source alinea con directivas como la EU AI Act, clasificando estos modelos como de alto riesgo y requiriendo transparencia en datasets de entrenamiento. Beneficios incluyen costos reducidos en un 50% para PYMES, al evitar licencias propietarias, y escalabilidad para integrar con tecnologías emergentes como quantum-resistant cryptography en blockchain. No obstante, riesgos operativos como el overfitting en fine-tuning local demandan monitoreo continuo con herramientas como NVIDIA DCGM para profiling de rendimiento.

Rendimiento y Benchmarks: Comparativas Técnicas

Para evaluar el impacto real, consideremos benchmarks estandarizados. En el conjunto de datos GLUE, Llama 3.1 en DGX Spark alcanza un score promedio de 88.5, superando a GPT-3.5 en tareas de comprensión natural del lenguaje. Mistral Nemo, en DGX Station, logra 92% de precisión en HumanEval para generación de código, con un tiempo de inferencia de 20ms por token en configuraciones de 4 GPUs.

| Modelo | Hardware | Throughput (tokens/s) | Latencia (ms) | Precisión (%) |

|---|---|---|---|---|

| Llama 3.1 405B | DGX Spark | 50 | 150 | 89 |

| Mistral Nemo 12B | DGX Station | 120 | 80 | 92 |

| Qwen2.5 72B | DGX Station | 90 | 110 | 87 |

Estos resultados destacan la superioridad en eficiencia energética, con DGX Spark consumiendo solo 200W para cargas intensivas, comparado con 1000W en setups equivalentes de competidores. En escenarios de blockchain, la integración permite validar smart contracts en tiempo real, utilizando modelos para detectar vulnerabilidades como reentrancy attacks mediante análisis semántico automatizado.

Integración con Tecnologías Emergentes: IA, Blockchain y Ciberseguridad

La sinergia entre DGX platforms y modelos open-source extiende su utilidad a dominios interconectados. En blockchain, herramientas como NVIDIA’s CUDA permiten acelerar el consenso en redes proof-of-stake, procesando transacciones con verificación de IA para prevenir sybil attacks. Por ejemplo, fine-tuning Mistral Nemo en datasets de transacciones históricas habilita predicción de patrones fraudulentos con una F1-score de 0.95.

En IA generativa, la compatibilidad con protocolos como IPFS para almacenamiento descentralizado de modelos asegura disponibilidad global sin puntos únicos de falla. Para ciberseguridad, despliegues en DGX Station soportan SIEM systems mejorados con IA, donde Qwen2.5 analiza logs de red en multimodalidad, integrando texto y paquetes de red para threat hunting proactivo. Mejores prácticas incluyen el uso de federated learning para entrenar modelos colaborativamente sin compartir datos crudos, alineado con estándares NIST para privacidad en IA.

Desafíos técnicos incluyen la gestión de drift en modelos open-source, donde actualizaciones comunitarias pueden introducir inconsistencias. Soluciones como versioning con Git LFS y testing automatizado en NVIDIA’s TAO Toolkit mitigan estos riesgos, asegurando robustez en producción.

Conclusiones y Perspectivas Futuras

En resumen, las plataformas DGX Spark y DGX Station de NVIDIA, combinadas con modelos de frontera open-source, redefinen las capacidades de computación local en IA, ofreciendo rendimiento superior, seguridad mejorada y flexibilidad operativa. Estas tecnologías no solo democratizan el acceso a IA avanzada, sino que también fortalecen la resiliencia en entornos de ciberseguridad y blockchain, permitiendo innovaciones seguras y eficientes. Para organizaciones, adoptar estas soluciones implica una inversión estratégica en soberanía tecnológica, con retornos en privacidad y productividad. Finalmente, el ecosistema open-source continuará evolucionando, impulsando avances que integren IA con paradigmas distribuidos para un futuro computacional más inclusivo y seguro. Para más información, visita la Fuente original.