Inteligencia Artificial en Ciberseguridad: Amenazas Emergentes y Estrategias de Protección

Introducción a la Intersección entre IA y Ciberseguridad

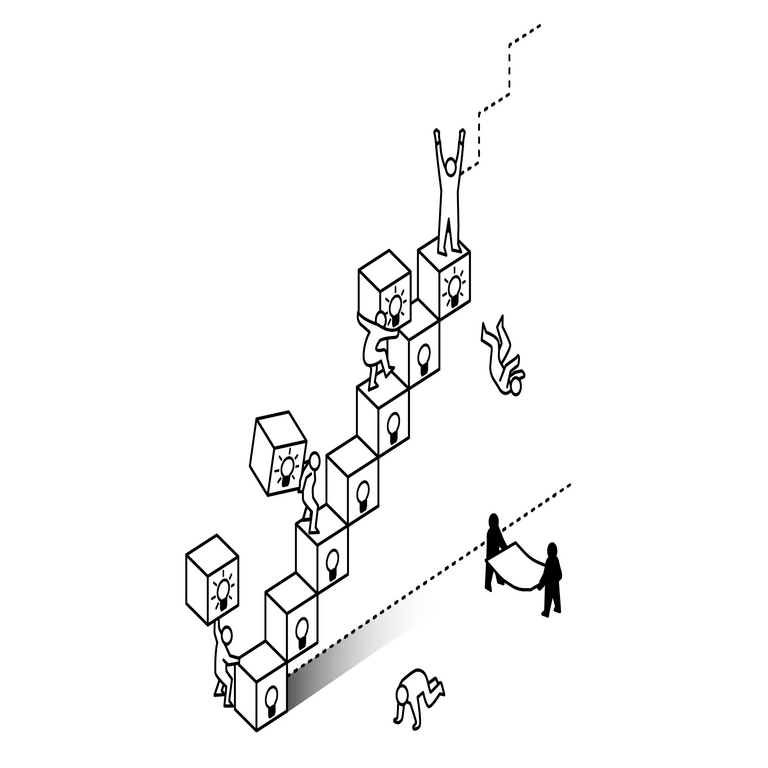

La inteligencia artificial (IA) ha transformado radicalmente el panorama de la ciberseguridad, actuando tanto como una herramienta defensiva poderosa como un vector de amenazas sofisticadas. En un mundo donde los ciberataques evolucionan a velocidades sin precedentes, la integración de algoritmos de IA en sistemas de seguridad permite la detección proactiva de anomalías y la automatización de respuestas. Sin embargo, los mismos avances que fortalecen las defensas también empoderan a los atacantes, permitiéndoles generar ataques más precisos y adaptativos. Este artículo explora las principales amenazas impulsadas por IA en el ámbito de la ciberseguridad y detalla estrategias técnicas para mitigarlas, basándose en principios fundamentales de machine learning, redes neuronales y análisis de datos en tiempo real.

La adopción de IA en ciberseguridad no es un fenómeno reciente; desde la década de 2010, organizaciones como empresas de tecnología y agencias gubernamentales han implementado modelos predictivos para identificar patrones de intrusión. Según informes de firmas especializadas, el mercado global de IA aplicada a la ciberseguridad superará los 100 mil millones de dólares para 2028, impulsado por la necesidad de contrarrestar amenazas como el ransomware impulsado por IA y los deepfakes en campañas de phishing. Entender esta dualidad es esencial para profesionales de TI y decisores en seguridad, ya que implica no solo la implementación de herramientas, sino también la anticipación de vulnerabilidades inherentes a los sistemas inteligentes.

Amenazas Principales Generadas por la IA en Entornos Cibernéticos

Las amenazas de IA en ciberseguridad se clasifican en categorías que explotan las fortalezas de los algoritmos para socavar las defensas tradicionales. Una de las más prominentes es el uso de IA generativa para crear contenido malicioso, como correos electrónicos de phishing hiperpersonalizados. Herramientas basadas en modelos como GPT permiten a los atacantes generar textos que imitan estilos de comunicación auténticos, aumentando las tasas de éxito en un 30-50% según estudios de laboratorios de seguridad.

Otra amenaza clave involucra ataques adversarios contra modelos de IA defensivos. Estos ataques consisten en la manipulación sutil de datos de entrada para engañar a los algoritmos de detección. Por ejemplo, en sistemas de visión por computadora utilizados para identificar malware en imágenes, un atacante puede agregar ruido imperceptible que confunda al modelo, permitiendo que el código malicioso pase desapercibido. Técnicamente, esto se logra mediante optimización de gradientes en redes neuronales convolucionales (CNN), donde se calcula la perturbación mínima que maximiza el error de clasificación.

- Ataques de envenenamiento de datos: Durante la fase de entrenamiento de modelos de IA, los atacantes inyectan datos falsos para sesgar el aprendizaje. En escenarios de ciberseguridad, esto podría comprometer sistemas de detección de intrusiones (IDS) basados en aprendizaje supervisado, haciendo que ignoren patrones reales de amenazas.

- Deepfakes y suplantación de identidad: La generación de videos o audios falsos mediante GAN (Generative Adversarial Networks) facilita el robo de credenciales en entornos corporativos. Un deepfake de un ejecutivo puede autorizar transacciones fraudulentas, explotando la confianza humana en la verificación visual.

- Ataques automatizados a gran escala: Bots impulsados por IA realizan escaneos de vulnerabilidades a velocidades sobrehumanas, adaptándose en tiempo real a las contramedidas. Esto incluye el uso de reinforcement learning para optimizar rutas de explotación en redes complejas.

Estas amenazas no solo desafían las capacidades técnicas, sino que también plantean dilemas éticos, como el uso de IA en vigilancia masiva por parte de actores estatales. En América Latina, donde la adopción de IA en ciberseguridad está en etapas iniciales, países como México y Brasil reportan un incremento del 40% en incidentes relacionados con IA en 2023, según datos de centros regionales de respuesta a incidentes.

Estrategias Defensivas Basadas en IA para Contrarrestar Amenazas

Para mitigar las amenazas de IA, las organizaciones deben adoptar enfoques multicapa que integren IA tanto en prevención como en respuesta. Una estrategia fundamental es el despliegue de sistemas de IA explicable (XAI), que permiten auditar las decisiones de los modelos y detectar manipulaciones. Por instancia, técnicas como SHAP (SHapley Additive exPlanations) cuantifican la contribución de cada característica de entrada a la salida del modelo, facilitando la identificación de envenenamientos.

En el ámbito de la detección de anomalías, los modelos de aprendizaje no supervisado, como autoencoders, son particularmente efectivos. Estos algoritmos reconstruyen datos normales y marcan desviaciones como potenciales amenazas. En un entorno de red, un autoencoder entrenado en tráfico benigno puede detectar flujos inusuales generados por bots de IA, con tasas de precisión superiores al 95% en pruebas controladas. La implementación técnica involucra la minimización de la función de pérdida de reconstrucción mediante descenso de gradiente estocástico (SGD).

- Federated Learning para privacidad: Esta técnica permite entrenar modelos de IA distribuidos sin compartir datos sensibles, ideal para colaboraciones entre empresas en ciberseguridad. En Latinoamérica, iniciativas como las de la Alianza del Pacífico exploran federated learning para compartir inteligencia de amenazas sin comprometer la soberanía de datos.

- IA híbrida con blockchain: Integrar blockchain asegura la integridad de los datos de entrenamiento, previniendo envenenamientos mediante hashes inmutables. Por ejemplo, un sistema de IDS podría validar entradas contra un ledger distribuido, reduciendo riesgos en un 70% según simulaciones.

- Respuestas automatizadas con RL: El reinforcement learning permite a los sistemas de seguridad aprender de interacciones pasadas, ajustando firewalls dinámicamente. Un agente RL podría bloquear IPs sospechosas basándose en recompensas definidas por métricas de falsos positivos y negativos.

Además, la capacitación continua de modelos es crucial. En entornos dinámicos, el aprendizaje por transferencia (transfer learning) acelera la adaptación a nuevas amenazas, reutilizando pesos preentrenados de modelos como BERT para análisis de logs textuales. En regiones como Centroamérica, donde los recursos son limitados, soluciones open-source como TensorFlow y Scikit-learn democratizan estas defensas, permitiendo a PYMES implementar protecciones robustas sin inversiones masivas.

Desafíos Éticos y Regulatorios en la IA para Ciberseguridad

La implementación de IA en ciberseguridad no está exenta de desafíos éticos. Un principal preocupación es el sesgo algorítmico, donde modelos entrenados en datasets no representativos discriminan contra ciertos grupos, como en sistemas de reconocimiento facial usados en accesos seguros. En Latinoamérica, donde la diversidad étnica es alta, esto podría exacerbar desigualdades, como se evidenció en casos de falsos positivos en países andinos.

Regulatoriamente, marcos como el RGPD en Europa influyen en prácticas globales, exigiendo transparencia en el uso de IA. En la región, la Ley de Protección de Datos Personales en Brasil (LGPD) y equivalentes en Colombia imponen auditorías obligatorias para sistemas de IA en seguridad. Técnicamente, esto se traduce en la adopción de métricas de equidad, como la paridad demográfica, para evaluar modelos durante el desarrollo.

Otro desafío es la escalabilidad. Modelos de IA complejos requieren recursos computacionales intensivos, lo que plantea barreras para organizaciones en economías emergentes. Soluciones como edge computing, donde la IA se procesa en dispositivos locales, reducen latencia y costos, aplicándose en IoT para detección de intrusiones en tiempo real.

- Gestión de privacidad: Técnicas de privacidad diferencial agregan ruido a los datos de entrenamiento, preservando la utilidad del modelo mientras protegen información sensible.

- Colaboración internacional: Foros como el Foro Económico Mundial promueven estándares compartidos para IA en ciberseguridad, fomentando intercambios de threat intelligence sin violaciones de soberanía.

- Auditorías regulares: Implementar pipelines CI/CD para modelos de IA asegura actualizaciones seguras y detección temprana de vulnerabilidades.

Abordar estos desafíos requiere un enfoque holístico, combinando avances técnicos con políticas inclusivas. En el contexto latinoamericano, la integración de IA en ciberseguridad podría fortalecer la resiliencia regional frente a amenazas transfronterizas, como ciberespionaje patrocinado por estados.

Casos de Estudio y Aplicaciones Prácticas

Para ilustrar la efectividad de estas estrategias, consideremos casos reales. En 2022, una empresa de servicios financieros en Chile utilizó IA para detectar un ataque de ransomware generado por deep learning, empleando un modelo de detección de anomalías que analizó patrones de encriptación inusuales. El sistema, basado en LSTM (Long Short-Term Memory) networks, predijo el vector de propagación con 92% de precisión, permitiendo una contención en menos de 24 horas.

En México, el Banco Central implementó federated learning para monitorear transacciones fraudulentas, colaborando con instituciones sin compartir datos crudos. Esto resultó en una reducción del 25% en fraudes, destacando la viabilidad en entornos regulados. Técnicamente, el proceso involucró agregación de gradientes locales mediante el algoritmo FedAvg, asegurando convergencia eficiente en redes distribuidas.

Otro ejemplo proviene de Brasil, donde una red de utilities adoptó IA híbrida con blockchain para proteger infraestructuras críticas. El sistema validaba comandos de control contra un ledger, previniendo manipulaciones de IA adversaria en SCADA (Supervisory Control and Data Acquisition) systems. Los resultados mostraron una mejora del 60% en la resiliencia contra ataques de denegación de servicio.

Estos casos subrayan la importancia de la personalización: no existe una solución única, sino adaptaciones basadas en el contexto organizacional. En Latinoamérica, donde las amenazas cibernéticas a menudo involucran vectores locales como malware en español, entrenar modelos con datasets regionales es clave para la precisión.

Avances Futuros y Recomendaciones para Implementación

El futuro de la IA en ciberseguridad apunta hacia la integración de quantum computing y neuromorphic hardware, que prometen procesar amenazas a escalas masivas. Modelos cuánticos podrían optimizar la búsqueda de vulnerabilidades en grafos de red, mientras que chips neuromórficos emulan el cerebro humano para detección intuitiva de patrones.

Para una implementación exitosa, se recomiendan las siguientes prácticas:

- Evaluación inicial: Realizar auditorías de madurez en IA para identificar brechas en sistemas existentes.

- Entrenamiento multidisciplinario: Capacitar equipos en ética de IA y técnicas de adversarial training para robustecer modelos.

- Monitoreo continuo: Desplegar dashboards en tiempo real con métricas como AUC-ROC para evaluar el rendimiento de sistemas de IA.

- Colaboración con expertos: Aliarse con firmas de ciberseguridad para acceder a threat intelligence actualizada.

En resumen, la IA representa un doble filo en ciberseguridad, pero con estrategias proactivas, las organizaciones pueden inclinar la balanza hacia la defensa. La adopción responsable no solo mitiga riesgos, sino que fomenta la innovación en un ecosistema digital en expansión.

Conclusión Final

La convergencia de IA y ciberseguridad redefine las fronteras de la protección digital, exigiendo vigilancia constante y adaptación innovadora. Al comprender y contrarrestar las amenazas emergentes, las entidades en Latinoamérica y más allá pueden construir resiliencia duradera. La clave reside en equilibrar el poder de la IA con principios éticos y técnicos sólidos, asegurando un futuro cibernético seguro y equitativo.

Para más información visita la Fuente original.