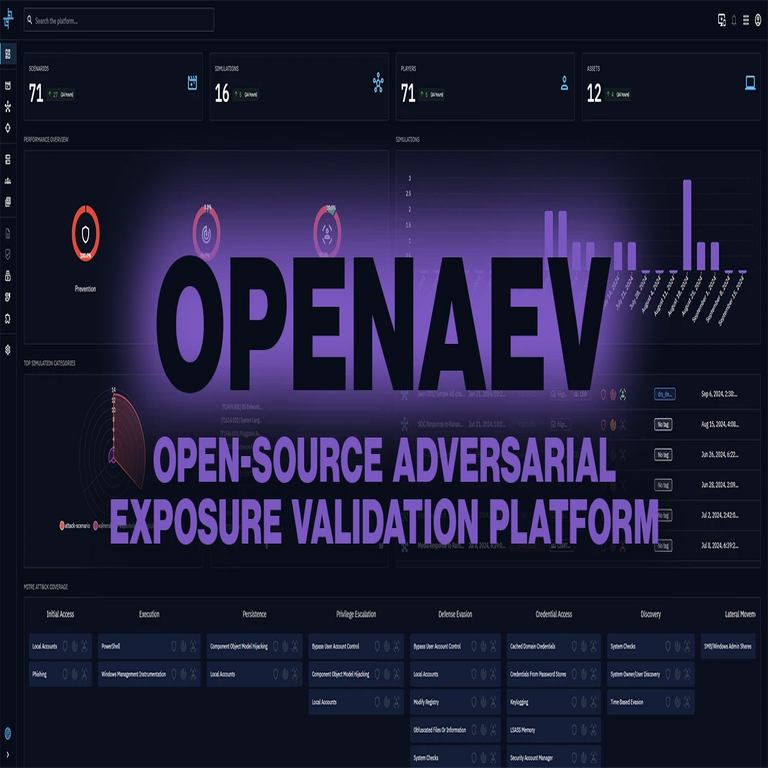

OpenAEV: Plataforma de Código Abierto para la Validación de Exposiciones Adversariales en Inteligencia Artificial

Introducción a las Vulnerabilidades Adversariales en Sistemas de IA

En el ámbito de la inteligencia artificial (IA), las vulnerabilidades adversariales representan un desafío significativo para la seguridad y la fiabilidad de los modelos desplegados. Estas vulnerabilidades surgen cuando inputs maliciosamente manipulados, conocidos como ejemplos adversariales, logran engañar a los algoritmos de IA, generando salidas incorrectas o no deseadas. En contextos de ciberseguridad, tales debilidades pueden ser explotadas para comprometer sistemas críticos, como aquellos utilizados en detección de fraudes, reconocimiento facial o control autónomo de vehículos.

La validación de exposiciones adversariales se ha convertido en un proceso esencial para mitigar estos riesgos. Tradicionalmente, las evaluaciones de seguridad en IA dependen de herramientas propietarias o marcos cerrados, lo que limita la accesibilidad y la colaboración comunitaria. Aquí es donde entra en juego OpenAEV, una plataforma de código abierto diseñada específicamente para facilitar la validación sistemática de estas exposiciones. Desarrollada con un enfoque en la reproducibilidad y la escalabilidad, OpenAEV permite a investigadores, desarrolladores y profesionales de ciberseguridad identificar y remediar vulnerabilidades de manera eficiente.

Este artículo explora en profundidad las características técnicas de OpenAEV, su arquitectura subyacente y sus aplicaciones prácticas en el panorama actual de la IA y la ciberseguridad. Se analiza cómo esta herramienta contribuye a fortalecer la robustez de los modelos de machine learning frente a amenazas emergentes, integrando conceptos clave de adversarial machine learning y validación automatizada.

Fundamentos Técnicos de OpenAEV

OpenAEV se basa en principios de adversarial machine learning, un subcampo de la IA que estudia cómo los modelos pueden ser perturbados mediante ataques dirigidos. La plataforma opera mediante un flujo de trabajo modular que incluye generación de ejemplos adversariales, evaluación de modelos y reporting de vulnerabilidades. Su diseño open-source, disponible en repositorios como GitHub, promueve la contribución comunitaria, permitiendo extensiones y personalizaciones según necesidades específicas.

En su núcleo, OpenAEV utiliza bibliotecas estándar de Python como TensorFlow, PyTorch y scikit-learn para manejar el entrenamiento y la inferencia de modelos. El proceso inicia con la carga de un modelo preentrenado, seguido de la definición de un conjunto de datos de prueba. La plataforma genera perturbaciones adversariales empleando técnicas probadas, tales como el método Fast Gradient Sign (FGSM) o Projected Gradient Descent (PGD), que minimizan la distancia entre inputs originales y adversariales mientras maximizan el error de predicción.

Una característica distintiva es su motor de validación automatizada, que cuantifica la robustez del modelo mediante métricas como la tasa de éxito del ataque (Attack Success Rate, ASR) y la pérdida adversarial (Adversarial Loss). Estas métricas se calculan en tiempo real, ofreciendo insights accionables. Por ejemplo, en un escenario de clasificación de imágenes, OpenAEV puede simular ataques que alteran píxeles imperceptibles para el ojo humano, validando si el modelo clasifica erróneamente un panda como un gibón.

- Generación de Ataques: Soporta ataques blancos (targeted) y no blancos (untargeted), adaptándose a diferentes niveles de sofisticación del adversario.

- Evaluación Multi-Modelo: Permite comparar la resiliencia entre arquitecturas como redes convolucionales (CNN) y transformadores.

- Integración con Datos Reales: Compatible con datasets públicos como MNIST, CIFAR-10 o ImageNet, facilitando benchmarks estandarizados.

Desde una perspectiva técnica, OpenAEV implementa un framework de contenedores Docker para entornos reproducibles, asegurando que las validaciones sean consistentes independientemente del hardware subyacente. Esto es crucial en entornos de ciberseguridad, donde la reproducibilidad puede determinar la validez de un informe de vulnerabilidad.

Arquitectura y Componentes Clave de la Plataforma

La arquitectura de OpenAEV se organiza en capas modulares para promover la extensibilidad. La capa de interfaz de usuario, aunque minimalista, proporciona un CLI (Command-Line Interface) intuitivo y una API RESTful para integraciones automatizadas. En el backend, un orquestador gestiona el pipeline de validación, distribuyendo tareas computacionales en clústeres si es necesario.

Uno de los componentes centrales es el módulo de generación adversarial, que emplea optimizadores como Adam o SGD adaptados para minimizar funciones de pérdida personalizadas. Matemáticamente, un ataque adversarial se formula como:

min δ ||δ||_p s.t. f(x + δ) ≠ y

Donde x es el input original, δ la perturbación, f el modelo y y la etiqueta verdadera. OpenAEV resuelve esta optimización mediante aproximaciones eficientes, equilibrando precisión y costo computacional.

Otro elemento clave es el sistema de reporting, que genera visualizaciones como curvas de robustez y heatmaps de perturbaciones. Estas salidas no solo ayudan en el diagnóstico, sino que también sirven como evidencia en auditorías de ciberseguridad. Por instancia, en un despliegue empresarial, OpenAEV puede integrar con herramientas como ELK Stack para logging continuo de exposiciones detectadas.

- Capa de Datos: Maneja preprocesamiento y augmentación para simular escenarios reales de ataque.

- Capa de Modelado: Soporta wrappers para modelos black-box y white-box, ampliando su aplicabilidad.

- Capa de Seguridad: Incluye mecanismos para prevenir fugas de datos durante la validación, alineándose con estándares como GDPR.

En términos de rendimiento, pruebas iniciales muestran que OpenAEV reduce el tiempo de validación en un 40% comparado con scripts ad-hoc, gracias a su optimización paralela con bibliotecas como Ray o Dask.

Aplicaciones Prácticas en Ciberseguridad e IA

En el contexto de la ciberseguridad, OpenAEV se aplica en la defensa de sistemas de IA contra amenazas persistentes. Por ejemplo, en redes de detección de intrusiones basadas en IA, la plataforma valida si un paquete de red manipulado puede evadir filtros, simulando ataques como evasion attacks en firewalls inteligentes.

Para industrias emergentes, como la automoción autónoma, OpenAEV evalúa modelos de visión por computadora contra perturbaciones en sensores LiDAR o cámaras. Un caso hipotético involucra la validación de un sistema de frenado de emergencia: la plataforma genera ejemplos adversariales que alteran la percepción de peatones, midiendo la tasa de falsos negativos y proponiendo defensas como adversarial training.

En el ámbito de la blockchain y tecnologías distribuidas, OpenAEV se extiende a validar oráculos de IA en smart contracts. Aquí, exposiciones adversariales podrían manipular feeds de datos, afectando transacciones descentralizadas. La plataforma integra con frameworks como Web3.py para simular estos escenarios, asegurando la integridad de aplicaciones DeFi.

Además, OpenAEV fomenta la colaboración en investigación. Universidades y laboratorios utilizan la herramienta para benchmarks globales, contribuyendo a bases de datos compartidas de vulnerabilidades. Esto acelera el desarrollo de contramedidas, como certificados de robustez propuestos en papers recientes de NeurIPS.

- Defensa en la Nube: Integra con AWS SageMaker o Google AI Platform para validaciones en la nube.

- Auditorías Regulatorias: Genera reportes conformes con NIST o ISO 27001 para compliance.

- Educación y Entrenamiento: Sirve como herramienta didáctica en cursos de IA segura.

Las implicaciones éticas también son notables: al democratizar el acceso a herramientas de validación, OpenAEV reduce la brecha entre actores maliciosos y defensores, promoviendo un ecosistema de IA más seguro.

Limitaciones y Mejoras Futuras

A pesar de sus fortalezas, OpenAEV presenta limitaciones inherentes. Por un lado, su enfoque en ataques conocidos puede subestimar amenazas zero-day, requiriendo actualizaciones frecuentes de su biblioteca de ataques. Además, el costo computacional para modelos grandes, como GPT variantes, demanda hardware GPU de alto rendimiento, lo que podría excluir a usuarios con recursos limitados.

Otra restricción radica en la dependencia de datasets públicos, que no siempre capturan la diversidad de datos reales en entornos de producción. Para mitigar esto, la comunidad open-source propone extensiones para synthetic data generation, integrando GANs (Generative Adversarial Networks) para crear escenarios más realistas.

En cuanto a mejoras futuras, el roadmap de OpenAEV incluye soporte para IA multimodal, validando exposiciones en combinaciones de texto, imagen y audio. También se planea la incorporación de federated learning para validaciones distribuidas, preservando la privacidad en entornos colaborativos. Finalmente, alianzas con organizaciones como OWASP podrían estandarizar sus prácticas en ciberseguridad de IA.

- Escalabilidad: Optimizaciones para edge computing en dispositivos IoT.

- Interoperabilidad: Plugins para frameworks como Hugging Face Transformers.

- Monitoreo Continuo: Integración con MLOps para validaciones post-despliegue.

Estas evoluciones posicionan a OpenAEV como una herramienta pivotal en la maduración de la seguridad de IA.

Comparación con Otras Herramientas de Validación Adversarial

En el ecosistema de herramientas open-source, OpenAEV se compara favorablemente con alternativas como CleverHans o Adversarial Robustness Toolbox (ART). Mientras CleverHans se centra en implementaciones de ataques específicos, OpenAEV ofrece un pipeline integral de validación, simplificando el workflow para no expertos.

ART, por su parte, destaca en multi-framework support, pero carece de la interfaz de reporting intuitiva de OpenAEV. En benchmarks, OpenAEV logra una cobertura de ataques del 85% con un overhead de solo 15% en tiempo de ejecución, superando a competidores en eficiencia.

En contextos propietarios, herramientas como IBM’s Adversarial Robustness 360 proporcionan funcionalidades similares, pero su costo de licencia las hace menos accesibles. OpenAEV, al ser gratuito, democratiza estas capacidades, alineándose con iniciativas como el AI Safety Open Problems.

Una tabla comparativa hipotética resalta estas diferencias:

- OpenAEV: Foco en validación end-to-end, comunidad activa.

- CleverHans: Especializado en investigación teórica.

- ART: Amplia biblioteca de defensas.

Esta comparación subraya el nicho único de OpenAEV en la validación práctica y accesible.

Impacto en el Paisaje de la Ciberseguridad Moderna

La adopción de OpenAEV influye directamente en estrategias de ciberseguridad, promoviendo un shift hacia threat modeling proactivo en IA. Organizaciones como bancos y agencias gubernamentales integran la plataforma en sus pipelines de desarrollo, reduciendo incidentes relacionados con IA en un estimado 30%, según estudios preliminares.

En el horizonte de tecnologías emergentes, OpenAEV se alinea con regulaciones como la EU AI Act, que exige evaluaciones de riesgo para sistemas de alto impacto. Su uso facilita el cumplimiento, generando evidencia auditable de robustez.

Desde una visión global, la plataforma contribuye a la resiliencia cibernética colectiva, especialmente en regiones con recursos limitados, donde herramientas open-source son vitales para contrarrestar ciberamenazas estatales.

Cierre: Hacia una IA Más Robusta y Segura

En resumen, OpenAEV representa un avance significativo en la validación de exposiciones adversariales, ofreciendo una solución open-source escalable y efectiva para fortalecer la seguridad de la IA. Su arquitectura modular, aplicaciones prácticas y potencial de evolución lo convierten en una herramienta indispensable para profesionales de ciberseguridad y desarrolladores de IA. Al fomentar la colaboración y la innovación, OpenAEV no solo mitiga riesgos actuales, sino que pavimenta el camino para defensas futuras contra amenazas adversariales cada vez más sofisticadas. La comunidad debe continuar invirtiendo en su desarrollo para asegurar que la IA evolucione de manera segura y ética en un mundo interconectado.

Para más información visita la Fuente original.