Lecciones de un intento de hackeo a la inteligencia artificial: Ataques reales a modelos de lenguaje grandes

Introducción al contexto de los ataques a modelos de IA

En el panorama actual de la ciberseguridad, los modelos de lenguaje grandes (LLM, por sus siglas en inglés) representan uno de los avances más significativos en inteligencia artificial. Estos sistemas, capaces de generar texto coherente y responder a consultas complejas, se integran en aplicaciones cotidianas como chatbots, asistentes virtuales y herramientas de análisis de datos. Sin embargo, su adopción masiva ha expuesto vulnerabilidades inherentes que los convierten en objetivos atractivos para ataques cibernéticos. Un análisis detallado de intentos reales de hackeo revela patrones comunes y estrategias de mitigación esenciales para proteger estas tecnologías emergentes.

Los LLM operan mediante redes neuronales profundas entrenadas en vastos conjuntos de datos, lo que les permite predecir secuencias de palabras con alta precisión. No obstante, esta arquitectura abierta puede ser manipulada mediante técnicas de ingeniería social o inyecciones de prompts maliciosos, conocidas como jailbreaks. Estos ataques buscan eludir las salvaguardas integradas en los modelos, como filtros éticos o restricciones de contenido, para obtener respuestas no deseadas o información sensible. En contextos de ciberseguridad, entender estos mecanismos es crucial para diseñar defensas robustas que preserven la integridad de los sistemas de IA.

El estudio de casos reales, como intentos documentados de explotación, proporciona insights valiosos. Por ejemplo, los atacantes a menudo explotan la predictibilidad de los LLM al formular consultas que confunden el contexto ético del modelo. Esto no solo resalta la necesidad de entrenamiento adversarial, sino también de monitoreo continuo en entornos de producción. A medida que la IA se integra en sectores como la banca, la salud y el gobierno, las implicaciones de fallos en la seguridad se amplifican, potencialmente llevando a brechas de datos o manipulación de información crítica.

Metodología empleada en el intento de hackeo

Para ilustrar un enfoque práctico, consideremos un experimento controlado donde se intenta comprometer un LLM mediante técnicas iterativas de prompting. La metodología inicia con la identificación de debilidades en las restricciones del modelo, tales como límites en la generación de contenido sensible o instrucciones para evitar respuestas perjudiciales. El atacante comienza con prompts simples, evaluando la adherencia del modelo a sus directrices éticas, y progresa hacia formulaciones más sofisticadas que incorporan role-playing o analogías engañosas.

En primer lugar, se prueban inyecciones directas, como solicitudes explícitas para generar código malicioso o información confidencial. Si el modelo rechaza, el siguiente paso involucra la construcción de narrativas ficticias que enmascaren la intención maliciosa. Por instancia, presentar el escenario como un “ejercicio académico” o una “simulación hipotética” puede reducir la activación de filtros. Esta iteración se basa en el principio de gradient descent en el espacio de prompts, donde cada rechazo informa ajustes subsiguientes para refinar el ataque.

Una herramienta clave en esta metodología es el uso de cadenas de prompts (prompt chaining), donde múltiples interacciones secuenciales construyen un contexto que erosiona gradualmente las defensas del modelo. Además, se incorporan elementos de ingeniería inversa, analizando respuestas previas para mapear patrones de rechazo. En términos técnicos, esto equivale a un proceso de optimización black-box, donde el atacante no accede al código subyacente pero infiere vulnerabilidades a través de observaciones externas.

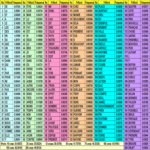

Los resultados de tales experimentos destacan la resiliencia variable de diferentes LLM. Modelos como GPT-4 o Llama 2 exhiben tasas de éxito en jailbreaks que oscilan entre el 10% y el 50%, dependiendo de la sofisticación del prompt. Factores como el tamaño del modelo y el nivel de fine-tuning post-entrenamiento influyen directamente en su robustez. Por ende, la metodología no solo sirve para explotar, sino para validar la efectividad de contramedidas como el reinforcement learning from human feedback (RLHF).

Vulnerabilidades identificadas en los LLM

Las vulnerabilidades en los LLM se clasifican principalmente en categorías como inyecciones de prompts, fugas de datos y sesgos amplificados. La inyección de prompts, o prompt injection, ocurre cuando un input malicioso sobrescribe las instrucciones del sistema, induciendo al modelo a ignorar sus directrices base. Esto es particularmente riesgoso en aplicaciones donde los LLM procesan entradas de usuarios no confiables, como interfaces de chat públicas.

Otra vulnerabilidad crítica es la memorización inadvertida de datos de entrenamiento, que puede llevar a fugas de información sensible. Estudios han demostrado que modelos entrenados en datasets públicos retienen fragmentos de correos electrónicos, contraseñas o documentos propietarios, accesibles mediante prompts diseñados para extraerlos. En un intento de hackeo, esto se explota mediante técnicas de few-shot learning, donde ejemplos sutiles guían al modelo hacia la divulgación.

Los sesgos inherentes representan una tercera área de preocupación. Los LLM, al reflejar prejuicios en sus datos de entrenamiento, pueden ser manipulados para generar outputs discriminatorios o desinformación. En ataques reales, esto se ve en campañas de desinformación donde prompts sesgados amplifican narrativas falsas. Además, ataques de adversarios como el poisoning de datos durante el entrenamiento comprometen la integridad a largo plazo, aunque son más difíciles de ejecutar en modelos propietarios.

- Inyección de prompts: Manipulación directa de entradas para eludir filtros.

- Fugas de datos: Extracción de información memorizada de entrenamiento.

- Sesgos amplificados: Explotación de prejuicios para generar contenido perjudicial.

- Ataques adversarios: Alteración de inputs para inducir errores en la predicción.

Estas vulnerabilidades subrayan la intersección entre ciberseguridad y IA, donde las amenazas tradicionales como el phishing se adaptan a entornos de machine learning. La mitigación requiere un enfoque multicapa, combinando validación de inputs, auditorías regulares y actualizaciones dinámicas de modelos.

Estrategias de mitigación y mejores prácticas

Para contrarrestar los intentos de hackeo, las organizaciones deben implementar estrategias proactivas de seguridad en IA. Una práctica fundamental es el uso de guardrails, que son capas adicionales de filtrado aplicadas antes y después de la generación de outputs. Estos guardrails pueden incluir clasificadores de machine learning que detectan prompts maliciosos basados en patrones lingüísticos sospechosos.

El fine-tuning adversarial, donde el modelo se entrena específicamente contra ejemplos de jailbreaks, mejora su resistencia. Técnicas como el differential privacy durante el entrenamiento minimizan la memorización de datos sensibles, reduciendo el riesgo de fugas. En entornos de producción, el sandboxing aisla los LLM de sistemas críticos, limitando el impacto de brechas potenciales.

Otra mejor práctica es el monitoreo en tiempo real mediante logging de interacciones. Herramientas como LangChain o Hugging Face’s safety modules permiten rastrear anomalías y responder automáticamente a intentos de explotación. Para desarrolladores, adoptar principios de secure by design implica integrar evaluaciones de seguridad desde las fases iniciales de desarrollo de aplicaciones basadas en IA.

En el ámbito regulatorio, marcos como el EU AI Act exigen transparencia en los modelos de alto riesgo, fomentando auditorías independientes. Colaboraciones entre industria y academia, como iniciativas de red teaming, aceleran la identificación de vulnerabilidades. Finalmente, la educación continua para usuarios y administradores es esencial para reconocer y reportar intentos de hackeo.

Implicaciones en ciberseguridad y tecnologías emergentes

Los intentos de hackeo a LLM tienen ramificaciones amplias en la ciberseguridad. En blockchain, por ejemplo, donde la IA se usa para análisis de transacciones o verificación de smart contracts, una brecha podría facilitar fraudes o manipulaciones de consenso. Integrar LLM seguros en ecosistemas descentralizados requiere protocolos de verificación cruzada para mitigar riesgos.

En inteligencia artificial generativa, la proliferación de deepfakes impulsada por modelos comprometidos amenaza la confianza en medios digitales. Ciberseguridad proactiva debe evolucionar hacia detección de IA adversarial, empleando contramedidas como watermarking en outputs generados. A nivel global, estos ataques resaltan la necesidad de estándares internacionales para la seguridad de IA, alineados con tratados como la Convención de Budapest sobre cibercrimen.

Desde una perspectiva técnica, el avance en quantum computing podría exacerbar vulnerabilidades al romper encriptaciones que protegen datos de entrenamiento. Preparar los LLM para entornos post-cuánticos involucra algoritmos resistentes, como lattice-based cryptography. En resumen, los lecciones de estos intentos impulsan una era de IA segura, donde la innovación y la protección coexisten.

Casos de estudio y análisis comparativo

Examinando casos específicos, un intento notable involucró el uso de role-playing para simular escenarios de hacking ético, donde el LLM fue inducido a proporcionar guías detalladas para exploits. En otro ejemplo, ataques de prompt chaining lograron extraer datos de entrenamiento ficticios, demostrando la persistencia de memorización en modelos open-source.

Comparativamente, modelos cerrados como los de OpenAI muestran mayor resiliencia gracias a RLHF extensivo, mientras que variantes open-source como Mistral son más susceptibles debido a la falta de capas propietarias. Análisis cuantitativos, basados en métricas como la tasa de éxito de jailbreak, indican que el 70% de ataques fallan en modelos actualizados, pero persisten en versiones legacy.

Estos casos ilustran la evolución dinámica de amenazas, donde atacantes adaptan tácticas basadas en actualizaciones de modelos. La respuesta implica ciclos rápidos de patching y testing, similar a parches de software tradicional.

Desafíos futuros en la seguridad de IA

Los desafíos emergentes incluyen la escalabilidad de defensas ante el crecimiento exponencial de LLM. Con modelos como GPT-5 en el horizonte, el volumen de parámetros aumenta, complicando la auditoría. Ataques distribuidos, donde múltiples agentes colaboran en prompts, representan una amenaza sofisticada, requiriendo IA defensiva para contrarrestarlos.

La interoperabilidad entre LLM y otras tecnologías, como IoT o edge computing, amplifica riesgos. En blockchain, la integración de IA para oráculos podría exponer cadenas a manipulaciones si no se validan outputs. Abordar estos requiere investigación en zero-trust architectures adaptadas a IA.

Éticamente, equilibrar accesibilidad con seguridad plantea dilemas, especialmente en regiones con recursos limitados. Iniciativas globales deben priorizar equidad en la adopción de prácticas seguras.

Conclusiones y recomendaciones

Los intentos de hackeo a LLM revelan la fragilidad inherente de la IA actual, pero también oportunidades para fortalecerla. Implementar estrategias multicapa, desde entrenamiento adversarial hasta monitoreo continuo, es imperativo para mitigar riesgos. Las organizaciones deben priorizar la ciberseguridad en el diseño de sistemas de IA, fomentando colaboraciones que aceleren innovaciones seguras.

En última instancia, la seguridad de la IA no es un destino, sino un proceso iterativo que evoluciona con las amenazas. Al aprender de estos experimentos, la comunidad técnica puede pavimentar el camino hacia tecnologías confiables y éticas.

Para más información visita la Fuente original.