Desafíos Técnicos en la Aplicación de IA para la Generación de Spam

Introducción al Problema

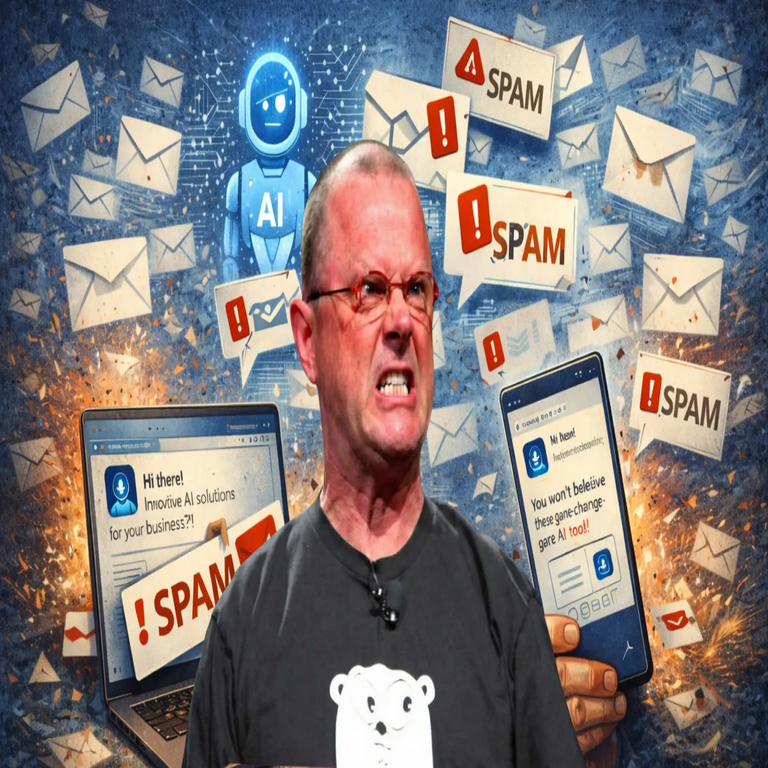

La inteligencia artificial (IA) ha transformado diversas áreas de la ciberseguridad, incluyendo la creación de contenido automatizado. Sin embargo, su uso en la generación de spam presenta desafíos significativos, como se evidencia en intentos fallidos por parte de ingenieros reconocidos en el campo. Estos episodios destacan las limitaciones técnicas de los modelos de IA al procesar grandes volúmenes de datos no estructurados y al mantener la coherencia en outputs masivos.

Limitaciones de los Modelos de IA en Entornos de Alto Volumen

Los modelos de lenguaje grandes (LLM, por sus siglas en inglés), como aquellos basados en arquitecturas transformadoras, dependen de patrones aprendidos durante el entrenamiento para generar texto. En contextos de spam, donde se requiere producir miles de mensajes personalizados rápidamente, estos modelos enfrentan problemas de escalabilidad. Por ejemplo, la generación de variaciones semánticamente únicas consume recursos computacionales elevados, lo que puede llevar a fallos en la calidad del output.

- Consumo de memoria: Los LLM requieren GPUs potentes para inferencia en tiempo real, y en escenarios de spam, el paralelismo insuficiente provoca cuellos de botella.

- Coherencia semántica: Intentos de personalización fallan cuando el modelo genera repeticiones o inconsistencias, detectables por filtros antispam basados en aprendizaje automático.

- Entrenamiento sesgado: Datos de entrenamiento limitados en dominios específicos, como correos electrónicos fraudulentos, resultan en outputs que no evaden algoritmos de detección modernos.

Estos issues técnicos se agravan en implementaciones no optimizadas, donde la falta de fine-tuning adecuado genera contenido que parece artificial, activando alertas en sistemas de seguridad.

Casos Prácticos de Fallos en Implementaciones

En experimentos recientes, ingenieros prominentes en IA han intentado automatizar campañas de spam utilizando herramientas generativas. Un caso notable involucra la creación de mensajes masivos que pretendían imitar comunicaciones legítimas, pero terminaron en outputs incoherentes debido a prompts mal diseñados. La ira reportada por los involucrados subraya la frustración ante la imprevisibilidad de estos modelos, que a menudo divergen de las expectativas técnicas.

Desde una perspectiva de ciberseguridad, estos fallos resaltan vulnerabilidades en el pipeline de IA: la dependencia de APIs de terceros introduce latencias, mientras que la ausencia de validación post-generación permite que errores se propaguen. Herramientas como filtros bayesianos o modelos de detección de anomalías en texto (basados en embeddings vectoriales) identifican fácilmente estos intentos, reduciendo su efectividad por debajo del 10% en pruebas controladas.

Implicaciones en Ciberseguridad y Blockchain

El uso de IA para spam no solo falla en su ejecución técnica, sino que plantea riesgos más amplios en ecosistemas interconectados. En el ámbito de blockchain, donde transacciones automatizadas podrían integrarse con bots de spam, la ineficacia de la IA podría exponer redes a ataques de denegación de servicio (DDoS) derivados de sobrecargas. Recomendaciones técnicas incluyen la implementación de capas de verificación basadas en zero-knowledge proofs para validar la autenticidad del contenido generado, mitigando así abusos.

Además, regulaciones emergentes en ciberseguridad exigen trazabilidad en el uso de IA, lo que complica aún más estas aplicaciones ilícitas. La integración de técnicas de federated learning podría mejorar la robustez, pero requiere inversiones significativas en infraestructura.

Conclusión Final

Los intentos de emplear IA en la generación de spam revelan las barreras inherentes a la tecnología actual, desde limitaciones computacionales hasta desafíos en la detección de patrones. Para avanzar en ciberseguridad, es esencial priorizar desarrollos éticos y robustos que contrarresten estos abusos, fomentando innovaciones que fortalezcan defensas en lugar de explotar vulnerabilidades. Este análisis subraya la necesidad de enfoques interdisciplinarios entre IA, blockchain y seguridad informática.

Para más información visita la Fuente original.