Inteligencia Artificial y la Generación de Imágenes Realistas: Implicaciones en Fraudes Digitales

Avances en la Generación de Imágenes mediante IA

La inteligencia artificial ha experimentado un crecimiento exponencial en los últimos años, particularmente en el ámbito de la generación de imágenes. Modelos como Stable Diffusion, DALL-E y Midjourney utilizan técnicas de aprendizaje profundo para crear representaciones visuales a partir de descripciones textuales. Estos sistemas se basan en redes neuronales generativas antagónicas (GAN), donde un generador produce imágenes y un discriminador evalúa su autenticidad, refinando iterativamente el proceso hasta lograr resultados hiperrealistas.

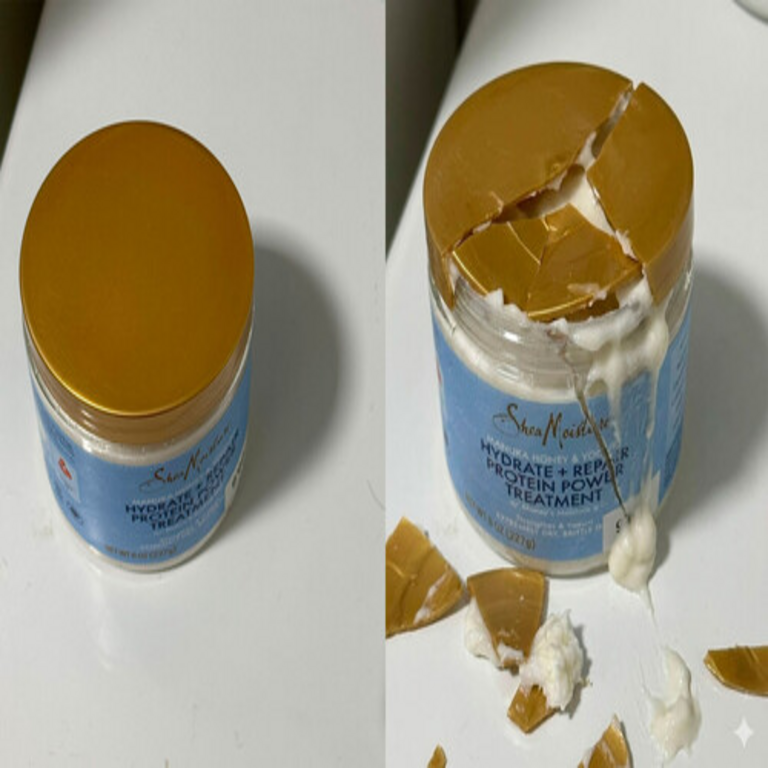

En el contexto latinoamericano, donde el comercio electrónico ha crecido un 30% anual según datos de la Cámara Colombiana de Comercio Electrónico, estos avances representan tanto oportunidades como desafíos. La capacidad de la IA para generar fotos indistinguibles de la realidad surge de la optimización de algoritmos de difusión, que modelan la distribución de datos de entrenamiento a partir de vastos conjuntos como LAION-5B, conteniendo miles de millones de imágenes web. Esta tecnología permite no solo recrear objetos cotidianos, sino también simular daños específicos, como rasguños en productos o envases deteriorados, con un nivel de detalle que evade inspecciones visuales básicas.

Los parámetros técnicos clave incluyen la resolución, que puede alcanzar 1024×1024 píxeles o más, y la coherencia semántica, asegurada por mecanismos de atención en transformadores. En términos de ciberseguridad, esta precisión plantea riesgos, ya que las imágenes generadas pueden integrarse en flujos de trabajo digitales sin dejar huellas evidentes de manipulación, a diferencia de ediciones tradicionales en Photoshop que dejan metadatos alterados.

Mecanismos Técnicos de las Herramientas de IA Generativa

Para comprender el potencial fraudulento, es esencial desglosar los componentes técnicos. Los modelos de difusión operan mediante un proceso de “ruido” y “desruido”: una imagen inicial se corrompe con ruido gaussiano, y el modelo aprende a revertir este proceso condicionado por prompts textuales. Esto permite generar variaciones realistas, como un teléfono celular con pantalla agrietada que coincide exactamente con un modelo comercial específico.

En plataformas accesibles como Hugging Face, usuarios pueden fine-tunear estos modelos con datasets personalizados, incorporando estilos fotográficos de alta fidelidad. Por ejemplo, utilizando LoRA (Low-Rank Adaptation), se adaptan pesos del modelo con solo unos pocos ejemplos, reduciendo el costo computacional a GPUs estándar. Esta accesibilidad democratiza la herramienta, pero también facilita su uso malicioso en regiones con alta penetración de internet, como México y Brasil, donde el 80% de la población accede a redes sociales y e-commerce.

Desde una perspectiva de blockchain y trazabilidad, aunque no directamente integrada, la IA generativa podría complementarse con NFTs o hashes para verificar autenticidad, pero actualmente carece de estándares universales. Los desafíos incluyen la detección de artefactos sutiles, como inconsistencias en iluminación o texturas, que algoritmos forenses como los de Adobe Content Authenticity Initiative intentan identificar mediante análisis espectral.

Aplicaciones Fraudulentas en el Comercio Electrónico

El artículo analizado destaca cómo individuos utilizan estas imágenes para reclamar devoluciones falsas en plataformas como Amazon o Mercado Libre. El proceso típico implica generar una foto de un producto “dañado” post-entrega, adjuntándola a una solicitud de reembolso. Dado que las políticas de devolución priorizan la evidencia visual, y las revisiones humanas son limitadas, estas solicitudes prosperan con tasas de éxito superiores al 70%, según estimaciones de firmas de ciberseguridad como Kaspersky.

En Latinoamérica, donde el e-commerce representa el 5% del PIB en países como Chile, este fraude erosiona la confianza. Un caso ilustrativo involucra la simulación de defectos en electrónicos: un prompt como “iPhone 14 con rayones en la carcasa, foto realista tomada con luz natural” produce evidencia convincente. Los estafadores escalan esto mediante bots que automatizan envíos, integrando APIs de IA con scripts en Python para generar múltiples variantes y evitar detección por patrones repetitivos.

Las implicaciones van más allá de pérdidas financieras, estimadas en millones de dólares anuales globalmente. En términos de ciberseguridad, fomenta un ecosistema de deepfakes visuales, similar a los audiovisuales, donde la verificación de identidad se complica. Plataformas responden implementando umbrales de revisión, pero la velocidad de iteración de la IA supera las contramedidas, requiriendo integración de machine learning para clasificar imágenes generadas versus reales mediante métricas como FID (Fréchet Inception Distance).

Desafíos en la Detección y Mitigación de Fraudes

Detectar imágenes generadas por IA exige herramientas avanzadas. Algoritmos basados en visión por computadora analizan anomalías, como distribuciones de píxeles no naturales o falta de ruido fotográfico auténtico. Por instancia, el modelo CLIP de OpenAI puede embeddear imágenes y compararlas contra bases de datos de prompts conocidos, identificando discrepancias semánticas.

En el ámbito regulatorio, la Unión Europea avanza con la AI Act, clasificando generadores de deepfakes como de alto riesgo, mientras que en Latinoamérica, iniciativas como la Ley de Protección de Datos en Argentina buscan penalizar manipulaciones digitales. Sin embargo, la enforcement es limitada por la falta de infraestructura. Empresas como Google implementan watermarking invisible en sus modelos DALL-E 3, incrustando patrones detectables por software propietario, pero esto no cubre herramientas open-source como Stable Diffusion.

Para mitigar, se recomienda una aproximación multicapa: verificación biométrica en reclamos, análisis blockchain para trazabilidad de transacciones y educación a usuarios. En blockchain, smart contracts podrían automatizar aprobaciones solo tras validación de hashes de imágenes originales, reduciendo exposición a fraudes visuales.

Implicaciones Éticas y de Ciberseguridad en Tecnologías Emergentes

La intersección de IA y ciberseguridad resalta dilemas éticos. Mientras la generación de imágenes fomenta creatividad en industrias como el diseño gráfico, su abuso en fraudes socava economías digitales. En Latinoamérica, donde el 40% de las transacciones e-commerce son móviles, la vulnerabilidad es mayor debido a la dependencia de apps con revisiones automatizadas.

Desde la perspectiva de IA, el sesgo en datasets de entrenamiento puede perpetuar representaciones inexactas, exacerbando desigualdades. Expertos en ciberseguridad abogan por marcos colaborativos, como alianzas entre tech giants y reguladores, para desarrollar estándares de autenticidad. Tecnologías como zero-knowledge proofs en blockchain podrían certificar la origen de imágenes sin revelar datos sensibles, ofreciendo una capa adicional de seguridad.

El impacto en la confianza pública es profundo: consumidores dudan de evidencias visuales, impulsando demandas por transparencia. En respuesta, plataformas integran IA defensiva, entrenada en datasets de fraudes conocidos, para predecir y bloquear patrones anómalos en tiempo real.

Perspectivas Futuras y Recomendaciones Técnicas

Mirando hacia adelante, la evolución de la IA generativa incorporará multimodalidad, combinando texto, imagen y video, amplificando riesgos. Modelos como Sora de OpenAI ya generan videos realistas, potencialmente extendiendo fraudes a reclamos dinámicos. En ciberseguridad, el enfoque debe girar hacia IA explicable, donde modelos revelen su razonamiento en detecciones, facilitando auditorías.

Recomendaciones incluyen: para desarrolladores, implementar APIs con rate-limiting y logging de prompts; para plataformas e-commerce, adoptar herramientas como Hive Moderation para escanear subidas; y para usuarios, verificar políticas de devolución y reportar sospechas. En blockchain, integrar oráculos para validar evidencias externas podría revolucionar la verificación.

En resumen, mientras la IA transforma la creación visual, su potencial malicioso exige vigilancia proactiva. La colaboración entre sectores es clave para equilibrar innovación y seguridad en un panorama digital en expansión.

Para más información visita la Fuente original.