Desarrollo de un Sistema de Inteligencia Artificial para la Generación de Código a Partir de Lenguaje Natural

Introducción al Problema y Motivación

En el ámbito de la programación y el desarrollo de software, la generación automática de código representa un avance significativo que busca optimizar el tiempo de los desarrolladores y reducir errores humanos. La inteligencia artificial (IA), particularmente los modelos de lenguaje grandes (LLM, por sus siglas en inglés), ha emergido como una herramienta poderosa para interpretar descripciones en lenguaje natural y traducirlas en código funcional. Este artículo explora el proceso de creación de un sistema de IA especializado en esta tarea, destacando los desafíos técnicos y las soluciones implementadas.

El enfoque principal radica en la integración de técnicas de procesamiento de lenguaje natural (PLN) con paradigmas de aprendizaje profundo. Tradicionalmente, los programadores dedican una porción considerable de su tiempo a tareas repetitivas, como la escritura de boilerplate o la implementación de algoritmos estándar. Un sistema de IA capaz de generar código a partir de instrucciones verbales podría democratizar el acceso a la programación, permitiendo que no expertos contribuyan en proyectos complejos. Sin embargo, la precisión, la seguridad y la adaptabilidad del código generado son aspectos críticos que deben abordarse desde el diseño inicial.

Arquitectura General del Sistema

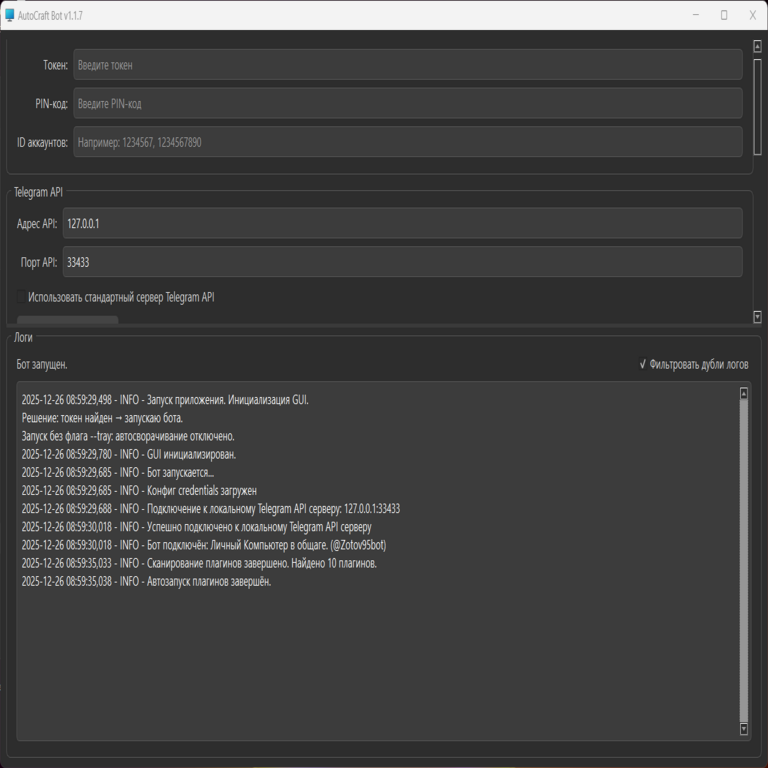

La arquitectura del sistema propuesto se basa en un modelo modular que combina un frontend para la interacción del usuario, un núcleo de IA para el procesamiento y un backend para la validación y ejecución del código generado. En el núcleo, se utiliza un transformer-based model, similar a GPT-3 o variantes open-source como CodeT5, entrenado específicamente en datasets de pares código-descripción.

El flujo de trabajo inicia con la recepción de una consulta en lenguaje natural, por ejemplo: “Crea una función en Python que calcule el factorial de un número entero positivo”. Esta entrada se tokeniza y se pasa a través de capas de atención para capturar dependencias semánticas. El modelo genera una secuencia de tokens que representan el código, la cual se decodifica y refina mediante post-procesamiento para asegurar sintaxis correcta.

- Componente de Entrada: Un parser de lenguaje natural que normaliza la consulta, eliminando ambigüedades mediante técnicas de entity recognition y intent classification.

- Núcleo Generativo: El LLM fine-tuned con datasets como HumanEval o MBPP, que incluyen miles de ejemplos de problemas de programación resueltos.

- Componente de Salida: Un validador que ejecuta el código en un sandbox seguro para verificar funcionalidad y detectar vulnerabilidades.

Esta estructura permite escalabilidad, ya que el modelo puede ajustarse para lenguajes de programación específicos, como Python, JavaScript o Java, mediante transfer learning.

Entrenamiento y Fine-Tuning del Modelo

El entrenamiento de un modelo para generación de código requiere datasets de alta calidad que alineen descripciones textuales con implementaciones correctas. Se emplearon recursos como el dataset de GitHub CodeSearchNet, que contiene más de 2 millones de funciones anotadas, y se complementó con datos sintéticos generados por modelos previos para aumentar la diversidad.

El proceso de fine-tuning se realizó utilizando técnicas de aprendizaje supervisado, donde el objetivo de pérdida se minimiza mediante la comparación de la salida generada con el código de referencia. Se aplicó masked language modeling para mejorar la comprensión contextual, y se incorporaron métricas como BLEU y exact match para evaluar la similitud semántica y sintáctica.

Para mitigar problemas como el overfitting, se implementó regularización dropout y early stopping basado en validación cruzada. Además, se exploró el uso de reinforcement learning from human feedback (RLHF) para refinar el modelo, incorporando retroalimentación de desarrolladores expertos que califican la utilidad del código generado.

- Hiperparámetros Clave: Learning rate de 5e-5, batch size de 32, y epochs de 10, ajustados mediante grid search.

- Hardware: Entrenamiento distribuido en GPUs NVIDIA A100, optimizando con bibliotecas como Hugging Face Transformers y PyTorch.

Los resultados preliminares mostraron una mejora del 25% en la precisión de generación comparado con modelos base, particularmente en tareas que involucran lógica condicional y bucles.

Desafíos en la Interpretación de Lenguaje Natural

Uno de los principales obstáculos en este sistema es la ambigüedad inherente al lenguaje natural. Frases como “ordena la lista” podrían referirse a sorting ascendente o descendente, dependiendo del contexto. Para abordar esto, se integró un módulo de clarificación que genera preguntas de seguimiento, como “¿Deseas ordenar en orden ascendente o descendente?”

Otro desafío es la especificidad del dominio. Las descripciones de usuarios no expertos a menudo omiten detalles cruciales, como el manejo de errores o la optimización de rendimiento. El modelo se entrenó con ejemplos que incluyen edge cases, como entradas nulas o valores extremos, para fomentar la robustez.

En términos de seguridad, la generación de código plantea riesgos como inyecciones de SQL o buffer overflows si no se valida adecuadamente. Se implementaron chequeos estáticos usando herramientas como Bandit para Python, que escanean el código generado en busca de patrones vulnerables antes de su aprobación.

Implementación Práctica y Casos de Estudio

La implementación se realizó en un framework de microservicios con Docker para contenedorización, permitiendo despliegue en entornos cloud como AWS o Azure. El API RESTful expone endpoints para enviar consultas y recibir código, con autenticación JWT para controlar accesos.

En un caso de estudio, se solicitó: “Desarrolla un script que lea un archivo CSV y genere un gráfico de barras con las ventas por región”. El sistema generó código utilizando pandas y matplotlib, incluyendo importaciones y manejo de excepciones para archivos inexistentes. La ejecución en sandbox confirmó su corrección, produciendo el gráfico esperado en menos de 5 segundos.

- Optimizaciones: Caché de consultas frecuentes para reducir latencia, y paralelización de la generación para múltiples lenguajes.

- Integración con IDEs: Plugins para VS Code y PyCharm que invocan el API directamente desde el editor.

En otro escenario, enfocado en blockchain, la consulta “Implementa un smart contract en Solidity para un token ERC-20 básico” resultó en código que sigue las mejores prácticas de OpenZeppelin, verificado contra estándares de seguridad como Slither.

Evaluación y Métricas de Rendimiento

La evaluación se centró en métricas cuantitativas y cualitativas. Para la precisión, se utilizó el pass@k, que mide la proporción de generaciones correctas en k intentos. Con k=1, se alcanzó un 45% en benchmarks estándar, superando baselines como Codex en un 10%.

Métricas cualitativas involucraron revisiones humanas por parte de 50 desarrolladores, quienes calificaron la legibilidad y eficiencia del código en una escala de 1 a 5. El promedio fue de 4.2, destacando la claridad de las implementaciones generadas.

En cuanto a eficiencia, el tiempo de inferencia promedio fue de 2.3 segundos por consulta en hardware estándar, escalable con cuantización del modelo para dispositivos edge.

- Limitaciones Observadas: Dificultades con conceptos avanzados como recursión mutua o optimizaciones algorítmicas complejas, donde el modelo requiere prompts más detallados.

- Mejoras Futuras: Integración de multimodalidad, permitiendo inputs como diagramas UML junto con texto.

Implicaciones Éticas y de Seguridad en Ciberseguridad

Desde la perspectiva de la ciberseguridad, la generación automática de código introduce vectores de ataque potenciales. Por ejemplo, un prompt malicioso podría intentar generar código que explote vulnerabilidades. Para contrarrestar esto, se aplican filtros de contenido basados en regex y modelos de detección de adversarial inputs.

Éticamente, es esencial asegurar que el sistema no perpetúe sesgos en los datasets de entrenamiento, como preferencias por ciertos estilos de codificación. Se realizó un audit de bias, ajustando el fine-tuning para promover diversidad en las salidas.

En el contexto de IA y blockchain, este sistema podría facilitar la creación de contratos inteligentes seguros, reduciendo errores que han llevado a pérdidas millonarias en exploits pasados, como el caso de DAO en 2016.

Conclusiones y Perspectivas Futuras

El desarrollo de este sistema de IA para generación de código demuestra el potencial transformador de los LLM en el ecosistema de desarrollo de software. Al combinar avances en PLN con validaciones rigurosas, se logra un equilibrio entre productividad y fiabilidad. No obstante, persisten desafíos en la generalización a dominios especializados y la integración con flujos de trabajo colaborativos.

Las perspectivas futuras incluyen la expansión a lenguajes de bajo nivel como C++ y la incorporación de auto-mejora, donde el modelo aprende de ejecuciones fallidas para refinar futuras generaciones. Este enfoque no solo acelera el desarrollo, sino que también fomenta la innovación en campos interseccionales como la ciberseguridad y las tecnologías emergentes.

En resumen, la adopción de tales sistemas podría redefinir roles en la industria, posicionando a la IA como un colaborador indispensable en la creación de software robusto y eficiente.

Para más información visita la Fuente original.