TorchTPU: El Arma Estratégica de Google contra el Hegemonía de CUDA en IA

El Panorama Actual del Ecosistema de Aceleración en Inteligencia Artificial

En el ámbito de la inteligencia artificial, el hardware de aceleración juega un rol pivotal en el entrenamiento y despliegue de modelos de machine learning. NVIDIA ha consolidado su posición dominante gracias a CUDA, una plataforma de cómputo paralelo que ha devenido en el estándar de facto para el procesamiento en GPUs. Esta hegemonía no solo se refleja en el mercado de hardware, sino también en el software, donde la mayoría de frameworks como TensorFlow y PyTorch están optimizados para CUDA. Sin embargo, Google, con su enfoque en la eficiencia y la escalabilidad en la nube, ha desarrollado alternativas que buscan erosionar esta supremacía. TorchTPU emerge como una de estas iniciativas, diseñada específicamente para integrar el popular framework PyTorch con las Unidades de Procesamiento Tensorial (TPUs) de Google Cloud.

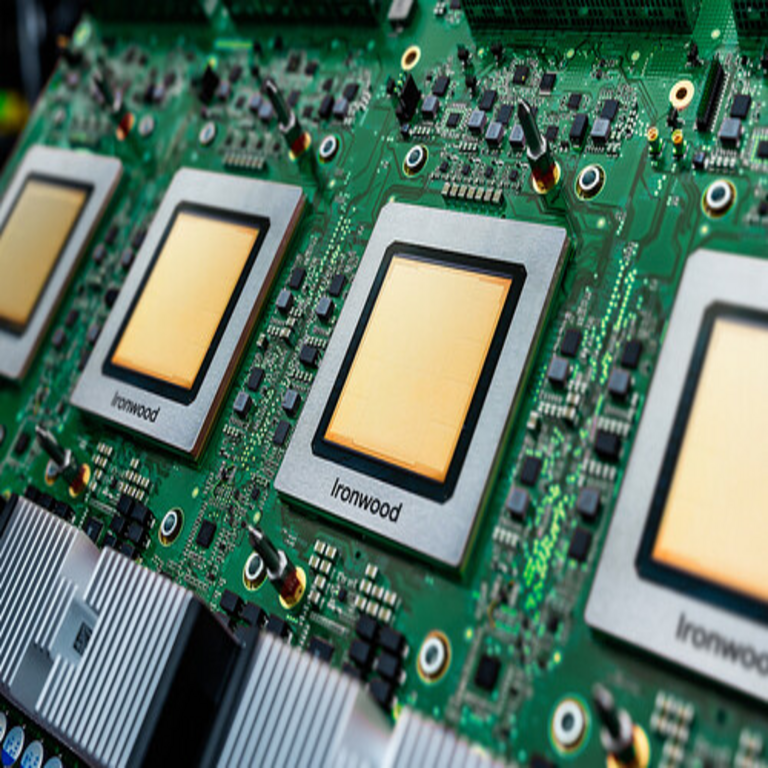

Las TPUs, introducidas por Google en 2016, representan una arquitectura especializada en operaciones matriciales y tensoriales, fundamentales para el deep learning. A diferencia de las GPUs de NVIDIA, que son versátiles pero menos eficientes en cargas de trabajo específicas de IA, las TPUs priorizan el rendimiento por vatio y la escalabilidad en entornos distribuidos. TorchTPU, anunciado recientemente, permite a los desarrolladores ejecutar código PyTorch directamente en TPUs sin necesidad de modificaciones significativas, democratizando el acceso a esta tecnología y posicionando a Google como un competidor directo en el dominio de CUDA.

Este desarrollo no es aislado; responde a la creciente demanda de alternativas a la dependencia de NVIDIA. Empresas como Meta, con su MTIA, y AMD, con ROCm, también buscan diversificar el ecosistema. No obstante, TorchTPU destaca por su integración nativa con PyTorch, que cuenta con una comunidad de más de un millón de usuarios activos y es el framework preferido en investigación académica y desarrollo de prototipos.

¿Qué es TorchTPU y Cómo Funciona?

TorchTPU es una extensión del runtime de PyTorch que habilita la ejecución en hardware TPU. En esencia, actúa como un backend alternativo a CUDA, traduciendo las operaciones de alto nivel de PyTorch en instrucciones optimizadas para la arquitectura systolic array de las TPUs. Las TPUs, particularmente los modelos Cloud TPU v4 y v5p, utilizan un diseño de matriz sistólica que acelera multiplicaciones de matrices a través de una red de unidades de procesamiento interconectadas, minimizando el movimiento de datos y maximizando el throughput.

Desde un punto de vista técnico, TorchTPU implementa un compilador just-in-time (JIT) basado en XLA (Accelerated Linear Algebra), el compilador de Google para optimizar grafos computacionales. Cuando un modelo PyTorch se ejecuta en TPU, el código se convierte en un grafo estático que XLA optimiza, fusionando operaciones y eliminando redundancias. Esto contrasta con CUDA, donde el enfoque es más en la programación paralela de bajo nivel mediante kernels en C++ o PTX.

Para ilustrar su implementación, consideremos un flujo de trabajo típico:

- Instalación y Configuración: Los desarrolladores acceden a TorchTPU a través de Google Cloud, instalando el paquete torch_xla vía pip. No se requiere hardware local; todo se maneja en instancias de VM con TPUs adjuntas.

- Entrenamiento de Modelos: Un script PyTorch estándar, como el entrenamiento de ResNet en ImageNet, se modifica mínimamente agregando import torch_xla.core.xla_model as xm y usando xm.optimizer_step para sincronizar gradientes en entornos distribuidos.

- Optimización: TorchTPU soporta técnicas avanzadas como mixed precision training y sharding de modelos, distribuyendo tensores grandes a través de múltiples chips TPU en pods de hasta 4096 unidades.

En términos de rendimiento, benchmarks iniciales muestran que TorchTPU en TPU v5p logra hasta un 2.7 veces más rendimiento en entrenamiento de modelos grandes como GPT-3 comparado con GPUs A100 de NVIDIA, con un consumo energético significativamente menor. Esta eficiencia se debe a la integración vertical de Google, donde el hardware, software y la red de interconexión (ICI) están diseñados en conjunto.

Comparación Técnica entre TorchTPU y CUDA

Para evaluar el impacto de TorchTPU, es esencial comparar sus fortalezas y limitaciones con CUDA. CUDA, lanzada en 2006, ofrece una API madura para programación GPU, con soporte para miles de bibliotecas como cuDNN para redes neuronales y cuBLAS para álgebra lineal. Su ecosistema es vasto, con herramientas de debugging como Nsight y soporte para lenguajes como Python, C++ y Fortran.

En contraste, TorchTPU se centra en la simplicidad y la portabilidad. Mientras CUDA requiere compilación específica para cada arquitectura GPU (Ampere, Hopper), TorchTPU abstrae estas complejidades mediante XLA, permitiendo que el mismo código PyTorch corra en CPU, GPU o TPU con cambios mínimos. Sin embargo, CUDA gana en flexibilidad para workloads no-IA, como simulación física o renderizado gráfico, donde las GPUs de NVIDIA brillan por su arquitectura de streaming multiprocesadores (SM).

Desde la perspectiva de costos, TorchTPU ofrece precios predecibles en Google Cloud: un pod TPU v4 cuesta aproximadamente 1.20 USD por hora por chip, escalable a miles de chips sin overhead significativo. NVIDIA, por su parte, depende de proveedores como AWS o Azure, donde el costo de instancias A100 puede superar los 3 USD por hora, más licencias implícitas en el software. Además, TorchTPU reduce la latencia en entrenamiento distribuido gracias a la topología de torus en pods TPU, que soporta all-to-all communications con bandwidth de hasta 1.2 TB/s por chip.

Otras diferencias clave incluyen:

- Soporte de Frameworks: CUDA es agnóstico, soportando TensorFlow, PyTorch, JAX y más. TorchTPU es específico para PyTorch, aunque Google planea extensiones para JAX vía XLA.

- Accesibilidad: CUDA requiere hardware propietario; TorchTPU es solo en la nube, pero con tiers gratuitos para investigación (hasta 100 horas mensuales en Colab).

- Seguridad y Cumplimiento: Ambas plataformas manejan datos sensibles, pero las TPUs de Google integran controles nativos para GDPR y HIPAA, con encriptación end-to-end en la red.

En benchmarks como MLPerf, TPUs con TorchTPU han demostrado superioridad en tareas de entrenamiento de visión por computadora, superando a clusters de NVIDIA en tiempo de convergencia y eficiencia energética. No obstante, para inferencia en edge computing, CUDA mantiene ventaja por su ubiquidad en dispositivos como Jetson.

Implicaciones para la Industria de la Ciberseguridad y Tecnologías Emergentes

El surgimiento de TorchTPU trasciende el rendimiento puro; impacta en ciberseguridad, blockchain e IA generativa. En ciberseguridad, las TPUs aceleran el entrenamiento de modelos de detección de anomalías y análisis de amenazas, permitiendo procesar petabytes de logs en tiempo real. Por ejemplo, un modelo de red neuronal para identificar patrones de ciberataques puede entrenarse en horas en lugar de días, reduciendo ventanas de vulnerabilidad.

En blockchain, donde la computación intensiva es clave para minería y validación de transacciones, TorchTPU podría optimizar simulaciones de redes distribuidas o entrenamiento de smart contracts basados en IA. Imagínese entrenar un modelo predictivo para volatilidad de criptoactivos en TPUs, integrando datos on-chain con off-chain de manera eficiente, lo que podría democratizar el acceso a herramientas avanzadas para DeFi.

Para IA emergente, TorchTPU facilita el desarrollo de large language models (LLMs) escalables. PyTorch, con su dynamic graph, es ideal para experimentación rápida, y su soporte en TPUs permite iteraciones más veloces en investigación. Esto podría acelerar avances en multimodal AI, donde modelos procesan texto, imagen y audio simultáneamente, con aplicaciones en vigilancia autónoma o asistentes virtuales seguros.

Sin embargo, desafíos persisten. La dependencia de la nube introduce riesgos de latencia y soberanía de datos, especialmente en regiones con regulaciones estrictas. Además, la curva de aprendizaje para migrar de CUDA a TorchTPU requiere inversión en capacitación, aunque Google mitiga esto con tutoriales exhaustivos y soporte comunitario en GitHub.

Desafíos y Perspectivas Futuras

A pesar de sus ventajas, TorchTPU enfrenta obstáculos. La madurez de CUDA, con dos décadas de refinamiento, ofrece un ecosistema de herramientas de third-party que TorchTPU aún no iguala. Por instancia, bibliotecas como Hugging Face Transformers están más probadas en CUDA, requiriendo adaptaciones para TPUs. Además, la disponibilidad limitada a Google Cloud podría disuadir a usuarios on-premise.

En el horizonte, Google anticipa integraciones con edge TPUs para inferencia en dispositivos IoT, expandiendo TorchTPU más allá de la nube. Colaboraciones con PyTorch Foundation podrían estandarizar XLA como backend universal, erosionando aún más el monopolio de CUDA. Para la industria, esto fomenta competencia saludable, potencialmente bajando costos y innovando en hardware como chips neuromórficos.

En ciberseguridad, TorchTPU podría potenciar defensas proactivas, como modelos de IA para threat hunting en entornos blockchain, donde la trazabilidad de transacciones se combina con predicciones en tiempo real. Tecnologías emergentes como quantum-resistant cryptography también se benefician, al entrenar algoritmos post-cuánticos en hardware eficiente.

Conclusiones

TorchTPU representa un punto de inflexión en la guerra por el dominio en aceleración de IA, desafiando directamente la fortaleza de CUDA con una propuesta integrada, eficiente y accesible. Al habilitar PyTorch en TPUs, Google no solo amplía su cuota en cloud computing, sino que empodera a desarrolladores en ciberseguridad, IA y blockchain para innovar sin barreras propietarias. Aunque la transición requiere esfuerzo, los beneficios en rendimiento y sostenibilidad posicionan a TorchTPU como un misil en la línea de flotación de NVIDIA. El futuro del ecosistema de IA dependerá de cómo estas tecnologías evolucionen, fomentando un panorama más diverso y colaborativo.

Para más información visita la Fuente original.