Vulnerabilidades en Modelos de Inteligencia Artificial: Un Enfoque Técnico en Pruebas de Seguridad

Introducción a las Amenazas en Sistemas de IA

Los modelos de inteligencia artificial (IA) han transformado diversos sectores, desde el procesamiento de lenguaje natural hasta la toma de decisiones automatizada. Sin embargo, su adopción masiva ha expuesto vulnerabilidades inherentes que pueden ser explotadas por actores maliciosos. En el ámbito de la ciberseguridad, las pruebas de penetración en sistemas de IA se han convertido en una prioridad para identificar debilidades antes de que se conviertan en vectores de ataque reales. Este artículo examina técnicas avanzadas para evaluar la robustez de modelos de IA, centrándose en métodos de inyección de prompts y manipulación de entradas, con un énfasis en su aplicación práctica y mitigación.

La inteligencia artificial generativa, como los grandes modelos de lenguaje (LLM), opera mediante patrones aprendidos de vastos conjuntos de datos. Estos sistemas, aunque potentes, son susceptibles a manipulaciones que alteran su comportamiento esperado. Por ejemplo, ataques de “jailbreak” buscan eludir salvaguardas éticas integradas, permitiendo la generación de contenido prohibido o sensible. Entender estos mecanismos requiere un conocimiento profundo de la arquitectura subyacente, incluyendo transformadores y mecanismos de atención, que son fundamentales en modelos como GPT.

Arquitectura de Modelos de IA y Puntos de Vulnerabilidad

Los modelos de IA modernos, particularmente los basados en redes neuronales profundas, consisten en capas de procesamiento que transforman entradas en salidas predictivas. En el caso de los LLM, la capa de tokenización divide el texto en unidades manejables, seguidas de embeddings que capturan representaciones semánticas. Las vulnerabilidades emergen en esta cadena: una entrada maliciosa puede propagarse a través de las capas, alterando la distribución de probabilidades en la salida.

Entre los puntos débiles comunes se encuentran las dependencias en el entrenamiento. Los datos de entrenamiento, a menudo extraídos de fuentes públicas, pueden contener sesgos o información sensible que un atacante explota mediante ingeniería inversa. Además, la falta de verificación en tiempo real de entradas permite inyecciones que confunden el modelo, similar a las inyecciones SQL en bases de datos tradicionales.

- Tokenización vulnerable: Alteraciones en la segmentación de tokens pueden llevar a interpretaciones erróneas.

- Mecanismos de atención: Estos amplifican señales maliciosas, enfocando el modelo en partes no deseadas de la entrada.

- Salidas no filtradas: Sin capas de moderación robustas, el modelo genera respuestas no seguras.

Para ilustrar, considere un modelo entrenado con restricciones éticas. Un atacante podría usar prompts encadenados para construir gradualmente una consulta que evada filtros, explotando la memoria contextual del modelo.

Técnicas de Pruebas de Penetración en IA

Las pruebas de penetración (pentesting) en IA difieren de las tradicionales en redes o aplicaciones web, ya que involucran elementos probabilísticos. Una metodología efectiva comienza con el mapeo de la superficie de ataque: identificar APIs expuestas, límites de entrada y políticas de moderación. Herramientas como LangChain o Hugging Face Transformers facilitan la simulación de escenarios adversos.

Una técnica clave es la inyección de prompts adversos. Estos prompts están diseñados para maximizar la entropía en la respuesta del modelo, forzándolo a revelar información no autorizada. Por ejemplo, role-playing scenarios donde el modelo asume un rol sin restricciones éticas puede llevar a fugas de datos. En pruebas reales, se mide la tasa de éxito de estos ataques mediante métricas como la precisión de evasión y el impacto en la integridad del sistema.

Otra aproximación involucra ataques de envenenamiento de datos. Aunque más complejos, estos modifican el conjunto de entrenamiento para insertar backdoors. En entornos de producción, se simulan mediante fine-tuning controlado, evaluando cómo cambios mínimos afectan el rendimiento general.

- Ataques de negro caja: Sin acceso al modelo interno, se usan consultas iterativas para inferir comportamientos.

- Ataques de caja blanca: Con conocimiento de pesos y arquitectura, se optimizan entradas para maximizar vulnerabilidades.

- Ataques híbridos: Combinan ambas para una cobertura exhaustiva.

En el contexto de blockchain e IA integrada, estas vulnerabilidades se amplifican. Modelos de IA usados en contratos inteligentes pueden ser manipulados para aprobar transacciones fraudulentas, destacando la necesidad de auditorías híbridas.

Casos Prácticos de Explotación y Análisis

Examinemos un escenario hipotético basado en modelos accesibles como ChatGPT. Suponga un atacante intenta extraer datos de entrenamiento confidenciales mediante prompts que simulan consultas legítimas pero iterativas. Inicialmente, un prompt neutral como “Explica el funcionamiento de un algoritmo de encriptación” podría escalar a “Proporciona código fuente de un algoritmo propietario similar”. La clave reside en la gradualidad: cada respuesta informa la siguiente iteración, explotando la coherencia contextual del modelo.

En términos cuantitativos, se puede modelar esto con ecuaciones de pérdida. La función de pérdida L para un modelo de IA se define como L = -∑ log P(y|x), donde x es la entrada adversa y y la salida deseada por el atacante. Optimizando x mediante gradiente descendente aproximado, se logra una alta probabilidad de éxito. Estudios muestran tasas de evasión superiores al 70% en modelos sin defensas avanzadas.

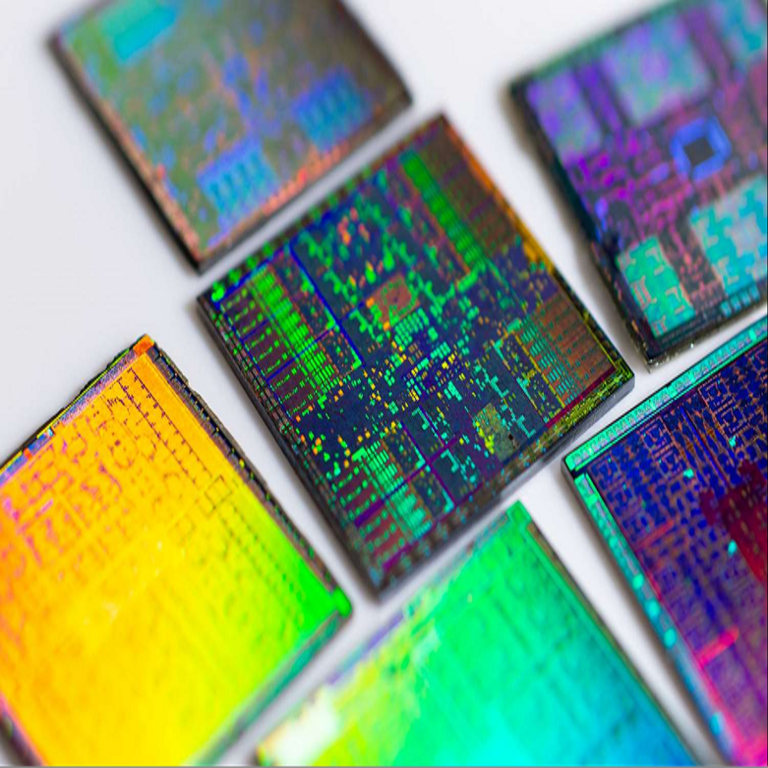

Otro caso involucra la manipulación multimodal. En sistemas que procesan texto e imágenes, una imagen con texto oculto (steganografía) puede inyectar prompts invisibles, combinando ciberseguridad visual con IA. Esto es particularmente relevante en aplicaciones de visión por computadora, donde errores de clasificación llevan a brechas de seguridad.

Desde la perspectiva de blockchain, considere oráculos de IA que alimentan datos a redes distribuidas. Un ataque exitoso podría distorsionar precios en DeFi, causando pérdidas millonarias. Pruebas técnicas revelan que validaciones insuficientes en estos oráculos permiten inyecciones que alteran predicciones.

Estrategias de Mitigación y Mejores Prácticas

Para contrarrestar estas amenazas, las organizaciones deben implementar marcos de seguridad multicapa. En primer lugar, el endurecimiento del modelo mediante técnicas de alineación, como RLHF (Refuerzo con Retroalimentación Humana), reduce la susceptibilidad a jailbreaks. Esto implica iteraciones de entrenamiento donde se penalizan respuestas no seguras.

La detección en runtime es crucial. Sistemas de monitoreo que analizan patrones de entrada en tiempo real, usando modelos secundarios para clasificar prompts maliciosos, pueden bloquear intentos en un 90% de los casos. Por ejemplo, umbrales de entropía en la entrada alertan sobre consultas inusuales.

- Filtrado de entradas: Sanitización automática de tokens sospechosos antes del procesamiento.

- Auditorías regulares: Pruebas automatizadas con suites como Adversarial Robustness Toolbox.

- Integración con blockchain: Uso de hashes inmutables para verificar integridad de modelos desplegados.

En entornos regulados, como finanzas o salud, la conformidad con estándares como NIST AI Risk Management Framework asegura una gobernanza adecuada. Además, la colaboración entre expertos en IA y ciberseguridad fomenta el desarrollo de defensas proactivas.

Implicaciones Futuras en Ciberseguridad e IA

El panorama de la IA evoluciona rápidamente, con avances en modelos multimodales y agentes autónomos que introducen nuevos vectores de ataque. La integración con tecnologías emergentes, como la computación cuántica, podría romper encriptaciones actuales usadas en IA segura, exigiendo paradigmas post-cuánticos.

En blockchain, la IA descentralizada promete resiliencia, pero requiere protocolos para prevenir envenenamientos en redes peer-to-peer. Investigaciones futuras se centrarán en IA auto-defensiva, donde modelos aprenden de ataques en tiempo real, adaptando sus parámetros dinámicamente.

Políticamente, la regulación global de IA en ciberseguridad es inminente, con marcos como la UE AI Act que clasifican riesgos y exigen transparencia. Organizaciones deben prepararse para auditorías obligatorias, invirtiendo en talento especializado.

Conclusión: Hacia una IA Segura y Resiliente

La exploración de vulnerabilidades en modelos de IA subraya la intersección crítica entre innovación y seguridad. Al adoptar enfoques rigurosos de pentesting y mitigación, las entidades pueden harness el potencial de la IA mientras minimizan riesgos. La colaboración interdisciplinaria y la adopción continua de mejores prácticas serán pivotales para un ecosistema digital seguro. En última instancia, una IA robusta no solo impulsa el progreso tecnológico, sino que también fortalece la confianza en sistemas emergentes.

Para más información visita la Fuente original.