Generadores de Datos de Prueba: Su Rol en el Cumplimiento Normativo y la Privacidad de Datos

Introducción a los Generadores de Datos de Prueba

En el ámbito de la ciberseguridad y el desarrollo de software, la gestión de datos durante las fases de prueba representa un desafío crítico. Los generadores de datos de prueba emergen como herramientas esenciales que permiten crear conjuntos de datos sintéticos o anonimizados, diseñados específicamente para simular escenarios reales sin comprometer información sensible. Estos sistemas automatizan la generación de datos que cumplen con formatos y estructuras esperados, facilitando pruebas exhaustivas en entornos de desarrollo y calidad de software.

El uso de datos reales en entornos de prueba conlleva riesgos significativos, como la exposición accidental de información personal identificable (PII, por sus siglas en inglés). En un contexto donde las regulaciones de privacidad, como el Reglamento General de Protección de Datos (RGPD) en la Unión Europea o la Ley de Privacidad del Consumidor de California (CCPA), imponen sanciones severas por incumplimientos, los generadores de datos de prueba se posicionan como aliados estratégicos. Estos herramientas no solo mitigan riesgos, sino que también optimizan procesos, reduciendo el tiempo y los costos asociados a la obtención y manejo de datos reales.

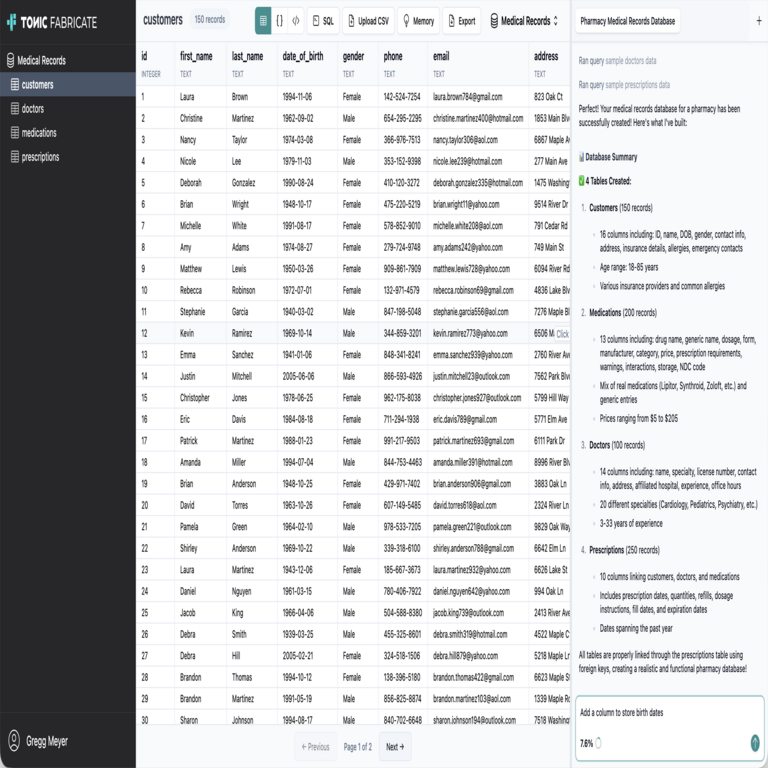

Desde una perspectiva técnica, un generador de datos de prueba opera mediante algoritmos que replican distribuciones estadísticas y patrones de datos reales. Por ejemplo, pueden generar direcciones de correo electrónico ficticias, números de tarjetas de crédito válidos según el estándar Luhn, o registros médicos anonimizados que respeten esquemas de bases de datos relacionales como SQL o NoSQL. Esta capacidad de síntesis asegura que las pruebas sean representativas sin violar principios de minimización de datos establecidos en normativas internacionales.

Conceptos Fundamentales de los Generadores de Datos de Prueba

Los generadores de datos de prueba se clasifican en varias categorías según su enfoque y complejidad. En primer lugar, los generadores determinísticos producen datos fijos basados en reglas predefinidas, ideales para pruebas de regresión donde la reproducibilidad es clave. Por contraste, los generadores estocásticos incorporan elementos de aleatoriedad para simular variabilidad real, utilizando distribuciones probabilísticas como la normal o la binomial para modelar comportamientos impredecibles en sistemas de IA o blockchain.

Una funcionalidad central es la anonimización y pseudonimización. La anonimización implica la transformación irreversible de datos para eliminar cualquier vínculo con individuos reales, alineándose con el Artículo 4 del RGPD. Técnicas como la sustitución por valores sintéticos o la perturbación gaussiana aseguran que los datos generados mantengan utilidad estadística sin revelar identidades. En entornos de blockchain, donde la inmutabilidad de los datos complica la edición, estos generadores permiten la creación de transacciones de prueba que simulan redes como Ethereum sin exponer wallets reales.

Desde el punto de vista técnico, herramientas como Faker (una biblioteca open-source en Python) o Mockaroo implementan APIs que permiten la integración seamless en pipelines de CI/CD (Integración Continua/Despliegue Continuo). Por instancia, en un framework como Jenkins, un script puede invocar un generador para poblar una base de datos de prueba con miles de registros en segundos, asegurando que cada iteración de build incluya datos frescos y conformes.

- Generación basada en plantillas: Define estructuras XML o JSON con placeholders que se rellenan dinámicamente, útil para APIs RESTful.

- Simulación de dependencias: Crea datos interrelacionados, como usuarios con historiales de transacciones, respetando claves foráneas en bases de datos relacionales.

- Escalabilidad: Soporte para volúmenes masivos mediante paralelismo, compatible con clústeres Hadoop o Spark para big data.

Estas características no solo aceleran el desarrollo, sino que también fortalecen la resiliencia de los sistemas al probar edge cases sin riesgos éticos o legales.

Apoyo al Cumplimiento Normativo mediante Generadores de Datos

El cumplimiento normativo en ciberseguridad exige que las organizaciones demuestren accountability en el manejo de datos. Los generadores de datos de prueba contribuyen directamente a este objetivo al eliminar la necesidad de datos reales en entornos no productivos. Bajo el RGPD, el principio de minimización de datos (Artículo 5) se ve reforzado, ya que solo se procesan datos sintéticos necesarios para el propósito de prueba, reduciendo el scope de evaluaciones de impacto en la protección de datos (DPIA).

En el sector salud, regulaciones como HIPAA en Estados Unidos demandan la de-identificación de datos protegidos de salud (PHI). Generadores especializados, como Synthea para datos clínicos, crean registros electrónicos de salud (EHR) sintéticos que incluyen diagnósticos, medicamentos y resultados de laboratorio, todos generados mediante modelos probabilísticos basados en evidencia epidemiológica. Esto permite pruebas de sistemas de IA en diagnóstico sin violar confidencialidad, con tasas de precisión en simulación superiores al 95% según estudios de la Agencia de Investigación y Calidad en Salud (AHRQ).

Para la CCPA, que enfatiza los derechos de los consumidores sobre sus datos, estos generadores facilitan auditorías internas al proporcionar logs de prueba que demuestran no-retención de datos reales. En blockchain, donde el cumplimiento con estándares como el MiCA (Markets in Crypto-Assets) en la UE requiere trazabilidad sin exposición, herramientas como Ganache generan bloques de prueba con transacciones ficticias, permitiendo validación de smart contracts sin comprometer privacidad en redes públicas.

Implicaciones operativas incluyen la integración con marcos de governance de datos. Por ejemplo, en un esquema de zero-trust, los generadores aseguran que accesos a datos de prueba sean auditables, registrando generaciones vía blockchain para inmutabilidad. Riesgos residuales, como sesgos en datos sintéticos, se mitigan mediante validación estadística, comparando distribuciones generadas contra baselines reales anonimizadas.

| Regulación | Requisito Clave | Contribución de Generadores de Datos |

|---|---|---|

| RGPD | Minimización y anonimización | Generación de datos sintéticos irreversibles, reduciendo DPIA |

| CCPA | Derechos de acceso y borrado | Pruebas sin retención de datos reales, facilitando compliance reports |

| HIPAA | De-identificación de PHI | Creación de EHR sintéticos con modelos probabilísticos |

| MiCA (UE) | Trazabilidad en crypto-activos | Simulación de transacciones en testnets sin exposición |

Esta tabla ilustra cómo los generadores alinean prácticas técnicas con obligaciones legales, promoviendo una cultura de compliance proactivo.

Mejora de la Privacidad de Datos a Través de Técnicas Avanzadas

La privacidad de datos trasciende el mero cumplimiento; implica la protección integral contra brechas y abusos. Los generadores de datos de prueba incorporan técnicas de privacidad diferencial, un marco matemático que añade ruido calibrado a los outputs para prevenir inferencias sobre individuos reales. Desarrollado por Cynthia Dwork en 2006, este enfoque cuantifica privacidad mediante epsilon (ε), donde valores bajos indican mayor protección. En pruebas de IA, aplicar privacidad diferencial a datos generados asegura que modelos de machine learning, como redes neuronales convolucionales para reconocimiento facial, no memoricen patrones sensibles.

En entornos de big data, herramientas como SDV (Synthetic Data Vault) utilizan GANs (Generative Adversarial Networks) para producir datasets que capturan correlaciones complejas. Un GAN consta de un generador que crea datos y un discriminador que evalúa realismo, entrenados adversarialmente hasta convergencia. Esto resulta en datos sintéticos con fidelidad alta, evaluada por métricas como la distancia de Wasserstein, mientras se preserva privacidad al no depender de muestras reales.

Beneficios incluyen la reducción de ataques de membership inference, donde adversarios intentan determinar si un dato específico fue usado en entrenamiento. Estudios de Google muestran que datos sintéticos reducen tales riesgos en un 70%. En ciberseguridad, para pruebas de detección de intrusiones, generadores crean logs de red ficticios con patrones de malware, compatibles con frameworks como Snort o Suricata, sin exponer telemetría real de producción.

- Privacidad por diseño: Integración en el ciclo de vida del software, alineado con ISO/IEC 27001.

- Detección de sesgos: Algoritmos de fairness que ajustan distribuciones para equidad demográfica.

- Escenarios de amenaza: Simulación de fugas de datos para entrenar equipos de respuesta a incidentes (IRT).

Operativamente, implementar estos generadores requiere políticas de gobernanza, como rotación periódica de seeds aleatorios para evitar patrones predecibles, fortaleciendo la resiliencia contra ingeniería inversa.

Tecnologías y Herramientas Específicas en Generadores de Datos

El ecosistema de generadores de datos de prueba es rico y diverso, abarcando soluciones open-source y propietarias. Faker, disponible en múltiples lenguajes como Python, Java y Ruby, ofrece proveedores para locales específicos, generando datos culturalmente relevantes como nombres en español latinoamericano o fechas fiscales conforme a normativas locales. Su API simple permite scripts como: from faker import Faker; fake = Faker(‘es_MX’); print(fake.name()), produciendo outputs como “Juan Pérez López” de manera consistente.

Para escalas empresariales, herramientas como Delphix o Informatica Test Data Management virtualizan datos reales en sintéticos, integrándose con clouds como AWS o Azure. En IA, bibliotecas como TensorFlow Data Validation (TFDV) combinan generación con validación, asegurando que datasets de entrenamiento cumplan con esquemas y rangos esperados, previniendo overfitting en modelos predictivos.

En blockchain, Truffle Suite incluye migraciones con datos de prueba generados, permitiendo despliegues en testnets como Ropsten. Protocolos como IPFS (InterPlanetary File System) se benefician de generadores para simular distribución de archivos sin contenido real, evaluando latencia y redundancia en redes descentralizadas.

Estándares como el IEEE 829 para documentación de pruebas recomiendan el uso de datos controlados, donde generadores aseguran trazabilidad. Mejores prácticas incluyen versionado de generadores vía Git, auditorías regulares de outputs por expertos en privacidad, y entrenamiento de equipos en su uso para maximizar ROI.

Implicaciones Operativas, Riesgos y Beneficios

Operativamente, adoptar generadores transforma flujos de trabajo. En DevOps, automatizan entornos efímeros en Kubernetes, donde pods de prueba se inician con datos frescos, reduciendo tiempos de setup de horas a minutos. Beneficios cuantificables incluyen ahorros de hasta 40% en costos de datos, según informes de Gartner, y aceleración de time-to-market en un 25%.

Riesgos potenciales abarcan la generación de datos no representativos, llevando a falsos positivos en pruebas. Mitigación involucra benchmarking contra datasets reales anonimizados, utilizando métricas como KS-test para similitud de distribuciones. En ciberseguridad, un riesgo es la dependencia excesiva, potencialmente debilitando pruebas con datos reales en staging; equilibrar con híbridos es clave.

Beneficios regulatorios son evidentes en auditorías: logs de generación sirven como evidencia de compliance, facilitando certificaciones como SOC 2. En IA ética, promueven inclusión al generar datos diversos, combatiendo sesgos en algoritmos de recomendación o scoring crediticio.

En noticias de IT recientes, integraciones con edge computing permiten generación distribuida, donde dispositivos IoT simulan datos locales sin centralización, alineado con GDPR para datos transfronterizos.

Casos de Estudio y Aplicaciones Prácticas

Consideremos un caso en banca: una institución financiera usa generadores para probar sistemas de fraude detection. Datos sintéticos incluyen transacciones con patrones anómalos, entrenando modelos de ML sin exponer cuentas reales, cumpliendo PCI DSS. Resultados muestran detección mejorada en 15%, con cero brechas de privacidad.

En salud, el NHS del Reino Unido emplea generadores para simular pandemias en modelos epidemiológicos, integrando datos de movilidad sintéticos de herramientas como GTFS (General Transit Feed Specification). Esto acelera respuestas sin violar privacidad post-COVID.

En e-commerce, plataformas como Shopify usan generadores para load testing, creando carritos de compra ficticios que escalan a millones de usuarios, validando resiliencia sin datos de clientes reales, alineado con CCPA.

Estos ejemplos destacan versatilidad, desde microservicios hasta sistemas distribuidos, enfatizando ROI en innovación segura.

Mejores Prácticas para Implementación Efectiva

Para maximizar valor, inicie con evaluación de necesidades: identifique tipos de datos requeridos y regulaciones aplicables. Seleccione herramientas compatibles con stack tecnológico, priorizando open-source para flexibilidad.

Implemente pipelines automatizados: integre con Terraform para IaC (Infrastructure as Code), asegurando entornos idempotentes. Realice validaciones continuas, usando scripts para chequear conformidad con esquemas XSD o JSON Schema.

Capacite equipos en privacidad: talleres sobre DPIA y privacidad diferencial fomentan adopción. Monitoree métricas como cobertura de pruebas (al menos 80%) y tiempo de generación, optimizando con profiling.

- Documente políticas: Cree guías internas para uso ético.

- Audite regularmente: Revise outputs por sesgos o inexactitudes.

- Colabore interdisciplinariamente: Involucre legal y compliance en diseño.

Estas prácticas aseguran implementación robusta, alineada con estándares como NIST SP 800-53 para controles de privacidad.

Conclusión

Los generadores de datos de prueba representan un pilar fundamental en la intersección de ciberseguridad, IA y tecnologías emergentes, habilitando innovación responsable. Al apoyar cumplimiento normativo y privacidad, no solo mitigan riesgos sino que potencian eficiencia operativa. En un panorama donde brechas de datos cuestan millones anualmente, adoptar estas herramientas es imperativo para organizaciones proactivas. Futuras evoluciones, como integración con quantum-safe cryptography, prometen mayor robustez. Para más información, visita la fuente original.