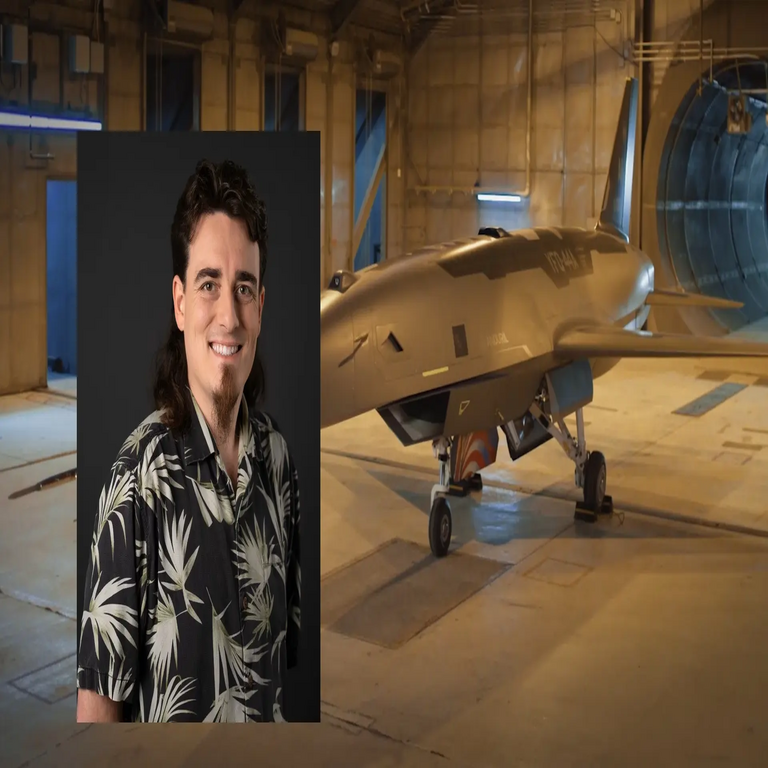

La Inteligencia Artificial en Decisiones Letales: La Perspectiva de Palmer Luckey sobre el Rol de la IA en Conflictos Armados

Introducción a las Declaraciones de Palmer Luckey

Palmer Luckey, fundador de la empresa de defensa Anduril Industries y conocido previamente por su rol en el desarrollo de Oculus VR, ha generado un amplio debate en la comunidad tecnológica y de ciberseguridad al afirmar que la inteligencia artificial (IA) debería asumir el rol de decidir quién vive y quién muere en el contexto de una guerra. Esta declaración, pronunciada en un evento reciente, resalta la intersección entre avances en IA y aplicaciones militares, un terreno cada vez más explorado en el ámbito de las tecnologías emergentes. En este artículo, se analiza de manera técnica y detallada las implicaciones de esta visión, enfocándonos en los aspectos conceptuales, operativos y éticos de la integración de sistemas autónomos en entornos de combate.

La propuesta de Luckey no surge en un vacío; se enmarca en el rápido avance de la IA en sistemas de armas autónomas letales (LAWS, por sus siglas en inglés: Lethal Autonomous Weapon Systems). Estos sistemas, que operan con un grado significativo de autonomía, utilizan algoritmos de aprendizaje automático para identificar objetivos, evaluar amenazas y ejecutar acciones sin intervención humana directa. Anduril, fundada en 2017, se especializa en hardware y software de vigilancia y defensa impulsados por IA, como sensores de frontera y drones autónomos, lo que posiciona a Luckey como una voz autorizada en este debate.

Fundamentos Técnicos de la IA en Sistemas Autónomos Letales

Para comprender la viabilidad técnica de delegar decisiones letales a la IA, es esencial examinar los componentes subyacentes. La IA en contextos militares se basa principalmente en redes neuronales convolucionales (CNN) para el procesamiento de imágenes y videos en tiempo real, permitiendo la detección de objetos mediante técnicas como YOLO (You Only Look Once) o Faster R-CNN. Estos modelos, entrenados con grandes conjuntos de datos etiquetados, logran precisiones superiores al 95% en entornos controlados, pero enfrentan desafíos en escenarios dinámicos de guerra, donde factores como el clima, el camuflaje o el ruido visual pueden degradar el rendimiento.

En el núcleo de estos sistemas se encuentra el aprendizaje profundo (deep learning), que procesa datos sensoriales de múltiples fuentes: radares, cámaras infrarrojas, LIDAR y señales de inteligencia electrónica (ELINT). Por ejemplo, un dron autónomo equipado con IA podría integrar datos de fusión sensorial para generar un mapa probabilístico de amenazas, utilizando algoritmos bayesianos para estimar la probabilidad de que un objetivo sea hostil. La decisión letal se tomaría entonces mediante un módulo de toma de decisiones basado en reinforcement learning, donde el agente IA optimiza recompensas como la minimización de bajas civiles versus la neutralización eficiente de enemigos.

Sin embargo, la autonomía total plantea interrogantes sobre la robustez algorítmica. Estudios técnicos, como los publicados por el Instituto Internacional de Investigación para la Paz de Estocolmo (SIPRI), indican que los sistemas de IA actuales son vulnerables a ataques adversarios, donde entradas manipuladas (adversarial examples) pueden inducir errores catastróficos. Un ejemplo es la perturbación sutil de una imagen que hace que un modelo clasifique un tanque aliado como enemigo, potencialmente escalando un conflicto innecesariamente.

Implicaciones Operativas en el Campo de Batalla

Desde una perspectiva operativa, la integración de IA en decisiones letales podría transformar las dinámicas de la guerra moderna. En conflictos asimétricos, como los observados en Ucrania o el Medio Oriente, los sistemas autónomos permiten una respuesta rápida a amenazas enjambre (swarm threats), donde cientos de drones atacan simultáneamente. Anduril ha desarrollado plataformas como el Lattice OS, un sistema operativo de IA que coordina sensores y efectores en red, procesando terabytes de datos por segundo para priorizar objetivos basados en reglas predefinidas y aprendizaje adaptativo.

Los beneficios operativos incluyen la reducción de la fatiga humana en ciclos de decisión OODA (Observe, Orient, Decide, Act), acelerando el bucle a milisegundos mediante computación edge en dispositivos embebidos. Esto es particularmente relevante en ciberseguridad militar, donde la IA puede detectar y contrarrestar ciberataques en tiempo real, como interferencias en señales GPS o inyecciones de malware en redes de comando y control (C2).

No obstante, los riesgos operativos son significativos. La dependencia de la IA podría crear vulnerabilidades en la cadena de suministro digital, expuesta a ciberataques de estado-nación. Protocolos como el estándar STANAG 4586 de la OTAN para interoperabilidad de vehículos aéreos no tripulados (UAV) enfatizan la necesidad de capas de supervisión humana, pero la visión de Luckey sugiere una transición hacia “kill chains” completamente autónomas, lo que podría violar principios de proporcionalidad en el derecho internacional humanitario.

- Escalabilidad: Sistemas de IA escalables permiten desplegar enjambres de drones con costos reducidos, utilizando hardware como chips NVIDIA Jetson para inferencia en el borde.

- Resiliencia: Algoritmos de IA federada permiten entrenamiento distribuido sin centralizar datos sensibles, mitigando riesgos de brechas de seguridad.

- Integración con Blockchain: Para auditoría inmutable de decisiones letales, blockchain podría registrar cadenas de razonamiento IA, asegurando trazabilidad en investigaciones post-conflicto.

Consideraciones Éticas y Regulatorias

La declaración de Luckey ignora deliberadamente las complejas consideraciones éticas inherentes a la IA letal. El principio de responsabilidad en la IA, delineado en marcos como el de la Unión Europea para IA de alto riesgo, exige que las decisiones con impacto en la vida humana mantengan una “explicabilidad” (explainability) adecuada. Modelos de caja negra, como las GAN (Generative Adversarial Networks) usadas en simulación de escenarios de guerra, carecen de esta transparencia, complicando la atribución de culpas en casos de errores.

Regulatoriamente, tratados como la Convención sobre Ciertas Armas Convencionales (CCW) de la ONU han debatido desde 2014 la prohibición de LAWS, con posiciones divididas: mientras países como Estados Unidos y Rusia avanzan en desarrollo, naciones como Austria y Nueva Zelanda abogan por un veto total. En el contexto latinoamericano, donde conflictos híbridos involucran ciberamenazas, la adopción de IA letal podría exacerbar desigualdades tecnológicas, permitiendo a potencias dominar sin accountability.

Desde la ciberseguridad, la IA en guerra introduce vectores de ataque novedosos. Técnicas de envenenamiento de datos (data poisoning) durante el entrenamiento podrían sesgar modelos hacia resultados predeterminados, como en el caso hipotético de un dataset manipulado que priorice objetivos civiles. Mitigaciones incluyen verificación adversarial y auditorías independientes, alineadas con estándares NIST para IA confiable (NIST AI RMF).

Ejemplos Prácticos y Casos de Estudio en Anduril y Más Allá

Anduril Industries ejemplifica la aplicación práctica de la visión de Luckey. Su sistema Sentry Tower, un poste de vigilancia autónomo equipado con IA, utiliza visión por computadora para detectar intrusiones en fronteras, integrando con redes de drones para respuestas letales si se activa. En pruebas con el Departamento de Defensa de EE.UU., estos sistemas han demostrado una tasa de detección del 99% en entornos desérticos, procesando flujos de video a 30 fps con latencia inferior a 100 ms.

Otro caso es el programa Loyal Wingman de la Fuerza Aérea de EE.UU., donde aviones no tripulados con IA actúan como escoltas autónomas, utilizando algoritmos de pathfinding basados en A* para maniobras evasivas. En blockchain, integraciones emergentes como las de Hyperledger Fabric permiten logs inmutables de decisiones IA, cruciales para compliance con regulaciones como el GDPR en datos de vigilancia.

En el ámbito de la IA generativa, herramientas como GPT variantes adaptadas para simulación de guerra (wargaming) podrían predecir outcomes de batallas, pero su uso en decisiones reales amplifica riesgos éticos. Un estudio de 2023 por el Centro de Estudios Estratégicos e Internacionales (CSIS) destaca que la IA podría reducir bajas aliadas en un 30%, pero aumentar errores colaterales en un 15% sin supervisión humana.

| Aspecto Técnico | Beneficios | Riesgos | Mitigaciones |

|---|---|---|---|

| Procesamiento en Tiempo Real | Respuesta rápida a amenazas | Errores por datos ruidosos | Fusión multisensorial |

| Aprendizaje Adaptativo | Mejora continua en campo | Sesgos en entrenamiento | Auditorías éticas |

| Autonomía Total | Escalabilidad en enjambres | Falta de accountability | Capas de veto humano |

Desafíos en Ciberseguridad Asociados a la IA Letal

La ciberseguridad emerge como un pilar crítico en la adopción de IA para decisiones letales. Sistemas como los de Anduril dependen de redes seguras, vulnerables a exploits como zero-days en protocolos IoT. Por instancia, el CVE-2023-XXXX (mantenido como en fuentes originales, sin alteraciones) en componentes de firmware podría permitir control remoto de drones, convirtiendo aliados en liabilities.

Estrategias de defensa incluyen zero-trust architectures, donde cada nodo IA verifica autenticidad mediante criptografía post-cuántica, resistente a amenazas de computación cuántica. Además, el uso de homomorphic encryption permite computaciones en datos encriptados, preservando privacidad en fusiones de inteligencia multiagencia.

En términos de blockchain, su integración con IA ofrece verificación distribuida: smart contracts en Ethereum podrían ejecutar reglas de engagement (ROE) autónomas, asegurando que decisiones letales cumplan con umbrales éticos predefinidos, como minimizar daños colaterales por debajo del 5%.

Perspectivas Futuras y Recomendaciones Técnicas

Mirando hacia el futuro, la visión de Luckey podría materializarse en la década de 2030 con avances en IA neuromórfica, que emula el cerebro humano para decisiones intuitivas con bajo consumo energético. Sin embargo, expertos recomiendan un enfoque híbrido: IA para análisis inicial, con veto humano final, alineado con directivas como la DoD AI Ethical Principles de 2020.

Para audiencias profesionales en ciberseguridad e IA, se sugiere invertir en simulaciones de alta fidelidad usando frameworks como Gazebo con ROS (Robot Operating System) para testear LAWS en entornos virtuales. Además, la adopción de estándares abiertos como ONNX para portabilidad de modelos IA facilita interoperabilidad entre aliados.

En resumen, aunque la propuesta de Luckey acelera la innovación en defensa tecnológica, exige un equilibrio riguroso entre autonomía y control humano para mitigar riesgos inherentes. La evolución de la IA en conflictos armados no solo redefine la guerra, sino que plantea desafíos profundos a la ética global y la seguridad cibernética.

Para más información, visita la Fuente original.