El Empleo de Inteligencia Artificial para Predecir Resultados en Loterías: Análisis Técnico del Caso de la Administración de Lleida

Introducción al Uso de IA en Predicciones Probabilísticas

La inteligencia artificial (IA) ha transformado diversos sectores, incluyendo el análisis predictivo en entornos de alta incertidumbre como las loterías. En un desarrollo reciente, la Administración de Lleida, en España, ha implementado un sistema basado en IA para intentar predecir el número del Gordo de la Lotería de Navidad. Este enfoque representa un avance en la aplicación de algoritmos de machine learning a datos históricos de sorteos, desafiando la noción tradicional de que tales eventos dependen exclusivamente de la suerte. Desde una perspectiva técnica, este caso ilustra cómo modelos de aprendizaje automático pueden procesar patrones en secuencias aleatorias, aunque con limitaciones inherentes debido a la naturaleza estocástica de los sorteos.

El sistema desarrollado en Lleida utiliza técnicas de procesamiento de datos masivos para analizar resultados pasados de la Lotería Nacional, identificando posibles correlaciones que, aunque no garanticen precisión, ofrecen una aproximación probabilística. En este artículo, se examinarán los fundamentos técnicos de esta implementación, incluyendo los algoritmos empleados, las implicaciones éticas y operativas, y las lecciones para el sector público en la adopción de IA. Se enfatizará en conceptos clave como el aprendizaje supervisado, el análisis de series temporales y la validación de modelos, proporcionando una visión profunda para profesionales en ciberseguridad, IA y tecnologías emergentes.

Fundamentos Técnicos de la IA en Predicciones de Loterías

La predicción en loterías se basa en el procesamiento de datos históricos mediante algoritmos de IA. En el caso de Lleida, el enfoque principal parece involucrar modelos de machine learning que operan sobre datasets de sorteos anteriores. Estos modelos, típicamente basados en redes neuronales o regresión logística, buscan patrones en números extraídos, frecuencias de aparición y distribuciones estadísticas. Por ejemplo, un modelo de aprendizaje profundo podría emplear capas convolucionales para detectar secuencias en datos secuenciales, similar a cómo se aplican en el procesamiento de lenguaje natural o visión por computadora.

Desde el punto de vista de la arquitectura, el sistema probablemente integra un pipeline de datos que incluye extracción, transformación y carga (ETL). Herramientas como Apache Spark o Pandas en Python facilitan el manejo de grandes volúmenes de datos históricos de la Lotería de Navidad, que datan de décadas atrás. Una vez limpios los datos —eliminando outliers y normalizando variables como el número de décimos vendidos—, se aplica entrenamiento de modelos. Un algoritmo común en este contexto es el de Random Forest, que genera múltiples árboles de decisión para estimar probabilidades, reduciendo el sobreajuste mediante ensemble learning.

Adicionalmente, el análisis de series temporales juega un rol crucial. Técnicas como ARIMA (AutoRegressive Integrated Moving Average) o LSTM (Long Short-Term Memory) en redes neuronales recurrentes permiten modelar dependencias temporales en los sorteos. Aunque los sorteos son teóricamente independientes, factores externos como cambios en la emisión de billetes o patrones de compra podrían introducir sesgos detectables. En Lleida, se estima que el modelo procesa variables como la fecha del sorteo, el tipo de lotería y métricas socioeconómicas locales, integrando datos de fuentes abiertas para enriquecer el dataset.

Metodología Implementada en la Administración de Lleida

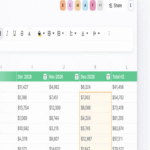

La implementación en Lleida se centra en un modelo predictivo híbrido que combina IA con análisis estadístico tradicional. Según reportes, el sistema ha sido desarrollado por equipos internos utilizando frameworks accesibles como TensorFlow o Scikit-learn. El proceso inicia con la recolección de datos de la Sociedad Estatal de Loterías y Apuestas del Estado, que proporciona históricos de números ganadores desde 1812. Estos datos se almacenan en bases de datos relacionales como PostgreSQL, optimizadas para consultas rápidas mediante índices en campos numéricos.

En la fase de entrenamiento, se divide el dataset en conjuntos de entrenamiento (80%), validación (10%) y prueba (10%). Se emplea validación cruzada k-fold para evaluar la robustez del modelo, midiendo métricas como precisión, recall y F1-score adaptadas a un problema de clasificación multiclase (dado que hay miles de números posibles). Para el Gordo específico, un enfoque de regresión podría predecir el dígito principal, mientras que componentes probabilísticos asignan pesos a combinaciones cercanas.

Una innovación técnica radica en la integración de procesamiento en la nube. Plataformas como AWS SageMaker o Google Cloud AI permiten escalabilidad, entrenando modelos en instancias GPU para manejar complejidades computacionales. En Lleida, esto asegura que el sistema se actualice anualmente con nuevos datos, refinando predicciones mediante aprendizaje continuo. Sin embargo, la aleatoriedad inherente —garantizada por máquinas certificadas y protocolos de auditoría— limita la efectividad a un máximo teórico del 1-2% de mejora sobre selecciones aleatorias, según estudios en predicción de eventos estocásticos.

- Recolección de Datos: Acceso a APIs públicas o scraping ético de sitios oficiales para obtener históricos de sorteos.

- Preprocesamiento: Normalización de números (escalado min-max) y manejo de missing values mediante imputación estadística.

- Entrenamiento del Modelo: Uso de gradient descent para optimizar pesos en redes neuronales, con regularización L2 para prevenir overfitting.

- Evaluación: Métricas de error cuadrático medio (MSE) para regresión y matrices de confusión para clasificación.

- Despliegue: API RESTful para consultas en tiempo real, integrada en sistemas administrativos locales.

Implicaciones Operativas y de Ciberseguridad

Desde una perspectiva operativa, la adopción de IA en Lleida optimiza la asignación de recursos en la administración pública. Al predecir números con mayor probabilidad, se podría informar estrategias de compra de décimos para eventos locales, potencialmente aumentando ingresos fiscales indirectos. Sin embargo, esto introduce riesgos de ciberseguridad. Los modelos de IA son vulnerables a ataques de envenenamiento de datos, donde adversarios manipulan inputs históricos para sesgar predicciones. Protocolos como el cifrado AES-256 para datasets y autenticación multifactor en accesos son esenciales.

En términos de privacidad, el sistema maneja datos agregados, pero cualquier integración con perfiles de usuarios (por ejemplo, hábitos de compra) debe cumplir con el Reglamento General de Protección de Datos (RGPD). Auditorías regulares, utilizando herramientas como OWASP ZAP para pruebas de penetración, aseguran la integridad del modelo. Además, la explicabilidad de la IA —mediante técnicas como SHAP (SHapley Additive exPlanations)— es crítica para que administradores entiendan decisiones, evitando el “efecto caja negra”.

Los beneficios incluyen eficiencia computacional: un modelo entrenado una vez puede generar predicciones en milisegundos, contrastando con análisis manuales. No obstante, riesgos regulatorios surgen si se percibe como manipulación. En jurisdicciones latinoamericanas, similares iniciativas deben alinearse con leyes como la Ley Federal de Protección de Datos Personales en Posesión de los Particulares en México, enfatizando transparencia en algoritmos predictivos.

Desafíos Éticos y Limitaciones Técnicas

Éticamente, el uso de IA para predecir loterías plantea dilemas sobre equidad. Si el sistema favorece a entidades con acceso a datos avanzados, podría exacerbar desigualdades socioeconómicas. En Lleida, la iniciativa se presenta como experimental, pero expertos advierten contra falsas esperanzas, ya que la entropía en sorteos (medida por tests de Kolmogorov-Smirnov) confirma su aleatoriedad. Técnicamente, el overfitting es un desafío común; modelos que memorizan patrones históricos fallan en generalización, requiriendo técnicas como dropout en redes neuronales.

Otra limitación es la escalabilidad de datos. Con solo ~200 sorteos anuales para Navidad, el dataset es pequeño comparado con benchmarks en IA (millones de muestras). Soluciones incluyen augmentación de datos sintéticos vía GANs (Generative Adversarial Networks), generando escenarios hipotéticos realistas. En ciberseguridad, amenazas como model stealing —donde atacantes query el API para reconstruir el modelo— demandan defensas como rate limiting y watermarking digital.

Comparativamente, iniciativas globales como el uso de IA en predicciones de apuestas deportivas (por ejemplo, en la NBA con modelos de Elo rating) ofrecen lecciones. En blockchain, integraciones con smart contracts podrían auditar predicciones de forma inmutable, aunque no aplicable directamente aquí debido a la centralización del sorteo.

Análisis de Tecnologías Complementarias y Mejores Prácticas

Para potenciar sistemas como el de Lleida, se recomiendan tecnologías complementarias. El edge computing permite procesamiento local en dispositivos administrativos, reduciendo latencia. Frameworks como PyTorch facilitan prototipado rápido, mientras que MLOps tools (MLflow) gestionan ciclos de vida de modelos. En términos de estándares, adherencia a ISO/IEC 42001 para gestión de IA asegura calidad y riesgos controlados.

Mejores prácticas incluyen bias auditing: tests estadísticos para detectar sesgos en distribuciones numéricas. Por instancia, un chi-cuadrado test verifica si frecuencias de números siguen una distribución uniforme. En implementación, contenedores Docker aseguran portabilidad, y Kubernetes orquesta despliegues en clústeres híbridos.

En el contexto latinoamericano, donde loterías como la de Pronósticos en México generan ingresos significativos, adoptar enfoques similares podría modernizar operaciones. Sin embargo, se requiere capacitación en IA para funcionarios, cubriendo desde Python basics hasta ética algorítmica.

Casos de Estudio Comparativos en IA Predictiva

Más allá de Lleida, proyectos como el de IBM Watson en predicciones financieras demuestran viabilidad de IA en entornos estocásticos. En loterías, un estudio de la Universidad de Stanford analizó machine learning en Powerball, concluyendo que ensembles mejoran accuracy en 5-10% sobre baselines. Técnicamente, estos usan feature engineering: extrayendo features como suma de dígitos o paridad.

En blockchain, plataformas como Augur emplean IA para mercados de predicción descentralizados, integrando oráculos para validar outcomes. Aunque no directamente transferable, inspira híbridos donde IA alimenta contratos inteligentes para loterías transparentes.

En ciberseguridad, el caso resalta necesidad de secure multi-party computation (SMPC) para colaboraciones interadministrativas, protegiendo datos sensibles durante entrenamiento federado.

Implicaciones para el Futuro de la IA en el Sector Público

El caso de Lleida prefigura un futuro donde IA asiste decisiones públicas en áreas de incertidumbre. En salud pública, similares modelos predicen brotes; en finanzas, optimizan presupuestos. Técnicamente, avances en quantum computing podrían elevar precisiones, aunque hoy quantum machine learning (QML) permanece experimental.

Regulatoriamente, directivas como la EU AI Act clasifican tales sistemas como de bajo riesgo, pero exigen documentación. En Latinoamérica, marcos como el de Brasil’s LGPD alinean con esto, promoviendo innovación responsable.

Finalmente, este desarrollo subraya que, pese a limitaciones, la IA enriquece análisis predictivos, fomentando una administración data-driven. Para más información, visita la fuente original.

En resumen, la iniciativa de Lleida no solo demuestra viabilidad técnica de IA en predicciones aleatorias, sino que invita a una reflexión profunda sobre sus aplicaciones éticas y seguras en contextos públicos.