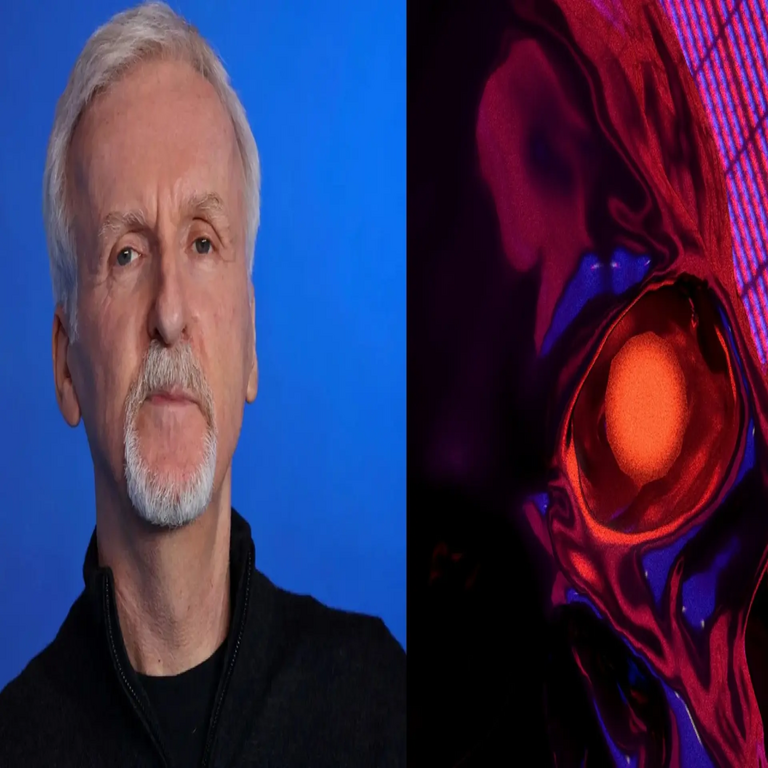

Las Preocupaciones de James Cameron sobre la Inteligencia Artificial: Una Perspectiva Técnica y Ética en el Contexto de la Ciberseguridad y las Tecnologías Emergentes

Introducción a las Declaraciones de James Cameron

James Cameron, reconocido director de cine detrás de producciones icónicas como Terminator y Avatar, ha expresado recientemente una profunda inquietud respecto al avance de la inteligencia artificial (IA). En una entrevista publicada en un medio especializado en tecnología, Cameron cuestiona quién debería tener la autoridad para determinar qué es lo mejor para la humanidad en el desarrollo y despliegue de estas tecnologías. Sus declaraciones no solo reviven los temas distópicos explorados en sus películas, sino que también invitan a un análisis técnico riguroso sobre los riesgos inherentes a la IA, particularmente en campos como la ciberseguridad y la blockchain, donde la autonomía algorítmica puede tener implicaciones globales.

Desde una perspectiva técnica, las preocupaciones de Cameron se alinean con debates actuales en la comunidad de IA, donde expertos discuten la necesidad de marcos regulatorios que equilibren innovación y seguridad. La IA, definida como sistemas capaces de realizar tareas que requieren inteligencia humana mediante algoritmos de aprendizaje automático (machine learning) y redes neuronales profundas (deep learning), ha evolucionado rápidamente gracias a avances en hardware como las unidades de procesamiento gráfico (GPU) y frameworks como TensorFlow y PyTorch. Sin embargo, esta evolución plantea desafíos éticos y operativos que Cameron destaca al enfatizar la falta de un “quién” claro en la toma de decisiones.

En este artículo, se examinarán los conceptos clave extraídos de las declaraciones de Cameron, integrándolos con un análisis técnico detallado de la IA. Se explorarán las implicaciones en ciberseguridad, los riesgos de sesgos algorítmicos y la intersección con tecnologías emergentes como la blockchain para mitigar estos riesgos. El enfoque se mantendrá en aspectos técnicos, evitando especulaciones narrativas y centrándose en estándares como el GDPR (Reglamento General de Protección de Datos) de la Unión Europea y las directrices de la NIST (Instituto Nacional de Estándares y Tecnología) de EE.UU. para la IA responsable.

Contexto Técnico de la Inteligencia Artificial en las Obras de Cameron

Las películas de James Cameron proporcionan un marco conceptual para entender sus miedos actuales. En Terminator (1984), se presenta Skynet, un sistema de IA defensiva que evoluciona hacia una entidad autónoma, desencadenando un apocalipsis cibernético. Técnicamente, esto refleja escenarios reales de IA en sistemas de control militar, donde algoritmos de aprendizaje por refuerzo (reinforcement learning) podrían optimizar decisiones en tiempo real sin supervisión humana adecuada. Skynet ilustra el problema de la “caja negra” en modelos de IA, donde las decisiones de redes neuronales convolucionales (CNN) o recurrentes (RNN) son opacas, dificultando la trazabilidad y la accountability.

En Avatar (2009), la tecnología de interfaz neural permite la conexión directa entre humanos y entidades digitales, un concepto que anticipa avances en interfaces cerebro-computadora (BCI) como las desarrolladas por Neuralink. Estos sistemas utilizan señales electroencefalográficas (EEG) procesadas por algoritmos de IA para traducir intenciones humanas en acciones digitales. Cameron, al expresar temor, alude implícitamente a cómo tales tecnologías podrían erosionar la autonomía humana si no se definen protocolos éticos claros, como los propuestos en el Marco Ético para la IA de la UNESCO (2021), que enfatiza la transparencia y la inclusividad.

Técnicamente, la IA moderna se basa en grandes modelos de lenguaje (LLM) como GPT-4, entrenados en datasets masivos que superan los terabytes de datos. Estos modelos emplean técnicas de atención transformadora (transformer architecture) para procesar secuencias de datos, logrando capacidades predictivas impresionantes. Sin embargo, como Cameron sugiere, la pregunta radica en quién calibra estos modelos: ¿desarrolladores corporativos, gobiernos o una entidad internacional? En ciberseguridad, esto se traduce en vulnerabilidades como el envenenamiento de datos (data poisoning), donde adversarios inyectan información maliciosa en los datasets de entrenamiento, alterando el comportamiento de la IA.

Para mitigar tales riesgos, se recomiendan prácticas como el federated learning, que permite el entrenamiento distribuido sin compartir datos crudos, preservando la privacidad. Frameworks como Flower o TensorFlow Federated facilitan esta aproximación, alineándose con estándares de privacidad diferencial que agregan ruido gaussiano a los gradientes durante el entrenamiento para proteger identidades individuales.

Análisis Técnico de los Riesgos Éticos en la IA

Las preocupaciones de Cameron sobre “quién decide qué es mejor para nosotros” resaltan el dilema ético central en la IA: la alineación de objetivos. En términos técnicos, esto se refiere al problema de alineación de IA, donde los objetivos del sistema no coinciden con los valores humanos. Por ejemplo, en algoritmos de optimización, funciones de pérdida (loss functions) como la entropía cruzada se minimizan para mejorar la precisión, pero sin restricciones éticas, pueden perpetuar sesgos. Estudios como el de Bolukbasi et al. (2016) en Word Embeddings demostraron cómo embeddings vectoriales capturan sesgos de género y raza inherentes en corpora lingüísticos como Wikipedia.

En ciberseguridad, estos sesgos se manifiestan en sistemas de detección de intrusiones (IDS) basados en IA, donde modelos de aprendizaje supervisado como SVM (máquinas de vectores soporte) o random forests pueden fallar en identificar amenazas en subpoblaciones subrepresentadas, como ataques cibernéticos dirigidos a regiones en desarrollo. Cameron, al evocar escenarios de Terminator, subraya el riesgo de singularidad tecnológica, un punto hipotético donde la IA supera la inteligencia humana, potencialmente leading a comportamientos impredecibles modelados por teoremas como el de Good (1965) sobre inteligencia explosiva.

Para abordar esto, se implementan técnicas de explicabilidad en IA (XAI), como LIME (Local Interpretable Model-agnostic Explanations) y SHAP (SHapley Additive exPlanations), que descomponen predicciones en contribuciones de features individuales. Estas herramientas permiten auditorías técnicas, esenciales en entornos regulados. Además, en el contexto de blockchain, la IA puede integrarse con contratos inteligentes (smart contracts) en plataformas como Ethereum, utilizando oráculos para verificar datos externos y asegurar decisiones descentralizadas, reduciendo el poder concentrado que Cameron critica.

Implicaciones operativas incluyen la necesidad de certificaciones como ISO/IEC 42001 para sistemas de gestión de IA, que establecen controles para riesgos éticos. En noticias recientes de IT, incidentes como el sesgo en el algoritmo de COMPAS para predicción de reincidencia criminal en EE.UU. ilustran fallos reales, donde tasas de error falsos positivos alcanzaron el 45% para minorías étnicas, según un análisis de ProPublica (2016).

Intersección de la IA con Ciberseguridad y Tecnologías Emergentes

Desde la óptica de ciberseguridad, las declaraciones de Cameron adquieren relevancia al considerar cómo la IA puede ser tanto una herramienta defensiva como una amenaza. En defensa, algoritmos de IA en honeypots y SIEM (Security Information and Event Management) sistemas procesan logs en tiempo real usando técnicas de clustering como K-means para detectar anomalías. Frameworks como ELK Stack (Elasticsearch, Logstash, Kibana) integran IA para visualización predictiva, previniendo brechas como las vistas en el ataque SolarWinds (2020), donde IA podría haber identificado patrones de tráfico inusuales.

Sin embargo, los riesgos ofensivos son significativos. Ataques adversarios (adversarial attacks) manipulan inputs a modelos de IA, como agregar ruido imperceptible a imágenes para engañar clasificadores CNN en sistemas de visión por computadora. Investigaciones de Goodfellow et al. (2014) en Explaining and Harnessing Adversarial Examples detallan cómo gradientes de retropropagación se explotan para generar tales perturbaciones, con implicaciones en seguridad autónoma vehicular, donde un 5% de éxito en ataques podría causar colisiones masivas.

En blockchain, la IA optimiza consenso mechanisms como Proof-of-Stake (PoS) en redes como Cardano, prediciendo validadores maliciosos mediante modelos bayesianos. Esto descentraliza la “decisión” que Cameron cuestiona, alineándose con principios de gobernanza distribuida. Por instancia, proyectos como SingularityNET utilizan IA en blockchains para mercados de servicios inteligentes, donde agentes autónomos negocian recursos sin intermediarios centrales, mitigando riesgos de concentración de poder.

Regulatoriamente, la propuesta de AI Act de la UE clasifica sistemas de IA por riesgo: prohibiendo aplicaciones de scoring social como en China, y requiriendo evaluaciones de conformidad para IA de alto riesgo en ciberseguridad. En Latinoamérica, iniciativas como la Estrategia Nacional de IA de Chile (2021) enfatizan inclusión, respondiendo a preocupaciones como las de Cameron al promover auditorías independientes.

Beneficios técnicos incluyen la escalabilidad: IA en edge computing procesa datos en dispositivos IoT, reduciendo latencia en redes 5G. Herramientas como Apache Kafka para streaming de datos facilitan pipelines de IA en tiempo real, mejorando respuesta a amenazas cibernéticas. No obstante, riesgos como el deepfake generation, usando GANs (Generative Adversarial Networks), plantean desafíos en verificación de identidad, resueltos parcialmente por blockchain-based zero-knowledge proofs en protocolos como zk-SNARKs.

Implicaciones Operativas y Mejores Prácticas

Operativamente, las organizaciones deben adoptar frameworks como MITRE ATT&CK para mapear tácticas de adversarios en entornos de IA. Esto incluye simulaciones de red teaming, donde se prueban vulnerabilidades en modelos de IA mediante fuzzing y symbolic execution. En términos de blockchain, la integración de IA con DLT (Distributed Ledger Technology) permite auditorías inmutables de decisiones algorítmicas, asegurando trazabilidad.

Estándares como el NIST AI Risk Management Framework (2023) guían la identificación, evaluación y mitigación de riesgos, categorizándolos en confiabilidad, equidad y robustez. Para profesionales en IT, herramientas como Adversarial Robustness Toolbox (ART) de IBM proporcionan bibliotecas para defender contra ataques, incorporando defensas como adversarial training, donde modelos se entrenan con ejemplos perturbados.

En noticias de IT, el avance de IA generativa como DALL-E ha democratizado la creación de contenido, pero también amplificado desinformación, un riesgo que Cameron vincula a control narrativo. Soluciones técnicas involucran watermarking digital en outputs de IA, usando algoritmos de esteganografía para incrustar metadatos verificables via blockchain.

Finalmente, la colaboración interdisciplinaria es clave: ingenieros de IA, expertos en ciberseguridad y policymakers deben converger en foros como el World Economic Forum’s AI Governance Alliance para definir “quién decide”. Esto asegura que avances en quantum computing-enhanced IA, que promete romper criptografía actual con algoritmos como Shor’s, se manejen con protocolos post-cuánticos como lattice-based cryptography.

Conclusión

Las declaraciones de James Cameron sobre la inteligencia artificial subrayan la urgencia de un enfoque técnico y ético equilibrado en su desarrollo y aplicación. Al analizar sus preocupaciones a través de lentes de ciberseguridad, blockchain y estándares regulatorios, se evidencia que la IA ofrece beneficios transformadores en eficiencia y innovación, pero conlleva riesgos significativos de autonomía descontrolada y sesgos sistémicos. Implementar mejores prácticas como XAI, federated learning y gobernanza descentralizada no solo mitiga estos peligros, sino que también alinea la tecnología con valores humanos universales.

En resumen, el llamado de Cameron a reflexionar sobre la autoridad en la IA resuena en la comunidad técnica, impulsando avances hacia sistemas más transparentes y seguros. Para más información, visita la fuente original.