La Competencia por Destronar a Nvidia: El Rol de Amazon y Google en la Evolución del Hardware para Inteligencia Artificial

En el panorama actual de la inteligencia artificial (IA), el hardware especializado se ha convertido en un pilar fundamental para el entrenamiento y despliegue de modelos de aprendizaje automático a gran escala. Nvidia ha dominado este mercado durante años gracias a sus unidades de procesamiento gráfico (GPUs) optimizadas para tareas computacionales paralelas, como el procesamiento de redes neuronales profundas. Sin embargo, la creciente demanda de soluciones de IA accesibles y eficientes ha impulsado a gigantes tecnológicos como Amazon y Google a desarrollar alternativas propias. Este artículo analiza las estrategias técnicas de estas empresas, sus implicaciones en el ecosistema de la IA y las oportunidades para la innovación en ciberseguridad y tecnologías emergentes.

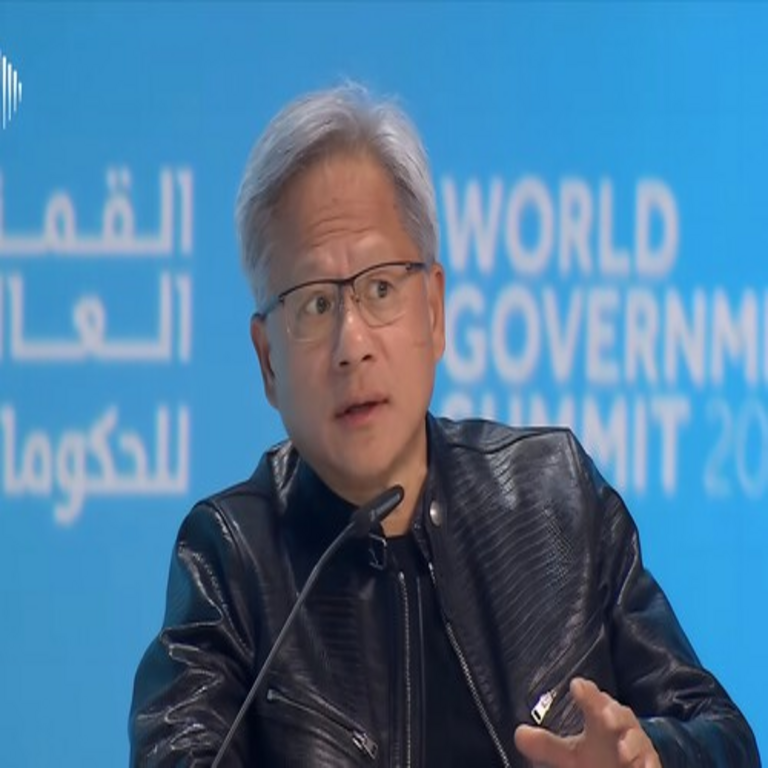

El Dominio de Nvidia en el Hardware para IA

Nvidia ha consolidado su posición mediante una arquitectura de GPUs basada en el modelo CUDA (Compute Unified Device Architecture), que permite una programación paralela eficiente en miles de núcleos. Sus productos emblemáticos, como las series A100 y H100, incorporan memorias HBM (High Bandwidth Memory) de alta velocidad, alcanzando anchos de banda superiores a 3 TB/s. Estas GPUs son esenciales para el entrenamiento de modelos grandes de lenguaje (LLMs), como GPT-4, donde el paralelismo masivo reduce tiempos de cómputo de semanas a horas.

Técnicamente, la ventaja de Nvidia radica en su integración de tensor cores, unidades especializadas en operaciones matriciales de punto flotante de precisión mixta (FP16 y FP8), que aceleran el forward y backward pass en redes neuronales convolucionales (CNNs) y transformers. Según datos de la industria, más del 80% de los clústeres de supercomputación para IA utilizan hardware Nvidia, lo que genera una dependencia significativa en el sector. Sin embargo, esta dominancia también plantea riesgos, como cuellos de botella en la cadena de suministro y vulnerabilidades en la seguridad de los chips, donde exploits como Spectre y Meltdown han demostrado la necesidad de mitigaciones hardware-level en diseños futuros.

Desde una perspectiva de ciberseguridad, las GPUs de Nvidia incorporan características como Secure Boot y cifrado de memoria mediante AES-256, pero la centralización en un solo proveedor expone a ecosistemas enteros a amenazas como ataques de cadena de suministro, similares a los vistos en el incidente SolarWinds. La competencia emergente podría diversificar estas vulnerabilidades, fomentando estándares abiertos como el OpenAI Hardware Alliance.

La Estrategia de Amazon Web Services (AWS) contra Nvidia

Amazon, a través de su división AWS, ha invertido en el desarrollo de chips personalizados para contrarrestar la dependencia de Nvidia. El Inferentia, lanzado en 2018, es un procesador de inferencia diseñado específicamente para ejecutar modelos de IA en producción, con un enfoque en eficiencia energética y latencia baja. Su arquitectura se basa en núcleos NeuronCore, que soportan operaciones de IA con precisión INT8 y FP16, optimizados para frameworks como TensorFlow y PyTorch.

Más recientemente, AWS introdujo el Trainium, un chip para entrenamiento de modelos, que compite directamente con las GPUs de Nvidia. Trainium utiliza una interconexión NeuronLink para escalar hasta miles de chips en clústeres, alcanzando un rendimiento equivalente a 100 GPUs A100 en términos de FLOPS (operaciones de punto flotante por segundo). Técnicamente, incorpora un compilador ML personalizado que optimiza el grafo de cómputo, reduciendo el overhead de memoria en un 40% comparado con soluciones genéricas.

En términos operativos, AWS integra estos chips en servicios como SageMaker, permitiendo a desarrolladores entrenar modelos sin migrar a hardware externo. Esto reduce costos en un 30-50% para cargas de trabajo de IA, según benchmarks internos. Desde el ángulo de la ciberseguridad, los chips de AWS enfatizan el aislamiento de tenants mediante enclaves seguros, similares a Intel SGX, protegiendo datos sensibles en entornos multiinquilino. Además, su integración con blockchain para trazabilidad de modelos IA podría mitigar riesgos de envenenamiento de datos en supply chains digitales.

Las implicaciones regulatorias son notables: al ser un proveedor cloud, AWS debe cumplir con estándares como GDPR y HIPAA, lo que obliga a sus chips a incluir hardware para privacidad diferencial y homomorfismo. Esto posiciona a Amazon como un actor clave en la soberanía de datos, especialmente en regiones con regulaciones estrictas como la UE, donde la dependencia de chips extranjeros es un punto de fricción geopolítica.

El Avance de Google con sus TPUs y Más Allá

Google ha sido pionero en hardware para IA con sus Tensor Processing Units (TPUs), introducidas en 2016. La cuarta generación, TPU v4, ofrece un rendimiento de 275 TFLOPS por chip en BF16, escalable a pods de 4096 unidades que superan los exaFLOPS. La arquitectura de TPU se centra en un systolic array para multiplicaciones matriciales, minimizando el movimiento de datos y logrando una eficiencia energética de hasta 200 TOPS/W, superior a las GPUs tradicionales.

Recientemente, Google ha expandido su portafolio con el Trillium (TPU v5), que incorpora soporte para sparse computing, reduciendo el cómputo en modelos con pesos cero, común en LLMs optimizados. Este chip integra memoria HBM3 con ancho de banda de 5.3 GB/s por pin, y utiliza un fabric de interconexión basado en Ethernet de 1.2 Tbps para clústeres distribuidos. En comparación con Nvidia, las TPUs destacan en workloads de inferencia a escala, como en Google Search o YouTube recommendations, donde el throughput es crítico.

Técnicamente, Google optimiza sus TPUs con el framework XLA (Accelerated Linear Algebra), que compila grafos de IA a código máquina eficiente, evitando abstracciones de alto nivel que generan overhead. Esto es particularmente útil en edge computing, donde Google despliega TPUs en dispositivos Pixel para procesamiento local de IA, mejorando la privacidad al evitar envíos a la nube.

En ciberseguridad, las TPUs incluyen mecanismos como confidential computing con AMD SEV-SNP, protegiendo contra accesos no autorizados en VMs. Google también explora integraciones con blockchain para verificación de integridad en modelos federados, abordando riesgos como backdoors en IA generativa. Las implicaciones operativas incluyen una mayor adopción en entornos híbridos, donde las TPUs se combinan con GPUs para workloads mixtos, fomentando estándares como ONNX para interoperabilidad.

Implicaciones Técnicas en el Ecosistema de IA

La entrada de Amazon y Google en la arena del hardware para IA acelera la innovación en arquitecturas especializadas. Mientras Nvidia se enfoca en GPUs versátiles, AWS y Google priorizan chips ASICs (Application-Specific Integrated Circuits) para tareas específicas, lo que reduce el consumo energético en un 50-70% para inferencia. Esto es crucial para la sostenibilidad, dado que el entrenamiento de un modelo como GPT-3 consume energía equivalente a 120 hogares estadounidenses anuales.

Desde una perspectiva técnica, surge la necesidad de benchmarks estandarizados. Herramientas como MLPerf evalúan rendimiento en escenarios reales, revelando que Trainium de AWS supera a H100 en eficiencia para entrenamiento de transformers, mientras TPUs v4 lideran en sparse models. Sin embargo, la fragmentación en ecosistemas —CUDA vs. Neuron SDK vs. XLA— complica la portabilidad de código, requiriendo abstracciones como Triton Inference Server para unificar despliegues.

- Beneficios operativos: Diversificación reduce riesgos de monopolio, bajando precios de hardware en un 20-30% a mediano plazo.

- Riesgos: Mayor complejidad en optimización de software, potencialmente incrementando vulnerabilidades en compiladores personalizados.

- Implicaciones en ciberseguridad: Chips diversificados permiten mitigaciones específicas, como hardware root-of-trust en Trainium para detectar tampering.

En blockchain, esta competencia podría impulsar hardware para minería eficiente y validación de transacciones IA-driven, como en redes proof-of-stake con oráculos inteligentes. Tecnologías emergentes como neuromorphic computing, exploradas por Google en su proyecto Loihi-inspired, prometen chips que emulan sinapsis cerebrales, reduciendo potencia en un orden de magnitud para edge AI.

Análisis de Riesgos y Oportunidades en Ciberseguridad

La guerra por destronar a Nvidia no solo es tecnológica, sino también un campo de batalla para la ciberseguridad. Los chips de IA procesan datos sensibles, haciendo imperativa la protección contra ataques side-channel, como cache timing en tensor cores. Amazon y Google incorporan defensas como rowhammer mitigation en sus memorias DDR5/HBM, alineadas con estándares NIST para hardware seguro.

Regulatoriamente, iniciativas como el CHIPS Act en EE.UU. subsidian desarrollo doméstico, incentivando a AWS y Google a invertir en fabs locales. Esto mitiga riesgos geopolíticos, como sanciones a proveedores taiwaneses de Nvidia. En IA, la competencia fomenta adversarial robustness, con chips que soportan entrenamiento con noise injection para resistir poisoning attacks.

Oportunidades incluyen integraciones con quantum-resistant cryptography en hardware, preparando para la era post-quantum. Por ejemplo, TPUs podrían acelerar algoritmos lattice-based, esenciales para firmas digitales en blockchain IA.

| Chip | Arquitectura Principal | Rendimiento (TFLOPS) | Eficiencia Energética (TOPS/W) | Aplicaciones Clave |

|---|---|---|---|---|

| Nvidia H100 | Tensor Cores con Hopper | 1979 (FP8) | ~100 | Entrenamiento LLMs |

| AWS Trainium | NeuronCore con NeuronLink | ~1000 (BF16) | ~150 | Entrenamiento distribuido |

| Google TPU v4 | Systolic Array | 275 (BF16) | ~200 | Inferencia a escala |

Esta tabla resume comparaciones técnicas, destacando cómo las alternativas optimizan para casos específicos.

Perspectivas Futuras y Tendencias Emergentes

La evolución del hardware para IA se dirige hacia heterogeneidad, con clústeres que combinan GPUs, TPUs y NPUs (Neural Processing Units) en un solo workload. Amazon planea integrar Trainium2 con optical interconnects para reducir latencia en data centers globales, mientras Google explora fotónica en TPUs para velocidades de luz en cómputo.

En ciberseguridad, la adopción de trusted execution environments (TEEs) en estos chips será estándar, alineado con frameworks como Confidential Computing Consortium. Para blockchain, hardware acelerado facilitará smart contracts con IA onboard, como en Ethereum 2.0 upgrades.

Las implicaciones para IT incluyen una transición hacia software-defined hardware, donde APIs como Kubernetes para IA gestionan recursos dinámicamente. Esto democratiza el acceso, permitiendo a startups competir sin presupuestos millonarios.

En resumen, la competencia iniciada por Amazon y Google no solo desafía el dominio de Nvidia, sino que redefine el panorama técnico de la IA, impulsando avances en eficiencia, seguridad y escalabilidad que beneficiarán a todo el sector tecnológico.

Para más información, visita la fuente original.