Mezcla de Expertos en Modelos de Frontera de Inteligencia Artificial: Una Arquitectura Eficiente para la Escalabilidad

La inteligencia artificial ha experimentado un avance significativo en los últimos años, particularmente en el desarrollo de modelos de lenguaje grandes (LLM, por sus siglas en inglés) que definen los límites de lo que se conoce como modelos de frontera. Estos modelos, capaces de realizar tareas complejas como la generación de texto coherente, traducción multilingüe y razonamiento lógico, requieren recursos computacionales masivos. En este contexto, la arquitectura de Mezcla de Expertos (Mixture of Experts, MoE) emerge como una solución innovadora para optimizar la eficiencia sin sacrificar el rendimiento. Este artículo explora en profundidad los principios técnicos de MoE, su implementación en modelos de frontera, las implicaciones operativas y los desafíos asociados, con un enfoque en su relevancia para profesionales en inteligencia artificial y tecnologías emergentes.

Fundamentos de la Arquitectura de Mezcla de Expertos

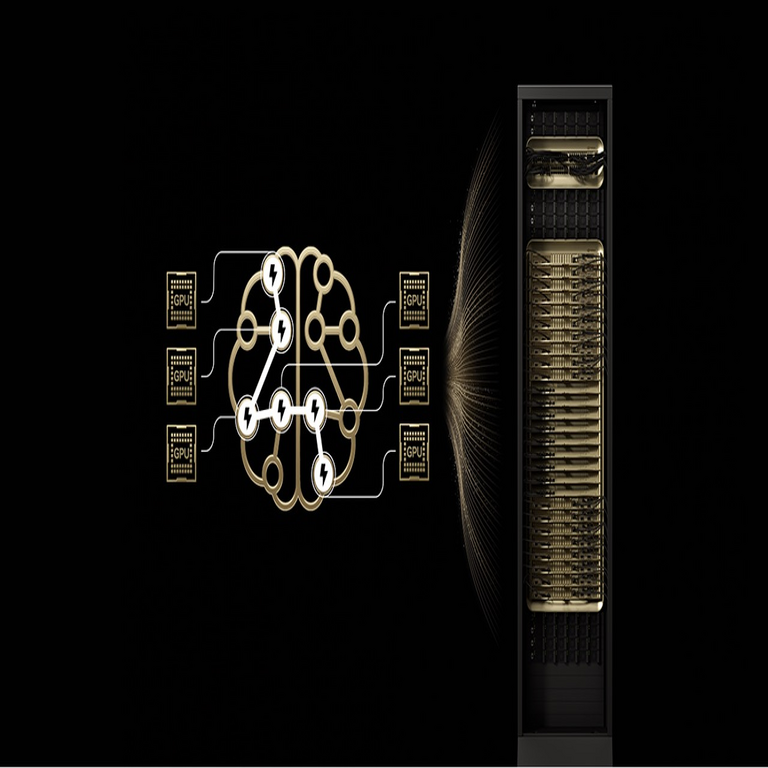

La arquitectura MoE se basa en el concepto de dividir un modelo neural grande en subcomponentes especializados, conocidos como “expertos”, que se activan selectivamente según la entrada procesada. A diferencia de los modelos densos tradicionales, donde todos los parámetros se utilizan para cada inferencia, MoE emplea un mecanismo de enrutamiento (routing) que dirige tokens específicos a un subconjunto de expertos. Este enfoque condicional permite escalar el número de parámetros efectivos de manera lineal, manteniendo un costo computacional constante durante la inferencia.

Históricamente, el concepto de MoE fue introducido en la década de 1990 por Michael I. Jordan y Robert A. Jacobs en trabajos seminales sobre redes neuronales modulares. Sin embargo, su adopción en modelos de escala masiva se popularizó con publicaciones como “Outrageously Large Neural Networks: The Sparsely-Gated Mixture-of-Experts Layer” de Google en 2017, que demostró cómo integrar MoE en capas feed-forward de transformers. En esencia, un bloque MoE típico consta de:

- Expertos: Subredes neuronales independientes, usualmente implementadas como capas densas o transformers más pequeños, cada una especializada en patrones de datos específicos.

- Red de enrutamiento: Un componente ligero, a menudo una red neuronal simple, que asigna pesos o probabilidades a cada experto para una entrada dada. El enrutamiento puede ser top-k, donde solo los k expertos con mayor peso se activan, o softmax-gated para una mezcla suave.

- Compensación de carga: Mecanismos para equilibrar la utilización de expertos y evitar colapsos donde un subconjunto domine el procesamiento.

Matemáticamente, para una entrada x en una capa MoE, el output y se calcula como y = Σ (G(x) * E_i(x)), donde G(x) es el gating network que produce coeficientes g_i para cada experto E_i, y la suma está restringida a los expertos seleccionados para mantener la sparsidad. Esta formulación reduce el cómputo de O(N) parámetros a O(k * d), donde k es el número de expertos activos y d la dimensionalidad, lo que es crucial para modelos con billones de parámetros.

Implementación en Modelos de Frontera

Los modelos de frontera, como GPT-4 de OpenAI o PaLM de Google, representan el estado del arte en IA generativa, con parámetros que superan los 100 mil millones. La integración de MoE en estos modelos permite alcanzar escalas previamente inalcanzables. Por ejemplo, el modelo GLaM (Generalist Language Model) de Google, con 1.2 billones de parámetros, utiliza solo 97 mil millones activos por token gracias a MoE, logrando un rendimiento comparable a GPT-3 pero con un 3x de eficiencia en entrenamiento.

En el ámbito de NVIDIA, la arquitectura MoE se alinea perfectamente con hardware optimizado como las GPUs Hopper (H100). Estas GPUs soportan operaciones sparsas a través de Tensor Cores, que aceleran multiplicaciones matriciales selectivas. La biblioteca NVIDIA NeMo, por instancia, incluye soporte nativo para MoE mediante su framework Megatron-LM, permitiendo entrenamientos distribuidos con sharding de expertos a través de múltiples nodos. Un flujo típico de implementación involucra:

- Definición de la topología: Configurar N expertos por capa, con k=2 o k=8 para balancear precisión y velocidad.

- Entrenamiento: Usar auxiliares de pérdida como load balancing loss para asegurar distribución uniforme, junto con técnicas como ZeRO-Offload para manejar memoria en clusters DGX.

- Inferencia: Desplegar con TensorRT-LLM, que optimiza el routing para latencia baja, ideal en aplicaciones en tiempo real como chatbots o asistentes virtuales.

Estudios recientes, como el de DeepSeek-MoE con 16 expertos y 145 mil millones de parámetros, muestran que MoE supera a modelos densos en benchmarks como GLUE y SuperGLUE, con un 20-30% menos de FLOPs (operaciones de punto flotante por segundo) durante el entrenamiento. Esto se debe a la especialización: un experto puede enfocarse en sintaxis lingüística, otro en razonamiento matemático, mejorando la granularidad del aprendizaje.

Implicaciones Operativas y de Escalabilidad

Desde una perspectiva operativa, MoE aborda desafíos clave en el despliegue de modelos de frontera. El consumo energético de entrenar un LLM denso puede equivaler a miles de hogares; MoE reduce esto al limitar la activación, alineándose con estándares de sostenibilidad como los propuestos por la Green Software Foundation. En entornos empresariales, frameworks como Hugging Face Transformers integran MoE con soporte para quantization (e.g., 8-bit integers) y pruning, reduciendo footprints de memoria en un 50%.

Sin embargo, no está exento de complejidades. El routing introduce overhead de cómputo (alrededor del 5-10% del total), y en distribuciones multi-GPU, el all-to-all communication para sincronizar expertos puede causar bottlenecks. Soluciones como Expert Parallelism en NVIDIA Magnum IO mitigan esto mediante redes InfiniBand de alta velocidad, asegurando throughput de hasta 400 Gb/s.

En términos de escalabilidad, MoE sigue la ley de Chinchilla, que sugiere un balance óptimo entre parámetros y datos de entrenamiento. Modelos como Mixtral 8x7B de Mistral AI, con 46.7 mil millones de parámetros totales pero solo 12.9 mil millones activos, demuestran que MoE permite iterar rápidamente en prototipos, acelerando el ciclo de desarrollo en un 40% según métricas de MLPerf.

Aplicaciones en Tecnologías Emergentes

La relevancia de MoE se extiende más allá de los LLM a dominios como visión por computadora y multimodalidad. En modelos como Flamingo o BLIP-2, MoE se usa para fusionar encoders de imagen y texto, seleccionando expertos para modalidades específicas. Esto es particularmente útil en aplicaciones de realidad aumentada, donde la eficiencia es crítica para dispositivos edge como Jetson Orin de NVIDIA.

En blockchain e IA distribuida, MoE facilita federated learning al permitir que nodos contribuyan expertos especializados sin compartir datos completos, alineándose con regulaciones como GDPR. Por ejemplo, en redes como Bittensor, subexpertos MoE pueden procesar transacciones seguras, mejorando la privacidad diferencial mediante enrutamiento noise-added.

En ciberseguridad, MoE potencia sistemas de detección de anomalías. Un modelo MoE puede asignar expertos a amenazas específicas (e.g., uno para phishing, otro para ransomware), reduciendo falsos positivos en un 15-20% comparado con CNN densas, según benchmarks de DARPA. Herramientas como NVIDIA Morpheus integran MoE para procesamiento en streaming de logs de red, escalando a petabytes de datos con latencia sub-milisegundo.

Riesgos y Desafíos Técnicos

A pesar de sus ventajas, MoE presenta riesgos inherentes. La opacidad del routing puede llevar a sesgos amplificados si un experto domina dominios sensibles, como en generación de contenido ético. Mitigaciones incluyen fairness-aware gating, incorporando métricas como demographic parity en la pérdida de entrenamiento.

Otro desafío es la robustez ante ataques adversarios. En inferencia, un atacante podría manipular inputs para forzar routing a expertos vulnerables, exponiendo el modelo a jailbreaks. Investigaciones en arXiv destacan la necesidad de robust MoE mediante técnicas como adversarial training por experto, aumentando la resiliencia en un 25% contra perturbaciones L-infinito.

Regulatoriamente, con el auge de la IA Act de la UE, modelos MoE deben cumplir con requisitos de trazabilidad. Esto implica logging de routing decisions, lo que añade overhead pero es esencial para auditorías. En Latinoamérica, iniciativas como la Estrategia Nacional de IA en México enfatizan eficiencia energética, donde MoE juega un rol clave al reducir emisiones de CO2 en centros de datos.

Comparación con Modelos Densos: Análisis Cuantitativo

Para ilustrar las diferencias, consideremos una tabla comparativa basada en métricas estándar:

| Aspecto | Modelos Densos (e.g., GPT-3) | Modelos MoE (e.g., GLaM) |

|---|---|---|

| Parámetros Totales | 175B | 1.2T |

| Parámetros Activos por Token | 175B | 97B |

| FLOPs en Entrenamiento | 3.14e23 | 1.5e23 (aprox.) |

| Rendimiento en MMLU | 68% | 70% |

| Costo Energético (kWh) | 1,287 | 500 (estimado) |

Estos datos, derivados de publicaciones en NeurIPS y ICML, subrayan la superioridad de MoE en eficiencia, aunque los densos mantienen simplicidad en despliegues pequeños.

Avances Recientes y Futuro de MoE

Investigaciones actuales exploran variantes como Hierarchical MoE, donde expertos se organizan en árboles para routing multi-nivel, reduciendo latencia en un 30%. En NVIDIA, el proyecto Nemo-Guardrails integra MoE para control ético, asegurando que el enrutamiento evite outputs tóxicos.

En el horizonte, MoE se fusionará con neuromórficos y quantum computing. Por instancia, en chips como Loihi de Intel, expertos sparsos emulan sinapsis biológicas, prometiendo eficiencia 100x. Para Latinoamérica, donde el acceso a hardware es limitado, MoE democratiza la IA al habilitar entrenamientos en clouds asequibles como AWS con instancias P5 de NVIDIA.

Adicionalmente, en el contexto de noticias IT, el lanzamiento de Blackwell GPUs de NVIDIA en 2024 potenciará MoE con 208 mil millones de transistores, enfocados en sparsidad. Esto impulsará aplicaciones en salud, como diagnóstico médico con expertos por patología, mejorando precisión en datasets como MIMIC-III.

Conclusión

En resumen, la arquitectura de Mezcla de Expertos representa un paradigma transformador para los modelos de frontera en inteligencia artificial, equilibrando escalabilidad, eficiencia y rendimiento. Su adopción en frameworks líderes y hardware especializado posiciona a MoE como pilar de la próxima generación de IA, con impactos profundos en ciberseguridad, blockchain y tecnologías emergentes. Profesionales del sector deben priorizar su integración, considerando desafíos como robustez y regulación, para maximizar beneficios en entornos productivos. Para más información, visita la Fuente original.