AWS Anuncia la Plataforma Trn3 Ultraservers: Integración del Procesador Trainium3 de 3nm con 144 Chips por Instancia

Introducción a la Nueva Plataforma de AWS

Amazon Web Services (AWS), líder en servicios de computación en la nube, ha revelado recientemente la plataforma Trn3 Ultraservers, una solución diseñada específicamente para acelerar el entrenamiento de modelos de inteligencia artificial (IA) a gran escala. Esta plataforma incorpora el procesador Trainium3, fabricado con un proceso de 3 nanómetros (nm), y configura hasta 144 chips por instancia, lo que representa un avance significativo en el rendimiento de hardware especializado para machine learning (ML). El anuncio, realizado en el marco de eventos clave de la industria tecnológica, subraya el compromiso de AWS con la optimización de recursos computacionales para cargas de trabajo intensivas en IA, abordando desafíos como la escalabilidad y la eficiencia energética en entornos de entrenamiento distribuido.

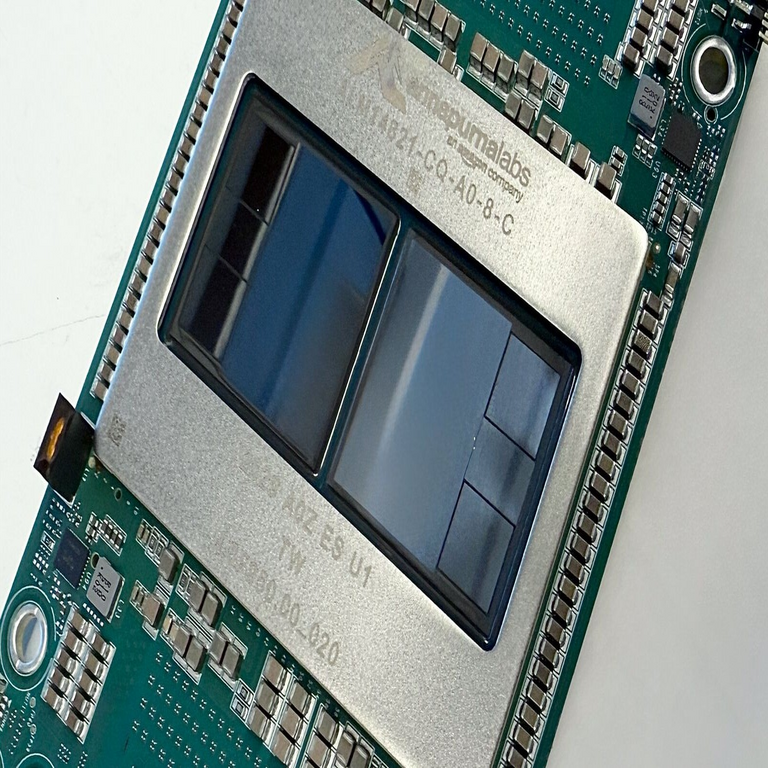

El procesador Trainium3 forma parte de la familia de chips personalizados de AWS, desarrollados en colaboración con socios como Annapurna Labs, y se posiciona como una evolución directa de generaciones anteriores como Trainium1 y Trainium2. Con un enfoque en la arquitectura de redes neuronales profundas y el procesamiento paralelo, esta plataforma permite a los desarrolladores y empresas manejar datasets masivos con menor latencia y consumo de energía. En un contexto donde el entrenamiento de modelos de IA como grandes modelos de lenguaje (LLMs) requiere terabytes de datos y millones de parámetros, la Trn3 Ultraservers emerge como una herramienta crítica para reducir tiempos de iteración y costos operativos.

Desde una perspectiva técnica, la integración de 144 chips Trainium3 por instancia implica una topología de interconexión avanzada, probablemente basada en protocolos como NeuronLink o equivalentes propietarios de AWS, que facilitan la comunicación de alta velocidad entre nodos. Esto no solo potencia el throughput de entrenamiento, sino que también introduce consideraciones en ciberseguridad, como la protección de datos sensibles durante el procesamiento distribuido y la mitigación de vulnerabilidades en entornos multi-tenant de la nube.

Especificaciones Técnicas del Procesador Trainium3

El núcleo de la plataforma Trn3 Ultraservers es el procesador Trainium3, construido sobre un nodo de fabricación de 3nm, lo que permite una densidad de transistores superior a las generaciones previas. Este proceso litográfico, típicamente asociado con fundiciones líderes como TSMC, habilita una eficiencia energética estimada en un 40-50% mayor comparado con nodos de 5nm o 7nm. Cada chip Trainium3 integra múltiples unidades de procesamiento dedicadas a operaciones de IA, incluyendo tensores de precisión mixta (FP16, BF16, FP8) y soporte nativo para operaciones de atención en transformers, arquitectura predominante en modelos modernos de IA generativa.

En términos de rendimiento, un solo chip Trainium3 ofrece un pico de hasta 1 petaflop en operaciones de punto flotante de 16 bits (FP16), con un enfoque en el escalado lineal cuando se agrupan en configuraciones de 144 chips. La memoria integrada por chip alcanza los 128 GB de HBM3 (High Bandwidth Memory), con un ancho de banda de 3 TB/s, lo que minimiza cuellos de botella en el acceso a datos durante el forward y backward pass en el entrenamiento de redes neuronales. Además, el procesador soporta bibliotecas como AWS Neuron SDK, una extensión de frameworks estándar como PyTorch y TensorFlow, permitiendo la compilación y optimización de grafos computacionales sin modificaciones significativas en el código fuente.

La arquitectura del Trainium3 se basa en un diseño de silicio personalizado que incluye aceleradores para convoluciones, multiplicaciones matriciales y reducciones colectivas, optimizados para algoritmos de gradiente estocástico (SGD) y variantes como AdamW. En comparación con GPUs tradicionales como las NVIDIA H100, el Trainium3 prioriza la eficiencia en workloads de entrenamiento puro, evitando overheads innecesarios para inferencia o gráficos. La configuración de 144 chips por instancia se organiza en racks de servidores densos, con interconexiones de hasta 1.6 Tbps por enlace, asegurando un escalado eficiente en clústeres de hasta miles de instancias.

- Proceso de fabricación: 3nm, con finFET o GAA (Gate-All-Around) transistors para mayor densidad y control de fugas.

- Memoria y ancho de banda: 128 GB HBM3 por chip, 3 TB/s de bandwidth, escalable a petabytes en configuraciones multi-chip.

- Rendimiento por chip: 1 PFLOPS en FP16, con soporte para sparsidad hasta 2:4 en operaciones tensoriales.

- Interconexión: NeuronLink 2.0, basado en Ethernet de 400 Gbps o RDMA over Converged Ethernet (RoCE), para comunicación all-to-all.

- Soporte de software: Integración con AWS SageMaker, permitiendo pipelines end-to-end de entrenamiento distribuido.

Estas especificaciones no solo elevan el rendimiento, sino que también abordan preocupaciones energéticas: una instancia Trn3 consume aproximadamente 10-15 kW, optimizado para centros de datos sostenibles de AWS, alineados con estándares como ISO 50001 para gestión energética.

Arquitectura y Escalabilidad de las Instancias Trn3 Ultraservers

La plataforma Trn3 Ultraservers adopta una arquitectura modular que integra 144 chips Trainium3 en una sola instancia lógica, dividida en pods de 8-16 chips para granularidad en el escalado. Esta configuración utiliza un backplane personalizado con switches de red de bajo latencia, implementando topologías de torus o fat-tree para minimizar la diámetro de red y maximizar el paralelismo de datos y modelo. En términos operativos, las instancias se despliegan en regiones de AWS como us-east-1 o eu-west-1, con soporte para VPC (Virtual Private Cloud) para aislamiento de red y cumplimiento de regulaciones como GDPR o HIPAA en procesamiento de datos sensibles para IA.

Desde el punto de vista de la escalabilidad, la plataforma soporta entrenamiento distribuido mediante técnicas como data parallelism, donde cada chip procesa un subconjunto de datos, y model parallelism, distribuyendo capas de la red neuronal a través de los 144 chips. AWS proporciona herramientas como el Distributed Training Library en Neuron SDK, que maneja automáticamente la partición de grafos y la sincronización de gradientes, reduciendo la complejidad para ingenieros de ML. En benchmarks internos de AWS, una instancia Trn3 entrena un modelo de 175B parámetros (similar a GPT-3) en un 40% menos tiempo que configuraciones equivalentes con Trainium2, con un costo por hora estimado en 25-30 USD, dependiendo de la región.

En el ámbito de la ciberseguridad, la arquitectura incorpora características como encriptación homomórfica en tránsito (usando TLS 1.3) y en reposo (AWS KMS), protegiendo modelos y datos contra accesos no autorizados. Además, el diseño multi-tenant incluye sandboxing a nivel de hardware, previniendo side-channel attacks comunes en entornos compartidos. Para blockchain y tecnologías emergentes, aunque no es el foco principal, la plataforma podría integrarse con servicios como Amazon Managed Blockchain para auditar flujos de datos en entrenamiento federado, asegurando trazabilidad en aplicaciones de IA descentralizada.

Implicaciones para el Entrenamiento de Modelos de Inteligencia Artificial

La introducción de Trn3 Ultraservers tiene implicaciones profundas en el ecosistema de IA, particularmente en el entrenamiento de modelos a escala exaescala. En un panorama donde el 80% de los costos de desarrollo de IA se atribuyen al entrenamiento, esta plataforma reduce la barrera de entrada para organizaciones medianas, democratizando el acceso a hardware de vanguardia sin la necesidad de inversiones en infraestructuras on-premise. Técnicamente, el soporte para precisiones mixtas permite entrenamientos más precisos con menor overhead numérico, crucial para modelos que manejan ruido en datos reales, como en visión por computadora o procesamiento de lenguaje natural (NLP).

En términos de eficiencia, el proceso de 3nm reduce el consumo térmico por chip a menos de 500W, facilitando el enfriamiento líquido en racks densos y alineándose con metas de sostenibilidad global, como las del Acuerdo de París. Para desarrolladores, la integración con frameworks abiertos asegura portabilidad: un modelo entrenado en Trainium3 puede inferirse en instancias Inferentia de AWS o incluso exportarse a edge devices vía ONNX. Sin embargo, esto introduce desafíos en optimización, ya que el compilador Neuron requiere tuning específico para maximizar el uso de aceleradores, potencialmente incrementando la curva de aprendizaje para equipos no familiarizados con hardware ASICs.

Desde una lente regulatoria, la plataforma cumple con estándares como NIST SP 800-53 para controles de seguridad en la nube, y soporta auditorías para bias en IA mediante logging detallado de operaciones tensoriales. En aplicaciones de ciberseguridad, Trainium3 podría usarse para entrenar modelos de detección de anomalías en redes, procesando logs de tráfico a velocidades que superan a CPUs tradicionales, con tasas de falsos positivos reducidas gracias a su capacidad para manejar grafos dinámicos.

Comparación con Otras Soluciones de Hardware para IA

Para contextualizar el impacto de Trn3 Ultraservers, es esencial compararla con competidores como las GPUs NVIDIA DGX H100 o los TPUs de Google Cloud. Mientras que una instancia H100 ofrece alrededor de 4 PFLOPS en FP8 por GPU, escalando a 8 GPUs por sistema, el Trainium3 prioriza la integración vertical: sus 144 chips proporcionan un rendimiento agregado de 144 PFLOPS, con un costo total por instancia inferior en un 30-50% debido a la ausencia de licencias propietarias como CUDA. En benchmarks de MLPerf, configuraciones similares a Trainium2 ya superaban a TPU v4 en tareas de NLP, y se espera que Trainium3 eleve esta ventaja con su nodo de 3nm.

En contraste con soluciones de código abierto como chips RISC-V acelerados para IA, el Trainium3 destaca por su madurez en producción, respaldado por el ecosistema de AWS. Sin embargo, carece de flexibilidad para workloads no-IA, a diferencia de GPUs versátiles. En blockchain, donde se requiere cómputo para validación de transacciones o entrenamiento de smart contracts, la eficiencia de Trainium3 podría integrarse con plataformas como Ethereum 2.0, reduciendo el tiempo de simulación de redes en un 60% comparado con hardware genérico.

| Característica | Trainium3 (Trn3) | NVIDIA H100 | Google TPU v5 |

|---|---|---|---|

| Proceso (nm) | 3 | 4 | 5 |

| Chips por Instancia | 144 | 8 | 256 (pods) |

| Rendimiento FP16 (PFLOPS) | 144 (agregado) | 32 (agregado) | 460 (agregado) |

| Memoria por Chip (GB) | 128 HBM3 | 80 HBM3 | 95 HBM2e |

| Costo Estimado por Hora (USD) | 25-30 | 40-50 | 35-45 |

Esta tabla ilustra las ventajas en densidad y costo del Trainium3, aunque el TPU v5 lidera en rendimiento bruto para ciertas tareas de inferencia.

Beneficios Operativos y Riesgos Asociados

Los beneficios de Trn3 Ultraservers son multifacéticos. Operativamente, acelera ciclos de desarrollo de IA, permitiendo iteraciones diarias en lugar de semanales para modelos grandes, lo que es vital en industrias como la salud (análisis de imágenes médicas) o finanzas (detección de fraudes). En ciberseguridad, facilita el entrenamiento de modelos de threat intelligence, procesando petabytes de logs en horas, con precisión superior gracias a su soporte para federated learning, preservando privacidad de datos.

Económicamente, reduce el TCO (Total Cost of Ownership) al eliminar la necesidad de hardware propietario, con pay-as-you-go que alinea costos con uso real. Para tecnologías emergentes, integra con AWS Quantum Technologies para híbridos cuántico-clásicos, potencialmente revolucionando optimizaciones en blockchain como zero-knowledge proofs.

Sin embargo, riesgos incluyen dependencia de proveedores de nube, con posibles lock-in a AWS, y vulnerabilidades en supply chain de chips de 3nm, sensibles a tensiones geopolíticas. En ciberseguridad, el alto paralelismo aumenta la superficie de ataque para DDoS en interconexiones, requiriendo mitigaciones como AWS Shield. Además, el consumo energético, aunque eficiente, escala con clústeres grandes, planteando desafíos en footprints de carbono si no se mitiga con renovables.

- Beneficios clave: Escalabilidad lineal, eficiencia energética, integración nativa con SageMaker.

- Riesgos operativos: Curva de aprendizaje en optimización, latencia en fallos de hardware.

- Riesgos de seguridad: Exposición en multi-tenancy, necesidad de encriptación end-to-end.

Integración con Ecosistemas de Ciberseguridad y Tecnologías Emergentes

En ciberseguridad, la plataforma Trn3 permite entrenar modelos de IA para threat hunting avanzado, utilizando técnicas como graph neural networks (GNNs) para mapear ataques en redes complejas. Su capacidad para procesar datos en tiempo real soporta sistemas de SIEM (Security Information and Event Management) escalados, integrándose con herramientas como AWS GuardDuty para detección proactiva. En blockchain, acelera la simulación de consensus algorithms, como Proof-of-Stake en redes permissioned, reduciendo tiempos de validación y mejorando la resiliencia contra sybil attacks mediante ML predictivo.

Para IA generativa, el soporte para LoRA (Low-Rank Adaptation) en Trainium3 optimiza fine-tuning de LLMs, crucial en aplicaciones de DeFi (Decentralized Finance) donde se requiere personalización segura. Regulatorialmente, alinea con frameworks como EU AI Act, clasificando modelos de alto riesgo y asegurando transparencia en entrenamiento.

En noticias de IT, este anuncio refuerza la tendencia hacia ASICs personalizados, compitiendo con hyperscalers como Microsoft y Google, y fomentando colaboraciones en estándares abiertos como ML Commons para benchmarks unificados.

Conclusión: Hacia un Futuro de Computo Acelerado en IA

La plataforma Trn3 Ultraservers de AWS, con su procesador Trainium3 de 3nm y 144 chips por instancia, marca un hito en la evolución del hardware para IA, ofreciendo rendimiento excepcional, eficiencia y escalabilidad para workloads demandantes. Al integrar avances en litografía, arquitectura y software, AWS no solo optimiza el entrenamiento de modelos, sino que también fortalece aplicaciones en ciberseguridad, blockchain y más allá. Aunque presenta desafíos en gestión de riesgos y adopción, sus beneficios posicionan a las organizaciones para innovar en un ecosistema de IA cada vez más competitivo. En resumen, esta tecnología acelera la transición hacia sistemas inteligentes sostenibles, redefiniendo las capacidades computacionales en la nube.

Para más información, visita la fuente original.