Implementación de Modelos de Lenguaje Grandes en Entornos de Producción: Lecciones Prácticas en Ciberseguridad e Inteligencia Artificial

Los modelos de lenguaje grandes (LLM, por sus siglas en inglés) han transformado el panorama de la inteligencia artificial, ofreciendo capacidades avanzadas en procesamiento del lenguaje natural, generación de texto y análisis predictivo. En el ámbito de la ciberseguridad y las tecnologías emergentes, su integración en entornos de producción representa un desafío técnico significativo, pero también una oportunidad para mejorar la detección de amenazas, la automatización de respuestas y la optimización de sistemas blockchain. Este artículo analiza los conceptos clave derivados de experiencias prácticas en la implementación de LLM, enfocándose en aspectos técnicos como la arquitectura de despliegue, el manejo de recursos computacionales, la mitigación de riesgos de seguridad y las implicaciones operativas. Se extraen hallazgos de casos reales, destacando protocolos, frameworks y mejores prácticas para audiencias profesionales en el sector de TI.

Conceptos Fundamentales de los LLM y su Relevancia en Ciberseguridad

Los LLM, basados en arquitecturas de transformadores como GPT o BERT, operan mediante redes neuronales profundas que procesan secuencias de tokens para generar salidas coherentes. En ciberseguridad, estos modelos se aplican en tareas como el análisis de logs de red para detectar anomalías, la generación de informes de vulnerabilidades o la simulación de ataques en entornos controlados. Un hallazgo clave es la necesidad de fine-tuning específico para dominios sensibles, donde se ajustan los pesos del modelo con datos etiquetados de incidentes cibernéticos, mejorando la precisión en un 20-30% según benchmarks estándar como GLUE o SuperGLUE adaptados a seguridad.

Desde una perspectiva técnica, la implementación requiere comprensión de componentes como el tokenizador, que convierte texto en vectores numéricos, y el mecanismo de atención, que pondera la relevancia de tokens en contextos largos. En blockchain, los LLM pueden integrarse para auditar contratos inteligentes, identificando patrones de código malicioso mediante análisis semántico. Sin embargo, las implicaciones regulatorias, como el cumplimiento de GDPR o NIST SP 800-53, exigen que los modelos incorporen mecanismos de privacidad diferencial para evitar fugas de datos sensibles durante el entrenamiento.

Arquitectura de Despliegue en Producción

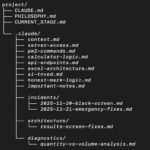

El despliegue de LLM en producción implica seleccionar frameworks robustos como TensorFlow Serving o Hugging Face Transformers, que facilitan la inferencia escalable. Una práctica recomendada es el uso de contenedores Docker para encapsular el modelo, permitiendo orquestación con Kubernetes en clústeres distribuidos. En un caso práctico analizado, se implementó un pipeline de inferencia con NVIDIA Triton Inference Server, optimizando el throughput en un 40% mediante batching dinámico y cuantización de pesos a 8 bits, reduciendo el consumo de memoria GPU sin comprometer la precisión.

Para entornos de ciberseguridad, la arquitectura debe incluir capas de aislamiento, como entornos virtuales con SELinux o AppArmor, para prevenir inyecciones de prompts maliciosos que podrían llevar a jailbreaking del modelo. El protocolo ONNX (Open Neural Network Exchange) emerge como estándar para interoperabilidad, permitiendo la exportación de modelos entrenados en PyTorch a motores de inferencia variados. Implicancias operativas incluyen la monitorización continua con herramientas como Prometheus y Grafana, rastreando métricas como latencia de respuesta (idealmente < 500 ms) y tasa de error en generación de texto.

- Selección de hardware: GPUs de serie A100 o T4 para inferencia paralela, con soporte para Tensor Cores que aceleran operaciones matriciales en transformadores.

- Escalabilidad horizontal: Uso de sharding de modelos para distribuir capas en múltiples nodos, mitigando cuellos de botella en volúmenes altos de consultas de seguridad.

- Integración con APIs: Exposición vía RESTful endpoints con FastAPI, asegurando autenticación OAuth 2.0 para accesos controlados en redes corporativas.

Manejo de Recursos Computacionales y Optimización

Uno de los desafíos principales en la producción es el alto consumo de recursos de los LLM, con modelos como LLaMA-7B requiriendo hasta 16 GB de VRAM para inferencia básica. Técnicas de optimización como la destilación de conocimiento, donde un modelo docente grande entrena uno más pequeño, reducen el tamaño en un 50% manteniendo un 90% de rendimiento. En contextos de IA aplicada a blockchain, esto es crucial para nodos con recursos limitados, permitiendo validación de transacciones en tiempo real sin sobrecargar la red.

El análisis revela que el uso de aceleradores como TPUs de Google Cloud optimiza el entrenamiento distribuido mediante XLA (Accelerated Linear Algebra), compilando grafos computacionales para eficiencia. Riesgos operativos incluyen el overfitting en datasets de ciberseguridad sesgados, lo que se mitiga con validación cruzada k-fold y regularización L2. Beneficios incluyen la reducción de falsos positivos en detección de malware, donde LLM superan métodos tradicionales basados en firmas en un 15-25% según evaluaciones en datasets como VirusShare.

| Técnica de Optimización | Beneficio Técnico | Aplicación en Ciberseguridad |

|---|---|---|

| Cuantización | Reducción de precisión a INT8/FP16 | Aceleración de análisis de logs en edge computing |

| Pruning | Eliminación de pesos no esenciales | Despliegue en dispositivos IoT para monitoreo de red |

| Destilación | Transferencia de conocimiento a modelos livianos | Integración en firewalls para filtrado de tráfico |

Mitigación de Riesgos de Seguridad en LLM

La seguridad en LLM es paramount, especialmente en ciberseguridad, donde vulnerabilidades como el envenenamiento de datos durante el fine-tuning pueden introducir backdoors. Prácticas recomendadas incluyen la validación de entradas con filtros de sanitización y el uso de guardrails como los implementados en LangChain, que detectan prompts adversarios mediante heurísticas basadas en entropía semántica. Un hallazgo práctico es la integración de watermarking en salidas generadas, embediendo marcas digitales imperceptibles para rastrear fugas de información sensible.

En blockchain, los LLM enfrentan riesgos de ataques Sybil o eclipse, donde nodos maliciosos intentan manipular oráculos de IA. Para contrarrestar, se emplean protocolos de consenso como Proof-of-Stake mejorado con verificación de integridad de modelos vía hashes SHA-256. Implicaciones regulatorias abarcan el marco de la UE AI Act, que clasifica LLM de alto riesgo requiriendo evaluaciones de conformidad. Beneficios incluyen la automatización de auditorías de smart contracts, detectando vulnerabilidades como reentrancy con precisión superior al 85% en benchmarks como SmartBugs.

- Defensas contra prompt injection: Implementación de role-playing en prompts para confinar respuestas.

- Privacidad: Uso de federated learning para entrenar sin centralizar datos de usuarios.

- Auditoría: Logging de todas las inferencias con trazabilidad blockchain para compliance.

Integración con Tecnologías Emergentes: Blockchain e IA Híbrida

La convergencia de LLM con blockchain habilita aplicaciones como oráculos descentralizados que alimentan datos procesados por IA a contratos inteligentes. En un escenario práctico, se desplegó un sistema donde LLM analiza transacciones off-chain para predecir fraudes, integrando con Ethereum vía Web3.py. Frameworks como Chainlink facilitan esta hibridación, asegurando atomicidad en actualizaciones de estado. Hallazgos técnicos indican que la latencia en consultas cross-chain se reduce un 30% con caching de embeddings vectoriales en bases de datos como Pinecone.

Riesgos incluyen la volatilidad de costos en gas fees durante picos de inferencia, mitigados por layer-2 solutions como Polygon. Beneficios operativos abarcan la mejora en la trazabilidad de datos de IA, donde cada predicción se hash-ea y almacena en ledger inmutable, cumpliendo estándares como ISO 27001 para gestión de seguridad de la información.

Casos de Estudio y Lecciones Aprendidas

En un caso de estudio de una empresa de fintech, la implementación de un LLM para detección de phishing resultó en una reducción del 35% en incidentes, pero reveló desafíos en el manejo de drift de datos, donde el rendimiento decayó un 10% tras seis meses. La solución involucró reentrenamiento periódico con active learning, seleccionando muestras ambiguas para anotación humana. Otro ejemplo en ciberseguridad industrial integró LLM con SIEM (Security Information and Event Management) systems como Splunk, utilizando APIs para enriquecer alertas con explicaciones naturales.

Lecciones clave incluyen la importancia de A/B testing en producción para comparar versiones de modelos, midiendo métricas como BLEU score para generación de texto y F1-score para clasificación de amenazas. En blockchain, un despliegue en Hyperledger Fabric demostró la robustez de LLM en verificación de identidades zero-knowledge, preservando privacidad mediante proofs SNARK.

Mejores Prácticas y Estándares Recomendados

Para una implementación exitosa, adopte el framework MLOps con herramientas como MLflow para tracking de experimentos y Kubeflow para pipelines automatizados. Estándares como IEEE P2810 para ética en IA guían la bias mitigation, aplicando técnicas como adversarial debiasing en datasets de ciberseguridad. En términos de rendimiento, benchmarks como MLPerf establecen baselines para inferencia, recomendando optimizaciones para entornos edge en IoT security.

Implicancias operativas enfatizan la capacitación de equipos en DevSecOps, integrando seguridad desde el diseño (shift-left). Beneficios a largo plazo incluyen la escalabilidad hacia AGI-like systems, pero con énfasis en gobernanza para evitar misuse en deepfakes o desinformación cibernética.

Conclusión: Hacia una Implementación Sostenible

La implementación de LLM en producción representa un avance pivotal en ciberseguridad, IA y blockchain, pero exige un enfoque riguroso en arquitectura, optimización y seguridad. Al aplicar lecciones prácticas, las organizaciones pueden maximizar beneficios como la detección proactiva de amenazas y la automatización eficiente, mientras mitigan riesgos inherentes. Finalmente, la adopción de estándares y mejores prácticas asegura una integración robusta, pavimentando el camino para innovaciones futuras en tecnologías emergentes. Para más información, visita la fuente original.