Configuración de CI/CD para Microservicios en Kubernetes: Una Guía Técnica Detallada

En el panorama actual de la ingeniería de software, la adopción de arquitecturas basadas en microservicios ha transformado la forma en que las organizaciones desarrollan, despliegan y mantienen aplicaciones escalables. Kubernetes, como orquestador de contenedores líder, se ha convertido en la plataforma predilecta para gestionar estos entornos distribuidos. Sin embargo, la implementación efectiva de pipelines de integración continua (CI) y despliegue continuo (CD) en tales sistemas requiere una comprensión profunda de herramientas, protocolos y mejores prácticas. Este artículo explora de manera técnica y detallada el proceso de configuración de CI/CD para microservicios en Kubernetes, basándose en experiencias prácticas y estándares del sector.

La integración continua implica la automatización de la compilación, pruebas y validación de código fuente cada vez que se realiza un cambio, mientras que el despliegue continuo extiende esta automatización al proceso de liberación de software en entornos de producción. En el contexto de microservicios, donde cada servicio opera de forma independiente pero interactúa con otros, los pipelines CI/CD deben manejar complejidades como la contenedorización con Docker, el manejo de secretos, el monitoreo de salud y la gestión de actualizaciones rodantes. A lo largo de este análisis, se detallarán los componentes clave, herramientas recomendadas y consideraciones operativas para lograr una implementación robusta.

Fundamentos de Microservicios y Kubernetes en CI/CD

Los microservicios representan una arquitectura donde las aplicaciones se dividen en servicios pequeños, autónomos y desacoplados, cada uno responsable de una función específica. Esta modularidad facilita el desarrollo paralelo, la escalabilidad horizontal y la resiliencia, pero introduce desafíos en la coordinación y el despliegue. Kubernetes aborda estos mediante su modelo de pods, deployments, services y namespaces, permitiendo la orquestación automática de contenedores Docker.

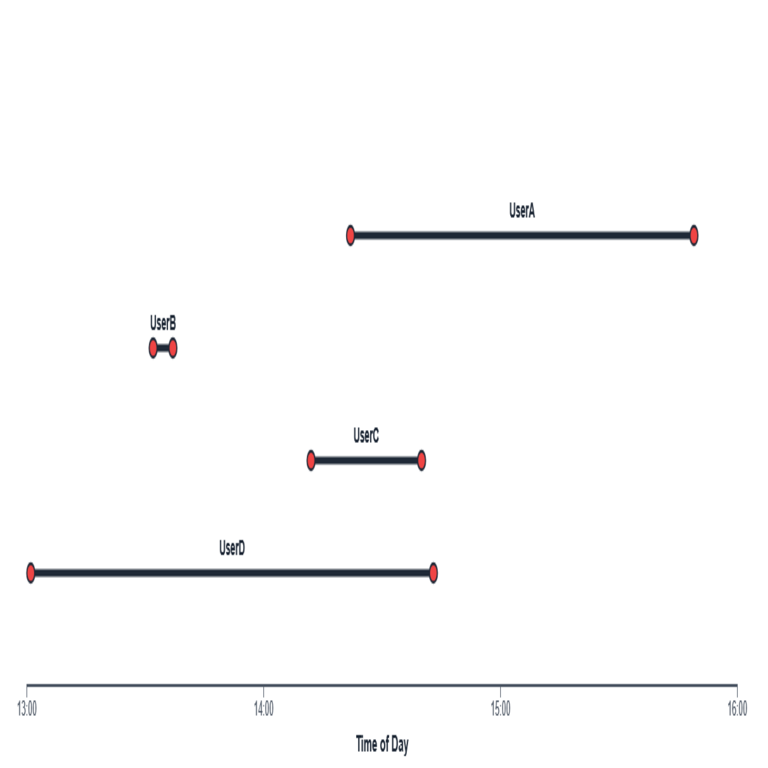

En un pipeline CI/CD, el flujo típico inicia con el control de versiones en Git, seguido de la compilación de imágenes de contenedores, pruebas unitarias e integradas, escaneo de vulnerabilidades y, finalmente, el despliegue en clústeres de Kubernetes. Herramientas como Jenkins, GitLab CI o GitHub Actions sirven como orquestadores de CI, mientras que Helm, Kustomize o ArgoCD facilitan el CD en Kubernetes. Según el informe de la Cloud Native Computing Foundation (CNCF), más del 80% de las organizaciones que utilizan Kubernetes integran pipelines CI/CD para automatizar despliegues, reduciendo tiempos de liberación de semanas a minutos.

Conceptos clave incluyen el uso de manifests de Kubernetes (archivos YAML que definen recursos como Deployments y Services) y el principio de GitOps, donde el estado deseado del clúster se declara en un repositorio Git, y herramientas como Flux o ArgoCD sincronizan automáticamente el estado real con el deseado. Esto asegura reproducibilidad y trazabilidad, esenciales en entornos de microservicios donde los cambios en un servicio pueden impactar a otros.

Selección y Configuración de Herramientas para CI

La fase de integración continua comienza con la detección de cambios en el repositorio. Utilizando webhooks de Git, herramientas como Jenkins pueden triggering jobs automáticamente. Para microservicios, es crucial estructurar el pipeline por servicio: cada repositorio de microservicio debe tener su propio pipeline que compile el código fuente en una imagen Docker.

Consideremos Jenkins como ejemplo principal. Se configura un pipeline declarativo en un archivo Jenkinsfile, que define etapas como checkout, build, test y push. En la etapa de build, se utiliza un Dockerfile para empaquetar la aplicación, incorporando dependencias y configuraciones de entorno. Un Dockerfile típico para un microservicio Node.js podría incluir:

- FROM node:18-alpine como imagen base ligera.

- COPY package*.json ./ para instalar dependencias con npm ci.

- COPY . . y RUN npm run build para compilar el código.

- EXPOSE 3000 y CMD [“npm”, “start”] para exponer el puerto y ejecutar la app.

Posteriormente, se construye la imagen con docker build -t mi-microservicio:v1.0 . y se empuja a un registro como Docker Hub o un privado como Harbor, utilizando docker push. Para optimizar, se implementa multi-stage builds para reducir el tamaño de la imagen final, alineándose con mejores prácticas de seguridad como las recomendadas por el OWASP Docker Security Cheat Sheet.

Las pruebas en CI son críticas: unitarias con frameworks como Jest o JUnit, integradas con herramientas como Postman para APIs, y de carga con JMeter. Además, escaneos de vulnerabilidades con Trivy o Clair detectan issues en dependencias y la imagen misma. En Kubernetes, pruebas de humo (smoke tests) validan la conectividad post-despliegue mediante kubectl port-forward o curls a services.

Otras herramientas incluyen GitLab CI, que usa archivos .gitlab-ci.yml con stages y jobs paralelos para microservicios, permitiendo herencia de configuraciones comunes. Para entornos distribuidos, Argo Workflows orquesta flujos complejos, integrando con Kubernetes nativamente.

Implementación de Despliegue Continuo en Kubernetes

Una vez validada en CI, la fase CD despliega la imagen en el clúster de Kubernetes. El desafío radica en manejar actualizaciones sin downtime, utilizando estrategias como rolling updates en Deployments. Un Deployment YAML define replicas, selector de pods y template de pod, con spec.template.spec.containers.image actualizándose dinámicamente.

Helm emerge como gestor de paquetes para Kubernetes, encapsulando manifests en charts reutilizables. Un chart de Helm para un microservicio incluye templates para Deployment, Service y ConfigMap, con valores parametrizados para entornos (dev, staging, prod). La instalación se realiza con helm upgrade –install mi-servicio ./chart –values values-prod.yaml, permitiendo zero-downtime deployments mediante hooks pre/post-install.

Kustomize, integrado en kubectl, ofrece una alternativa ligera para personalizar bases YAML sin templates. Se define un kustomization.yaml con bases y parches, como cambiar imágenes o recursos por namespace. Para GitOps, ArgoCD monitorea el repositorio Git y aplica drifts automáticamente, usando Application CRDs para declarar apps.

La gestión de secretos es vital: Kubernetes Secrets almacenan tokens y claves, montados como volúmenes en pods. Integrar con Vault o AWS Secrets Manager vía operadores como external-secrets asegura rotación automática. En CD, políticas de RBAC (Role-Based Access Control) restringen accesos, alineadas con el principio de menor privilegio.

Para multi-entorno, se utilizan namespaces separados, con NetworkPolicies para aislamiento de tráfico. Istio o Linkerd como service meshes añaden capas de observabilidad y seguridad, inyectando sidecars en pods durante el despliegue.

Consideraciones de Seguridad y Monitoreo en Pipelines CI/CD

La seguridad en CI/CD para microservicios en Kubernetes no es opcional. Desde la fase CI, firmar imágenes con cosign o notar compliant con Sigstore previene supply chain attacks. Escaneos SAST/DAST con SonarQube o Checkmarx identifican vulnerabilidades en código y runtime.

En CD, validaciones como OPA/Gatekeeper enforzan políticas de admisión, rechazando deployments no conformes (e.g., imágenes sin escaneo). Para Kubernetes, habilitar Pod Security Standards (PSS) en versiones 1.23+ restringe privilegios como runAsNonRoot.

El monitoreo integra Prometheus para métricas de pods y services, Grafana para dashboards y ELK stack para logs. Alertmanager notifica issues como fallos en health checks (liveness/readiness probes en pods). En pipelines, stages de monitoreo post-despliegue verifican métricas como CPU/memory usage y latency de APIs.

Riesgos incluyen misconfiguraciones en RBAC leading a escaladas de privilegios, o exposición de secrets en logs. Beneficios abarcan resiliencia: actualizaciones canary o blue-green con Flagger permiten rollout gradual, midiendo KPIs como error rates antes de promover a producción.

Escalabilidad y Optimización de Pipelines para Microservicios

En arquitecturas con docenas de microservicios, pipelines centralizados fallan en escalabilidad. Adoptar pipelines distribuidos, donde cada servicio tiene su runner dedicado (e.g., GitLab runners en Kubernetes via gitlab-runner operator), reduce bottlenecks.

Optimizaciones incluyen caching de dependencias en CI (e.g., Docker layer caching) y paralelización de jobs. Para CD, operators como Keel o Goldilocks automatizan actualizaciones de imágenes y right-sizing de recursos.

Integración con cloud providers: En AWS EKS, usar eksctl para clústeres y CodePipeline para CD. En GCP GKE, Cloud Build maneja CI con kaniko para builds sin Docker daemon. Azure AKS integra con Azure DevOps.

Estándares como OpenTelemetry para tracing distribuido y eBPF para observabilidad kernel-level mejoran debugging en microservicios. El ciclo de vida completo incluye rollbacks automáticos via kubectl rollout undo si probes fallan.

Casos de Estudio y Mejores Prácticas

Empresas como Netflix y Spotify han refinado CI/CD en Kubernetes para cientos de microservicios. Netflix usa Spinnaker para CD multi-cloud, con canary deployments basados en métricas de usuario. Spotify emplea Backstage para portal de servicios, integrando pipelines con Tekton.

Mejores prácticas:

- Versionado semántico para imágenes y charts (e.g., v1.2.3).

- Pruebas en entornos mirror de producción usando kind o minikube.

- Auditorías regulares con kube-bench contra CIS Benchmarks.

- Documentación de pipelines como código, con tests para el pipeline mismo (pipeline as code).

Implicaciones regulatorias incluyen compliance con GDPR o PCI-DSS, donde pipelines deben loggear accesos y retener artifacts por períodos definidos.

Desafíos Comunes y Soluciones

Desafíos incluyen coordinación entre equipos (solved con service ownership models) y manejo de dependencias inter-servicios (usando contract testing con Pact). Flaky tests se mitigan con retries y isolation en CI.

En clústeres grandes, resource quotas por namespace previenen starvation. Para alta disponibilidad, multi-AZ deployments y affinity rules aseguran distribución.

En resumen, configurar CI/CD para microservicios en Kubernetes demanda una integración meticulosa de herramientas y prácticas, pero yields eficiencia operativa y agilidad. Para más información, visita la Fuente original.