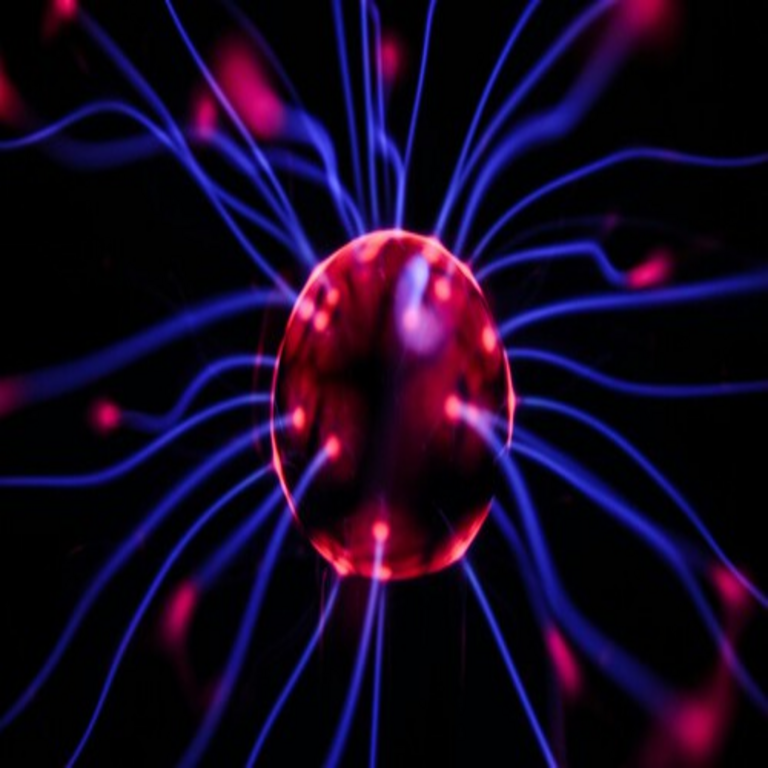

La Intersección entre Neurociencia e Inteligencia Artificial: La Nueva Frontera de las Grandes Empresas Tecnológicas

En el panorama actual de la tecnología, la inteligencia artificial (IA) ha alcanzado avances significativos, pero sus límites en términos de eficiencia, razonamiento y comprensión del mundo real impulsan a las principales empresas del sector a explorar nuevas fronteras. Una de estas fronteras es la neurociencia, el estudio científico del sistema nervioso, particularmente del cerebro humano. Las compañías líderes en IA, como Meta, Google y OpenAI, reconocen que el cerebro humano representa un modelo biológico supremamente eficiente para el procesamiento de información, y están invirtiendo recursos sustanciales en laboratorios y colaboraciones interdisciplinarias para integrar principios neurocientíficos en el desarrollo de sistemas de IA más avanzados. Este enfoque no solo busca mejorar el rendimiento de los modelos de IA, sino también abordar desafíos fundamentales como el consumo energético y la capacidad de generalización.

Antecedentes Históricos de la Inspiración Biológica en la IA

La conexión entre neurociencia e IA no es un fenómeno reciente. Desde los inicios de la cibernética en la década de 1940, figuras como Warren McCulloch y Walter Pitts propusieron modelos matemáticos de neuronas artificiales inspirados en las células nerviosas biológicas. Estos trabajos sentaron las bases para las redes neuronales artificiales (RNA), que hoy en día sustentan la mayoría de los sistemas de aprendizaje profundo. Sin embargo, durante décadas, el progreso en IA se centró en enfoques computacionales abstractos, alejándose en cierta medida de la biología. En las últimas dos décadas, con el auge del big data y la potencia computacional, ha resurgido el interés por emular la arquitectura cerebral.

El cerebro humano, con aproximadamente 86 mil millones de neuronas interconectadas mediante sinapsis, procesa información de manera paralela y distribuida, consumiendo solo alrededor de 20 vatios de energía, en contraste con los miles de vatios requeridos por supercomputadoras que entrenan modelos de IA como GPT-4. Esta disparidad energética ha motivado investigaciones en computación neuromórfica, que busca hardware y software que repliquen la plasticidad sináptica y la eficiencia neuronal. Estándares como el de la International Brain Initiative promueven la estandarización de datos neurocientíficos para su integración en modelos de IA, facilitando el intercambio de conocimiento entre disciplinas.

En términos técnicos, las RNA convolucionales (CNN) y las redes recurrentes (RNN), predecesoras de los transformadores modernos, ya incorporaban elementos inspirados en la visión y el procesamiento secuencial del cerebro. Hoy, los transformadores, introducidos en el paper “Attention is All You Need” de 2017, utilizan mecanismos de atención que simulan selectivamente el enfoque cognitivo humano, pero carecen de la robustez adaptativa del cerebro ante datos escasos o ruidosos.

Iniciativas de Meta en Neurociencia e IA

Meta, anteriormente conocida como Facebook, ha sido una de las pioneras en formalizar esta intersección mediante la creación de laboratorios dedicados. En 2023, la compañía inauguró un centro de neurociencia en París, Francia, enfocado en mapear circuitos neuronales y su aplicación a algoritmos de IA. Este laboratorio colabora con instituciones como el Institut du Cerveau (ICM) y utiliza técnicas avanzadas como la optogenética y la imagenología funcional por resonancia magnética (fMRI) para estudiar cómo las neuronas codifican representaciones abstractas, como el lenguaje o la memoria espacial.

Técnicamente, Meta explora la integración de modelos de IA con simulaciones neuronales a gran escala. Por ejemplo, su proyecto de IA generativa incorpora módulos inspirados en el hipocampo, responsable de la formación de memorias en el cerebro, para mejorar la retención contextual en conversaciones largas. Esto se logra mediante arquitecturas híbridas que combinan transformadores con grafos neuronales dinámicos, permitiendo que el modelo “olvide” información irrelevante de manera selectiva, similar al proceso de consolidación de memoria en humanos. Los beneficios operativos incluyen una reducción en el tamaño de los modelos, lo que disminuye el costo computacional en un 20-30% según estimaciones internas de Meta.

Además, Meta invierte en hardware neuromórfico, como chips que emulan spikes neuronales en lugar de operaciones flotantes tradicionales. Estos dispositivos, basados en principios de spiking neural networks (SNN), procesan información de forma asincrónica, mejorando la eficiencia en tareas de tiempo real como el reconocimiento de voz en entornos ruidosos. Sin embargo, riesgos como la opacidad de estos modelos híbridos plantean desafíos regulatorios, ya que la Unión Europea, a través del AI Act, exige mayor transparencia en sistemas de alto riesgo.

Colaboraciones de Google DeepMind en la Fusión Neuro-IA

Google DeepMind, la división de investigación en IA de Alphabet, ha establecido alianzas estratégicas con neurocientíficos de universidades como Stanford y el Max Planck Institute. Un ejemplo clave es el proyecto GNoME (Graph Networks for Materials Exploration), que aunque enfocado en descubrimiento de materiales, utiliza principios de conectómica —el mapeo completo de conexiones neuronales— para optimizar redes de IA. DeepMind argumenta que entender la estructura del cerebro, como el cerebelo responsable del control motor, puede inspirar algoritmos de refuerzo más eficientes para robótica.

En detalle, DeepMind emplea técnicas de aprendizaje por refuerzo profundo (DRL) inspiradas en el sistema de recompensas dopaminérgico del cerebro. Modelos como AlphaGo integraron elementos de planificación jerárquica, similar a cómo el córtex prefrontal organiza decisiones complejas. Recientemente, han desarrollado simuladores cerebrales virtuales usando datos de fMRI y electroencefalografía (EEG), permitiendo entrenar IA en escenarios hipotéticos de cognición humana. Esto implica el uso de frameworks como TensorFlow con extensiones para modelado bayesiano, que incorporan incertidumbre neuronal para mejorar la robustez de los modelos ante adversarios en ciberseguridad, como ataques de envenenamiento de datos.

Las implicaciones operativas son profundas: en ciberseguridad, estos avances podrían llevar a sistemas de detección de anomalías más intuitivos, emulando la intuición humana para identificar amenazas zero-day. No obstante, beneficios como la aceleración en el descubrimiento farmacéutico —usando IA para simular interacciones neuronales en enfermedades como el Alzheimer— deben equilibrarse con riesgos éticos, incluyendo el potencial mal uso en vigilancia neuronal.

OpenAI y la Exploración de la Cognición Humana en Modelos de Lenguaje

OpenAI, creadores de ChatGPT, ha manifestado interés en la neurociencia como vía para superar limitaciones en el razonamiento causal de sus modelos de lenguaje grandes (LLM). En colaboraciones con neurocientíficos de MIT, exploran cómo el lóbulo temporal integra conocimiento semántico, aplicándolo a mejoras en la comprensión multimodal de IA. Técnicamente, esto involucra la fusión de LLM con modelos de visión computacional inspirados en la corteza visual, utilizando arquitecturas como CLIP pero enriquecidas con datos de neuroimagen.

Un avance notable es la incorporación de plasticidad sináptica en el entrenamiento, donde los pesos de la red se ajustan dinámicamente basados en patrones de activación cerebral simulados. Esto reduce el fenómeno de “alucinaciones” en LLM, donde generan información falsa, al emular la verificación cruzada neuronal. En términos de blockchain y tecnologías emergentes, OpenAI considera integrar estos modelos en redes distribuidas para entrenamiento federado, preservando privacidad de datos neurocientíficos sensibles mediante protocolos como homomorphic encryption.

Los riesgos incluyen sesgos amplificados si los datos neuronales provienen de poblaciones no diversas, lo que podría perpetuar desigualdades en aplicaciones de IA en salud mental. Regulatoriamente, agencias como la FDA en Estados Unidos evalúan estos híbridos como dispositivos médicos si se aplican a diagnósticos neuronales.

Tecnologías Clave y Mejores Prácticas en la Integración Neuro-IA

La integración de neurociencia en IA abarca varias tecnologías emergentes. Las redes neuronales neuromórficas, como las desarrolladas por IBM con su chip TrueNorth, utilizan eventos de spikes para procesamiento eficiente, contrastando con el cómputo síncrono de GPUs tradicionales. Protocolos como el de la Human Brain Project en Europa proporcionan datasets estandarizados, como el Allen Brain Atlas, que mapea expresión génica en regiones cerebrales para entrenar modelos de IA en tareas de segmentación.

En cuanto a frameworks, PyTorch y JAX se adaptan bien para simulaciones híbridas, permitiendo la implementación de ecuaciones diferenciales que modelan dinámicas neuronales, como el modelo de Hodgkin-Huxley para potenciales de acción. Mejores prácticas incluyen el uso de validación cruzada con datos biológicos reales para evitar overfitting, y la adopción de estándares éticos como los de la IEEE para IA responsable.

- Computación Neuromórfica: Hardware que emula sinapsis con memristores, reduciendo consumo energético en un factor de 1000 comparado con von Neumann tradicional.

- Aprendizaje Inspirado en el Cerebro: Técnicas como el aprendizaje Hebbiano, donde “neuronas que disparan juntas se conectan juntas”, aplicado a clustering en datos no supervisados.

- Interfaz Cerebro-Máquina (BCI): Dispositivos como Neuralink de Elon Musk, que aunque controvertidos, proporcionan datos directos para calibrar modelos de IA en control motor.

En ciberseguridad, estos avances fortalecen defensas contra ataques adversariales, ya que modelos inspirados en el cerebro son más resilientes a perturbaciones, simulando la adaptabilidad homeostática neuronal.

Implicaciones Operativas, Regulatorias, Riesgos y Beneficios

Operativamente, la neuro-IA promete optimizaciones en industrias como la automotriz, donde algoritmos de conducción autónoma incorporan percepción sensorial cerebral para mejor navegación en entornos dinámicos. En blockchain, podría mejorar contratos inteligentes mediante razonamiento probabilístico inspirado en inferencia bayesiana cortical.

Regulatoriamente, el GDPR en Europa y la CCPA en California exigen protección de datos neurocientíficos, clasificados como sensibles. Riesgos incluyen la dual-use technology, donde avances en IA neuronal podrían usarse en armas autónomas, violando tratados como la Convención sobre Armas Convencionales.

Beneficios abarcan avances en medicina, como IA para predecir epilepsia mediante análisis de patrones EEG, y en sostenibilidad, reduciendo la huella de carbono de centros de datos mediante eficiencia neuromórfica. Sin embargo, la brecha de habilidades entre neurocientíficos y ingenieros de IA requiere programas educativos integrados.

| Tecnología | Aplicación en IA | Beneficio Principal | Riesgo Asociado |

|---|---|---|---|

| Spiking Neural Networks | Procesamiento en tiempo real | Eficiencia energética | Complejidad de entrenamiento |

| Optogenética en Modelos | Control preciso de simulaciones | Precisión en mapeo neuronal | Ética en experimentos animales |

| Transformadores Híbridos | Razonamiento multimodal | Mejor generalización | Opacidad algorítmica |

Desafíos Éticos y Futuros Desarrollos

Éticamente, la monetización de datos cerebrales plantea preocupaciones de privacidad, similar a debates en IA generativa. Organizaciones como la UNESCO promueven marcos para IA ética, enfatizando equidad en el acceso a tecnologías neuro-IA.

En el futuro, se espera la emergencia de IA “consciente” limitada, emulando estados de atención sostenida del cerebro, lo que revolucionaría campos como la educación personalizada y la terapia cognitiva. Colaboraciones globales, como la BRAIN Initiative de EE.UU., acelerarán estos progresos.

En resumen, la inversión de grandes empresas en laboratorios de neurociencia marca un paradigma shift en el desarrollo de IA, fusionando biología y silicio para sistemas más eficientes y adaptativos. Esta trayectoria promete transformar no solo la tecnología, sino nuestra comprensión del intelecto humano. Para más información, visita la fuente original.