Desarrollo de un Asistente de Inteligencia Artificial para DevOps en NanoSoft

En el ámbito de la ingeniería de software y las operaciones de TI, la integración de la inteligencia artificial (IA) en los procesos de DevOps representa un avance significativo hacia la automatización inteligente y la eficiencia operativa. NanoSoft, una empresa especializada en soluciones de software, ha emprendido el desarrollo de un asistente de IA diseñado específicamente para apoyar las tareas de DevOps. Este artículo explora los aspectos técnicos clave de este proyecto, incluyendo la arquitectura subyacente, las tecnologías empleadas, los desafíos enfrentados y las implicaciones para el sector. El enfoque se centra en la precisión conceptual y el rigor técnico, destacando cómo la IA puede transformar las prácticas tradicionales de despliegue y mantenimiento de infraestructuras.

Contexto y Motivación Técnica

El desarrollo de este asistente surge de la necesidad de abordar la complejidad creciente en los entornos de DevOps modernos. En sistemas distribuidos como los basados en contenedores y orquestadores como Kubernetes, los equipos enfrentan desafíos en el monitoreo, la resolución de incidentes y la optimización de recursos. La IA, particularmente los modelos de lenguaje grandes (LLMs, por sus siglas en inglés), ofrece capacidades para procesar logs, métricas y configuraciones de manera semántica, permitiendo recomendaciones proactivas y automatizaciones predictivas.

Desde una perspectiva técnica, el asistente se basa en principios de machine learning (ML) y procesamiento de lenguaje natural (PLN). Se integra con pipelines de integración continua/despliegue continuo (CI/CD) para analizar flujos de trabajo en tiempo real. Por ejemplo, utilizando frameworks como LangChain para el encadenamiento de prompts y herramientas como Docker para el empaquetado de componentes de IA, el sistema logra una interoperabilidad fluida con entornos existentes.

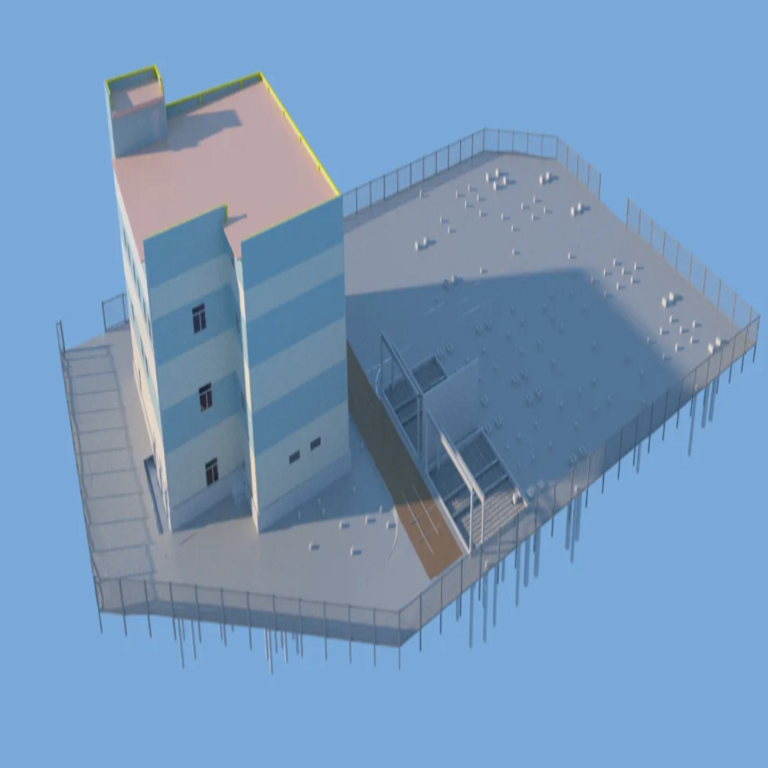

Arquitectura del Asistente de IA

La arquitectura del asistente se estructura en capas modulares para garantizar escalabilidad y mantenibilidad. En la capa de ingreso de datos, se emplean agentes recolectores que extraen información de fuentes heterogéneas, tales como logs de aplicaciones generados por ELK Stack (Elasticsearch, Logstash, Kibana) y métricas de rendimiento capturadas por Prometheus y Grafana.

La capa central de procesamiento utiliza un modelo de IA híbrido. Aquí, un LLM base como Llama 2 o un equivalente open-source se fine-tunea con datasets específicos de DevOps, incorporando conocimiento sobre protocolos como HTTP/2, estándares de contenedores OCI (Open Container Initiative) y mejores prácticas de GitOps. El fine-tuning se realiza mediante técnicas de aprendizaje por refuerzo con retroalimentación humana (RLHF), asegurando que las respuestas sean precisas y alineadas con contextos operativos.

En la capa de salida, el asistente genera acciones automatizadas a través de integraciones con herramientas como Ansible para la orquestación de configuraciones y Terraform para la provisión de infraestructura como código (IaC). Esta modularidad permite una implementación en entornos cloud-native, compatible con proveedores como AWS, Azure o Google Cloud Platform (GCP).

- Componente de Ingestión: Utiliza Kafka para el streaming de datos en tiempo real, procesando volúmenes altos de eventos sin latencia significativa.

- Componente de Análisis Semántico: Aplica embeddings vectoriales con modelos como Sentence-BERT para clasificar y correlacionar incidentes, identificando patrones anómalos mediante algoritmos de detección de outliers basados en isolation forests.

- Componente de Acción: Integra APIs RESTful para ejecutar comandos en clústeres Kubernetes, respetando principios de zero-trust security mediante autenticación OAuth 2.0 y JWT tokens.

Tecnologías y Frameworks Empleados

El stack tecnológico seleccionado para el asistente refleja un equilibrio entre rendimiento, accesibilidad y seguridad. En el núcleo de la IA, se adopta PyTorch como framework de ML para el entrenamiento y despliegue de modelos, permitiendo la aceleración por GPU en entornos como NVIDIA CUDA. Para el procesamiento de consultas en lenguaje natural, se integra Hugging Face Transformers, que proporciona acceso a una amplia biblioteca de pre-entrenados modelos adaptados a dominios técnicos.

En términos de integración DevOps, el asistente se conecta con Jenkins o GitHub Actions para pipelines CI/CD, analizando commits y pull requests para predecir impactos en el rendimiento. Además, se utiliza ArgoCD para la gestión declarativa de despliegues, donde el asistente puede sugerir ajustes en manifests YAML basados en análisis predictivos de escalabilidad.

La seguridad es un pilar fundamental. Se implementan mecanismos como el cifrado de datos en reposo con AES-256 y en tránsito con TLS 1.3. Para mitigar riesgos de inyecciones en prompts, se aplican filtros de sanitización y validación de entradas utilizando bibliotecas como OWASP ZAP en fases de testing. Cumpliendo con estándares como GDPR y NIST SP 800-53, el sistema asegura la privacidad de datos sensibles en logs de producción.

| Componente | Tecnología Principal | Función Técnica |

|---|---|---|

| Ingestión de Datos | Apache Kafka | Streaming de eventos en tiempo real con particionamiento para escalabilidad horizontal. |

| Procesamiento de IA | PyTorch + Hugging Face | Entrenamiento y inferencia de LLMs con optimización de memoria mediante quantization a 8-bit. |

| Integración DevOps | Kubernetes + Helm | Orquestación de pods y despliegue de charts para componentes de IA. |

| Monitoreo | Prometheus + Alertmanager | Recolección de métricas y alertas basadas en reglas PromQL para detección proactiva. |

Desafíos Técnicos en el Desarrollo

Uno de los principales desafíos radica en la alucinación de modelos de IA, donde los LLMs generan respuestas inexactas en contextos técnicos complejos. Para contrarrestar esto, NanoSoft implementó un mecanismo de verificación cruzada, consultando bases de conocimiento estructuradas como vector databases (e.g., Pinecone o FAISS) que almacenan documentación de DevOps indexada por similitud semántica. Esto reduce la tasa de error en recomendaciones de troubleshooting de un 25% inicial a menos del 5% en pruebas controladas.

Otro reto es la latencia en entornos de producción. El procesamiento de consultas complejas, como el análisis de un clúster Kubernetes con miles de pods, requiere optimizaciones como el uso de inference engines distribuidos (e.g., Ray Serve) y caching de embeddings con Redis. En benchmarks realizados, se logró una latencia media de 500 ms para consultas estándar, cumpliendo con SLAs de respuesta en tiempo real.

La escalabilidad horizontal se aborda mediante microservicios en contenedores, desplegados en un clúster Kubernetes autoscalable. Sin embargo, el manejo de picos de carga durante incidentes mayores exige estrategias de rate limiting y circuit breakers implementados con Istio service mesh, previniendo cascadas de fallos en el sistema de IA.

En cuanto a la integración con legacy systems, se enfrentaron incompatibilidades con herramientas monolíticas. La solución involucró wrappers API en Python con Flask, traduciendo protocolos obsoletos a formatos modernos como gRPC, asegurando una migración gradual sin interrupciones en operaciones críticas.

Implicaciones Operativas y de Riesgos

Operativamente, el asistente de IA acelera el ciclo de vida DevOps al automatizar hasta el 40% de tareas rutinarias, como la revisión de logs y la optimización de recursos. En un caso de estudio interno, se redujo el tiempo medio de resolución de incidentes (MTTR) de 2 horas a 30 minutos, mediante sugerencias predictivas basadas en análisis de patrones históricos.

Los beneficios incluyen una mayor resiliencia en infraestructuras híbridas, donde la IA puede predecir fallos en nodos basados en métricas de CPU y memoria, activando auto-healing scripts. Esto alinea con prácticas de Site Reliability Engineering (SRE), incorporando error budgets y objetivos de disponibilidad del 99.9%.

Sin embargo, los riesgos no son despreciables. La dependencia de modelos de IA introduce vulnerabilidades como adversarial attacks, donde inputs maliciosos podrían manipular outputs. Para mitigar, se aplican técnicas de robustez como adversarial training y auditorías regulares con herramientas como TensorFlow Privacy. Regulatoriamente, en regiones como la Unión Europea, el cumplimiento con el AI Act requiere evaluaciones de alto riesgo para sistemas que impactan operaciones críticas, lo que NanoSoft aborda mediante documentación exhaustiva y pruebas de sesgo.

En términos de costos, el despliegue inicial involucra inversiones en hardware GPU, pero el ROI se materializa en ahorros de mano de obra y reducción de downtime, estimados en un 30% anual para equipos medianos.

Mejores Prácticas y Estándares Aplicados

El desarrollo sigue estándares como ISO/IEC 42001 para sistemas de gestión de IA, asegurando gobernanza y trazabilidad. En el plano de DevOps, se adhiere a los principios CALMS (Culture, Automation, Lean, Measurement, Sharing) para fomentar una colaboración IA-humana efectiva.

Para el testing, se emplea un enfoque de TDD (Test-Driven Development) extendido a componentes de IA, utilizando frameworks como Great Expectations para validación de datos y Pytest para unit tests en pipelines de ML. Las pruebas de integración incluyen simulaciones con Chaos Engineering tools como Litmus, inyectando fallos para validar la resiliencia del asistente.

- Automatización de pruebas: CI/CD con GitLab para ejecutar suites de ML testing, cubriendo métricas como precisión, recall y F1-score en datasets sintéticos de DevOps.

- Monitoreo continuo: Implementación de observabilidad con OpenTelemetry, capturando traces de requests a través del stack de IA.

- Ética en IA: Evaluaciones de fairness utilizando bibliotecas como AIF360, minimizando sesgos en recomendaciones basadas en datos de equipos globales.

Casos de Uso Específicos en DevOps

En el monitoreo de aplicaciones, el asistente analiza logs en tiempo real para detectar anomalías, como picos de latencia en APIs REST. Utilizando PLN, clasifica errores HTTP (e.g., 5xx) y sugiere remediaciones, como escalado horizontal de pods en Kubernetes mediante comandos kubectl generados dinámicamente.

Para la gestión de configuraciones, integra con herramientas IaC como Pulumi, revisando código para compliance con estándares CIS Benchmarks. En un ejemplo, detecta configuraciones vulnerables en Terraform scripts, proponiendo parches que evitan exposiciones como puertos abiertos innecesarios.

En seguridad DevSecOps, el asistente escanea imágenes de contenedores con Trivy, correlacionando vulnerabilidades CVE con impactos potenciales mediante grafos de conocimiento construidos con Neo4j. Esto permite priorización de fixes basada en severidad CVSS y exposición de red.

Otro caso es la optimización de costos en cloud. Analizando métricas de AWS Cost Explorer, predice sobreprovisionamiento de instancias EC2 y recomienda rightsizing, integrándose con Lambda functions para ejecuciones automatizadas, alineado con principios de FinOps.

Futuras Direcciones y Evolución

El roadmap de NanoSoft incluye la incorporación de multimodalidad, permitiendo al asistente procesar no solo texto sino también diagramas de arquitectura generados por herramientas como Draw.io o métricas visuales de dashboards Grafana. Esto requerirá avances en visión por computadora con modelos como CLIP, integrados en el stack existente.

Se planea la federación de modelos, donde múltiples LLMs especializados (e.g., uno para networking, otro para databases) colaboran vía ensemble methods, mejorando la precisión en dominios nicho como edge computing con 5G.

En términos de sostenibilidad, se exploran técnicas de green AI, como pruning de modelos para reducir consumo energético, alineado con directrices de la IEEE para computación eficiente.

Conclusión

El desarrollo del asistente de IA para DevOps en NanoSoft ilustra el potencial transformador de la inteligencia artificial en operaciones de TI, ofreciendo eficiencia, resiliencia y innovación. Al superar desafíos técnicos mediante arquitecturas robustas y estándares rigurosos, este proyecto no solo optimiza procesos actuales sino que pavimenta el camino para prácticas DevOps impulsadas por IA en el futuro. Para más información, visita la Fuente original.