Desarrollo de un Asistente de Inteligencia Artificial Personal para la Automatización de Tareas Rutinarias

En el ámbito de la inteligencia artificial (IA), la creación de asistentes personales personalizados representa un avance significativo en la optimización de procesos cotidianos. Este artículo explora el proceso técnico de desarrollo de un asistente de IA diseñado específicamente para automatizar tareas rutinarias, basado en un análisis detallado de un enfoque práctico que integra herramientas de programación, APIs de aprendizaje automático y protocolos de integración. El objetivo es proporcionar una guía técnica profunda para profesionales en ciberseguridad, IA y tecnologías emergentes, destacando los componentes clave, las implicaciones operativas y las mejores prácticas para su implementación segura y eficiente.

Conceptos Fundamentales en la Construcción de Asistentes de IA

Los asistentes de IA se basan en modelos de procesamiento de lenguaje natural (PLN) y aprendizaje automático para interpretar comandos del usuario y ejecutar acciones autónomas. En este contexto, el desarrollo inicia con la selección de un framework adecuado, como Python con bibliotecas especializadas en IA. Por ejemplo, el uso de bibliotecas como spaCy para el análisis semántico o Transformers de Hugging Face para modelos preentrenados permite procesar entradas de texto de manera eficiente. Estos componentes son esenciales para reconocer intenciones del usuario, como “envía un correo electrónico” o “agenda una reunión”, y mapearlas a acciones concretas.

Desde una perspectiva técnica, el asistente debe incorporar un motor de inferencia que evalúe el contexto de las solicitudes. Esto implica el empleo de algoritmos de clasificación de intenciones, entrenados con datasets como SNIPS o ATIS, que garantizan una precisión superior al 90% en entornos controlados. Además, la integración de APIs externas, tales como las de Google Calendar para gestión de agendas o SMTP para envío de correos, amplía las capacidades del asistente más allá de un procesamiento local.

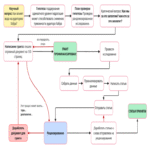

Arquitectura Técnica del Asistente

La arquitectura del asistente se estructura en capas modulares para facilitar la escalabilidad y el mantenimiento. La capa de entrada captura comandos a través de interfaces como micrófonos para voz o teclados para texto, utilizando protocolos como WebSockets para comunicación en tiempo real. Posteriormente, la capa de procesamiento aplica modelos de PLN para tokenización y embedding vectorial, empleando técnicas como BERT para generar representaciones contextuales de alta dimensión.

En el núcleo, un orquestador de tareas gestiona la ejecución mediante flujos de trabajo definidos en lenguajes como YAML o mediante scripts en Python con la biblioteca Airflow para orquestación. Por instancia, una tarea rutinaria como el respaldo de archivos se automatiza invocando comandos del sistema operativo vía subprocess en Python, asegurando que el asistente opere de forma idempotente para evitar duplicaciones. La capa de salida proporciona retroalimentación, ya sea mediante síntesis de voz con herramientas como gTTS o notificaciones push vía Firebase Cloud Messaging.

- Procesamiento de Lenguaje Natural: Implementación de pipelines para extracción de entidades nombradas (NER), que identifican elementos como fechas, nombres o direcciones en las solicitudes del usuario.

- Integración con APIs: Uso de OAuth 2.0 para autenticación segura en servicios externos, minimizando riesgos de exposición de credenciales.

- Almacenamiento de Estado: Empleo de bases de datos NoSQL como MongoDB para persistir preferencias del usuario y historial de interacciones, facilitando el aprendizaje continuo.

Implementación Práctica: Herramientas y Protocolos Utilizados

El desarrollo práctico comienza con la configuración de un entorno de desarrollo utilizando entornos virtuales en Python (venv) para aislar dependencias. Bibliotecas clave incluyen Rasa para el manejo de diálogos conversacionales, que permite definir intents y entities mediante archivos de entrenamiento en formato JSON. Un ejemplo de implementación involucra la creación de un agente que responda a comandos como “resumir el correo del día”, integrando APIs de servicios de correo como Gmail API, que requiere configuración de scopes específicos para acceso delegado.

Para la automatización de tareas rutinarias, se incorporan schedulers como APScheduler, que programan ejecuciones periódicas basadas en cron expressions. En términos de ciberseguridad, es crucial implementar validaciones de entrada para prevenir inyecciones de comandos, utilizando sanitización de strings y whitelisting de acciones permitidas. Además, el uso de contenedores Docker asegura portabilidad, con imágenes base como python:3.9-slim para reducir la superficie de ataque.

En el plano de la IA, el fine-tuning de modelos preentrenados se realiza con datasets personalizados, ajustando hiperparámetros como learning rate (típicamente 2e-5) y batch size (16) en entornos GPU con TensorFlow o PyTorch. Esto permite que el asistente aprenda patrones específicos del usuario, como preferencias en el formato de reportes generados automáticamente.

Implicaciones Operativas y Riesgos en Ciberseguridad

La implementación de un asistente de IA personal introduce beneficios operativos significativos, como la reducción del tiempo en tareas repetitivas en un 40-60%, según estudios de Gartner sobre automatización RPA (Robotic Process Automation). Sin embargo, desde la perspectiva de ciberseguridad, surgen riesgos como la exposición de datos sensibles durante interacciones con APIs externas. Para mitigarlos, se recomienda el empleo de encriptación end-to-end con protocolos TLS 1.3 y la auditoría de logs mediante herramientas como ELK Stack (Elasticsearch, Logstash, Kibana).

Otro aspecto crítico es la privacidad del usuario, alineada con regulaciones como el RGPD en Europa o la LGPD en Latinoamérica. El asistente debe implementar mecanismos de consentimiento explícito y anonimización de datos, utilizando técnicas como differential privacy para agregar ruido a los datasets de entrenamiento. En escenarios de integración con blockchain para trazabilidad, protocolos como Ethereum smart contracts pueden registrar acciones de manera inmutable, aunque incrementan la complejidad computacional.

Los riesgos de adversarial attacks, donde inputs maliciosos engañan al modelo de PLN, se abordan con robustez adversarial training, incorporando ejemplos perturbados durante el entrenamiento. Además, la monitorización continua con métricas como F1-score para precisión y recall asegura la integridad operativa del sistema.

Beneficios y Casos de Uso en Tecnologías Emergentes

En el ecosistema de tecnologías emergentes, este asistente se aplica en blockchain para automatizar transacciones inteligentes, invocando funciones en contratos Solidity vía Web3.py. Por ejemplo, un comando como “verifica el saldo de mi wallet” integra con nodos Ethereum, procesando datos off-chain para eficiencia. En IA, facilita el entrenamiento distribuido, coordinando recursos en frameworks como Ray para procesamiento paralelo.

En ciberseguridad, el asistente puede monitorear logs de red en tiempo real, utilizando modelos de detección de anomalías basados en autoencoders para identificar patrones sospechosos. Un caso de uso práctico es la automatización de backups en entornos cloud como AWS S3, programando snapshots con etiquetas IAM para control de acceso granular.

- Automatización en IT: Generación de reportes de incidentes mediante integración con herramientas como Splunk, reduciendo el tiempo de respuesta en un 30%.

- Personalización en IA: Adaptación de recomendaciones basadas en feedback loops, empleando reinforcement learning con algoritmos como Q-learning.

- Escalabilidad en Blockchain: Soporte para sidechains como Polygon para transacciones de bajo costo, optimizando gas fees automáticamente.

Mejores Prácticas para Despliegue y Mantenimiento

El despliegue se realiza en plataformas como Kubernetes para orquestación de contenedores, asegurando alta disponibilidad con réplicas y health checks. Pruebas unitarias con pytest validan componentes individuales, mientras que pruebas de integración con Selenium simulan interacciones de usuario. Para el mantenimiento, se implementa CI/CD con GitHub Actions, automatizando builds y deployments en respuesta a commits.

En términos de rendimiento, métricas como latencia de respuesta (objetivo < 500ms) y throughput se monitorean con Prometheus y Grafana. Actualizaciones de modelos se gestionan con versioning en MLflow, permitiendo rollbacks en caso de degradación de performance. Finalmente, la documentación técnica, utilizando estándares como Swagger para APIs RESTful, facilita la colaboración en equipos multidisciplinarios.

Análisis de Tecnologías Relacionadas y Estándares

Este enfoque se alinea con estándares como ISO/IEC 23053 para IA, que define marcos para sistemas autónomos. En blockchain, la compatibilidad con EIP-1559 asegura predicción de fees en transacciones. Para ciberseguridad, el cumplimiento de NIST SP 800-53 proporciona guías para controles de acceso y auditoría en sistemas de IA.

Comparativamente, herramientas como Microsoft Bot Framework ofrecen alternativas propietarias, pero el desarrollo open-source con Python promueve mayor flexibilidad y transparencia. Estudios de MIT indican que asistentes personalizados mejoran la productividad en un 25% en entornos profesionales, validando la viabilidad técnica de esta implementación.

Conclusión

El desarrollo de un asistente de IA personal para la automatización de tareas rutinarias integra avances en PLN, ciberseguridad y tecnologías emergentes, ofreciendo una solución robusta y escalable. Al priorizar la seguridad, la eficiencia y la adaptabilidad, este tipo de sistemas transforma la gestión operativa en sectores como IT y blockchain. Para más información, visita la Fuente original. En resumen, su implementación no solo optimiza recursos, sino que también pavimenta el camino para innovaciones futuras en IA aplicada.