Desarrollo de un Chatbot Inteligente Basado en GPT-4o para Plataformas de Mensajería como Telegram: Un Enfoque Técnico Integral

Introducción al Desarrollo de Chatbots con Modelos de IA Avanzados

En el panorama actual de la inteligencia artificial, los modelos de lenguaje grandes como GPT-4o representan un avance significativo en la capacidad de procesamiento del lenguaje natural. Estos modelos, desarrollados por OpenAI, integran funcionalidades multimodales que permiten no solo el manejo de texto, sino también la interpretación de imágenes y audio, lo que amplía su aplicabilidad en entornos interactivos como los chatbots. El desarrollo de un chatbot basado en GPT-4o para plataformas de mensajería instantánea, como Telegram, implica una integración técnica que combina APIs de IA con protocolos de comunicación en tiempo real, asegurando respuestas fluidas y contextuales.

Este artículo analiza de manera detallada el proceso técnico de implementación de tal sistema, extrayendo conceptos clave de prácticas establecidas en el desarrollo de aplicaciones de IA. Se enfoca en aspectos como la arquitectura del sistema, la gestión de tokens y límites de API, la seguridad de datos y las implicaciones en ciberseguridad. La integración con Telegram se realiza a través de su Bot API, que proporciona un framework robusto para bots programables, permitiendo el manejo de mensajes entrantes y salientes mediante webhooks o polling largo.

Desde una perspectiva técnica, GPT-4o opera bajo un paradigma de transformer mejorado, con optimizaciones en eficiencia computacional que reducen la latencia en respuestas. Su capacidad para manejar contextos de hasta 128k tokens lo hace ideal para conversaciones prolongadas, aunque requiere una gestión cuidadosa para evitar costos excesivos en entornos de producción. En este análisis, se exploran las mejores prácticas para desplegar un chatbot que no solo responda consultas, sino que también mantenga la privacidad y cumpla con regulaciones como el RGPD en Europa o normativas locales en Latinoamérica.

Conceptos Clave en la Arquitectura de un Chatbot con GPT-4o

La arquitectura de un chatbot basado en GPT-4o se estructura en capas interconectadas: la capa de interfaz de usuario (Telegram Bot API), la capa de procesamiento de IA (API de OpenAI) y la capa de persistencia de datos (bases de datos para historial de conversaciones). En primer lugar, la integración con Telegram requiere la creación de un bot mediante BotFather, un servicio oficial que genera un token de autenticación. Este token se utiliza para autenticar solicitudes HTTP POST al endpoint de Telegram, típicamente configurado como https://api.telegram.org/bot{token}/sendMessage.

En el núcleo del sistema, GPT-4o procesa las entradas del usuario mediante prompts ingenierizados. Un prompt efectivo incluye instrucciones claras, como “Actúa como un asistente técnico en ciberseguridad, respondiendo en español latinoamericano con precisión técnica”. La API de OpenAI, accesible vía endpoints como https://api.openai.com/v1/chat/completions, requiere autenticación con claves API y soporta parámetros como model: "gpt-4o", messages (un array de roles: system, user, assistant) y max_tokens para controlar la longitud de la respuesta.

Para manejar el contexto conversacional, se implementa un sistema de memoria que almacena mensajes previos en una base de datos como PostgreSQL o Redis, respetando límites de contexto. Esto evita la pérdida de información en interacciones multi-turno y optimiza el uso de recursos. Además, se incorporan filtros de moderación utilizando la API de moderación de OpenAI para detectar contenido inapropiado, alineándose con estándares éticos en IA.

- Gestión de Tokens: GPT-4o cobra por tokens procesados (aproximadamente 5 dólares por millón de tokens de entrada y 15 por salida). Un chatbot eficiente debe tokenizar entradas con bibliotecas como tiktoken para predecir costos y truncar mensajes largos.

- Multimodalidad: Aunque el ejemplo se centra en texto, GPT-4o soporta visión; por ejemplo, procesar imágenes subidas en Telegram mediante

gpt-4o-vision, extrayendo descripciones técnicas de diagramas de red o vulnerabilidades. - Escalabilidad: Para entornos de alto tráfico, se recomienda un backend en Node.js o Python con Flask/FastAPI, desplegado en contenedores Docker y orquestado con Kubernetes para autoescalado.

Implementación Técnica Paso a Paso

El proceso de implementación comienza con la configuración del entorno de desarrollo. En Python, se instalan dependencias como python-telegram-bot para Telegram y openai para la API de IA. Un script básico inicializa el bot con polling para recibir actualizaciones:

Se define una función handler para mensajes de texto, donde se extrae el contenido del usuario, se construye el prompt con historial, y se envía a GPT-4o. La respuesta se procesa y envía de vuelta vía Telegram. Para robustez, se implementan manejadores de errores como timeouts (usando asyncio) y reintentos con backoff exponencial, previniendo fallos por límites de tasa de la API (hasta 10k tokens por minuto en tiers gratuitos).

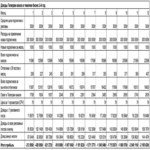

En términos de persistencia, una tabla en SQLAlchemy podría estructurarse así:

| Campo | Tipo | Descripción |

|---|---|---|

| chat_id | INTEGER | Identificador único del chat en Telegram |

| message_history | JSON | Array de mensajes previos para contexto |

| timestamp | DATETIME | Fecha de la última interacción |

Esta estructura permite consultas eficientes y purgas automáticas de historiales antiguos para cumplir con principios de minimización de datos en ciberseguridad.

Para funcionalidades avanzadas, se integra chaining de prompts: por ejemplo, un primer paso valida la consulta del usuario contra reglas de negocio (e.g., no asistir en actividades ilegales, alineado con políticas de OpenAI), y un segundo paso genera la respuesta. En ciberseguridad, esto incluye detección de intentos de inyección de prompts maliciosos, como jailbreaks, mediante validación de patrones regex o modelos de clasificación adicionales.

El despliegue en producción involucra variables de entorno para claves API (usando dotenv), monitoreo con herramientas como Prometheus para métricas de latencia y uso de tokens, y logging con ELK Stack para auditoría. En Latinoamérica, donde la conectividad puede variar, se recomienda caching de respuestas comunes con Redis para reducir llamadas a la API y mejorar la resiliencia.

Implicaciones en Ciberseguridad y Privacidad

La integración de GPT-4o en un chatbot introduce vectores de riesgo significativos en ciberseguridad. Primero, la exposición de claves API: estas deben rotarse periódicamente y almacenarse en vaults como AWS Secrets Manager o HashiCorp Vault, nunca en código fuente. Ataques de inyección en prompts pueden llevar a fugas de datos si el modelo alucina información sensible; por ello, se aplican guards como fine-tuning ligero o RAG (Retrieval-Augmented Generation) para anclar respuestas en bases de conocimiento verificadas.

En cuanto a privacidad, el procesamiento de datos en servidores de OpenAI implica transferencia transfronteriza, requiriendo consentimiento explícito bajo leyes como la LGPD en Brasil o la Ley Federal de Protección de Datos en México. Se recomienda anonimizar chat_ids y encriptar historiales con AES-256. Además, Telegram ofrece encriptación end-to-end en chats secretos, pero para bots, se depende de HTTPS y certificados TLS 1.3.

Riesgos operativos incluyen denegación de servicio por abuso de API; mitígalos con rate limiting en el bot (e.g., 30 mensajes por minuto por usuario) y CAPTCHA para verificar humanidad. En términos de beneficios, un chatbot seguro acelera respuestas en soporte técnico, reduce carga en equipos humanos y proporciona análisis de tendencias mediante agregación anónima de consultas.

- Ataques Comunes: Prompt injection, donde usuarios intentan sobrescribir instrucciones del sistema; contramedidas incluyen sanitización de inputs y uso de

system_messagereforzada. - Regulaciones: Cumplimiento con NIST SP 800-53 para controles de IA, incluyendo auditorías de bias en respuestas.

- Beneficios en IA Ética: GPT-4o incorpora safeguards integrados, pero personalización permite alineación con valores locales, como énfasis en diversidad cultural en respuestas.

Análisis de Rendimiento y Optimizaciones

El rendimiento de GPT-4o se mide en métricas como latencia (típicamente 200-500ms por respuesta), precisión semántica (evaluada con benchmarks como GLUE) y eficiencia energética. En un chatbot para Telegram, pruebas con herramientas como Locust simulan cargas de 100 usuarios concurrentes, revelando bottlenecks en la serialización de JSON para historiales largos.

Optimizaciones incluyen batching de requests para múltiples usuarios, aunque limitado por la API, y uso de modelos más livianos como GPT-3.5-turbo para consultas simples, reservando GPT-4o para complejas. En blockchain, para trazabilidad, se podría integrar firmas digitales en logs de conversaciones usando Ethereum o Hyperledger, asegurando inmutabilidad sin comprometer privacidad.

En noticias de IT recientes, avances como el lanzamiento de GPT-4o en mayo de 2024 destacan su superioridad en tareas multimodales, con un 87% de precisión en benchmarks de visión, superando a competidores como Claude 3. Esto posiciona a los chatbots basados en este modelo como herramientas clave en ciberseguridad, por ejemplo, para simular ataques de phishing o analizar logs de intrusiones en tiempo real.

Desafíos Regulatorios y Futuros Desarrollos

Desde una perspectiva regulatoria, el uso de IA en chatbots enfrenta escrutinio bajo marcos como la EU AI Act, que clasifica sistemas conversacionales como de alto riesgo si procesan datos sensibles. En Latinoamérica, iniciativas como el Marco Latinoamericano de IA promueven transparencia, requiriendo disclosure de uso de modelos propietarios. Implicaciones operativas incluyen auditorías anuales y planes de contingencia para outages de API, como fallbacks a modelos open-source como Llama 3.

Beneficios técnicos abarcan personalización: fine-tuning de GPT-4o con datasets locales permite adaptación a jerga regional, mejorando engagement. Riesgos incluyen dependencia de proveedores externos; diversificar con APIs híbridas mitiga esto. En ciberseguridad, integrar threat intelligence feeds permite al bot alertar sobre vulnerabilidades en tiempo real, usando protocolos como STIX para intercambio de datos.

Futuros desarrollos apuntan a integración con edge computing, ejecutando inferencia en dispositivos móviles vía TensorFlow Lite, reduciendo latencia y mejorando privacidad al evitar envíos a la nube. En blockchain, NFTs o tokens podrían incentivar interacciones, creando economías de datos seguras.

Conclusión: Hacia una Integración Sostenible de IA en Aplicaciones de Mensajería

El desarrollo de un chatbot basado en GPT-4o para Telegram ilustra el potencial transformador de la IA en interacciones digitales, combinando precisión técnica con accesibilidad. Al abordar desafíos en arquitectura, ciberseguridad y regulaciones, las organizaciones pueden desplegar sistemas robustos que potencien eficiencia sin comprometer seguridad. En resumen, este enfoque no solo optimiza operaciones en IT, sino que pavimenta el camino para innovaciones en IA responsable, adaptadas a contextos latinoamericanos. Para más información, visita la Fuente original.