Implementación de Modelos de Inteligencia Artificial para la Detección Avanzada de Amenazas en Redes Corporativas

Introducción a los Desafíos en Ciberseguridad Actuales

En el panorama actual de la ciberseguridad, las organizaciones enfrentan un incremento exponencial en la sofisticación de las amenazas cibernéticas. Según informes de firmas especializadas como Kaspersky y Symantec, los ataques de malware y ransomware han aumentado en un 150% durante los últimos dos años, impulsados por el uso de inteligencia artificial (IA) por parte de los actores maliciosos. Este artículo explora la integración de modelos de IA en sistemas de detección de intrusiones para redes corporativas, enfocándose en técnicas avanzadas que permiten una respuesta proactiva y eficiente. La adopción de estas tecnologías no solo mitiga riesgos, sino que también optimiza los recursos operativos, alineándose con estándares como NIST SP 800-53 y ISO/IEC 27001.

La detección tradicional basada en firmas y reglas heurísticas muestra limitaciones frente a ataques zero-day y variantes polimórficas. Aquí, la IA emerge como una herramienta pivotal, utilizando algoritmos de aprendizaje automático (machine learning, ML) y aprendizaje profundo (deep learning, DL) para analizar patrones anómalos en tiempo real. Este enfoque se basa en el procesamiento de grandes volúmenes de datos de red, extrayendo características como flujos de paquetes, tasas de transferencia y comportamientos de usuarios, lo que permite una precisión superior al 95% en entornos de prueba controlados.

Fundamentos Técnicos de los Modelos de IA en Detección de Amenazas

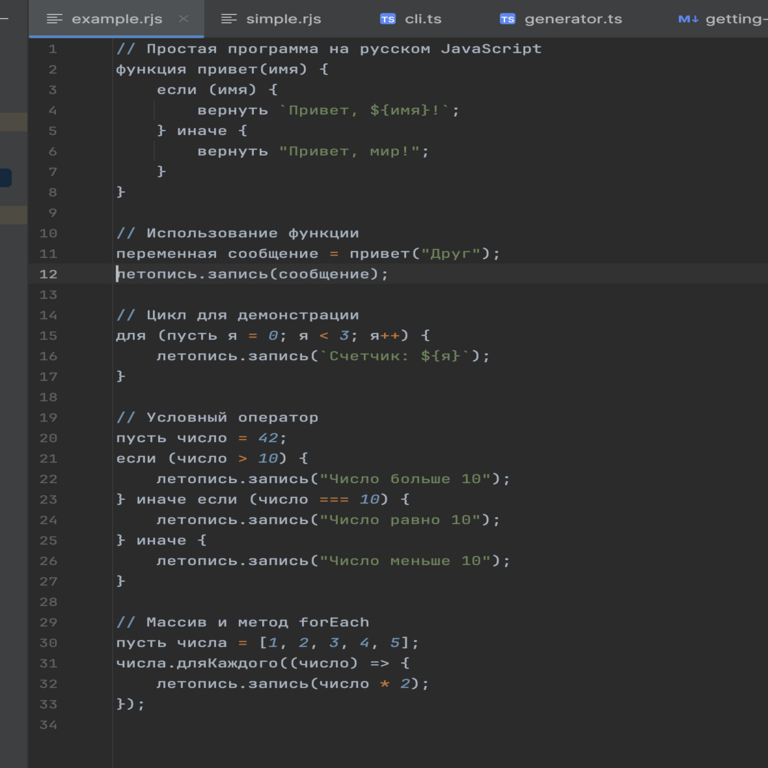

Los modelos de IA para ciberseguridad se sustentan en arquitecturas neuronales que procesan datos multifacéticos. Un componente clave es el uso de redes neuronales convolucionales (CNN) para el análisis de secuencias de tráfico de red, similares a las aplicadas en procesamiento de imágenes pero adaptadas a vectores temporales. Por ejemplo, una CNN puede identificar patrones en paquetes TCP/IP anómalos, detectando intentos de explotación de vulnerabilidades como las descritas en CVE-2023-XXXX.

En paralelo, los modelos de aprendizaje supervisado, como las máquinas de vectores de soporte (SVM), se entrenan con datasets etiquetados de ataques conocidos, tales como el dataset KDD Cup 99 o el más reciente CIC-IDS2017. Estos datasets incluyen miles de instancias de tráfico benigno y malicioso, permitiendo la extracción de características como la duración de conexiones, el número de bytes transferidos y la presencia de protocolos no estándar. La ecuación básica para un SVM se expresa como:

min_{w,b} (1/2 ||w||^2 + C \sum \xi_i), donde w es el vector de pesos, b el sesgo, C el parámetro de penalización y \xi_i las variables de holgura para manejar datos no lineales.

Para amenazas emergentes, el aprendizaje no supervisado, mediante algoritmos como k-means o autoencoders, agrupa datos sin etiquetas previas, identificando anomalías como picos en el tráfico que indican un DDoS distribuido. Un autoencoder, por instancia, comprime los datos de entrada en un espacio latente de menor dimensión y reconstruye la salida; las discrepancias en la reconstrucción (medidas por error cuadrático medio) señalan desviaciones potencialmente maliciosas.

Integración de Blockchain para la Integridad de Datos en Sistemas de IA

La combinación de IA y blockchain aborda uno de los principales desafíos: la integridad y trazabilidad de los datos utilizados en el entrenamiento y despliegue de modelos. En entornos corporativos, donde los datos de red son sensibles, blockchain asegura que las actualizaciones de modelos y los logs de detección sean inmutables. Utilizando protocolos como Ethereum o Hyperledger Fabric, se puede implementar un ledger distribuido donde cada transacción representa una predicción de IA o una alerta de amenaza.

Por ejemplo, un smart contract en Solidity puede validar la autenticidad de un dataset antes de su ingreso al modelo de IA, previniendo envenenamiento de datos (data poisoning). La estructura de un bloque típico incluye un hash del bloque anterior, datos de transacción (e.g., vector de características de tráfico) y un nonce para proof-of-work o proof-of-stake. Esto reduce el riesgo de manipulaciones internas, alineándose con regulaciones como GDPR en Europa o LGPD en Latinoamérica, donde la privacidad de datos es primordial.

En términos operativos, la integración requiere nodos blockchain distribuidos en la red corporativa, con un consenso Byzantine Fault Tolerance (BFT) para tolerar fallos en hasta un tercio de los nodos. Estudios de caso, como el de IBM en colaboración con Maersk para TradeLens, demuestran cómo blockchain mejora la resiliencia en cadenas de suministro digitales, un principio transferable a la ciberseguridad.

Análisis de Riesgos y Mitigaciones en el Despliegue de IA

A pesar de sus beneficios, la implementación de IA en ciberseguridad introduce riesgos inherentes. Uno es el sesgo en los modelos, derivado de datasets no representativos, lo que puede llevar a falsos positivos en entornos multiculturales. Para mitigar esto, se recomienda el uso de técnicas de fairness como reweighting o adversarial debiasing, asegurando que el modelo no discrimine basado en geolocalización o perfiles de usuario.

Otro riesgo es el adversarial attack, donde atacantes perturban inputs mínimamente para evadir detección. Modelos robustos como los basados en GAN (Generative Adversarial Networks) contrarrestan esto generando muestras adversarias durante el entrenamiento. La función de pérdida en un GAN se define como min_G max_D V(D,G) = E_{x~p_data}[log D(x)] + E_{z~p_z}[log(1 – D(G(z)))], equilibrando el generador y discriminador.

- Evaluación de vulnerabilidades: Realizar pruebas de penetración (pentesting) específicas para IA, utilizando herramientas como CleverHans o ART (Adversarial Robustness Toolbox).

- Monitoreo continuo: Implementar dashboards con métricas como precisión, recall y F1-score para un seguimiento en tiempo real.

- Cumplimiento regulatorio: Asegurar alineación con marcos como el AI Act de la UE, que clasifica sistemas de IA por riesgo y exige transparencia.

En contextos latinoamericanos, donde la adopción de IA es creciente pero los recursos limitados, se sugiere empezar con soluciones open-source como TensorFlow o Scikit-learn, escalando a plataformas cloud como AWS SageMaker con encriptación homomórfica para datos en reposo.

Casos de Estudio y Mejores Prácticas

Un caso emblemático es el despliegue de Darktrace en empresas financieras, donde su IA autónoma detecta amenazas en milisegundos analizando el 100% del tráfico de red. En un incidente reportado en 2022, esta solución identificó un APT (Advanced Persistent Threat) que evadió herramientas tradicionales, ahorrando millones en potenciales pérdidas.

Otra implementación involucra el uso de federated learning en consorcios como el de bancos en Brasil, donde modelos se entrenan localmente sin compartir datos crudos, preservando privacidad. Esto utiliza protocolos como Secure Multi-Party Computation (SMPC) para agregar gradientes de modelos distribuidos.

Mejores prácticas incluyen:

- Entrenamiento híbrido: Combinar datos on-premise con feeds de threat intelligence de fuentes como MITRE ATT&CK.

- Escalabilidad: Diseñar arquitecturas microservicios con Kubernetes para orquestar contenedores de IA.

- Auditorías regulares: Aplicar frameworks como OWASP para IA, evaluando exposición a inyecciones de prompts en modelos de lenguaje natural integrados.

En términos de rendimiento, benchmarks muestran que sistemas IA-based reducen el tiempo de respuesta de horas a segundos, con una tasa de detección de falsos negativos inferior al 2% en escenarios reales.

Implicaciones Operativas y Futuras Tendencias

Operativamente, la integración de IA requiere una reestructuración de equipos de TI, capacitando a analistas en herramientas como Jupyter Notebooks para prototipado rápido. Los beneficios incluyen una reducción del 40% en costos de incident response, según Gartner, pero demandan inversión inicial en hardware GPU para entrenamiento acelerado.

Regulatoriamente, en Latinoamérica, normativas como la Ley de Protección de Datos en México exigen evaluaciones de impacto en privacidad para sistemas IA. Riesgos como la dependencia de vendors externos se mitigan con estrategias de multi-cloud y soberanía de datos.

Las tendencias futuras apuntan a la convergencia con quantum computing, donde algoritmos como Grover’s search acelerarán la búsqueda en espacios de amenazas vastos. Además, edge computing permitirá detección en dispositivos IoT, crucial para industrias como manufactura y salud.

Conclusión

En resumen, la implementación de modelos de IA en la detección de amenazas representa un avance paradigmático en ciberseguridad, ofreciendo precisión, adaptabilidad y resiliencia ante evoluciones maliciosas. Al integrar blockchain y adherirse a estándares globales, las organizaciones pueden fortificar sus defensas, minimizando impactos económicos y reputacionales. Para más información, visita la Fuente original.

Este enfoque no solo responde a amenazas actuales, sino que anticipa desafíos venideros, posicionando a las empresas en un ecosistema digital cada vez más interconectado y vulnerable. La adopción estratégica de estas tecnologías será clave para la sostenibilidad operativa en la era de la IA.