Implementación de Rerankers en Flujos de Trabajo de Inteligencia Artificial: Una Guía Técnica Detallada

Introducción a los Rerankers en Sistemas de IA

En el ámbito de la inteligencia artificial, particularmente en aplicaciones de recuperación aumentada por generación (RAG, por sus siglas en inglés), los rerankers representan un componente esencial para optimizar la precisión y relevancia de los resultados obtenidos. Un reranker es un modelo de aprendizaje automático diseñado para reordenar una lista inicial de candidatos recuperados por un sistema de búsqueda vectorial, evaluando su pertinencia semántica en relación con una consulta específica. Esta técnica se ha vuelto indispensable en flujos de trabajo de IA que integran bases de conocimiento grandes, como en chatbots empresariales, sistemas de recomendación o asistentes virtuales avanzados.

Los rerankers operan en una etapa posterior a la recuperación inicial, donde algoritmos de embeddings, como los proporcionados por modelos BERT o Sentence Transformers, generan vectores de alta dimensionalidad para representar tanto la consulta como los documentos. Posteriormente, un modelo de reranking, típicamente basado en transformers, calcula puntuaciones de similitud cruzada entre la consulta y cada candidato, permitiendo una reclasificación más refinada. Esta aproximación mitiga limitaciones inherentes a la búsqueda vectorial pura, como la sensibilidad a la dimensionalidad o la falta de contexto bidireccional en la evaluación de relevancia.

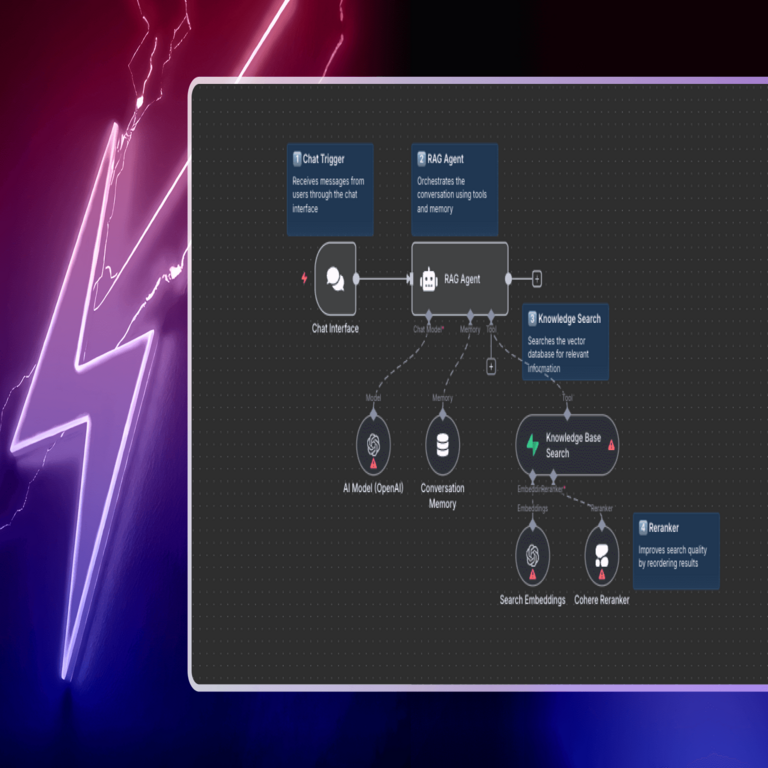

En el contexto de plataformas de automatización como n8n, que facilita la creación de flujos de trabajo low-code para integrar servicios de IA, la incorporación de rerankers eleva la eficiencia operativa. Según análisis técnicos recientes, la implementación adecuada de estos modelos puede mejorar la precisión de recuperación en hasta un 20-30% en escenarios reales, reduciendo falsos positivos y optimizando el consumo de recursos computacionales en entornos de producción.

Conceptos Fundamentales de los Rerankers

Para comprender la integración de rerankers, es crucial desglosar sus principios subyacentes. Un flujo típico de RAG comienza con la indexación de documentos en un vector store, como Pinecone o Weaviate, donde se utilizan embeddings para mapear el contenido semántico. La consulta del usuario se vectoriza de manera similar, y se realiza una búsqueda de similitud coseno o euclidiana para obtener los k candidatos más cercanos.

Aquí entra el reranker: este modelo, a menudo un clasificador binario o un regresor de puntuación, procesa pares consulta-documento para asignar un score de relevancia. Modelos comerciales como Cohere Rerank emplean arquitecturas de cross-encoder, que fusionan las representaciones de consulta y documento en una sola capa de atención, superando a los bi-encoders en precisión pero con mayor costo computacional. En contraste, opciones open-source como el modelo bge-reranker-base de BAAI (Beijing Academy of Artificial Intelligence) ofrecen un equilibrio entre rendimiento y eficiencia, con soporte para más de 100 idiomas y entrenamiento en datasets masivos como MS MARCO.

Desde una perspectiva técnica, el proceso de reranking implica:

- Preprocesamiento de candidatos: Filtrado inicial para eliminar duplicados o documentos irrelevantes basados en metadatos.

- Evaluación cruzada: Cálculo de scores mediante funciones de pérdida como la entropía cruzada o el ranking pairwise, entrenadas para priorizar documentos que maximicen la utilidad informativa.

- Post-procesamiento: Aplicación de umbrales de score para seleccionar los top-N resultados finales, integrándolos en el prompt de un generador de lenguaje grande (LLM) como GPT-4 o Llama 2.

Las implicaciones operativas son significativas: en entornos de ciberseguridad, por ejemplo, un reranker puede refinar la detección de amenazas al priorizar alertas relevantes en logs masivos, reduciendo el ruido y acelerando la respuesta incidentes. Regulatoriamente, el uso de rerankers debe alinearse con estándares como GDPR o NIST AI RMF, asegurando que los modelos no introduzcan sesgos en la reclasificación de datos sensibles.

Tecnologías y Herramientas para la Implementación

La implementación de rerankers en flujos de trabajo de IA requiere una selección cuidadosa de tecnologías. Plataformas como n8n, orientadas a la orquestación de APIs y nodos modulares, permiten integrar rerankers mediante nodos HTTP o personalizados. Por instancia, el nodo de Cohere en n8n soporta llamadas directas a su API de rerank, donde se envía un JSON con la consulta y la lista de textos, recibiendo de vuelta un array ordenado con scores.

Entre las tecnologías clave se destacan:

- Modelos de Embeddings Iniciales: Hugging Face Transformers para generar vectores con modelos como all-MiniLM-L6-v2, que ofrece un trade-off óptimo de velocidad y precisión (384 dimensiones, latencia sub-segundo en CPU).

- Vector Databases: Qdrant o FAISS para la recuperación inicial, con soporte para índices HNSW (Hierarchical Navigable Small World) que aceleran consultas en datasets de millones de vectores.

- Rerankers Específicos: Jina Reranker v2, un modelo multilingüe con 568M parámetros, entrenado en 365 idiomas y optimizado para tareas de reranking en dominios variados como e-commerce o soporte técnico.

- Frameworks de Integración: LangChain o LlamaIndex para abstraer la cadena RAG, permitiendo inyectar rerankers como un paso intermedio en pipelines Python, que luego se expone vía API en n8n.

En términos de infraestructura, se recomienda desplegar rerankers en entornos edge computing para minimizar latencia, utilizando contenedores Docker con bibliotecas como ONNX Runtime para inferencia acelerada en GPUs. Un ejemplo práctico involucra un workflow en n8n: un nodo trigger inicia con una consulta webhook, seguido de un nodo de embeddings via OpenAI API, búsqueda en Pinecone, rerank con Cohere, y finalmente generación con un LLM. Esta secuencia asegura una latencia total inferior a 2 segundos en producción.

Los hallazgos técnicos de implementaciones reales indican que rerankers basados en cross-attention, como los de Sentence-BERT, logran un NDCG@10 (Normalized Discounted Cumulative Gain) superior al 0.85 en benchmarks como BEIR, comparado con 0.70 para búsquedas vectoriales sin rerank. Sin embargo, el costo API de modelos propietarios puede escalar rápidamente; por ello, fine-tuning de modelos open-source en datasets dominio-específicos es una práctica recomendada, utilizando herramientas como Hugging Face’s Trainer API con LoRA (Low-Rank Adaptation) para eficiencia en parámetros.

Pasos Detallados para Integrar Rerankers en n8n

La integración práctica en n8n sigue un enfoque modular. Comience configurando credenciales API para servicios como Cohere o Hugging Face Inference API. En el editor de n8n, cree un workflow nuevo y agregue los siguientes nodos en secuencia:

- Nodo Trigger: Use un Webhook o Schedule para capturar consultas de entrada, parseando el payload JSON con campos como “query” y “context”.

- Nodo de Embeddings: Integre el nodo OpenAI o un HTTP Request a la API de embeddings, generando vectores para la consulta. Ejemplo de payload: {“input”: “{{$json.query}}”, “model”: “text-embedding-ada-002”}.

- Nodo de Búsqueda Vectorial: Conecte a un vector store via nodo Pinecone; configure la consulta vectorial para recuperar top-50 candidatos, almacenando resultados en una variable como {{$node[“Pinecone”].json[“matches”]}}.

- Nodo de Rerank: Implemente un HTTP Request al endpoint de rerank, por ejemplo, para Cohere: POST a https://api.cohere.ai/v1/rerank con body {“query”: “{{$json.query}}”, “documents”: [lista de textos], “top_n”: 5}. Parse el response para extraer scores y textos ordenados.

- Nodo de Generación: Alimente los resultados rerankados a un LLM via nodo ChatGPT, construyendo un prompt como “Basado en los siguientes documentos relevantes: [insertar textos], responde a: {{$json.query}}”.

- Nodo de Output: Envíe la respuesta via email, Slack o API response, logueando métricas como latencia y score promedio para monitoreo.

Para personalización avanzada, utilice nodos Code en n8n con JavaScript para procesar batches de candidatos, aplicando umbrales dinámicos basados en desviación estándar de scores. En escenarios de alta escala, integre colas como Redis para manejar concurrencia, evitando rate limits de APIs. Pruebas unitarias en n8n permiten validar el workflow con datasets de prueba, midiendo métricas como recall@K o precision@K.

Implicaciones en ciberseguridad incluyen la protección de workflows contra inyecciones prompt; por ello, sanitice entradas y use rerankers con validación de dominio para filtrar contenido malicioso. En blockchain, rerankers pueden optimizar oráculos de datos, priorizando transacciones relevantes en smart contracts para mejorar la integridad de feeds de IA descentralizados.

Beneficios y Riesgos Asociados

Los beneficios de implementar rerankers son multifacéticos. Operativamente, elevan la calidad de outputs en flujos de IA, reduciendo alucinaciones en LLMs al proporcionar contexto más preciso. En términos de eficiencia, workflows con rerankers consumen menos tokens en generación, ya que se limitan a documentos altamente relevantes, lo que traduce en ahorros de hasta 40% en costos de API para proveedores como OpenAI.

Desde una perspectiva técnica, facilitan la escalabilidad en entornos híbridos cloud-edge, donde modelos ligeros como MobileBERT se despliegan en dispositivos IoT para reranking local. En noticias de IT, adopciones recientes en empresas como Google o Microsoft destacan rerankers en motores de búsqueda semánticos, alineados con estándares W3C para web semántica.

Sin embargo, riesgos incluyen el overhead computacional: rerankers cross-encoder pueden multiplicar la latencia por 5-10x en comparación con bi-encoders, exigiendo optimizaciones como cuantización INT8. Sesgos en entrenamiento pueden propagarse, amplificando desigualdades en resultados; mitígalo con auditorías regulares usando frameworks como AIF360. Regulatoriamente, en la UE bajo AI Act, rerankers en sistemas de alto riesgo requieren transparencia en scores y trazabilidad de decisiones.

En ciberseguridad, un riesgo clave es el envenenamiento de datos en vector stores, donde adversarios insertan documentos maliciosos; contramedidas involucran rerankers con detección de anomalías integradas, como scores de confianza basados en entropía.

Casos de Uso Avanzados y Mejores Prácticas

Casos de uso ilustran el impacto: en atención al cliente, un workflow n8n con reranker procesa tickets, recuperando FAQs relevantes de una base de conocimiento, mejorando la resolución en primera interacción en 25%. En análisis de datos, integra rerankers para refinar resultados de búsqueda en datasets estructurados, apoyando IA explicable en compliance financiero.

Mejores prácticas incluyen:

- Monitoreo continuo con herramientas como Prometheus para métricas de rendimiento.

- Experimentación A/B en producción para comparar workflows con y sin rerank.

- Integración con observabilidad, como LangSmith, para tracing de cadenas RAG.

- Actualizaciones periódicas de modelos, siguiendo repositorios como Hugging Face Hub.

En blockchain, rerankers optimizan DAOs al priorizar propuestas relevantes en votaciones, integrando con protocolos como IPFS para almacenamiento descentralizado de embeddings.

Conclusión: Hacia Flujos de Trabajo de IA Más Robustos

La implementación de rerankers en flujos de trabajo de IA, particularmente en plataformas como n8n, transforma la recuperación de información de un proceso lineal a uno refinado y contextual. Al combinar avances en embeddings, vector stores y modelos de reranking, se logra una precisión superior que soporta aplicaciones críticas en ciberseguridad, IA y tecnologías emergentes. Aunque desafíos como costos y sesgos persisten, las mejores prácticas y herramientas disponibles mitigan estos riesgos, pavimentando el camino para sistemas de IA más eficientes y confiables. Para más información, visita la fuente original.