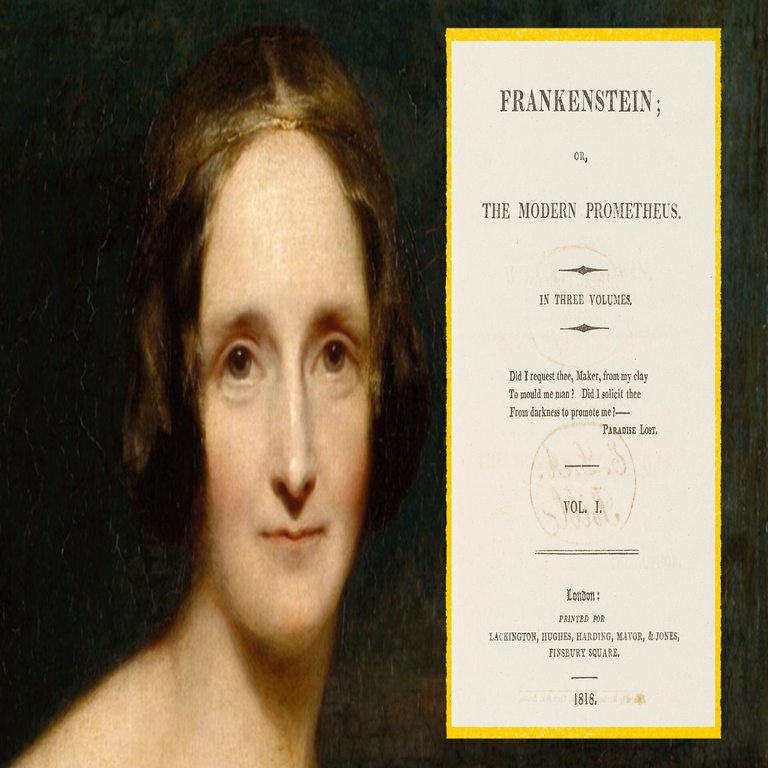

Gobernanza algorítmica y responsabilidad ética en la era de la IA generativa: lecciones técnico-regulatorias desde “Frankenstein” hasta los sistemas modernos

De la criatura artificial de Shelley a la infraestructura crítica de modelos de lenguaje y sistemas autónomos

La expansión de la inteligencia artificial generativa, los modelos fundacionales de propósito general y los sistemas autónomos de toma de decisiones han reactivado un conjunto de dilemas éticos, regulatorios y técnicos que, en forma literaria, fueron anticipados hace dos siglos. Aunque el contexto tecnológico de “Frankenstein o el moderno Prometeo” de Mary Shelley difiere radicalmente de la realidad digital actual, su núcleo conceptual resulta plenamente aplicable a la discusión contemporánea sobre seguridad de la IA, trazabilidad algorítmica, responsabilidad de los desarrolladores, riesgos de descontrol tecnológico y gobernanza de sistemas que pueden operar más allá de la intención inicial de sus creadores.

Este artículo desarrolla, desde una perspectiva estrictamente técnica y profesional, las implicancias de estos dilemas para el diseño, despliegue y supervisión de sistemas de IA actuales, particularmente aquellos utilizados en contextos de infraestructura crítica, ciberseguridad ofensiva y defensiva, gobernanza de datos, toma de decisiones automatizada en sectores sensibles, aplicaciones militares, y entornos regulados donde la integridad, la auditabilidad y la rendición de cuentas son obligatorias. Además, se vinculan estas reflexiones con marcos normativos emergentes (como el AI Act europeo), estándares técnicos (como NIST AI RMF, ISO/IEC 42001, 27001, 23894, 38507, 23053, entre otros) y mejores prácticas de ingeniería segura orientada a minimizar el daño potencial de sistemas avanzados.

La anticipación conceptual: creación sin control, opacidad y responsabilidad

La obra de Shelley plantea, de manera estructural, tres ejes que hoy son centrales en la discusión sobre inteligencia artificial:

- La generación de una entidad artificial con capacidades no triviales que exceden la comprensión y control total de su creador.

- La ausencia de una arquitectura de gobernanza, supervisión y responsabilidad que acompañe el desarrollo, uso y consecuencias del sistema creado.

- La externalización del riesgo hacia el entorno social, dejando a terceros expuestos a decisiones o comportamientos no previstos.

Trasladados al contexto contemporáneo, estos ejes se reflejan en el despliegue acelerado de grandes modelos de lenguaje (LLM), modelos multimodales, sistemas de recomendación de alto impacto, agentes autónomos basados en cadenas de herramientas (tool-augmented agents), y sistemas de toma de decisiones automatizada en dominios críticos como:

- Detección y respuesta ante incidentes de ciberseguridad (SOAR, XDR, UEBA con IA).

- Sistemas de puntuación crediticia y scoring de riesgo financiero.

- Plataformas de moderación de contenidos y análisis de comportamiento en redes sociales.

- Aplicaciones de IA generativa para código (copilots) integradas en pipelines de desarrollo DevSecOps.

- Sistemas de vigilancia, reconocimiento facial y análisis biométrico.

- Uso dual de modelos avanzados en ciberataques automatizados, ingeniería social sofisticada y campañas de desinformación.

Al igual que la criatura de Shelley, muchos de estos sistemas se entrenan sobre grandes volúmenes de datos, adquieren patrones complejos de comportamiento y producen resultados que ya no pueden atribuirse a reglas explícitas. Lo central no es la analogía literaria, sino la constatación técnica: la ausencia de mecanismos robustos de gobernanza algorítmica, documentación, evaluación de riesgos, validación continua, auditoría independiente y canales de responsabilidad jurídica convierte estos sistemas en potenciales fuentes de daño sistémico.

IA generativa, opacidad y el problema de la trazabilidad

El desarrollo de modelos de lenguaje masivos y sistemas generativos introduce un desafío estructural: la combinación de opacidad técnica (cajas negras de alta dimensionalidad) con capacidad de generalización sobre dominios sensibles. Esto presenta varias implicancias:

- Falta de interpretabilidad: El número de parámetros, capas y transformaciones internas dificulta explicar, de manera determinista, por qué un modelo produce una salida específica, lo que limita la transparencia y la capacidad de auditoría.

- Debilidades de alineación: Los mecanismos de alineación (RLHF, RLAIF, técnicas de filtrado, instrucciones de seguridad) pueden ser insuficientes frente a técnicas adversariales como prompt injection, jailbreaking, manipulación contextual o explotación de herramientas conectadas.

- Riesgo de uso dual: La misma infraestructura que permite asistencia avanzada en ciberseguridad defensiva también puede facilitar la automatización de ataques (generación de malware, explotación de vulnerabilidades, campañas de phishing hiperpersonalizado, desinformación dirigida).

- Dependencia crítica: Organizaciones que integran IA generativa en flujos de negocio esenciales sin capacidades propias de verificación, monitoreo y fallback incurren en riesgo operacional significativo.

Desde la perspectiva de ingeniería segura, esto exige la adopción de prácticas orientadas a la trazabilidad y la gobernanza técnica, que incluyen:

- Registro exhaustivo de versiones de modelos, datasets, parámetros de entrenamiento y configuración de inferencia.

- Implementación de mecanismos de observabilidad (logs, métricas, auditoría) específicos para IA, integrados en SIEM y plataformas de monitoreo.

- Evaluaciones sistemáticas de seguridad y robustez frente a ataques adversariales, inyección de prompts, extracción de modelos, fuga de datos de entrenamiento y evasión de políticas.

- Aplicación de marcos como NIST AI Risk Management Framework (AI RMF) para gestionar el ciclo de vida del riesgo.

- Uso de metodologías basadas en ISO/IEC 42001 (Sistemas de gestión de IA), ISO/IEC 23894 (Gestión del riesgo de IA) e integración con ISO/IEC 27001 (Seguridad de la información).

Responsabilidad del desarrollador y del operador: de la autoría técnica a la rendición de cuentas

Uno de los puntos neurálgicos que emergen del análisis técnico-jurídico actual es la definición de responsabilidad cuando un sistema de IA genera daño directo o indirecto. Ya no es aceptable la postura de neutralidad tecnológica donde el proveedor alega que el sistema solo ejecuta cálculos estadísticos. La perspectiva moderna exige delimitar responsabilidades en múltiples capas:

- Desarrolladores de modelos fundacionales: Responsables de documentar el modelo, sus capacidades, limitaciones, riesgos conocidos, dataset utilizados (cuando sea posible), pruebas de seguridad, alignment y benchmarks de robustez.

- Integradores y proveedores de plataformas: Responsables de la configuración segura, de la orquestación de agentes, de las políticas de acceso, autenticación y autorización, de la protección frente a abuso y de la implementación de salvaguardas en las interfaces.

- Organizaciones usuarias: Responsables de los contextos de uso, de la validación de resultados antes de decisiones de impacto, de la formación de usuarios y de incorporar la IA en un marco de cumplimiento normativo sectorial (bancario, sanitario, gubernamental, defensa, etc.).

- Supervisión regulatoria: Responsabilidad de establecer criterios mínimos de seguridad, transparencia, evaluaciones previas de impacto y obligaciones de notificación de incidentes asociados a IA.

En términos técnicos, esto implica que cada fase del ciclo de vida de la IA debe estar respaldada por controles verificables, incluyendo:

- Model cards y system cards con especificaciones técnicas, objetivos, restricciones y contextos no permitidos.

- Data sheets para datasets, describiendo procedencia, sesgos potenciales, procesos de anonimización y licenciamiento.

- Políticas claras de logging, monitoreo de anomalías y mecanismos de respuesta ante incidentes provocados o amplificados por sistemas de IA.

- Integración de la gobernanza de IA con marcos como COBIT, ITIL, ISO/IEC 38507 (gobernanza de TI con IA), y regulaciones específicas como el Reglamento Europeo de IA (AI Act) para sistemas de alto riesgo, incluidos aquellos con impacto en infraestructuras críticas.

Riesgos avanzados: autonomía operativa, weaponización y ciberseguridad

La transición de sistemas estáticos a agentes autónomos con capacidad de actuar sobre entornos reales, ejecutar acciones en sistemas de información, realizar transacciones, modificar configuraciones o interactuar con otros agentes, eleva significativamente el perfil de riesgo. Entre los escenarios que requieren atención prioritaria desde ciberseguridad e ingeniería de control se encuentran:

- Agentes conectados a herramientas críticas: Sistemas de IA con acceso a APIs internas, repositorios de código, sistemas de orquestación en la nube, paneles administrativos, infraestructura OT/ICS o sistemas de gestión de identidades.

- Automatización ofensiva: Uso de IA generativa para desarrollar exploits, analizar grandes superficies de ataque, producir payloads polimórficos, optimizar phishing spear-targeted y coordinar ataques distribuidos.

- Sistemas militares y de seguridad: Integración de IA en drones, sistemas de reconocimiento, plataformas de targeting, defensa antimisiles o vigilancia masiva, donde la degradación, manipulación o comportamiento inesperado puede provocar consecuencias críticas.

- Cascadas de decisiones: Sistemas interconectados donde el output de un modelo sirve como input de otros, generando cadenas de acciones difíciles de auditar, con riesgo de escalamiento no intencional.

Mitigar estos riesgos exige una arquitectura “secure-by-design” y “governed-by-default” aplicable a la IA, que incluya, de forma no exhaustiva:

- Segmentación estricta de privilegios: los agentes de IA deben operar con el mínimo privilegio necesario, bajo modelos de Zero Trust y controles de acceso granulares.

- Limitación de superficie de acción: definición explícita de qué operaciones puede ejecutar la IA, con validación humana para acciones de alto impacto.

- Monitoreo de comportamiento anómalo del agente: detección de patrones inusuales, loops, escalamiento de privilegios, acceso a recursos no autorizados o generación de resultados maliciosos.

- Pruebas de penetración específicas para pipelines de IA, incluyendo ataques de envenenamiento de datos (data poisoning), ataques de inferencia, extracción de modelos (model stealing) y manipulación de contextos de entrada.

- Controles criptográficos, aislamiento de entornos y hardware seguro (TPM, enclaves de confianza) para proteger modelos, pesos y datos sensibles frente a robo o alteración.

Marco regulatorio y estándares aplicables a la IA de alto impacto

Los marcos regulatorios emergentes reflejan la necesidad de evitar una repetición del patrón de creación sin responsabilidad que dramatiza Shelley, pero traducido a infraestructuras digitales. Entre los esquemas más relevantes para organizaciones que diseñan, adopan o integran IA avanzada se destacan:

- AI Act (Unión Europea): Clasificación de sistemas de IA por niveles de riesgo (inaceptable, alto, limitado, mínimo). Establece obligaciones estrictas para sistemas de alto riesgo: gestión de riesgos, documentación técnica, calidad de datos, logging, transparencia, supervisión humana y robustez.

- NIST AI RMF: Marco orientado a la gestión del riesgo de IA que define funciones clave (Gobernar, Mapear, Medir, Gestionar), aplicables a entornos corporativos y de gobierno para estructurar la gestión responsable.

- ISO/IEC 42001: Sistema de gestión para IA, que articula políticas, controles, roles y procedimientos para el ciclo de vida completo de sistemas de IA, alineado con buenas prácticas de gestión de riesgos y auditoría.

- ISO/IEC 23894: Gestión del riesgo de IA, integrando principios de identificación, análisis, evaluación y tratamiento del riesgo asociado a sistemas basados en aprendizaje automático y modelos complejos.

- ISO/IEC 27001 y familia 27000: Seguridad de la información aplicada a entornos donde la IA se nutre de datos sensibles, propiedad intelectual crítica y operaciones reguladas.

- ISO/IEC 38507: Gobernanza corporativa de TI en relación con el uso de IA, enfatizando supervisión a nivel directivo, alineamiento con objetivos de negocio y ética de la tecnología.

La convergencia entre estos estándares y las exigencias regulatorias apunta a un modelo en el cual el despliegue de IA no puede ser entendido solo como una innovación técnica, sino como una infraestructura crítica que requiere:

- Evaluaciones de impacto algorítmico (Algorithmic Impact Assessments) previas al despliegue.

- Canales de reporte y respuesta ante fallos o daños generados por IA, con obligaciones de remediación.

- Supervisión independiente (auditorías técnicas, evaluaciones de conformidad, certificaciones).

- Transparencia mínima hacia usuarios, reguladores y terceros afectados.

Ética operacional: alineación, sesgos y diseño responsable

La dimensión ética de la IA no es accesoria, sino un componente de diseño funcional, dado que errores éticos se traducen en fallos sistémicos, riesgos legales y daño reputacional. Desde un enfoque técnico se deben abordar, como mínimo, los siguientes vectores:

- Sesgos en entrenamiento: Datos históricos con discriminación, exclusión o representaciones distorsionadas generan modelos que replican patrones injustos. Se requieren técnicas de mitigación (reponderación, preprocesamiento, fairness constraints, evaluación diferenciada por subgrupos).

- Desigualdad de acceso: Sistemas optimizados solo para segmentos específicos pueden degradar el servicio para minorías o entornos con condiciones técnicas diferentes.

- Falsificación y desinformación: La IA generativa facilita la producción de contenido sintético (texto, audio, imagen, video) difícil de diferenciar de material legítimo, lo que requiere políticas de autenticidad, firmas digitales, estándares como C2PA y detección avanzada.

- Privacidad y protección de datos: Es indispensable garantizar que la IA no memorice ni exponga información personal sensible, ni viole regulaciones como GDPR, LGPD u otras normativas locales.

- Supervisión humana efectiva: La “human in the loop” debe ser real, con capacidad de corregir, bloquear o revertir decisiones, no una formalidad sin poder de intervención.

Diseñar sistemas alineados implica formalizar requisitos éticos como requisitos de ingeniería, integrados en el ciclo de vida:

- Definición explícita de valores, restricciones y contextos prohibidos antes del desarrollo.

- Métricas de evaluación para fairness, robustez, seguridad y respeto a derechos fundamentales.

- Revisión periódica de comportamiento del modelo en producción, con mecanismos de actualización segura.

Arquitecturas de IA seguras: principios esenciales para entornos críticos

Para sectores con alta exposición a riesgos (finanzas, salud, energía, transporte, telecomunicaciones, defensa, administración pública), la integración de IA debe sustentarse en arquitecturas robustas, auditables y resistentes a abuso. Algunos principios clave son:

- Seguridad multicapa: Protección en red, aplicaciones, identidad, datos, modelo y agente. Cada capa debe tener controles específicos para IA (filtrado de prompts, rate limiting, tokenización segura, monitoreo contextual).

- Separación de dominios: Entrenamiento, validación, pruebas y producción en entornos aislados, con rutas de promoción controladas y verificables.

- Gestión de identidades para IA: Tratamiento de modelos y agentes como entidades con identidad propia, con credenciales, permisos, registro de actividad y revocación.

- Mecanismos de apagado y contención: Capacidades técnicas reales para detener o aislar sistemas que presenten comportamientos anómalos o peligrosos, incluyendo kill-switches, revocación de claves y bloqueo de conectores críticos.

- Validación previa a decisiones críticas: Cualquier resultado de IA que impacte derechos, recursos financieros significativos o seguridad debe ser validado por humanos o sistemas independientes redundantes.

- DevSecOps aplicado a IA: Integrar escaneos de seguridad, controles de calidad de datos, análisis de dependencia de modelos externos y pruebas adversariales en el pipeline de desarrollo.

Blockchain, trazabilidad y prueba de integridad para sistemas de IA

La interacción entre IA y tecnologías de registro distribuido (DLT) ofrece mecanismos potenciales para fortalecer la trazabilidad y la integridad en sistemas de alto impacto. Si bien no es una solución universal, su aplicación bien diseñada puede contribuir a mitigar algunos de los dilemas de responsabilidad y opacidad:

- Registro inmutable de eventos: Uso de cadenas de bloques o ledgers permissioned para registrar versiones de modelos, cambios de configuración, parámetros clave y decisiones críticas.

- Verificabilidad de modelos: Hashes de pesos de modelos almacenados en registros distribuidos, permitiendo verificar que el modelo ejecutado corresponde a una versión auditada y no manipulada.

- Cadena de suministro de IA: Registro de orígenes de datasets, licencias, contribuciones de desarrolladores y validaciones de terceros para asegurar integridad de la cadena de suministro algorítmica.

- Pruebas de procedencia de contenido: Asociar contenido generado (imágenes, textos, videos) con metadatos verificables que permitan identificar si fue producido por IA, bajo qué sistema y con qué parámetros.

No obstante, la integración de blockchain debe evaluarse con rigor, considerando su costo, escalabilidad, complejidad operativa, regulaciones de datos personales y alineación con el resto de la arquitectura de seguridad.

Implicancias para la ciberseguridad organizacional

La adopción de IA avanzada transforma el modelo de amenaza y obliga a rediseñar la estrategia de ciberseguridad en varios niveles:

- Expansión de la superficie de ataque: APIs de modelos, integraciones con herramientas de terceros, plugins, agentes externos y dependencias con servicios cloud incrementan vectores explotables.

- Exfiltración de datos vía consultas: Usuarios internos pueden exponer información sensible al introducirla en asistentes de IA no controlados, generando fugas de propiedad intelectual y datos personales.

- Ataques contra los modelos: Envenenamiento de datos, manipulación de contextos de entrada, ataques de inferencia para recuperar información de entrenamiento o aprender parámetros internos.

- Phishing y fraude sofisticado: Deepfakes de voz e imagen, correos perfectos en lenguaje humano, suplantación de identidades, automatización de ingeniería social de alta precisión.

- Automatización defensiva: Del lado positivo, IA aplicada a detección temprana de amenazas, correlación avanzada, respuesta automatizada y reducción de tiempos de contención.

En este escenario, las organizaciones deben:

- Definir políticas internas explícitas sobre el uso de IA generativa y modelos externos.

- Implementar controles de DLP, clasificación de información y monitoreo de interacción con herramientas de IA.

- Integrar señales y telemetría de sistemas de IA en el SIEM para análisis conjunto.

- Capacitar a equipos de seguridad en técnicas ofensivas y defensivas específicas para IA.

- Realizar ejercicios de red teaming y simulaciones que incluyan amenazas basadas en IA.

Recomendaciones estratégicas para una IA responsable y segura

A partir de la síntesis técnica de los dilemas planteados, pueden establecerse líneas de acción concretas para organizaciones que desarrollan, adquieren o integran soluciones de IA avanzada:

- Adoptar un marco de gobernanza robusto de IA basado en estándares (NIST AI RMF, ISO/IEC 42001, ISO/IEC 23894, ISO/IEC 27001, ISO/IEC 38507).

- Clasificar los sistemas de IA según su nivel de criticidad y potencial de daño, aplicando mayores controles a sistemas de alto impacto.

- Formalizar la supervisión humana como requisito funcional, con procesos claros de override, revisión y bloqueo de outputs riesgosos.

- Establecer equipos multidisciplinarios (seguridad, datos, legal, compliance, ética, negocio) responsables de la evaluación continúa de la IA en producción.

- Garantizar transparencia técnica suficiente: documentación, especificaciones de capacidades, limitaciones, fuentes de datos, versiones, métricas y riesgos conocidos.

- Implementar pruebas adversariales periódicas, ejercicios de resiliencia y auditorías externas sobre modelos críticos.

- Limitar el acceso directo a modelos potentes desde entornos abiertos, aplicando reglas estrictas de autenticación, autorización y monitoreo.

- Desarrollar protocolos de gestión de incidentes específicos para IA, incluyendo fallos de alineación, outputs tóxicos, errores de decisión y abusos maliciosos.

- Diseñar desde el inicio con principios de privacidad por diseño, seguridad por diseño y ética por diseño, en lugar de agregar controles de forma reactiva.

Perspectiva profesional: por qué estos dilemas no son teóricos

Los dilemas de responsabilidad, control y consecuencias no previstas no pertenecen al ámbito abstracto, sino que se manifiestan en productos concretos: asistentes legales automatizados, diagnósticos médicos asistidos por IA, scoring crediticio algorítmico, análisis predictivo policial, sistemas de defensa autónomos, plataformas de vigilancia masiva, herramientas de generación de código y contenidos que pueden amplificar vulnerabilidades. El riesgo principal no es la aparición de una “conciencia artificial”, sino la combinación de:

- Modelos muy potentes.

- Integraciones con infraestructuras críticas.

- Falta de controles y gobernanza adecuada.

- Uso malintencionado o negligente.

Por ello, el diseño, despliegue y operación de sistemas de IA deben ser tratados con el mismo rigor, o superior, que la gestión de sistemas financieros regulados, equipamiento médico crítico o infraestructura nuclear. La IA no puede seguir siendo considerada un experimento masivo en producción sin supervisión. La lección de fondo es técnica y operacional: no se debe crear ni liberar capacidades de alto impacto sin mecanismos de contención, supervisión, trazabilidad y asunción explícita de responsabilidad.

Aprovechar las capacidades sin repetir errores: hacia una IA confiable

La pregunta clave no es si la IA debe avanzar, sino bajo qué condiciones arquitectónicas, regulatorias y éticas puede hacerlo minimizando daños y maximizando beneficios verificables. La respuesta técnica se orienta hacia un modelo de “IA confiable” (trustworthy AI), que integre:

- Robustez y resiliencia frente a errores, ataques y abusos.

- Transparencia proporcional al impacto: mayor impacto, mayor obligación de explicabilidad y documentación.

- Respeto estricto por derechos fundamentales, privacidad y no discriminación.

- Supervisión humana informada, con criterio técnico y autoridad real.

- Evaluación continua, no solo certificación puntual.

Esto requiere inversiones en capacidades internas de ingeniería de IA, ciberseguridad avanzada, ciencia de datos responsable, auditoría técnica y cumplimiento regulatorio, en lugar de depender exclusivamente de proveedores externos sin cuestionamiento.

En síntesis

Los desafíos que hoy enfrentan la ciberseguridad, la gobernanza algorítmica y el despliegue de inteligencia artificial avanzada no son un fenómeno aislado, sino la manifestación tecnológica de problemas estructurales: creación de sistemas complejos sin estructuras equivalentes de control, responsabilidad difusa, priorización de velocidad sobre seguridad, y subestimación de los impactos sociales y materiales de fallos algorítmicos. En la práctica profesional, esto se traduce en la obligación de diseñar, implementar y operar sistemas de IA bajo estándares rigurosos, con marcos normativos claros, métricas verificables y mecanismos efectivos de supervisión.

Para las organizaciones que lideran la adopción de tecnologías emergentes, la recomendación central es inequívoca: tratar la IA generativa y los sistemas autónomos como componentes de infraestructura crítica, con el mismo nivel de disciplina técnica, controles de seguridad, gobernanza corporativa y responsabilidad legal que cualquier otro sistema cuya falla pueda causar daño significativo. La diferencia entre innovación responsable y riesgo inaceptable reside en la calidad de estas decisiones de diseño y gobernanza.

Para más información visita la Fuente original.