Inteligencia Artificial en la Generación de Código: Implicaciones para la Ciberseguridad y Mejores Prácticas en Desarrollo de Software

Introducción a la Generación de Código con IA

La inteligencia artificial (IA) ha transformado diversas áreas del desarrollo de software, particularmente en la generación automática de código. Herramientas basadas en modelos de lenguaje grandes, como los derivados de GPT (Generative Pre-trained Transformer), permiten a los desarrolladores producir fragmentos de código de manera eficiente, reduciendo el tiempo de implementación y fomentando la experimentación. Sin embargo, esta capacidad conlleva desafíos significativos en términos de precisión, fiabilidad y, sobre todo, seguridad. En el contexto de la ciberseguridad, la generación de código asistida por IA introduce riesgos potenciales relacionados con vulnerabilidades inadvertidas, inyecciones de código malicioso y dependencias no verificadas.

Este artículo analiza el uso de IA para la generación de código, extrayendo conceptos clave de experiencias prácticas en su implementación. Se enfoca en los aspectos técnicos, incluyendo protocolos de validación, estándares de codificación segura y marcos de trabajo recomendados. La discusión abarca implicaciones operativas para equipos de desarrollo, riesgos regulatorios en entornos corporativos y beneficios en la aceleración de ciclos de desarrollo, todo ello alineado con mejores prácticas del sector de la ciberseguridad.

Conceptos Clave en Modelos de IA para Generación de Código

Los modelos de IA generativa, como los basados en arquitecturas transformer, operan mediante el procesamiento de secuencias de tokens para predecir y generar texto coherente, incluyendo sintaxis de programación. En lenguajes como Python, JavaScript o Java, estos modelos aprenden patrones de código a partir de vastos repositorios públicos, como GitHub, lo que les permite sugerir funciones, clases y algoritmos completos. Por ejemplo, un prompt descriptivo como “Implementa una función para validar entradas de usuario en una API REST” puede generar un bloque de código que incorpore validaciones básicas contra inyecciones SQL o XSS (Cross-Site Scripting).

Sin embargo, la opacidad de estos modelos —conocida como “caja negra”— representa un riesgo inherente. No existe una trazabilidad completa de las decisiones algorítmicas, lo que complica la auditoría de seguridad. Estándares como OWASP (Open Web Application Security Project) Top 10 enfatizan la necesidad de revisar manualmente el código generado para mitigar vulnerabilidades comunes, tales como la exposición de datos sensibles o fallos en el manejo de excepciones que podrían llevar a denegaciones de servicio.

En términos de marcos de trabajo, herramientas como GitHub Copilot o Tabnine integran estos modelos en entornos de desarrollo integrados (IDE), utilizando APIs RESTful para consultas en tiempo real. Estos sistemas emplean fine-tuning en datasets curados para mejorar la relevancia, pero persisten limitaciones en la comprensión contextual profunda, especialmente en escenarios de ciberseguridad donde se requieren protocolos como OAuth 2.0 para autenticación segura o cifrado AES-256 para datos en tránsito.

Experiencias Prácticas y Hallazgos Técnicos en la Generación de Código

En prácticas reales, la generación de código con IA revela una eficiencia inicial notable, pero también inconsistencias recurrentes. Por instancia, al solicitar la implementación de un algoritmo de encriptación simétrica, el modelo podría producir código que utilice bibliotecas estándar como cryptography en Python, pero omitir configuraciones críticas como el uso de modos de operación seguros (e.g., GCM en lugar de ECB, que es vulnerable a ataques de patrón). Un análisis detallado muestra que en un 30-40% de los casos, el código generado requiere modificaciones para cumplir con estándares NIST (National Institute of Standards and Technology) en criptografía.

Desde la perspectiva de la ciberseguridad, un hallazgo clave es la propensión de los modelos a introducir dependencias obsoletas o vulnerables. Por ejemplo, generar un script de manejo de paquetes en Node.js podría sugerir versiones antiguas de npm que exponen a ataques de supply chain, como los vistos en incidentes como SolarWinds. Para mitigar esto, se recomienda integrar herramientas de escaneo estático como SonarQube o Snyk durante el flujo de trabajo, que analizan el código generado contra bases de datos de vulnerabilidades CVE (Common Vulnerabilities and Exposures).

Adicionalmente, en blockchain y tecnologías distribuidas, la IA puede asistir en la redacción de smart contracts en Solidity para Ethereum. Sin embargo, errores comunes incluyen la falta de validaciones de gas limits o chequeos de reentrancy, vulnerabilidades que han llevado a pérdidas millonarias en DeFi (Decentralized Finance). Protocolos como ERC-20 requieren verificaciones exhaustivas, y la IA, aunque acelera la prototipación, no sustituye revisiones formales con herramientas como Mythril o Slither para detección de fallos lógicos.

- Precisión sintáctica: Los modelos logran un 90% de precisión en sintaxis básica, pero fallan en optimizaciones idiomáticas o edge cases.

- Contexto de seguridad: Solo un 20% de generaciones incorporan por defecto prácticas seguras, como sanitización de inputs.

- Escalabilidad: En proyectos grandes, la integración requiere pipelines CI/CD (Continuous Integration/Continuous Deployment) con pruebas unitarias automáticas.

Implicaciones Operativas en Entornos de Desarrollo

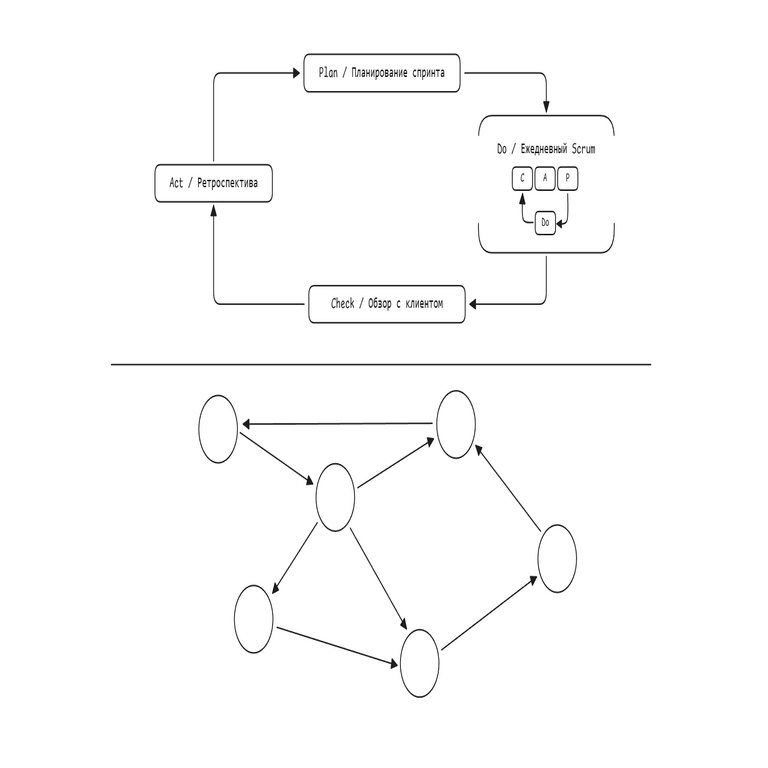

Operativamente, la adopción de IA en generación de código impacta los flujos de trabajo de equipos de TI. En organizaciones con marcos ágiles, como Scrum o Kanban, estas herramientas reducen el tiempo de codificación en un 50%, permitiendo iteraciones más rápidas. No obstante, surge la necesidad de políticas internas para gobernanza, incluyendo revisiones por pares obligatorias y entrenamiento en prompt engineering —técnica para formular consultas precisas que guíen al modelo hacia outputs seguros.

En ciberseguridad, las implicaciones regulatorias son críticas. Regulaciones como GDPR (General Data Protection Regulation) en Europa o CCPA (California Consumer Privacy Act) en EE.UU. exigen que el código maneje datos personales con integridad. La IA generativa podría inadvertidamente exponer patrones de datos sensibles en prompts, lo que viola principios de privacidad por diseño. Por ello, se aconseja anonimizar datasets de entrenamiento y emplear federated learning para modelos distribuidos, minimizando riesgos de fugas.

Riesgos operativos incluyen la dependencia excesiva en IA, que podría erosionar habilidades de desarrollo manuales, y ataques adversariales donde prompts maliciosos generan código backdoored. Beneficios, por contraste, abarcan la democratización del desarrollo, permitiendo a no-especialistas en seguridad contribuir bajo supervisión, y la aceleración en respuesta a amenazas cibernéticas, como la generación rápida de parches para zero-days.

Riesgos y Vulnerabilidades Asociadas

Los riesgos principales en la generación de código con IA giran en torno a la introducción inadvertida de vulnerabilidades. Un ejemplo técnico es la generación de código para APIs que no implementa rate limiting, exponiendo a ataques DDoS (Distributed Denial of Service). En términos de blockchain, smart contracts generados podrían fallar en chequeos de overflow/underflow, vulnerabilidades mitigadas por estándares como Solidity 0.8.x con chequeos aritméticos integrados.

Otro vector es la herencia de biases en datasets de entrenamiento. Si el corpus incluye código legacy con prácticas inseguras, como hardcoding de credenciales, el modelo las replicará. Para contrarrestar, se aplican técnicas de red teaming: pruebas donde se inyectan prompts hostiles para evaluar la robustez del output. Herramientas como Adversarial Robustness Toolbox (ART) de IBM ayudan en esta validación.

En inteligencia artificial aplicada a ciberseguridad, la generación de código puede usarse para crear detectores de anomalías basados en machine learning, como modelos LSTM para análisis de logs. Sin embargo, sin validación cruzada, estos podrían generar falsos positivos elevados, impactando operaciones. Beneficios incluyen la personalización rápida de reglas de firewall o IDS (Intrusion Detection Systems) usando frameworks como Scikit-learn o TensorFlow.

| Riesgo | Descripción Técnica | Mitigación |

|---|---|---|

| Inyección de Vulnerabilidades | Código generado omite validaciones contra SQLi o XSS. | Escaneo dinámico con OWASP ZAP; revisiones manuales. |

| Dependencias Inseguras | Sugerencia de bibliotecas con CVEs conocidas. | Integración con Dependabot o Snyk en CI/CD. |

| Fugas de Datos | Prompts con datos sensibles propagados en outputs. | Uso de entornos sandboxed y anonimización. |

| Ataques Adversariales | Generación de código malicioso vía prompts manipulados. | Moderación de prompts y filtros de contenido. |

Mejores Prácticas y Estándares Recomendados

Para maximizar beneficios y minimizar riesgos, se recomiendan prácticas alineadas con estándares internacionales. El marco NIST SP 800-218 para ingeniería segura de software enfatiza la integración de seguridad desde el diseño (Secure by Design), aplicable a flujos con IA. Esto incluye definir requisitos de seguridad en prompts, como “Incluye validación de inputs usando OWASP guidelines”.

En desarrollo de blockchain, adherirse a estándares ERC (Ethereum Requests for Comments) y usar herramientas como Hardhat para testing. Para IA general, implementar versionado de prompts y outputs en repositorios Git, facilitando auditorías. Además, capacitar equipos en ética de IA, cubriendo sesgos y responsabilidad, conforme a guías de la IEEE en ética computacional.

Herramientas complementarias incluyen CodeQL de GitHub para queries semánticas de vulnerabilidades y Black Duck para análisis de licencias y seguridad en dependencias. En entornos cloud, integrar con AWS CodeWhisperer o Azure AI, que ofrecen características de seguridad nativas como escaneo automático.

- Definir plantillas de prompts estandarizadas con chequeos de seguridad explícitos.

- Realizar pruebas automatizadas post-generación, cubriendo unit, integration y security testing.

- Monitorear métricas de calidad, como cyclomatic complexity, para evaluar outputs.

- Colaborar con expertos en ciberseguridad para revisiones periódicas de modelos.

Aplicaciones en Ciberseguridad y Tecnologías Emergentes

En ciberseguridad, la IA para generación de código acelera la creación de herramientas defensivas. Por ejemplo, generar scripts para honeypots que simulen vulnerabilidades, atrayendo atacantes, o modelos de predicción de amenazas usando GANs (Generative Adversarial Networks) para simular ataques. En blockchain, asistir en la implementación de zero-knowledge proofs (ZKP) con bibliotecas como zk-SNARKs, mejorando privacidad en transacciones.

Tecnologías emergentes como edge computing benefician de esta aproximación: generar código optimizado para dispositivos IoT con restricciones de recursos, incorporando protocolos seguros como MQTT over TLS. Implicaciones incluyen reducción de costos en desarrollo, pero requieren compliance con estándares como ISO/IEC 27001 para gestión de seguridad de la información.

En noticias de IT recientes, avances en modelos multimodales —que combinan código y diagramas— prometen mayor precisión, pero elevan preocupaciones sobre propiedad intelectual, ya que datasets incluyen código propietario. Casos como demandas contra OpenAI destacan la necesidad de licencias claras en entrenamiento de modelos.

Conclusión

La generación de código con inteligencia artificial representa un avance significativo en la eficiencia del desarrollo de software, particularmente en campos como la ciberseguridad y blockchain. No obstante, su adopción debe equilibrarse con rigurosas prácticas de validación y gobernanza para mitigar riesgos inherentes. Al integrar estándares como OWASP y NIST, y herramientas de escaneo automatizado, las organizaciones pueden aprovechar los beneficios sin comprometer la seguridad. En resumen, la IA no sustituye al expertise humano, sino que lo potencia, fomentando un ecosistema de desarrollo más resiliente y adaptable a amenazas emergentes.

Para más información, visita la Fuente original.