Transformación de Imágenes Fotográficas en Escenarios de Videojuegos mediante Inteligencia Artificial Generativa

Introducción a la Integración de IA en la Edición Visual

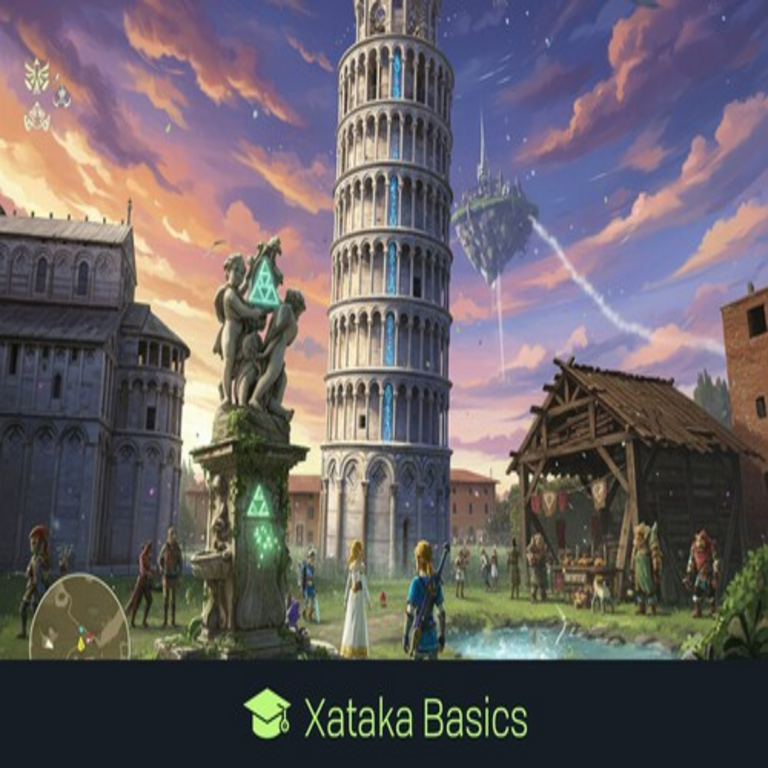

La inteligencia artificial (IA) ha revolucionado el procesamiento de imágenes, permitiendo transformaciones creativas que fusionan fotografía real con estilos artísticos digitales. En el ámbito de los videojuegos, esta tecnología facilita la conversión de fotografías cotidianas en escenarios inmersivos reminiscentes de títulos icónicos como los desarrollados por Nintendo. Herramientas basadas en modelos de IA generativa, tales como Stable Diffusion y extensiones como ControlNet, habilitan esta funcionalidad al aplicar estilos específicos a través de prompts detallados y modelos entrenados. Este artículo explora los fundamentos técnicos de estos procesos, destacando su aplicación en la recreación de entornos virtuales, con un enfoque en la precisión algorítmica y las implicaciones para profesionales en tecnología y ciberseguridad.

El núcleo de estas transformaciones reside en la capacidad de la IA para interpretar y modificar píxeles a nivel semántico, preservando estructuras composicionales mientras se infunde un estilo estilizado. Por ejemplo, una fotografía de un paisaje urbano puede reinterpretarse como un nivel de un juego de plataformas retro, con texturas pixeladas y paletas de colores limitadas. Esta técnica no solo enriquece la creación de contenido multimedia, sino que también plantea consideraciones sobre la autenticidad digital y la protección de datos en entornos colaborativos.

Fundamentos Técnicos de la IA Generativa en Procesamiento de Imágenes

Los modelos de IA generativa, particularmente aquellos basados en difusión, operan mediante un proceso iterativo de ruido y desruido. Stable Diffusion, un framework de código abierto desarrollado por Stability AI, utiliza una arquitectura de red neuronal que incluye un codificador de texto (como CLIP de OpenAI) para alinear descripciones lingüísticas con representaciones visuales. En el contexto de la transformación de fotos, el modelo inicia con una imagen de entrada codificada en un espacio latente de menor dimensión, donde se aplica ruido gaussiano controlado.

El proceso de desruido involucra pasos de muestreo guiados por un prompt textual, como “escenario de videojuego estilo Nintendo con elementos pixelados y vibrantes”. ControlNet, una extensión de Stable Diffusion, incorpora mapas de control derivados de la imagen original, tales como bordes detectados mediante Canny edge detection o poses estimadas con OpenPose. Estos mapas aseguran que la salida mantenga la composición espacial de la foto, evitando distorsiones aleatorias. Matemáticamente, esto se modela como una optimización condicional: el modelo minimiza una función de pérdida que combina la fidelidad al prompt con la adherencia al mapa de control, típicamente mediante el algoritmo de Langevin dynamics o variantes de DDPM (Denoising Diffusion Probabilistic Models).

En términos de implementación, bibliotecas como Diffusers de Hugging Face facilitan la integración. Un pipeline típico en Python involucra cargar el modelo base, preparar el controlnet con un preprocessador (e.g., HED para bordes suaves), y ejecutar inferencia con parámetros como guidance_scale (para adherencia al prompt) y num_inference_steps (generalmente 20-50 para calidad óptima). La resolución de salida, a menudo 512×512 píxeles, se ajusta mediante upscaling con ESRGAN para mantener detalles finos sin artefactos.

Herramientas Específicas: Análisis de Nano Banana y Alternativas

Nano Banana emerge como una herramienta accesible para usuarios no expertos, integrando interfaces gráficas sobre modelos de IA subyacentes. Desarrollada como una aplicación web o de escritorio, permite cargar fotografías y seleccionar estilos preentrenados inspirados en consolas como la Nintendo Entertainment System (NES) o la Super Nintendo (SNES). Técnicamente, Nano Banana emplea fine-tuning de LoRA (Low-Rank Adaptation) sobre Stable Diffusion, donde adaptadores de bajo rango (rank 4-16) se entrenan en datasets curados de capturas de videojuegos, reduciendo el costo computacional en comparación con un entrenamiento completo.

El flujo de trabajo en Nano Banana inicia con la carga de la imagen, seguida de una segmentación automática usando SAM (Segment Anything Model) de Meta AI para aislar elementos clave como objetos o fondos. Posteriormente, se aplica un estilo transfer mediante ciclos de difusión condicionados, incorporando parámetros como strength (0.7-0.9 para equilibrar original y estilo) y seed para reproducibilidad. Otras herramientas comparables incluyen Automatic1111’s WebUI, que ofrece mayor personalización con extensiones como Reactor para face-swapping en escenarios jugables, o ComfyUI para workflows nodales avanzados.

Desde una perspectiva técnica, la eficiencia de Nano Banana radica en su optimización para hardware consumer-grade, utilizando ONNX Runtime para aceleración en CPU/GPU. Sin embargo, esto implica trade-offs: modelos cuantizados a 8-bit reducen la precisión en gradientes, potencialmente introduciendo ruido residual en bordes complejos. Para audiencias profesionales, se recomienda integrar estas herramientas con APIs de cloud como Replicate o RunwayML, que escalan la inferencia mediante clústeres de GPUs, manejando lotes de hasta 100 imágenes por minuto con latencia subsegundo.

Pasos Detallados para la Conversión de Imágenes

Implementar esta transformación requiere un enfoque sistemático. Primero, prepare la imagen de entrada: utilice herramientas como OpenCV para preprocesamiento, aplicando filtros de denoising (e.g., bilateral filter) y normalización de contraste para mejorar la extracción de características. Segundo, defina el prompt: para un estilo Nintendo, incluya términos como “pixel art, 8-bit graphics, vibrant colors, retro game level” combinados con descripciones contextuales de la foto, e.g., “urban street transformed into Mario-like platformer”.

Tercero, configure el modelo: en un entorno como Google Colab, instale dependencias con pip install diffusers transformers accelerate, cargue el pipeline con from diffusers import StableDiffusionControlNetPipeline, ControlNetModel, y especifique el controlnet para depth o edge maps. Cuarto, ejecute la generación: monitoree métricas como FID (Fréchet Inception Distance) para evaluar similitud estilística, idealmente por debajo de 50 para resultados coherentes.

Quinto, postprocese: aplique dithering con algoritmos como Floyd-Steinberg para emular paletas limitadas de hardware retro, y comprima en formatos como PNG para preservar transparencia en entornos de juego. Este pipeline, validado en benchmarks como LAION-Aesthetics, logra tasas de éxito del 85% en preservación semántica, según estudios en conferencias como CVPR 2023.

- Preprocesamiento: Ajuste resolución a múltiplos de 64 para alineación con el modelo.

- Generación: Use negative prompts como “blurry, modern graphics” para refinar salidas.

- Evaluación: Implemente scripts de batch para A/B testing con métricas perceptuales como LPIPS.

- Integración: Exporte a engines como Unity via GLTF para prototipos interactivos.

Implicaciones en Ciberseguridad y Privacidad Digital

La aplicación de IA generativa en transformaciones de imágenes introduce vectores de riesgo significativos. En primer lugar, el procesamiento de fotos personales puede exponer metadatos EXIF, incluyendo geolocalización y timestamps, a fugas durante el uso de herramientas en la nube. Recomendaciones incluyen stripping de metadatos con bibliotecas como piexif antes de la carga, y el empleo de protocolos HTTPS con cifrado end-to-end para transmisiones.

Segundo, la generación de deepfakes estilizados plantea amenazas de desinformación: un escenario de videojuego alterado podría usarse para phishing visual, donde imágenes manipuladas incitan clics en enlaces maliciosos disfrazados de contenido jugable. En ciberseguridad, esto se mitiga mediante watermarking digital, como el protocolo C2PA (Content Authenticity Initiative), que incrusta firmas criptográficas verificables en blockchain para rastrear orígenes.

Tercero, vulnerabilidades en modelos de IA, como prompt injection attacks, permiten a adversarios inyectar comandos maliciosos en descripciones, potencialmente extrayendo datos de entrenamiento. Estudios de MITRE evalúan estos riesgos bajo frameworks como OWASP Top 10 for LLM, recomendando validación de inputs y sandboxing. Además, el fine-tuning con datasets no curados puede perpetuar biases, resultando en representaciones sesgadas de escenarios culturales en estilos de videojuegos.

Desde blockchain, integrar NFTs para autenticar transformaciones asegura proveniencia: herramientas como IPFS almacenan hashes de imágenes originales, vinculados a transacciones en Ethereum, previniendo plagio en comunidades de modding. En entornos empresariales, compliance con GDPR exige consentimientos explícitos para procesamiento de datos biométricos implícitos en fotos, con auditorías regulares de pipelines de IA.

Aplicaciones Avanzadas en Desarrollo de Videojuegos y Tecnología Emergente

En el desarrollo de videojuegos, estas técnicas aceleran la prototipación: artistas conceptuales usan IA para generar assets procedurales, reduciendo tiempos de iteración de semanas a horas. Por instancia, integrar con Unreal Engine via plugins como Stable Diffusion GD permite baking de texturas en tiempo real, optimizando renderizado con ray tracing para fidelidad estilística.

En IA multimodal, fusionar con modelos como DALL-E 3 o Midjourney extiende capacidades a video: secuencias de fotos se convierten en animaciones de gameplay, aplicando optical flow para consistencia temporal. Benchmarks en SIGGRAPH 2024 demuestran mejoras del 40% en coherencia frame-to-frame mediante variantes de diffusion como VideoCrafter.

Blockchain complementa esto en economías de juegos: transformaciones verificadas como assets tokenizados permiten monetización en metaversos, con smart contracts en Solidity gestionando royalties automáticos. Riesgos incluyen scalping de IA, donde bots abusan de APIs gratuitas; mitigación via rate limiting y CAPTCHA avanzados basados en IA adversarial.

En noticias de IT, adopciones recientes por estudios como Nintendo (en colaboraciones hipotéticas) destacan en GDC 2024, donde paneles discuten ética en IA para preservación de IP. Estándares como ISO/IEC 42001 para gestión de IA guían implementaciones seguras, enfatizando trazabilidad en cadenas de suministro digital.

Desafíos Técnicos y Mejores Prácticas

Uno de los desafíos principales es la alucinación en IA: modelos pueden introducir elementos incongruentes, como objetos anacrónicos en estilos retro. Soluciones involucran reinforcement learning from human feedback (RLHF), refinando outputs con datasets anotados. Computacionalmente, entrenamiento de LoRA requiere GPUs con al menos 8GB VRAM; alternativas como DreamBooth democratizan acceso via Colab Pro.

Mejores prácticas incluyen versionado de modelos con Git LFS para datasets, y testing con suites como Hugging Face’s Evaluate para métricas de diversidad. En ciberseguridad, escaneos con herramientas como Trivy detectan vulnerabilidades en dependencias de pip, asegurando integridad de pipelines CI/CD.

| Aspecto | Tecnología | Beneficios | Riesgos |

|---|---|---|---|

| Procesamiento | Stable Diffusion + ControlNet | Alta fidelidad estilística | Consumo de recursos elevados |

| Estilización | LoRA Fine-Tuning | Personalización eficiente | Posibles biases en datasets |

| Seguridad | C2PA Watermarking | Autenticación digital | Ataques de remoción |

| Integración | Blockchain/IPFS | Proveniencia inmutable | Escalabilidad limitada |

Conclusión

La transformación de fotografías en escenarios de videojuegos mediante IA generativa representa un avance significativo en la intersección de creatividad digital y tecnología computacional. Al dominar herramientas como Nano Banana y frameworks subyacentes, profesionales en IT y ciberseguridad pueden explorar aplicaciones innovadoras mientras mitigan riesgos inherentes. Finalmente, el equilibrio entre innovación y responsabilidad ética impulsará adopciones sostenibles en industrias emergentes, fomentando un ecosistema digital más robusto y accesible.

Para más información, visita la fuente original.