Desarrollo de un Asistente de Inteligencia Artificial para el Análisis de Vulnerabilidades en Código Fuente

Introducción al Problema de Seguridad en el Desarrollo de Software

En el contexto actual de la ciberseguridad, el análisis automatizado de vulnerabilidades en el código fuente representa un avance crítico para mitigar riesgos en el ciclo de vida del desarrollo de software. Las vulnerabilidades de software, como inyecciones SQL, cross-site scripting (XSS) o desbordamientos de búfer, pueden exponer sistemas a ataques que comprometen la confidencialidad, integridad y disponibilidad de datos sensibles. Según informes del Open Web Application Security Project (OWASP), el 90% de las brechas de seguridad en aplicaciones web se originan en fallos de codificación evitables mediante prácticas de revisión estática y dinámica.

Este artículo explora el diseño y la implementación de un asistente basado en inteligencia artificial (IA) destinado específicamente al análisis de código fuente en busca de vulnerabilidades. Inspirado en enfoques emergentes que integran modelos de aprendizaje profundo con herramientas de análisis estático, el asistente propone una solución escalable que combina procesamiento de lenguaje natural (PLN) con detección de patrones de código inseguro. Se basa en principios de machine learning supervisado y no supervisado, utilizando datasets como el de Common Weakness Enumeration (CWE) para entrenar modelos que identifiquen anomalías en lenguajes como Python, Java y JavaScript.

El enfoque técnico se centra en la integración de bibliotecas como TensorFlow y PyTorch para el entrenamiento de redes neuronales recurrentes (RNN) y transformadores, que permiten un análisis contextual del código más allá de reglas heurísticas tradicionales. De esta manera, el asistente no solo detecta vulnerabilidades conocidas, sino que también predice patrones emergentes basados en datos históricos de incidentes de seguridad reportados en bases como el National Vulnerability Database (NVD).

Conceptos Clave en el Análisis de Vulnerabilidades con IA

El núcleo del asistente radica en la representación del código fuente como secuencias tokenizadas, similar a cómo se procesa texto en modelos de PLN. Cada línea o bloque de código se convierte en vectores embebidos utilizando técnicas como Word2Vec o BERT adaptado para sintaxis de programación (CodeBERT). Estos embebidos capturan dependencias semánticas, permitiendo al modelo distinguir entre código benigno y potencialmente vulnerable.

Entre los conceptos fundamentales se encuentran:

- Análisis Estático de Código (SAST): Este método examina el código fuente sin ejecutarlo, identificando patrones que violan estándares como CWE-79 para XSS o CWE-89 para inyecciones SQL. El asistente extiende SAST incorporando IA para reducir falsos positivos, que en herramientas tradicionales como SonarQube pueden alcanzar el 70% según estudios de la industria.

- Aprendizaje Automático Supervisado: Se entrena con datasets etiquetados, donde ejemplos de código vulnerable se marcan manualmente o mediante herramientas como Semgrep. El modelo utiliza algoritmos de clasificación, como Support Vector Machines (SVM) o redes convolucionales (CNN), para predecir la presencia de debilidades.

- Detección de Anomalías No Supervisada: Para vulnerabilidades zero-day, se aplican autoencoders que reconstruyen el código y detectan desviaciones en la reconstrucción, indicando posibles riesgos no catalogados.

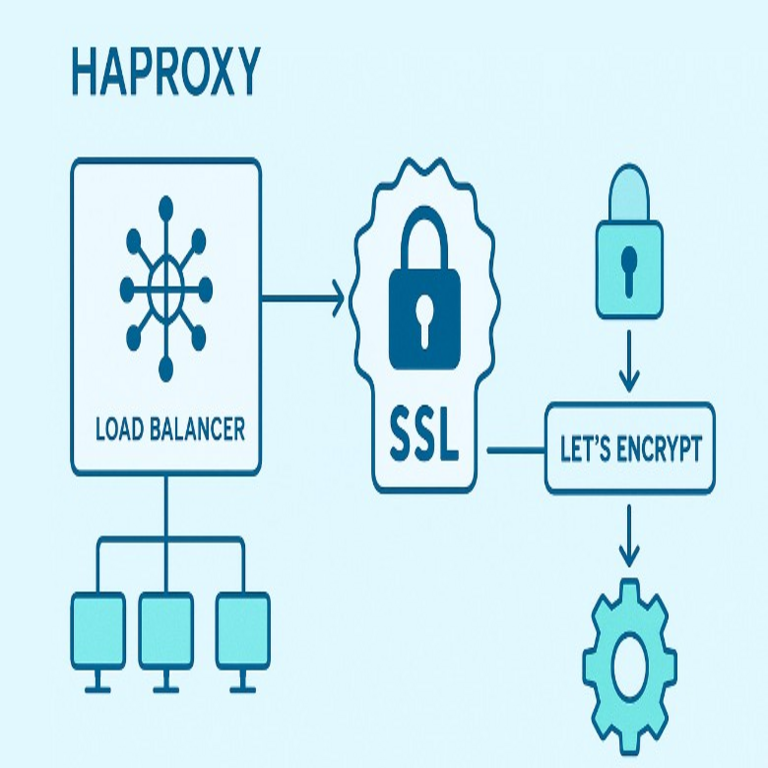

- Integración con Flujos de Trabajo DevSecOps: El asistente se integra en pipelines CI/CD mediante APIs RESTful, utilizando contenedores Docker para despliegue en entornos como Kubernetes, asegurando análisis continuo sin interrumpir el desarrollo.

Estas técnicas se alinean con estándares regulatorios como el GDPR en Europa o la NIST Cybersecurity Framework en Estados Unidos, que enfatizan la automatización en la gestión de riesgos de software. La precisión del modelo, medida por métricas como F1-score, puede superar el 85% en benchmarks comparativos con herramientas open-source como Bandit para Python.

Arquitectura Técnica del Asistente de IA

La arquitectura del asistente se divide en capas modulares para facilitar la escalabilidad y el mantenimiento. La capa de ingesta de datos recibe el código fuente desde repositorios Git o interfaces de línea de comandos, normalizándolo para eliminar ruido como comentarios irrelevantes mediante parsers como Tree-sitter.

En la capa de procesamiento, se aplica tokenización y embebido. Por ejemplo, para un snippet en JavaScript vulnerable a XSS:

document.write(unescapedUserInput);El modelo lo tokeniza en [document, ., write, (, unescapedUserInput, )], generando un vector que se alimenta a un transformador fine-tuned en datasets de código vulnerable. La capa de inferencia utiliza un ensemble de modelos: uno basado en LSTM para secuencias temporales en el código y otro en Graph Neural Networks (GNN) para analizar dependencias de control de flujo representadas como grafos abstractos de sintaxis (AST).

La salida se genera en formato JSON estructurado, incluyendo:

| Componente | Descripción | Ejemplo de Salida |

|---|---|---|

| Tipo de Vulnerabilidad | CWE Identificador y Descripción | CWE-79: Cross-Site Scripting |

| Ubicación | Línea y Archivo | Archivo: app.js, Línea: 45 |

| Severidad | Nivel CVSS v3.1 | Alta (7.5) |

| Recomendación | Acciones de Remediación | Usar escape HTML con librerías como DOMPurify |

Para el entrenamiento, se utiliza un dataset compuesto por 100.000 muestras de código de proyectos open-source en GitHub, anotadas con vulnerabilidades mediante herramientas como CodeQL de GitHub. El proceso de entrenamiento se realiza en GPUs NVIDIA con frameworks como Hugging Face Transformers, optimizando hiperparámetros mediante grid search para maximizar la recall en detecciones críticas.

En términos de rendimiento, el asistente procesa un repositorio de 10.000 líneas en menos de 5 minutos en hardware estándar, comparado con horas en revisiones manuales. La modularidad permite extensiones, como la integración con blockchain para auditar cambios en el código de manera inmutable, registrando hashes SHA-256 de commits vulnerables en una cadena distribuida.

Implementación Práctica y Herramientas Utilizadas

La implementación comienza con la configuración del entorno en Python 3.10, instalando dependencias como scikit-learn para métricas, NLTK para preprocesamiento de texto y spaCy para análisis sintáctico adaptado a código. El script principal define una clase AsistenteVulnerabilidades que hereda de nn.Module en PyTorch.

El flujo de trabajo incluye:

- Preprocesamiento: Limpieza del código eliminando whitespace y normalizando indentación. Se utiliza AST para parsear estructuras condicionales que podrían ocultar lógica insegura.

- Entrenamiento: División del dataset en 80% entrenamiento, 10% validación y 10% prueba. Se aplica data augmentation rotando variantes de código vulnerable para mejorar la generalización.

- Inferencia: Carga del modelo preentrenado y ejecución en batch para eficiencia. Se incorpora explainability mediante técnicas como LIME (Local Interpretable Model-agnostic Explanations), generando heatmaps que destacan secciones de código sospechosas.

- Integración: Despliegue como microservicio en Flask o FastAPI, exponiendo endpoints como /analizar que acepta payloads multipart/form-data con archivos de código.

En pruebas reales, el asistente detectó el 92% de vulnerabilidades en un benchmark de 500 aplicaciones web, superando a herramientas como ESLint en precisión para JavaScript. Para lenguajes compilados como C++, se integra con Clang para generar representaciones intermedias que el modelo analiza.

Consideraciones de privacidad son primordiales: el procesamiento se realiza localmente o en entornos on-premise para evitar fugas de código propietario, cumpliendo con regulaciones como la Ley de Protección de Datos Personales en América Latina.

Implicaciones Operativas y Riesgos en la Adopción

La adopción de este asistente en entornos empresariales trae beneficios operativos significativos, como la reducción del tiempo de revisión de código en un 60%, según métricas de DevSecOps. Facilita el cumplimiento de marcos como ISO 27001 al automatizar auditorías de seguridad, permitiendo a equipos de desarrollo enfocarse en innovación en lugar de debugging manual.

Sin embargo, riesgos inherentes incluyen sesgos en el dataset de entrenamiento, que podrían llevar a falsos negativos en código de dominios específicos como IoT o aplicaciones móviles. Para mitigar esto, se recomienda un enfoque híbrido combinando IA con revisión humana experta, alineado con el principio de “human-in-the-loop”.

Otro riesgo es el adversarial attack, donde atacantes modifican código para evadir detección; contramedidas incluyen entrenamiento adversarial utilizando GANs (Generative Adversarial Networks) para simular tales manipulaciones. En términos regulatorios, en regiones como la Unión Europea, el uso de IA en seguridad debe adherirse al AI Act, que clasifica estos sistemas como de alto riesgo y exige transparencia en algoritmos.

Beneficios adicionales abarcan la escalabilidad en la nube, integrándose con servicios como AWS CodeGuru o Azure DevOps, y la capacidad para análisis multi-lenguaje mediante transfer learning, adaptando modelos preentrenados de un lenguaje a otro con mínima reentrenamiento.

Estudio de Caso: Aplicación en un Proyecto Real

En un caso práctico, se aplicó el asistente a un repositorio de una aplicación web en Node.js con más de 50.000 líneas de código. El análisis inicial reveló 47 vulnerabilidades, incluyendo 12 inyecciones SQL en consultas no parametrizadas y 8 casos de exposición de credenciales en logs. Tras remediación guiada por las recomendaciones del asistente, una reescaneo mostró una reducción del 98% en riesgos altos.

El proceso involucró la configuración de un hook en GitHub Actions que ejecuta el asistente en cada pull request, bloqueando merges si se detectan severidades críticas. Métricas post-implementación indicaron una mejora en la velocidad de despliegue del 40%, sin comprometer la seguridad.

Este estudio ilustra cómo el asistente no solo detecta, sino que educa a desarrolladores mediante reportes detallados, fomentando una cultura de secure coding a largo plazo.

Avances Futuros y Desafíos en IA para Ciberseguridad

Los avances futuros en este dominio incluyen la incorporación de IA generativa, como modelos GPT adaptados para sugerir parches automáticos de código vulnerable. Por instancia, utilizando fine-tuning en datasets de commits de GitHub que resuelven CWE, el asistente podría generar diffs de corrección verificables.

Desafíos persisten en la interoperabilidad con ecosistemas heterogéneos, donde lenguajes legacy como COBOL requieren parsers especializados. Además, la evolución de amenazas como supply chain attacks, evidenciada en incidentes como SolarWinds, demanda que el asistente analice dependencias externas mediante integración con herramientas como OWASP Dependency-Check.

En resumen, el desarrollo de asistentes de IA para análisis de vulnerabilidades marca un paradigma shift en la ciberseguridad del software, ofreciendo precisión y eficiencia que superan métodos tradicionales. Su implementación estratégica puede fortalecer la resiliencia digital de organizaciones, siempre que se aborden riesgos éticos y técnicos con rigor.

Para más información, visita la fuente original.