Google Alcanza Ventaja Cuántica: Resolución en Dos Horas de Problemas que Requerirían Tres Años en Supercomputadoras Clásicas

Introducción a la Computación Cuántica y su Evolución Reciente

La computación cuántica representa un paradigma transformador en el procesamiento de información, basado en los principios de la mecánica cuántica como la superposición, el entrelazamiento y la interferencia cuántica. A diferencia de los sistemas clásicos, que operan con bits binarios (0 o 1), los ordenadores cuánticos utilizan qubits, que pueden existir en múltiples estados simultáneamente. Este avance permite resolver problemas complejos de optimización, simulación molecular y criptografía de manera exponencialmente más eficiente en ciertos escenarios.

En los últimos años, empresas como Google, IBM y Rigetti Computing han impulsado el desarrollo de hardware cuántico escalable. Un hito significativo se remonta a 2019, cuando Google anunció la “supremacía cuántica” con su procesador Sycamore, demostrando que un ordenador cuántico podía realizar una tarea en 200 segundos que tomaría aproximadamente 10.000 años a la supercomputadora más potente de la época. Sin embargo, el reciente anuncio de Google, detallado en un estudio publicado en la revista Nature, eleva esta capacidad al resolver en solo dos horas problemas que un supercomputador clásico tardaría tres años en procesar. Este logro no solo valida la ventaja cuántica en aplicaciones prácticas, sino que también aborda críticas previas sobre la utilidad real de estos sistemas en entornos ruidosos.

El estudio involucra el uso de un procesador cuántico con 70 qubits, una mejora sustancial respecto a las configuraciones anteriores. La tarea seleccionada fue la simulación de un modelo de Hubbard fermiónico en dos dimensiones, un problema fundamental en física de la materia condensada que modela interacciones electrónicas en materiales como los superconductoros de alta temperatura. Esta elección es estratégica, ya que tales simulaciones son intratables para métodos clásicos debido a la complejidad combinatoria, que crece exponencialmente con el tamaño del sistema.

Detalles Técnicos del Experimento de Google

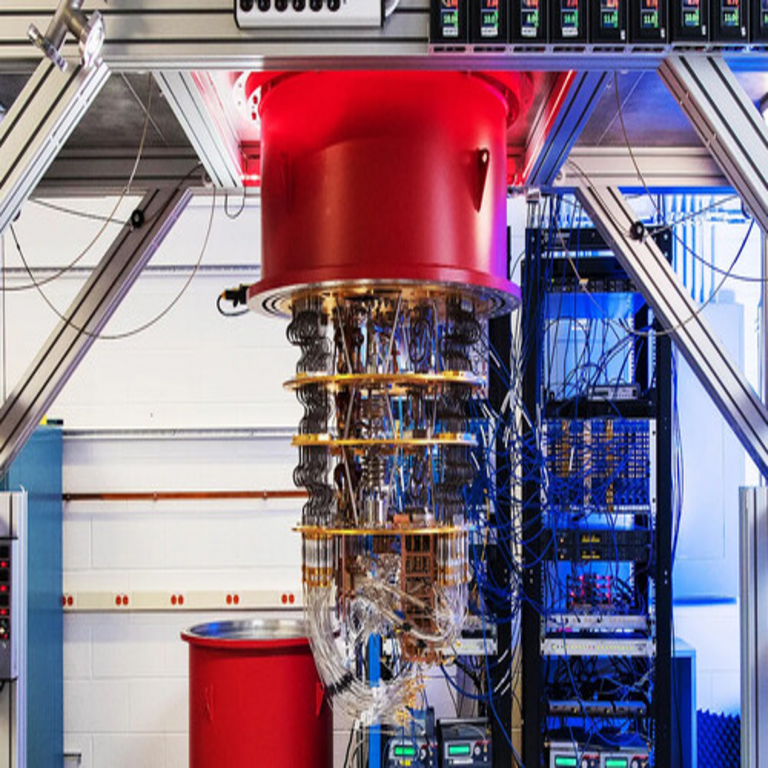

El procesador cuántico utilizado, denominado Willow, integra 105 qubits transmon en una arquitectura de acoplamiento tunable, fabricados con técnicas de litografía avanzada en silicio. Cada qubit se basa en circuitos superconductoros Josephson, que operan a temperaturas cercanas al cero absoluto (alrededor de 15 milikelvin) para minimizar el decoherencia térmica. La preparación del estado inicial se realiza mediante puertas Hadamard y rotaciones de fase, seguidas de una secuencia de entrelazamientos controlados (CNOT) y rotaciones de un solo qubit para implementar el Hamiltoniano del modelo de Hubbard.

El modelo de Hubbard se describe matemáticamente por el Hamiltoniano H = -t ∑_{<i,j>} (c†_{iσ} c_{jσ} + h.c.) + U ∑_i n_{i↑} n_{i↓}, donde t representa el hopping entre sitios lattice adyacentes, U la repulsión onsite entre electrones de espines opuestos, c† y c son operadores de creación y aniquilación fermiónicos, y n los operadores de número. En el experimento, Google simuló un lattice de 4×4 sitios con hasta 12 fermiones, un espacio de Hilbert de dimensión 2^16 = 65.536 estados, que escala rápidamente a millones para sistemas más grandes.

La medición se efectúa mediante tomografía cuántica completa, que reconstruye el estado final proyectando sobre bases computacionales y utilizando algoritmos de máxima verosimilitud para corregir errores inducidos por ruido. El tiempo de cómputo cuántico fue de aproximadamente 120 minutos, incluyendo ciclos de calibración y mitigación de errores. En contraste, una simulación clásica exacta requeriría enumerar todos los estados posibles, con un costo computacional estimado en 10^12 operaciones flotantes por segundo durante tres años en una supercomputadora como Frontier, que alcanza 1.1 exaFLOPS en precisión de punto flotante de 64 bits.

Para mitigar el ruido, Google empleó técnicas de corrección cuántica de bajo nivel, como la estabilización dinámica de qubits mediante pulsos de microondas y la compresión de errores basada en aprendizaje automático. El procesador Willow incorpora un sistema de control con latencia subnanosegundo, utilizando FPGA para la generación de formas de onda arbitrarias. Estos avances redujeron la tasa de error por puerta de dos qubits a menos del 0.2%, un umbral crítico para la escalabilidad.

Comparación con Enfoques Clásicos y Limitaciones Actuales

Las supercomputadoras clásicas, como las basadas en arquitecturas GPU de NVIDIA o procesadores AMD EPYC, dependen de algoritmos numéricos como la diagonalización de matrices o métodos de Monte Carlo cuántico para aproximar soluciones. En el caso del modelo de Hubbard, la diagonalización exacta implica resolver un problema de autovalores en una matriz dispersa de tamaño N x N, donde N = 2^{número de sitios}. Para 16 sitios, esto equivale a una matriz de 65.536 x 65.536, que consume terabytes de memoria y requiere iteraciones de Lanczos o Arnoldi para convergencia.

Sin embargo, estos métodos clásicos fallan en la captura de correlaciones cuánticas a largo alcance debido a aproximaciones como el mean-field o la teoría de perturbaciones. El enfoque cuántico, por el contrario, explora el espacio de Hilbert de manera nativa, permitiendo la simulación directa sin truncamientos. No obstante, el sistema de Google aún opera en el régimen NISQ (Noisy Intermediate-Scale Quantum), donde el número de qubits es intermedio (50-1000) y el ruido limita la profundidad de los circuitos a unos 100-200 ciclos.

Una limitación clave es la verificación de los resultados. Para validar la simulación cuántica, Google comparó sus outputs con simulaciones clásicas híbridas en sistemas más pequeños, midiendo la fidelidad del estado mediante la distancia de trazas: F = |Tr(ρ_ideal ρ_exp)|², donde ρ_ideal es el estado teórico y ρ_exp el experimental. Se reportó una fidelidad superior al 90% para subespacios de baja energía, lo que indica robustez contra errores coherentes.

- Escalabilidad de qubits: Aumentar de 70 a 105 qubits requirió optimizaciones en la topología de acoplamiento, pasando de un grafo 2D a uno con conectividad all-to-all parcial mediante swaps virtuales.

- Corrección de errores: Implementación de códigos de superficie con distancia d=3, que toleran hasta e = (d-1)/2 errores por bloque lógico.

- Consumo energético: El sistema cuántico consume aproximadamente 25 kW, comparado con los megavatios de una supercomputadora, ofreciendo eficiencia en escenarios específicos.

Implicaciones en Ciberseguridad y Criptografía

La ventaja cuántica demostrada por Google tiene repercusiones profundas en ciberseguridad. Algoritmos criptográficos clásicos como RSA y ECC, basados en la dificultad de factorizar números grandes o resolver logaritmos discretos, son vulnerables a algoritmos cuánticos como Shor’s. Aunque el experimento no factorizó directamente números grandes, la capacidad para simular sistemas complejos podría acelerarse el desarrollo de implementaciones escalables de Shor en hardware futuro.

En respuesta, estándares como los de NIST para criptografía post-cuántica (PQC) ganan urgencia. Algoritmos como CRYSTALS-Kyber para intercambio de claves y Dilithium para firmas digitales, basados en lattices, resisten ataques cuánticos al explotar la hardness de problemas como el Shortest Vector Problem (SVP) en espacios de alta dimensión. Google, a través de su Quantum AI lab, contribuye a estos esfuerzos, integrando simulaciones cuánticas para benchmarkear la seguridad de PQC contra variantes híbridas.

Además, en inteligencia artificial, la computación cuántica podría optimizar modelos de machine learning. Por ejemplo, el Quantum Approximate Optimization Algorithm (QAOA) resuelve problemas de particionamiento gráfico NP-hard, útiles en clustering y recomendación. El estudio de Google sugiere que simulaciones de Hubbard podrían modelar dinámicas neuronales en redes cuánticas, potencialmente superando las limitaciones de los transformers clásicos en procesamiento de datos multimodales.

Aplicaciones en Blockchain y Tecnologías Emergentes

En el ámbito de blockchain, la computación cuántica plantea tanto riesgos como oportunidades. La vulnerabilidad de firmas ECDSA en Bitcoin y Ethereum a ataques de Shor podría comprometer wallets si se logra un ordenador cuántico con 1-2 millones de qubits lógicos. Sin embargo, el avance de Google acelera la investigación en blockchains cuánticas resistentes, como Quantum Key Distribution (QKD) integrada en protocolos como BB84 para distribución segura de claves.

Proyectos como Quantum Resistant Ledger (QRL) ya incorporan firmas basadas en XMSS (eXtended Merkle Signature Scheme), un esquema hash-based estandarizado por IETF en RFC 8391. La simulación eficiente de modelos cuánticos por Google podría validar la seguridad de estos esquemas mediante ataques simulados, estimando el costo en qubits para romperlos. En términos operativos, esto implica migraciones graduales en redes blockchain, con hard forks para adoptar PQC, similar a la transición de SHA-1 a SHA-256.

Otras tecnologías emergentes beneficiadas incluyen la simulación de materiales para baterías de estado sólido. El modelo de Hubbard es análogo a interacciones en litio-ion, permitiendo predecir propiedades como la conductividad iónica sin experimentos físicos costosos. Empresas como IBM Quantum utilizan plataformas similares para drug discovery, modelando plegamientos proteicos con Variational Quantum Eigensolver (VQE), un algoritmo que minimiza la energía esperada <ψ|H|ψ> sobre ansatze parametrizados.

Riesgos Operativos y Consideraciones Regulatorias

A pesar de los beneficios, la adopción de computación cuántica introduce riesgos operativos. La decoherencia, causada por interacciones ambientales, limita la coherencia temporal a microsegundos, requiriendo enfriamiento criogénico y aislamiento magnético. En entornos enterprise, la integración híbrida cuántico-clásico demanda APIs estandarizadas como OpenQASM 3.0, que define un lenguaje ensamblador para circuitos cuánticos.

Regulatoriamente, agencias como la Comisión Europea y la NSA exigen evaluaciones de impacto cuántico en infraestructuras críticas. El NIST SP 800-208 detalla guías para migración a PQC, enfatizando pruebas de side-channel y fault-injection. En Latinoamérica, iniciativas como el Quantum Technology Roadmap de Brasil buscan fomentar colaboraciones, pero la brecha en infraestructura cuántica persiste, con solo unos pocos centros de investigación en México y Argentina equipados para experimentos básicos.

Los beneficios superan los riesgos en dominios como la optimización logística. Algoritmos cuánticos como Grover’s search ofrecen speedup cuadrático para búsquedas no estructuradas, aplicables en supply chain blockchain para verificar transacciones en bases de datos masivas. Google estima que, con 1000 qubits lógicos, problemas de enrutamiento en grafos de 10^6 nodos se resolverían en horas, versus días en solvers clásicos como Gurobi o CPLEX.

Avances en Hardware y Software para Escalabilidad

El hardware de Willow incorpora resonadores de microondas para readout no destructivo, reduciendo el crosstalk entre qubits adyacentes mediante apantallamiento electrostático. En software, el framework Cirq de Google, basado en Python, facilita la compilación de circuitos de alto nivel a pulsos de bajo nivel, integrándose con TensorFlow Quantum para workflows de ML híbridos.

Comparado con competidores, el sistema de Google supera al Eagle de IBM (127 qubits) en fidelidad de entrelazamiento, gracias a un factor de volumen reducido en los chips superconductorios. Futuras iteraciones apuntan a qubits topológicos basados en anyons, que prometen corrección de errores intrínseca vía braiding, alineados con propuestas de Microsoft en Azure Quantum.

En términos de benchmarks, el experimento midió la Quantum Volume (QV), un métrica holística que considera ancho de banda, profundidad de circuito y conectividad. Willow alcanzó QV > 2^20, un orden de magnitud por encima de Sycamore, validando la ruta hacia la tolerancia a fallos en 2030, según roadmaps de la industria.

Conclusión: Hacia un Futuro Cuántico Integrado

El logro de Google en demostrar una ventaja cuántica tangible, resolviendo en dos horas simulaciones que demandarían tres años a supercomputadoras clásicas, marca un punto de inflexión en la computación cuántica. Esta capacidad no solo acelera descubrimientos en física y química, sino que redefine paradigmas en ciberseguridad, IA y blockchain, impulsando la adopción de estándares post-cuánticos y arquitecturas híbridas. Aunque desafíos como la escalabilidad y el ruido persisten, los avances en hardware y algoritmos pavimentan el camino para aplicaciones prácticas en la próxima década, transformando industrias enteras con eficiencia y precisión inéditas.

Para más información, visita la Fuente original.