La Expansión de la Inteligencia Artificial hacia el Espacio: La Apuesta de Nvidia por Servidores Orbitantes para Resolver la Crisis Energética

La inteligencia artificial (IA) ha transformado radicalmente múltiples sectores de la economía global, desde la optimización de procesos industriales hasta el avance en la investigación científica. Sin embargo, su crecimiento exponencial conlleva un desafío crítico: el consumo masivo de energía. Los centros de datos que soportan modelos de IA avanzados, como los grandes modelos de lenguaje o sistemas de aprendizaje profundo, demandan cantidades colosales de electricidad, superando a menudo la capacidad de las infraestructuras terrestres existentes. En este contexto, Nvidia, líder indiscutible en el desarrollo de unidades de procesamiento gráfico (GPU) especializadas para IA, ha propuesto una solución innovadora: desplegar servidores en el espacio exterior. Esta iniciativa busca aprovechar la energía solar ilimitada disponible en órbita para alimentar la computación de IA, mitigando así las limitaciones energéticas en la Tierra. Este artículo analiza en profundidad los aspectos técnicos de esta propuesta, sus implicaciones operativas y los desafíos inherentes a su implementación.

El Consumo Energético de la IA: Una Perspectiva Técnica

El entrenamiento y el despliegue de modelos de IA requieren recursos computacionales intensivos. Por ejemplo, el entrenamiento de un modelo como GPT-4, basado en arquitecturas de transformers, puede consumir energía equivalente al consumo anual de miles de hogares. Según estimaciones de la Agencia Internacional de Energía (AIE), los centros de datos globales consumieron alrededor de 460 teravatios-hora (TWh) en 2022, un valor que se proyecta duplicarse para 2026 debido al auge de la IA generativa. Las GPU de Nvidia, como las series H100 o A100, son el núcleo de estos sistemas, con un consumo por chip que alcanza los 700 vatios (W) en operación máxima.

Desde un punto de vista técnico, este consumo se deriva de varios factores. Primero, los algoritmos de aprendizaje profundo involucran operaciones matriciales masivas, como multiplicaciones de matrices en redes neuronales convolucionales (CNN) o recurrentes (RNN). Cada iteración de entrenamiento requiere miles de millones de cálculos flotantes por segundo (FLOPS), lo que genera calor significativo y demanda sistemas de enfriamiento avanzados. Segundo, la escalabilidad horizontal en clústeres de GPU, conectados mediante protocolos como NVLink o InfiniBand, amplifica el requerimiento energético. Un clúster típico para IA puede integrar cientos de nodos, cada uno con múltiples GPU, resultando en demandas de potencia que superan los megavatios (MW).

En términos de eficiencia, métricas como los FLOPS por vatio son cruciales. Las GPU modernas de Nvidia logran hasta 4 petaFLOPS en precisión FP8 por H100, pero el overhead de memoria y interconexiones reduce la eficiencia global. Además, la dependencia de fuentes de energía no renovables en muchas regiones agrava el impacto ambiental, contribuyendo a emisiones de CO2 equivalentes a las de la aviación comercial. Esta presión energética ha llevado a restricciones regulatorias en países como la Unión Europea, donde directivas como el Green Deal exigen reducciones en el consumo de centros de datos para 2030.

Limitaciones de las Infraestructuras Terrestres para la IA

La Tierra enfrenta barreras estructurales para sostener el crecimiento de la IA. La red eléctrica global, compuesta por generadores, líneas de transmisión y subestaciones, opera cerca de su capacidad máxima en muchas áreas urbanas. En Estados Unidos, por instancia, el despliegue de nuevos centros de datos ha sido retrasado por la falta de capacidad en la red, como reportado por la Comisión Federal de Regulación de Energía (FERC). En regiones en desarrollo, como América Latina, la intermitencia de fuentes renovables como la hidroeléctrica complica aún más la situación.

Técnicamente, los centros de datos terrestres dependen de sistemas de respaldo como baterías de ion-litio o generadores diésel, que introducen ineficiencias. El coeficiente de rendimiento de energía (PUE, por sus siglas en inglés) en instalaciones modernas oscila entre 1.1 y 1.5, indicando que por cada vatio consumido en computación, se desperdician entre 0.1 y 0.5 vatios en enfriamiento y distribución. En climas cálidos, como en México o Brasil, el enfriamiento por evaporación o aire aumenta este overhead.

Otra limitación radica en la disponibilidad de silicio y materiales raros para fabricar GPU. La cadena de suministro global, afectada por tensiones geopolíticas, como las restricciones de exportación de China en tierras raras, podría escasear en los próximos años. Además, el ruido y el calor generado por estos centros impactan comunidades locales, generando oposiciones regulatorias y sociales. En resumen, las infraestructuras terrestres no escalan linealmente con la demanda de IA, proyectada en un crecimiento anual del 40% según informes de McKinsey.

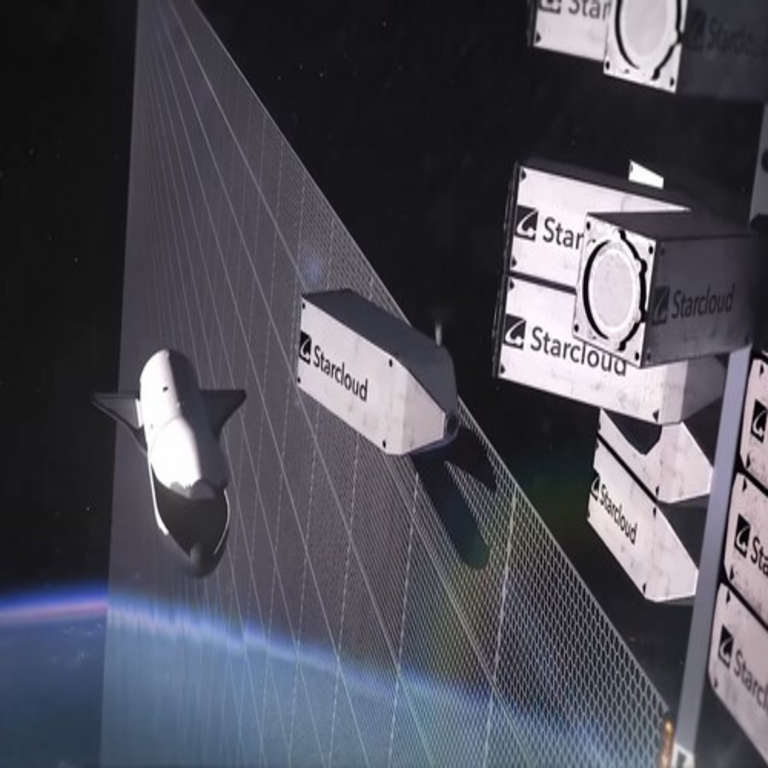

La Propuesta de Nvidia: Servidores de IA en Órbita

Nvidia, en colaboración con empresas espaciales como SpaceX y Orbital Insight, ha explorado la idea de satélites equipados con servidores de IA en órbita baja terrestre (LEO, por sus siglas en inglés), a altitudes de 300-600 kilómetros. Esta aproximación aprovecha la exposición constante al sol, eliminando las variaciones diurnas y estacionales que afectan los paneles solares terrestres. Un satélite en LEO recibe hasta 1.366 vatios por metro cuadrado de radiación solar constante, comparado con un promedio de 200-300 W/m² en la superficie terrestre.

Técnicamente, estos servidores orbitantes integrarían GPU compactas, como variantes de las Tegra o Jetson series de Nvidia, optimizadas para entornos de baja gravedad y radiación. La arquitectura propuesta incluiría paneles solares de células fotovoltaicas de arseniuro de galio (GaAs), con eficiencias superiores al 30%, conectados a baterías de estado sólido para periodos de eclipse orbital (aproximadamente 30 minutos por órbita de 90 minutos). La potencia generada podría alcanzar los 10-50 kW por satélite, suficiente para procesar tareas de IA distribuidas, como inferencia en modelos de visión por computadora para monitoreo satelital.

La comunicación se realizaría mediante enlaces láser ópticos, como los Starlink de SpaceX, con tasas de datos de hasta 100 Gbps y latencias inferiores a 50 milisegundos para aplicaciones en tiempo real. Esto permitiría federar computación entre constelaciones de satélites, formando una “nube espacial” para IA. Nvidia ha patentado conceptos como el “Orbital AI Fabric”, que utiliza redes neuronales distribuidas para procesar datos in situ, reduciendo la necesidad de transmitir terabytes de datos crudos a la Tierra.

Tecnologías Clave Involucradas en la Computación Espacial de IA

La implementación de servidores de IA en el espacio requiere avances en múltiples disciplinas. En primer lugar, los procesadores deben resistir la radiación cósmica y solar, que causa errores de bits (SEU, Single Event Upsets) en memorias DRAM y SRAM. Soluciones incluyen memorias con corrección de errores (ECC) y arquitecturas de redundancia, como las usadas en misiones de la NASA, que reducen tasas de error a menos de 10^-9 por bit-hora.

El enfriamiento representa otro reto. En el vacío espacial, la disipación de calor se logra mediante radiadores pasivos que emiten infrarrojos, siguiendo la ley de Stefan-Boltzmann. Un GPU de 700 W requeriría una superficie radiadora de aproximadamente 1 m² a 300 K, pero fluctuaciones térmicas orbitales demandan sistemas activos con fluidos dieléctricos o heat pipes. Nvidia investiga materiales como grafeno para mejorar la conductividad térmica en estos entornos.

En cuanto a software, frameworks como CUDA de Nvidia se adaptarían para computación distribuida en órbita, integrando bibliotecas de IA como TensorRT para optimización de inferencia. Protocolos de blockchain podrían usarse para verificar integridad de datos en entornos no confiables, asegurando trazabilidad en cadenas de suministro espaciales. Además, estándares como el SpaceWire de la ESA facilitarían interconexiones entre módulos satelitales.

- Paneles solares avanzados: Eficiencia del 40% con perovskitas híbridas, permitiendo despliegues compactos.

- Enlaces de comunicación: Láseres de fibra óptica para baja latencia, superando limitaciones de RF en bandas Ka.

- Sistemas de IA edge: Procesamiento local de datos satelitales, como imágenes hyperspectrales para análisis ambiental.

- Gestión de energía: Algoritmos de IA para optimizar carga y descarga en baterías, minimizando degradación.

Estas tecnologías no solo habilitan la computación de IA espacial, sino que también abren puertas a aplicaciones como predicción climática en tiempo real o detección de anomalías en redes globales de ciberseguridad.

Desafíos Técnicos y Operativos de los Servidores Orbitantes

A pesar de sus promesas, la propuesta enfrenta obstáculos significativos. La latencia de comunicación, aunque minimizada por LEO, sigue siendo superior a la fibra óptica terrestre (alrededor de 20-100 ms vs. 1 ms). Para tareas de IA que requieren iteraciones rápidas, como entrenamiento en tiempo real, esto implica algoritmos tolerantes a latencia, como aprendizaje federado con actualizaciones asincrónicas.

La durabilidad es crítica: la vida útil de un satélite se limita a 5-10 años debido a degradación por radiación y micrometeoritos. Costos de lanzamiento, estimados en 1.000-2.000 dólares por kg con cohetes reutilizables como Falcon 9, hacen que un clúster de 100 kg cueste millones. Además, la gestión orbital requiere evitación de colisiones, regulada por la Oficina de las Naciones Unidas para el Espacio Exterior (UNOOSA), con protocolos como el de rastreo de objetos en el catálogo de NORAD.

Desde una perspectiva de ciberseguridad, los servidores espaciales son vulnerables a ataques como jamming de señales o inyección de fallos inducidos por láser. Medidas de protección incluyen cifrado cuántico-resistente y firewalls basados en IA para detección de anomalías. Regulatoriamente, tratados como el de Outer Space de 1967 prohíben armas nucleares en órbita, pero no abordan explícitamente la computación civil, potencialmente generando disputas sobre soberanía de datos.

Otros riesgos incluyen la contaminación lumínica para telescopios terrestres y el impacto en la ionosfera por emisiones electromagnéticas. Para mitigarlos, diseños con apagonado selectivo y órbitas polares son esenciales.

Implicaciones Operativas, Regulatorias y Económicas

Operativamente, los servidores orbitantes podrían descentralizar la computación de IA, reduciendo dependencia de hubs terrestres como Virginia en EE.UU. o Frankfurt en Europa. Beneficios incluyen escalabilidad ilimitada mediante constelaciones como Starlink, con miles de satélites, y procesamiento de datos globales in situ, como monitoreo de deforestación en la Amazonia mediante IA en satélites.

En términos regulatorios, agencias como la FCC en EE.UU. y la ANATEL en Brasil deben actualizar espectros de frecuencia para enlaces espaciales. La Unión Internacional de Telecomunicaciones (UIT) coordina asignaciones, pero el auge de IA espacial podría saturar bandas. Implicancias éticas surgen en privacidad: datos procesados en órbita podrían usarse para vigilancia masiva, requiriendo marcos como el GDPR adaptado a entornos extraterrestres.

Económicamente, la inversión inicial es alta, pero el retorno proviene de eficiencia energética. Un estudio de la NASA estima que la computación espacial reduce costos operativos en un 50% a largo plazo, al eliminar necesidades de enfriamiento terrestre. Para América Latina, esto representa oportunidades en soberanía digital, permitiendo procesar datos locales sin exportarlos, alineado con iniciativas como el Marco Digital de la CEPAL.

Riesgos incluyen desigualdades: países sin acceso a lanzamientos espaciales podrían quedar rezagados en IA. Beneficios, sin embargo, abarcan avances en sostenibilidad, con IA espacial optimizando redes eléctricas globales para transiciones renovables.

Conclusión: Hacia un Futuro Híbrido de IA Terrestre-Espacial

La apuesta de Nvidia por servidores de IA en el espacio marca un paradigma en la evolución de la computación, abordando la crisis energética mediante innovación técnica audaz. Al integrar avances en fotónica, materiales resistentes y algoritmos distribuidos, esta aproximación no solo resuelve limitaciones actuales, sino que expande las fronteras de la IA hacia aplicaciones globales y sostenibles. Aunque desafíos como la latencia y la regulación persisten, el potencial para una computación eficiente y ecológica es innegable. En un mundo donde la IA impulsa el progreso, el espacio emerge como el próximo frontera para su despliegue óptimo, prometiendo un equilibrio entre innovación y responsabilidad ambiental.

Para más información, visita la fuente original.