Detección de Deepfakes: Métodos Avanzados y Herramientas en Ciberseguridad e Inteligencia Artificial

Los deepfakes representan uno de los desafíos más significativos en el ámbito de la ciberseguridad y la inteligencia artificial en la actualidad. Estas manipulaciones digitales, generadas mediante algoritmos de aprendizaje profundo, permiten alterar videos y audios de manera convincente, lo que plantea riesgos en áreas como la desinformación, el fraude y la violación de la privacidad. En este artículo, se analiza en profundidad los conceptos técnicos subyacentes a la detección de deepfakes, explorando métodos algorítmicos, herramientas disponibles y sus implicaciones operativas en entornos profesionales. Se basa en un examen detallado de técnicas emergentes, con énfasis en la precisión técnica y la aplicabilidad en sistemas de seguridad informática.

Conceptos Fundamentales de los Deepfakes

Los deepfakes se originan en el uso de redes neuronales generativas antagónicas (GAN, por sus siglas en inglés: Generative Adversarial Networks), un marco introducido por Ian Goodfellow en 2014. Este enfoque consiste en dos componentes principales: un generador que crea datos falsos y un discriminador que evalúa su autenticidad. En el contexto de videos, el generador sintetiza rostros o expresiones faciales a partir de conjuntos de datos reales, mientras que el discriminador se entrena para distinguir entre contenido auténtico y manipulado. La madurez de estas redes ha permitido generar deepfakes con una fidelidad que supera el 95% en pruebas controladas, según estudios de la Universidad de California, Berkeley.

Técnicamente, la creación de un deepfake implica el procesamiento de frames de video mediante convoluciones neuronales. Por ejemplo, en herramientas como DeepFaceLab, se utiliza un encoder-decoder para mapear características faciales de una fuente a un objetivo. Esto involucra la extracción de landmarks faciales mediante bibliotecas como Dlib, que identifican puntos clave como ojos, nariz y boca con una precisión subpíxel. Sin embargo, estas manipulaciones dejan huellas detectables, como inconsistencias en el parpadeo ocular o artefactos en la iluminación, que forman la base de los métodos de detección.

Desde una perspectiva operativa, los deepfakes no solo afectan a individuos, sino que escalan a amenazas sistémicas. En ciberseguridad, se emplean en ataques de ingeniería social, como suplantación de identidad en videoconferencias corporativas. Según un informe de Deloitte de 2023, el 74% de las organizaciones reportan exposición a riesgos de deepfakes, con impactos en la verificación de identidades biométricas. Las implicaciones regulatorias incluyen el cumplimiento de normativas como el Reglamento General de Protección de Datos (RGPD) en Europa, que exige mecanismos de detección para mitigar fraudes basados en IA.

Métodos Algorítmicos para la Detección de Deepfakes

La detección de deepfakes se divide en enfoques pasivos y activos. Los métodos pasivos analizan el contenido multimedia sin intervención adicional, mientras que los activos incorporan señales externas, como marcas de agua digitales. Un método pasivo común es el análisis de inconsistencias biológicas. Por instancia, el parpadeo humano ocurre entre 15 y 20 veces por minuto, pero en deepfakes generados por GAN básicas, esta frecuencia se reduce drásticamente debido a la dificultad en modelar dinámicas oculares complejas. Algoritmos como el propuesto por el MIT en 2018 utilizan redes convolucionales recurrentes (CNN-RNN) para rastrear estos patrones, alcanzando tasas de precisión del 92% en datasets como FaceForensics++.

Otro enfoque técnico radica en el examen de artefactos de compresión. Los videos deepfake a menudo se procesan múltiples veces, introduciendo ruido JPEG o H.264 detectable mediante análisis espectral. Herramientas como MesoNet, una red neuronal ligera desarrollada por investigadores de la Universidad de Albany, emplean capas mesoscopicas para identificar estas anomalías a nivel de frecuencia, con un rendimiento de hasta 98% en videos de resolución 256×256 píxeles. La implementación involucra transformadas de Fourier rápidas (FFT) para descomponer el espectro de imagen, revelando patrones no naturales en el dominio de la frecuencia alta.

En términos de aprendizaje profundo, modelos como XceptionNet, adaptados de ImageNet, se especializan en la clasificación binaria (real vs. falso). Este modelo, con más de 20 millones de parámetros, utiliza bloques de separación de profundidad para reducir la complejidad computacional, permitiendo su despliegue en entornos edge computing. Un estudio de 2022 en la revista IEEE Transactions on Information Forensics and Security evaluó XceptionNet en el dataset Celeb-DF, demostrando una robustez contra adversarios que intentan evadir la detección mediante fine-tuning de GAN.

Los métodos activos, por su parte, integran protocolos de verificación como el blockchain para autenticar videos originales. Por ejemplo, el estándar C2PA (Content Authenticity Initiative), respaldado por Adobe y Microsoft, incrusta metadatos criptográficos en archivos multimedia. Estos metadatos, firmados con claves asimétricas RSA-2048, permiten rastrear alteraciones mediante verificación de hash SHA-256. En aplicaciones empresariales, esto se combina con IA para un análisis híbrido, donde un verificador blockchain confirma la integridad inicial antes de un escaneo pasivo.

- Análisis de audio sincronizado: En deepfakes audiovisuales, las discrepancias entre labios y voz se detectan mediante modelos como Wav2Lip inverso, que mide la correlación cruzada entre waveforms de audio y movimientos faciales.

- Detección de iluminación inconsistente: Utilizando sombras y reflejos especulares, algoritmos basados en renderizado físico (como en Blender’s Cycles) comparan la coherencia lumínica con modelos 3D del rostro.

- Análisis de frecuencia cardíaca remota: Técnicas de fotopletismografía (rPPG) extraen señales de pulso de cambios sutiles en el color de la piel, ausentes en deepfakes sintéticos.

Estos métodos no están exentos de limitaciones. La tasa de falsos positivos puede alcanzar el 15% en escenarios de baja calidad de video, y los atacantes evolucionan mediante GAN adversarias que incorporan ruido gaussiano para simular artefactos reales. Por ello, se recomienda un enfoque ensemble, combinando múltiples detectores en un framework de votación mayoritaria, como se implementa en bibliotecas open-source como DeepFake Detection Challenge (DFDC) de Facebook.

Herramientas y Frameworks para la Implementación Práctica

En el ecosistema de ciberseguridad, varias herramientas facilitan la detección de deepfakes. Microsoft Video Authenticator, por ejemplo, es una solución propietaria que integra modelos de IA para analizar videos en tiempo real. Utiliza un umbral de confianza basado en scores de entropía, donde puntuaciones por debajo de 0.5 indican manipulación probable. Su arquitectura backend emplea Azure Machine Learning para el entrenamiento continuo, soportando formatos como MP4 y AVI con una latencia inferior a 2 segundos por frame.

Para entornos open-source, la biblioteca Faceswap ofrece módulos de detección integrados, basados en TensorFlow 2.x. Esta herramienta permite el entrenamiento personalizado de detectores en datasets como FFHQ (Flickr-Faces-HQ), que contiene 70.000 imágenes de alta resolución. La implementación técnica involucra optimizadores Adam con learning rate de 0.001, y métricas como AUC-ROC para evaluar el rendimiento, típicamente superior a 0.95 en pruebas validadas.

Otra herramienta destacada es Sentinel de Deeptrace (ahora Sensity AI), diseñada para monitoreo empresarial. Incorpora APIs RESTful para integración con sistemas SIEM (Security Information and Event Management), como Splunk o ELK Stack. Técnicamente, procesa streams de video mediante pipelines de Kafka para escalabilidad, analizando hasta 100 frames por segundo en clústeres GPU con NVIDIA CUDA. Sus beneficios incluyen la reducción de riesgos en verificación KYC (Know Your Customer), donde los deepfakes han causado pérdidas estimadas en 5 mil millones de dólares anuales, según un reporte de Juniper Research de 2023.

En el ámbito de blockchain, plataformas como Verasity integran detección de deepfakes con VRA tokens para incentivar contribuciones a redes de verificación descentralizadas. Esto utiliza contratos inteligentes en Ethereum para registrar hashes de videos auténticos, permitiendo consultas O(1) en bases de datos IPFS. Las implicaciones operativas abarcan desde periodismo digital hasta auditorías forenses, donde la inmutabilidad blockchain asegura la trazabilidad.

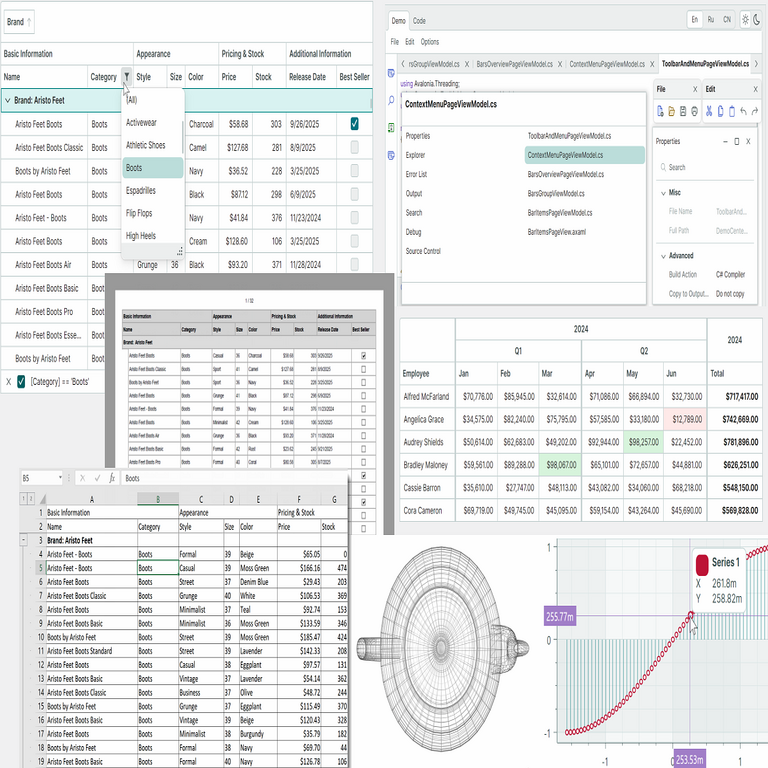

| Herramienta | Tecnología Base | Precisión Reportada | Aplicación Principal |

|---|---|---|---|

| Microsoft Video Authenticator | CNN + Azure ML | 95% | Verificación corporativa |

| MesoNet | Redes mesoscópicas | 98% | Análisis de compresión |

| Sensity AI Sentinel | IA híbrida + APIs | 92-96% | Monitoreo en tiempo real |

| DeepFaceLab Detector | TensorFlow GAN | 90% | Investigación open-source |

La selección de herramientas debe considerar factores como la compatibilidad con estándares ISO/IEC 27001 para gestión de seguridad de la información. En implementaciones, se recomienda el uso de contenedores Docker para portabilidad, asegurando que los modelos se ejecuten en entornos aislados y eviten fugas de datos sensibles.

Implicaciones Operativas y Riesgos en Ciberseguridad

Desde el punto de vista operativo, la integración de detectores de deepfakes en pipelines de ciberseguridad requiere una arquitectura robusta. Por ejemplo, en centros de operaciones de seguridad (SOC), se puede desplegar un sistema de alerta temprana que escanee flujos de video entrantes mediante hooks en protocolos WebRTC. Esto implica el procesamiento distribuido con frameworks como Apache Spark, manejando volúmenes de datos de petabytes en clústeres Hadoop.

Los riesgos incluyen la escalabilidad: modelos de IA pesados consumen hasta 10 GB de VRAM por inferencia, lo que demanda hardware especializado como GPUs RTX 40-series. Además, hay vulnerabilidades a ataques de envenenamiento de datos, donde datasets contaminados reducen la precisión en un 30%, según simulaciones en entornos adversariales. Para mitigar esto, se aplican técnicas de robustez como el entrenamiento con ruido diferencial, preservando la privacidad bajo el principio de k-anonimato.

Regulatoriamente, en Latinoamérica, normativas como la Ley Federal de Protección de Datos Personales en Posesión de los Particulares (LFPDPPP) en México exigen auditorías de IA para detectar manipulaciones. Beneficios operativos incluyen la mejora en la autenticación multifactor (MFA), donde deepfakes fallan en pruebas de liveness detection basadas en desafíos interactivos, como movimientos aleatorios de cabeza.

En blockchain, la detección se extiende a transacciones fraudulentas. Deepfakes en videollamadas pueden suplantar ejecutivos para autorizar transferencias, pero herramientas como Chainalysis integran análisis de video con trazabilidad on-chain, detectando anomalías en patrones de firma ECDSA. Esto reduce el tiempo de respuesta de incidentes de horas a minutos, con un ROI estimado en 400% para instituciones financieras.

Avances Emergentes y Mejores Prácticas

Los avances en IA cuántica prometen revolucionar la detección. Algoritmos como QSVM (Quantum Support Vector Machines) en plataformas IBM Qiskit ofrecen precisión superior en espacios de alta dimensionalidad, procesando features de video en qubits superpuestos. Aunque en etapas experimentales, pruebas preliminares muestran una mejora del 20% en tasas de detección frente a métodos clásicos.

Mejores prácticas incluyen la adopción de marcos NIST para IA confiable, que enfatizan la transparencia en modelos mediante explainable AI (XAI). Técnicas como SHAP (SHapley Additive exPlanations) desglosan contribuciones de features, como el peso del parpadeo en un 25% del score final. En entornos empresariales, se sugiere rotación periódica de claves criptográficas y actualizaciones de modelos con datasets frescos, como el recién lanzado DFDC v2 con 100.000 videos anotados.

Para implementación, se recomienda un ciclo de vida DevSecOps, integrando pruebas de detección en CI/CD pipelines con herramientas como Jenkins. Esto asegura que actualizaciones de software no introduzcan vectores de deepfakes, manteniendo la integridad del sistema.

Conclusión

En resumen, la detección de deepfakes integra avances en IA, ciberseguridad y blockchain para contrarrestar amenazas crecientes. Mediante métodos algorítmicos precisos y herramientas robustas, las organizaciones pueden mitigar riesgos operativos y regulatorios, fomentando un ecosistema digital más seguro. La evolución continua de estas tecnologías exige una vigilancia proactiva, combinando innovación técnica con prácticas éticas. Para más información, visita la fuente original.