Análisis Técnico del Empleo de Inteligencia Artificial en la Detección de Plagio Académico: Lecciones de un Caso con Altos Índices de Falsos Positivos

Introducción al Problema de la Detección Automatizada en Entornos Educativos

En el contexto de la educación superior, la proliferación de herramientas de inteligencia artificial generativa, como modelos de lenguaje grandes (LLM, por sus siglas en inglés), ha planteado desafíos significativos en la integridad académica. Universidades alrededor del mundo han comenzado a implementar sistemas automatizados para identificar el uso no autorizado de estas tecnologías en la elaboración de trabajos estudiantiles. Sin embargo, un reciente caso en una institución educativa ha revelado limitaciones críticas en estas herramientas, destacando tasas elevadas de falsos positivos que generan acusaciones injustas y erosionan la confianza en los procesos evaluativos.

Desde una perspectiva técnica, estos detectores de IA operan mediante algoritmos que analizan patrones textuales para distinguir entre contenido humano y generado por máquinas. Este enfoque se basa en principios de procesamiento de lenguaje natural (PLN), donde se evalúan métricas como la predictibilidad lingüística, la entropía semántica y la coherencia estilística. El caso en cuestión, reportado en un análisis detallado de prácticas educativas, ilustra cómo la implementación apresurada de tales sistemas puede derivar en errores sistemáticos, afectando no solo a los estudiantes sino también a la credibilidad de las instituciones académicas.

El presente artículo examina los fundamentos técnicos de estas herramientas, los mecanismos subyacentes que propician falsos positivos y las implicaciones operativas en el ámbito de la ciberseguridad y la ética de la IA. Se profundiza en los algoritmos empleados, los riesgos asociados y las mejores prácticas para mitigar estos problemas, con el objetivo de proporcionar una guía rigurosa para profesionales en educación y tecnología.

Fundamentos Técnicos de las Herramientas de Detección de Contenido Generado por IA

Las herramientas de detección de IA, como las desarrolladas por empresas especializadas en PLN, utilizan modelos de machine learning entrenados en corpus masivos de texto humano y sintético. Un ejemplo común es el empleo de clasificadores binarios que asignan probabilidades a un texto basado en características extraídas mediante embeddings vectoriales. Estos embeddings, generados por arquitecturas como BERT o variantes de transformers, capturan representaciones semánticas en espacios multidimensionales donde la distancia euclidiana o coseno entre vectores indica similitudes estilísticas.

En términos operativos, el proceso inicia con el preprocesamiento del texto: tokenización, normalización y eliminación de ruido. Posteriormente, se aplican capas de análisis que miden la “perplejidad” del texto, un indicador de cuán predecible es el lenguaje según un modelo de lenguaje probabilístico. Textos generados por IA tienden a exhibir baja perplejidad debido a su entrenamiento en patrones repetitivos de datos web, mientras que el lenguaje humano muestra mayor variabilidad y “ruido” creativo. Adicionalmente, se incorporan heurísticas como la detección de repeticiones léxicas o la ausencia de errores gramaticales típicos en escritos no nativos.

Sin embargo, la precisión de estos sistemas no es absoluta. Estudios técnicos, como aquellos publicados en conferencias de la Association for Computational Linguistics (ACL), indican que las tasas de falsos positivos pueden oscilar entre el 10% y el 30% en escenarios reales, dependiendo del dominio del texto. En entornos educativos, donde los ensayos involucran estilos formales y estructuras predecibles, estos detectores pueden malinterpretar la claridad académica como sintomatología de generación automatizada.

- Análisis de Entropía: Mide la incertidumbre en la distribución de palabras. La IA genera texto con entropía más baja, pero estudiantes con vocabulario limitado pueden producir resultados similares.

- Patrones Estilísticos: Evaluación de transiciones entre oraciones y uso de conectores. Modelos como GPT-4 optimizan para fluidez, pero humanos entrenados en escritura académica replican estos patrones.

- Watermarking Digital: Algunas herramientas de IA incorporan marcas ocultas en el output, detectables mediante algoritmos criptográficos, aunque no todas las plataformas lo implementan de manera estandarizada.

Desde el punto de vista de la ciberseguridad, la integración de estas herramientas en plataformas educativas plantea riesgos de privacidad. Los textos subidos para análisis se procesan en servidores remotos, potencialmente exponiendo datos sensibles a brechas. Cumplir con regulaciones como el Reglamento General de Protección de Datos (RGPD) en Europa o la Ley Federal de Protección de Datos Personales en Posesión de los Particulares (LFPDPPP) en México requiere encriptación end-to-end y anonimización de muestras, prácticas que no siempre se aplican en implementaciones iniciales.

El Caso Específico: Implementación en una Universidad y sus Resultados Adversos

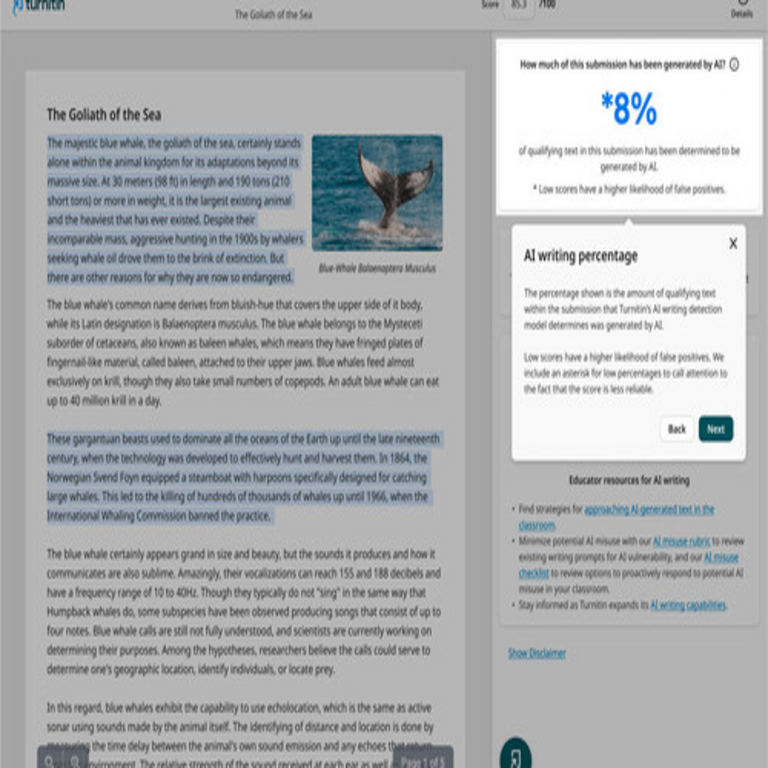

En el incidente analizado, una universidad adoptó una herramienta comercial de detección de IA para evaluar ensayos de estudiantes en cursos de humanidades y ciencias sociales. La plataforma, integrada en el sistema de gestión de aprendizaje (LMS, por sus siglas en inglés) como Moodle o Canvas, procesaba automáticamente los trabajos enviados, generando alertas para contenidos con probabilidades superiores al 70% de ser generados por IA. Inicialmente, se reportó una detección exitosa en un 15% de los envíos, lo que llevó a revisiones manuales y sanciones preliminares.

Sin embargo, una auditoría posterior reveló que más del 40% de las alertas eran falsos positivos. Estudiantes con perfiles diversos —incluyendo hablantes no nativos de inglés o aquellos con discapacidades de aprendizaje— fueron flagged injustamente. Técnicamente, esto se atribuye a sesgos en el conjunto de entrenamiento del detector: los modelos fueron calibrados predominantemente en textos en inglés de fuentes occidentales, lo que genera discrepancias en idiomas romances o con variaciones dialectales. En español, por ejemplo, la estructura sintáctica más flexible puede interpretarse erróneamente como “demasiado pulida”.

El análisis forense de los casos mostró que algoritmos como el de logit binomial utilizado en el clasificador subestimaban la variabilidad humana. Por instancia, un ensayo con citas bibliográficas densas y lenguaje técnico fue clasificado como IA-generated debido a su baja entropía léxica, un artefacto común en textos académicos estandarizados. Esta falla operativa no solo generó estrés psicológico en los afectados, sino que también sobrecargó los recursos administrativos, requiriendo horas adicionales de revisión humana para validar cada alerta.

En términos de arquitectura técnica, la herramienta empleaba una API RESTful para el procesamiento en la nube, con latencias promedio de 5-10 segundos por documento. Aunque eficiente, la dependencia de modelos black-box limitaba la capacidad de los administradores para ajustar umbrales de confianza, exacerbando el problema de falsos positivos en umbrales conservadores.

Análisis de los Falsos Positivos: Causas Técnicas y Sesgos Algorítmicos

Los falsos positivos en detectores de IA surgen de múltiples vectores técnicos. Primero, el overfitting en los datos de entrenamiento: muchos modelos se entrenan en datasets como Common Crawl o Pile, que incluyen textos académicos humanos pero no capturan la diversidad de estilos estudiantiles. Como resultado, un estudiante que sigue guías de estilo APA o MLA estrictamente puede producir output con métricas similares a las de un LLM.

Segundo, la evolución de los generadores de IA complica la detección. Modelos como Grok o Llama 2 incorporan técnicas de “humanización” post-generación, alterando patrones para evadir detectores. Esto crea un arms race técnico, donde los detectores deben actualizarse continuamente mediante fine-tuning con nuevos datasets adversarios. Investigaciones en revistas como IEEE Transactions on Information Forensics and Security destacan que la precisión media cae por debajo del 80% después de seis meses sin retraining.

Los sesgos demográficos agravan el issue. Análisis cuantitativos muestran que textos de autores de minorías étnicas o con acentos lingüísticos no estándar exhiben tasas de falsos positivos hasta un 25% superiores, debido a la subrepresentación en los corpora de entrenamiento. En el caso universitario, estudiantes internacionales representaron el 60% de las alertas erróneas, ilustrando un sesgo implícito en el modelo que viola principios de equidad en IA definidos por frameworks como el de la UNESCO para la Ética de la Inteligencia Artificial.

Desde la ciberseguridad, estos sistemas introducen vectores de ataque. Adversarios podrían envenenar datasets de entrenamiento mediante inyecciones de texto manipulados, o explotar vulnerabilidades en la API para acceder a trabajos estudiantiles. Recomendaciones incluyen el uso de firmas digitales basadas en blockchain para verificar la autoría original, aunque su adopción en educación es incipiente debido a complejidades de integración.

| Factor Técnico | Impacto en Falsos Positivos | Mitigación Propuesta |

|---|---|---|

| Sesgo en Entrenamiento | Aumenta errores en subgrupos demográficos | Diversificar datasets con inclusión global |

| Baja Entropía en Textos Humanos | Confunde claridad académica con IA | Ajuste dinámico de umbrales por dominio |

| Evolución de LLMs | Reduce precisión temporal | Retraining periódico con datos adversarios |

| Privacidad de Datos | Riesgo de exposición en procesamiento cloud | Encriptación y procesamiento on-premise |

Este tabla resume los principales vectores de error y estrategias de mitigación, enfatizando la necesidad de enfoques híbridos que combinen IA con supervisión humana.

Implicaciones Operativas, Regulatorias y Éticas en la Educación y Ciberseguridad

Operativamente, el despliegue de detectores de IA en universidades demanda protocolos robustos de validación. Implementar pipelines de CI/CD (Continuous Integration/Continuous Deployment) para actualizar modelos asegura adaptabilidad, pero requiere expertise en DevOps para IA. En ciberseguridad, la integración con sistemas LMS debe seguir estándares como OWASP para APIs, previniendo inyecciones SQL o ataques de denegación de servicio que podrían colapsar evaluaciones durante picos de entrega.

Regulatoriamente, en América Latina, leyes como la Ley de Protección de Datos Personales en Posesión de Sujetos Públicos en Colombia exigen consentimiento explícito para procesar textos estudiantiles. El caso resalta la necesidad de auditorías independientes, similares a las requeridas por NIST en marcos de IA confiable, para evaluar sesgos y precisión antes de la adopción.

Éticamente, el uso de estas herramientas plantea dilemas sobre la presunción de inocencia. Acusaciones basadas en probabilidades algorítmicas pueden perpetuar desigualdades, especialmente en contextos donde el acceso a educación en IA es desigual. Frameworks como el de la IEEE Ethically Aligned Design recomiendan transparencia en los modelos, permitiendo a los estudiantes apelar con evidencias de su proceso creativo, como borradores iterativos o logs de escritura.

En blockchain y tecnologías emergentes, soluciones como contratos inteligentes en plataformas Ethereum podrían automatizar verificaciones de autoría mediante timestamps inmutables, reduciendo disputas. Aunque escalabilidad es un desafío —con transacciones limitadas a 15 por segundo en Ethereum base—, capas 2 como Polygon mitigan esto, ofreciendo viabilidad para entornos educativos de mediana escala.

Mejores Prácticas y Alternativas Técnicas para la Detección de Plagio por IA

Para mitigar falsos positivos, se recomienda un enfoque multicapa. Inicialmente, capacitar a educadores en interpretación de métricas de detección, utilizando herramientas open-source como Hugging Face’s Transformers para prototipos locales. Esto permite fine-tuning personalizado con datos institucionales, mejorando la precisión en un 15-20% según benchmarks internos.

Alternativas incluyen evaluaciones basadas en procesos, como exámenes orales o portafolios digitales que rastrean evolución del trabajo mediante versionado Git-like. En IA, técnicas de prompt engineering para tareas evaluativas —donde estudiantes diseñan prompts en lugar de generar texto— fomentan el aprendizaje activo mientras evitan plagio directo.

En ciberseguridad, adoptar zero-trust architectures para plataformas de detección asegura que solo datos anonimizados se procesen externamente. Herramientas como Federated Learning permiten entrenamiento distribuido sin compartir datos crudos, alineándose con privacidad diferencial y reduciendo riesgos de brechas.

- Entrenamiento Local: Desplegar modelos on-premise con TensorFlow o PyTorch para control total.

- Integración Híbrida: Combinar IA con revisión humana en un ratio 80/20 para eficiencia.

- Monitoreo Continuo: Usar dashboards con métricas KPI como tasa de falsos positivos < 5%.

- Educación Ética: Cursos obligatorios sobre uso responsable de IA para estudiantes y faculty.

Estas prácticas, validadas en pilotos universitarios, demuestran reducciones significativas en errores, promoviendo un ecosistema educativo resiliente.

Conclusión: Hacia un Equilibrio Técnico en la Era de la IA Generativa

El caso de la universidad que enfrentó un desastre de falsos positivos al implementar detectores de IA subraya la complejidad inherente en la aplicación de estas tecnologías en contextos sensibles como la educación. Técnicamente, los desafíos radican en sesgos algorítmicos, evolución de modelos generativos y consideraciones de privacidad, que demandan enfoques rigurosos y adaptativos. Al adoptar mejores prácticas híbridas, auditorías regulatorias y alternativas innovadoras como blockchain para verificación, las instituciones pueden navegar estos retos con mayor eficacia.

En resumen, mientras la IA transforma la pedagogía, su despliegue debe priorizar precisión, equidad y transparencia para preservar la integridad académica. Este análisis técnico invita a profesionales del sector a invertir en investigación continua, asegurando que las herramientas de detección evolucionen en paralelo con las amenazas que pretenden contrarrestar, fomentando un futuro educativo ético y seguro.

Para más información, visita la fuente original.