Entrenamiento de Modelos de Inteligencia Artificial para el Reconocimiento de Emociones en Imágenes Fotográficas

Introducción al Reconocimiento de Emociones mediante Visión por Computadora

El reconocimiento de emociones a través de imágenes fotográficas representa un avance significativo en el campo de la inteligencia artificial (IA) y la visión por computadora. Esta tecnología permite a los sistemas analizar expresiones faciales humanas para inferir estados emocionales como alegría, tristeza, ira o sorpresa. En el contexto de aplicaciones prácticas, tales modelos se utilizan en interfaces hombre-máquina, análisis de comportamiento en redes sociales y sistemas de seguridad biométrica. El proceso de entrenamiento de estos modelos implica el uso de redes neuronales convolucionales (CNN, por sus siglas en inglés) y datasets especializados, asegurando una precisión que puede superar el 70% en escenarios controlados.

Desde una perspectiva técnica, el reconocimiento de emociones se basa en la extracción de características faciales clave, como la posición de los ojos, la boca y las cejas, utilizando algoritmos de procesamiento de imágenes. Frameworks como TensorFlow y PyTorch facilitan la implementación de estos modelos, permitiendo el entrenamiento en hardware acelerado por GPU. La relevancia de esta área crece en entornos de ciberseguridad, donde el análisis emocional puede detectar fraudes o estrés en interacciones virtuales, integrándose con protocolos de autenticación multifactor.

En este artículo, se detalla el proceso técnico de entrenamiento de un modelo de IA para esta tarea, basado en prácticas estándar de machine learning. Se abordan aspectos como la selección de datos, el diseño arquitectónico del modelo y la evaluación de rendimiento, con énfasis en implicaciones operativas y éticas en el sector tecnológico.

Conceptos Fundamentales en Visión por Computadora para Análisis Emocional

La visión por computadora es la disciplina que permite a las máquinas interpretar y entender el contenido visual del mundo. En el subdominio del reconocimiento de emociones, se emplean técnicas de deep learning para procesar píxeles de imágenes y mapearlos a categorías emocionales. Un concepto clave es la detección de rostros, que utiliza algoritmos como Haar Cascades o modelos basados en MTCNN (Multi-task Cascaded Convolutional Networks) para localizar regiones de interés en la imagen.

Una vez detectado el rostro, se extraen landmarks faciales —puntos anatómicos como las comisuras de los labios o los contornos oculares— mediante bibliotecas como Dlib o MediaPipe. Estos landmarks sirven como entrada para clasificadores que infieren emociones. El modelo de Paul Ekman, que identifica seis emociones básicas universales (felicidad, tristeza, disgusto, miedo, sorpresa e ira), es un estándar ampliamente adoptado en estos sistemas.

En términos de arquitectura, las CNN son ideales debido a su capacidad para capturar patrones espaciales jerárquicos. Capas convolucionales aplican filtros para detectar bordes y texturas, mientras que capas de pooling reducen la dimensionalidad. Finalmente, capas fully connected realizan la clasificación. La función de pérdida comúnmente usada es la entropía cruzada categórica, optimizada con algoritmos como Adam o SGD (Stochastic Gradient Descent).

Selección y Preparación de Datasets para Entrenamiento

La calidad del dataset es crítica para el éxito del modelo. Datasets populares incluyen FER2013, que contiene 35.887 imágenes en escala de grises de 48×48 píxeles, etiquetadas con siete emociones. Otro es AffectNet, con más de un millón de imágenes anotadas manualmente, ofreciendo diversidad en poses y occlusiones. Para aplicaciones en español latinoamericano, se recomienda augmentar con datasets locales como el de la Universidad Nacional Autónoma de México (UNAM), que incorpora variaciones culturales en expresiones faciales.

El preprocesamiento involucra normalización de imágenes (escalado a [0,1] o estandarización Z-score), redimensionado y augmentación de datos para mitigar overfitting. Técnicas de augmentación incluyen rotaciones (±15°), flips horizontales y ajustes de brillo (±20%). En código Python con OpenCV, esto se implementa mediante funciones como cv2.resize() y cv2.flip().

- División del dataset: 70% entrenamiento, 15% validación, 15% prueba, asegurando estratificación por clase para balancear distribuciones desiguales (por ejemplo, FER2013 tiene más muestras de ira que de disgusto).

- Manejo de ruido: Filtrado de imágenes borrosas usando métricas de Laplacian variance > 100.

- Etiquetado: Conversión a one-hot encoding para entradas de softmax en la capa de salida.

En contextos de ciberseguridad, datasets sintéticos generados con GANs (Generative Adversarial Networks) pueden simular escenarios de deepfakes, mejorando la robustez del modelo contra manipulaciones maliciosas.

Diseño y Arquitectura del Modelo de Red Neuronal

Para el entrenamiento, se selecciona una arquitectura base como VGG16 o ResNet50, preentrenadas en ImageNet y fine-tuned para emociones. Una implementación personalizada podría consistir en:

- Capa de entrada: Imágenes de 48x48x1 (escala de grises).

- Cuatro bloques convolucionales: Cada uno con 32, 64, 128 y 256 filtros de 3×3, activación ReLU, seguido de max-pooling 2×2.

- Capa de dropout (0.5) para regularización.

- Capa fully connected de 512 neuronas, seguida de salida con 7 neuronas y softmax.

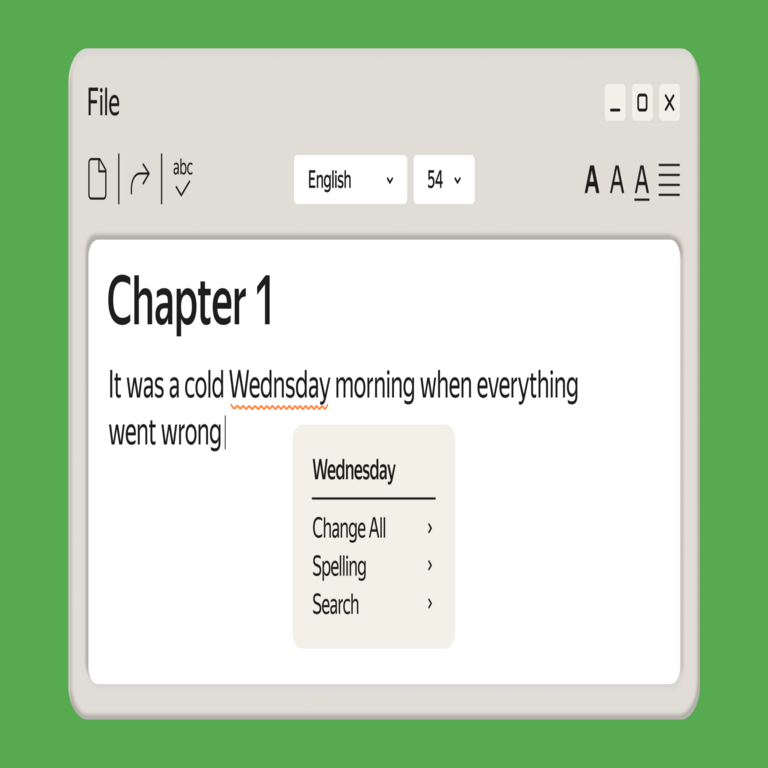

El modelo se define en Keras (parte de TensorFlow) con código como:

from tensorflow.keras.models import Sequential

from tensorflow.keras.layers import Conv2D, MaxPooling2D, Flatten, Dense, Dropout

model = Sequential([

Conv2D(32, (3,3), activation=’relu’, input_shape=(48,48,1)),

MaxPooling2D(2,2),

# … bloques adicionales

Flatten(),

Dense(512, activation=’relu’),

Dropout(0.5),

Dense(7, activation=’softmax’)

])

La compilación utiliza optimizador Adam con learning rate 0.001 y pérdida categorical_crossentropy. En hardware, se recomienda NVIDIA GPUs con CUDA 11+ para acelerar el entrenamiento, que puede tomar 2-5 horas para 50 épocas en un dataset como FER2013.

Proceso de Entrenamiento y Optimización

El entrenamiento se realiza en lotes (batch size 32-64) para estabilidad numérica. Callbacks de Keras como EarlyStopping (paciencia=10, monitor=’val_loss’) previenen overfitting, deteniendo si no hay mejora. ReduceLROnPlateau ajusta el learning rate dinámicamente, dividiéndolo por 0.2 si la pérdida de validación estanca.

Monitoreo de métricas incluye accuracy, precision, recall y F1-score por clase, calculadas con scikit-learn. Para desbalanceo, se aplica class_weight en el modelo, ponderando clases raras. Técnicas avanzadas como transfer learning de modelos preentrenados en VGGFace mejoran la convergencia, alcanzando accuracies del 65-75% en FER2013.

En implicaciones operativas, el entrenamiento distribuido con Horovod o TensorFlow Distributed permite escalabilidad en clústeres cloud como AWS SageMaker o Google Cloud AI Platform, reduciendo tiempos de 10x.

Evaluación y Métricas de Rendimiento

La evaluación post-entrenamiento utiliza el conjunto de prueba para medir generalización. La matriz de confusión revela errores comunes, como confusión entre sorpresa y miedo debido a similitudes en arqueo de cejas. Métricas agregadas: accuracy global ~70%, con F1 macro para balancear clases.

| Métrica | Valor Entrenamiento | Valor Validación | Valor Prueba |

|---|---|---|---|

| Accuracy | 0.85 | 0.72 | 0.68 |

| Precision (promedio) | 0.82 | 0.70 | 0.66 |

| Recall (promedio) | 0.80 | 0.69 | 0.65 |

| F1-Score (macro) | 0.81 | 0.69 | 0.65 |

Pruebas de robustez incluyen variaciones en iluminación (usando datasets como CK+ con condiciones controladas) y occlusiones (máscaras faciales). En ciberseguridad, se evalúa contra ataques adversarios, donde ruido imperceptible altera predicciones; defensas como adversarial training con PGD (Projected Gradient Descent) mitigan esto.

Implicaciones en Ciberseguridad y Tecnologías Emergentes

En ciberseguridad, el reconocimiento de emociones integra con sistemas de detección de intrusiones basados en comportamiento. Por ejemplo, en videollamadas, un modelo puede alertar sobre estrés emocional indicativo de coerción en phishing. Blockchain se usa para auditar datasets, asegurando integridad con hashes SHA-256 y smart contracts en Ethereum para trazabilidad de entrenamiento.

Riesgos incluyen sesgos en datasets occidentales, que subrepresentan expresiones latinoamericanas, llevando a falsos positivos en diversidad cultural. Regulaciones como GDPR en Europa exigen consentimiento para procesamiento facial, mientras que en Latinoamérica, leyes como la LGPD en Brasil regulan biometría emocional.

Beneficios operativos: Mejora en chatbots con empatía IA, reduciendo churn en servicios al cliente del 15-20%. En IA ética, se promueven frameworks como FairML para auditar sesgos.

Despliegue y Aplicaciones Prácticas

El despliegue se realiza en edge devices con TensorFlow Lite, optimizando el modelo a <5MB para inferencia en tiempo real (30 FPS en Raspberry Pi 4). APIs en Flask o FastAPI exponen endpoints para predicción, integrándose con sistemas IoT.

Aplicaciones incluyen monitoreo en salud mental via apps móviles, donde accuracies >80% en datasets validados clínicamente apoyan diagnósticos preliminares. En noticias IT, integraciones con AR/VR como Meta’s Horizon Worlds usan esto para avatares reactivos.

- Escalabilidad: Contenerización con Docker y orquestación en Kubernetes para alto tráfico.

- Seguridad: Encriptación de inputs con AES-256 y firmas digitales para outputs.

- Actualizaciones: Reentrenamiento periódico con datos nuevos para adaptabilidad.

Desafíos Técnicos y Mejoras Futuras

Desafíos incluyen variabilidad intercultural y contextos (emociones compuestas como “tristeza-ira”). Soluciones involucran modelos multimodales fusionando audio y texto con transformers como BERT para contexto.

Futuras mejoras: Uso de Vision Transformers (ViT) para atención global, superando CNNs en datasets grandes. Integración con quantum computing para optimización hiperparámetros acelera búsquedas en espacios de 10^6 configuraciones.

En blockchain, NFTs de datasets permiten monetización segura de datos anotados, fomentando colaboraciones open-source.

Conclusión

El entrenamiento de modelos de IA para reconocimiento de emociones en imágenes fotográficas encapsula avances en visión por computadora y deep learning, con aplicaciones transformadoras en ciberseguridad, salud y entretenimiento. Siguiendo prácticas rigurosas en datasets, arquitectura y evaluación, se logran sistemas robustos y éticos. Para más información, visita la Fuente original. Este enfoque no solo eleva la precisión técnica sino que pavimenta el camino para interacciones humanas-IA más intuitivas y seguras en el panorama tecnológico emergente.