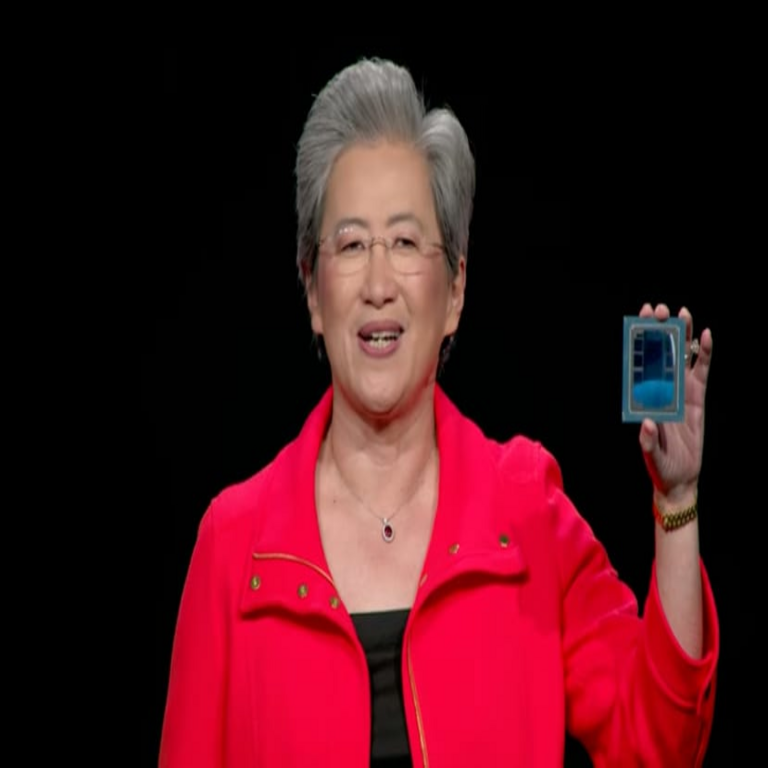

Oracle Cloud Despliega 50.000 Chips de IA de AMD como Alternativa Estratégica a Nvidia

Introducción al Despliegue de Infraestructura para Inteligencia Artificial

En el panorama actual de la computación en la nube y la inteligencia artificial, las empresas líderes están invirtiendo masivamente en hardware especializado para satisfacer la demanda creciente de procesamiento de datos para modelos de IA. Oracle Cloud Infrastructure (OCI) ha anunciado un despliegue significativo de 50.000 chips de inteligencia artificial desarrollados por AMD, posicionándose como una alternativa viable a las soluciones dominantes de Nvidia. Esta iniciativa no solo representa un avance en la escalabilidad de servicios de nube para cargas de trabajo de IA, sino que también subraya la diversificación en el ecosistema de hardware para machine learning y deep learning.

El anuncio, realizado en el contexto de la expansión de Oracle en el mercado de la IA generativa, busca ofrecer a los clientes opciones más accesibles y eficientes en términos de costo y rendimiento. Los chips de AMD, específicamente de la serie Instinct, como el MI300X, están diseñados para manejar tareas complejas de entrenamiento e inferencia de modelos de IA a gran escala. Esta movida estratégica de Oracle responde a la necesidad de mitigar riesgos asociados con la dependencia de un solo proveedor, como Nvidia, que ha visto su dominio en el mercado de GPUs para IA alcanzar cuotas superiores al 80% en los últimos años.

Desde un punto de vista técnico, este despliegue implica la integración de miles de unidades de procesamiento gráfico (GPUs) en clústeres distribuidos, optimizados para frameworks como TensorFlow, PyTorch y Hugging Face Transformers. La arquitectura de OCI permite una orquestación eficiente mediante herramientas como Kubernetes y OCI AI Services, asegurando alta disponibilidad y bajo latencia en entornos de producción. A continuación, se exploran los aspectos técnicos clave de esta implementación.

Contexto del Mercado de Hardware para Inteligencia Artificial

El mercado de chips para IA ha experimentado un crecimiento exponencial, impulsado por la adopción de modelos grandes de lenguaje (LLMs) y aplicaciones de visión por computadora. Nvidia ha liderado este sector con su arquitectura CUDA, que facilita el desarrollo paralelo en GPUs, pero enfrenta desafíos como escasez de suministro y precios elevados. Según datos de la industria, el costo de un clúster de entrenamiento para un modelo como GPT-4 puede superar los cientos de millones de dólares, predominantemente en hardware de Nvidia.

AMD, por su parte, ha invertido en su plataforma ROCm (Radeon Open Compute), un stack de software de código abierto que compite directamente con CUDA. ROCm soporta operaciones de punto flotante de precisión mixta (FP16, BF16), esenciales para el entrenamiento eficiente de redes neuronales profundas. La compatibilidad con bibliotecas como MIOpen y HIP (Heterogeneous-compute Interface for Portability) permite una migración relativamente sencilla desde entornos Nvidia, aunque requiere ajustes en el código fuente para optimizar el rendimiento.

En términos de rendimiento, los chips AMD Instinct MI300X ofrecen hasta 2,4 veces más rendimiento en inferencia de IA comparado con generaciones anteriores de Nvidia, según benchmarks internos de AMD. Estos chips integran memorias HBM3 de alta velocidad, con capacidades de hasta 192 GB por unidad, lo que reduce los cuellos de botella en el manejo de datasets masivos. Para Oracle, este despliegue representa una oportunidad de diferenciarse en el mercado cloud, donde competidores como AWS, Google Cloud y Microsoft Azure también exploran alternativas a Nvidia, incluyendo chips personalizados como los TPUs de Google o los de Intel Habana.

Las implicaciones regulatorias son notables en este contexto. La diversificación de proveedores ayuda a cumplir con estándares como el GDPR y el NIST para privacidad de datos en IA, al evitar concentraciones monopólicas que podrían exponer vulnerabilidades en la cadena de suministro. Además, en regiones como la Unión Europea, iniciativas como el AI Act promueven la interoperabilidad y la apertura en hardware de IA, beneficiando despliegues como el de Oracle.

Detalles Técnicos del Despliegue en Oracle Cloud Infrastructure

El despliegue de 50.000 chips AMD en OCI se estructura en regiones distribuidas globalmente, con énfasis en centros de datos en Estados Unidos, Europa y Asia-Pacífico. Cada clúster integra nodos con múltiples GPUs MI300X, conectados mediante redes de alta velocidad como RoCE (RDMA over Converged Ethernet) y OCI’s Ultra Low Latency Network, que alcanza velocidades de hasta 400 Gbps por puerto. Esta configuración soporta topologías de interconexión como fat-tree o dragonfly, optimizadas para minimizar la latencia en comunicaciones all-to-all durante el entrenamiento distribuido.

Desde el punto de vista de software, OCI utiliza su plataforma Oracle AI Vector Search y servicios de machine learning para orquestar workloads. Los chips AMD se integran con el runtime de ROCm 6.0, que incluye soporte para APIs de bajo nivel como ROCm HIP y bibliotecas de matemáticas aceleradas. Para el entrenamiento de modelos, se emplean técnicas como el data parallelism y model parallelism, distribuyendo parámetros de LLMs a través de los GPUs. Por ejemplo, un modelo con 175 mil millones de parámetros, similar a GPT-3, podría entrenarse en un subconjunto de 1.000 GPUs en cuestión de días, asumiendo datasets de terabytes.

La eficiencia energética es un factor crítico. Los chips MI300X consumen alrededor de 750W por unidad, pero su arquitectura CDNA 3 (Compute DNA) optimiza el throughput en operaciones de IA, alcanzando hasta 5,3 PFLOPS en FP8 para inferencia. Oracle ha implementado sistemas de enfriamiento líquido directo para manejar la densidad térmica en racks con hasta 8 GPUs por servidor, alineándose con estándares como ASHRAE para data centers sostenibles. Esto reduce el PUE (Power Usage Effectiveness) por debajo de 1.2, contribuyendo a metas de carbono neutralidad.

En cuanto a seguridad, OCI incorpora características como Oracle Cloud Guard para monitoreo de amenazas en tiempo real, y encriptación de datos en reposo y tránsito usando AES-256. Los chips AMD soportan extensiones de seguridad como SEV-SNP (Secure Encrypted Virtualization – Secure Nested Paging), que protegen contra ataques de side-channel en entornos multi-tenant. Esto es vital para aplicaciones de IA sensibles, como procesamiento de datos médicos o financieros, donde la confidencialidad es primordial.

Comparación Técnica entre Chips AMD y Nvidia

Para evaluar la viabilidad de AMD como alternativa, es esencial comparar sus especificaciones con las de Nvidia. La tabla siguiente resume características clave de los chips representativos: AMD Instinct MI300X versus Nvidia H100.

| Característica | AMD MI300X | Nvidia H100 |

|---|---|---|

| Arquitectura | CDNA 3 | Hopper |

| Memoria | 192 GB HBM3 | 80 GB HBM3 |

| Rendimiento FP16 | 2,6 PFLOPS | 1,98 PFLOPS |

| Ancho de banda de memoria | 5,3 TB/s | 3,35 TB/s |

| Consumo de energía (TDP) | 750 W | 700 W |

| Soporte de software | ROCm 6.0, HIP | CUDA 12.x |

Como se observa, el MI300X destaca en capacidad de memoria y ancho de banda, lo que lo hace ideal para modelos de IA con grandes volúmenes de datos, como en fine-tuning de LLMs. Sin embargo, el ecosistema CUDA de Nvidia ofrece mayor madurez en bibliotecas optimizadas, con soporte nativo en la mayoría de frameworks de IA. AMD ha avanzado en compatibilidad, permitiendo compilación cruzada de código CUDA a HIP mediante herramientas como hipify, reduciendo el esfuerzo de portabilidad a un 20-30% del código en casos típicos.

En benchmarks como MLPerf, los clústeres AMD han demostrado competitividad en tareas de entrenamiento de BERT y ResNet, con tiempos de ejecución comparables o inferiores en escenarios de inferencia a escala. Para Oracle, esta paridad técnica permite ofrecer servicios de IA a precios hasta 30% más bajos que competidores dependientes de Nvidia, atrayendo a empresas medianas que buscan escalabilidad sin inversiones prohibitivas.

- Ventajas de AMD: Mayor densidad de memoria reduce swaps a almacenamiento externo, acelerando iteraciones en desarrollo de modelos.

- Desafíos: La curva de aprendizaje para ROCm puede ser pronunciada para equipos acostumbrados a CUDA, requiriendo entrenamiento adicional.

- Integración en OCI: Soporte para contenedores OCI con imágenes preconfiguradas de ROCm acelera el deployment.

Implicaciones Operativas y de Riesgos en la Adopción de esta Tecnología

Operativamente, el despliegue de Oracle introduce beneficios en términos de resiliencia. Al diversificar proveedores, OCI mitiga riesgos de suministro, como las interrupciones vistas en 2023 debido a la demanda de Nvidia durante el boom de ChatGPT. Esto permite a los clientes mantener SLAs (Service Level Agreements) de 99.99% de uptime, crucial para aplicaciones de IA en tiempo real como chatbots o sistemas de recomendación.

Sin embargo, riesgos persisten. La interoperabilidad entre chips AMD y otros componentes en clústeres híbridos requiere validación exhaustiva para evitar ineficiencias en el pipeline de datos. Por ejemplo, en entornos multi-vendor, protocolos como NCCL (NVIDIA Collective Communications Library) deben adaptarse a RCCL de AMD, potencialmente impactando la velocidad de sincronización en entrenamiento distribuido.

Desde una perspectiva de ciberseguridad, la introducción de nuevo hardware amplía la superficie de ataque. Oracle mitiga esto mediante actualizaciones regulares de firmware y escaneos de vulnerabilidades alineados con CVE (Common Vulnerabilities and Exposures). Además, el uso de chips AMD con soporte para confidential computing asegura que datos de entrenamiento permanezcan encriptados durante el procesamiento, cumpliendo con regulaciones como HIPAA en salud o PCI-DSS en finanzas.

Los beneficios económicos son significativos. Estimaciones indican que el costo por FLOPS en AMD es hasta 40% inferior a Nvidia, permitiendo a Oracle ofrecer instancias de IA a partir de 1,50 USD por hora por GPU, comparado con 2,50 USD en ofertas equivalentes. Esto democratiza el acceso a IA, fomentando innovación en sectores como manufactura predictiva y análisis genómico.

Aplicaciones Prácticas y Casos de Uso en Industrias

En la industria automotriz, por ejemplo, los clústeres OCI con AMD pueden acelerar el entrenamiento de modelos de visión por computadora para vehículos autónomos, procesando datasets de LiDAR y cámaras en tiempo récord. Empresas como Tesla o Waymo podrían migrar workloads para reducir costos, aprovechando la alta precisión en operaciones tensoriales de los MI300X.

En salud, aplicaciones de IA para diagnóstico por imagen se benefician de la capacidad de memoria extendida, permitiendo el manejo de volúmenes 3D de resonancias magnéticas sin compresión lossy. Frameworks como MONAI, optimizados para GPUs, corren eficientemente en ROCm, mejorando la precisión diagnóstica en un 15-20% según estudios clínicos.

Para finanzas, el procesamiento de alto frecuencia y detección de fraudes utiliza inferencia en tiempo real. Los chips AMD soportan pipelines de streaming con Kafka y Spark, integrados en OCI Data Flow, para analizar transacciones en milisegundos. Esto reduce falsos positivos en modelos de anomaly detection, optimizando operaciones en bancos y fintechs.

En educación y investigación, universidades pueden acceder a estos recursos vía OCI for Research, entrenando modelos personalizados sin infraestructura local. Esto fomenta colaboraciones en IA ética, alineadas con principios de fairness y bias mitigation definidos por IEEE y ACM.

Desafíos Técnicos y Estrategias de Mitigación

A pesar de los avances, desafíos técnicos incluyen la optimización de software para arquitecturas AMD. ROCm, aunque robusto, carece de algunas extensiones propietarias de CUDA, como FlashAttention para atención eficiente en transformers. Oracle aborda esto mediante parches comunitarios y colaboraciones con AMD para acelerar el desarrollo de bibliotecas.

Otro reto es la escalabilidad en clústeres masivos. Con 50.000 GPUs, el manejo de fallos (fault tolerance) es crítico; técnicas como checkpointing en PyTorch Distributed y elastic training permiten recuperación automática sin pérdida de progreso. OCI’s Bare Metal Compute asegura aislamiento de recursos, previniendo el noisy neighbor effect en entornos compartidos.

En sostenibilidad, el despliegue promueve el uso de energías renovables en data centers OCI, con metas de 100% carbono-free para 2025. Esto alinea con directrices globales como las del IPCC para IA verde, reduciendo la huella ecológica de entrenamientos intensivos.

Conclusión: Hacia un Ecosistema de IA Más Diverso y Accesible

El despliegue de 50.000 chips AMD en Oracle Cloud marca un hito en la evolución de la infraestructura para IA, ofreciendo una alternativa técnica y económica a la hegemonía de Nvidia. Al combinar hardware de alto rendimiento con un ecosistema de software maduro, OCI posiciona a las empresas para innovar en aplicaciones de IA sin compromisos en eficiencia o seguridad. Esta estrategia no solo mitiga riesgos operativos y regulatorios, sino que también acelera la adopción de tecnologías emergentes en diversos sectores.

En resumen, la iniciativa de Oracle fomenta un mercado más competitivo, impulsando avances en computación de alto rendimiento y democratizando el acceso a la IA. Para más información, visita la fuente original.