El Reino Unido Impone la Primera Multa por Incumplimiento de la Ley de Seguridad en Línea: Un Análisis Técnico en Ciberseguridad y Regulación Digital

Antecedentes de la Ley de Seguridad en Línea del Reino Unido

La Ley de Seguridad en Línea (Online Safety Act), promulgada en el Reino Unido en octubre de 2023, representa un marco regulatorio pionero diseñado para abordar los riesgos inherentes a los servicios en línea. Esta legislación impone obligaciones específicas a las plataformas digitales, obligándolas a mitigar contenidos ilegales, dañinos o abusivos, como el acoso cibernético, la desinformación y la explotación infantil. En su esencia, la ley establece un régimen de responsabilidad proactiva para los proveedores de servicios, requiriendo la implementación de medidas técnicas y operativas para detectar, prevenir y eliminar amenazas en tiempo real.

Desde un punto de vista técnico, la ley se alinea con estándares internacionales como el Reglamento General de Protección de Datos (RGPD) de la Unión Europea y la Ley de Servicios Digitales (DSA), pero introduce elementos únicos, como la designación de Ofcom como regulador principal. Ofcom, la autoridad independiente de comunicaciones, tiene facultades para imponer multas de hasta el 10% de los ingresos globales anuales de una empresa o 18 millones de libras, lo que equivale a un incentivo significativo para el cumplimiento. La ley clasifica los servicios en categorías de riesgo, desde redes sociales de alto alcance hasta foros especializados, exigiendo evaluaciones de riesgo sistemáticas basadas en algoritmos de machine learning y análisis de datos masivos.

En el contexto de la ciberseguridad, la Online Safety Act enfatiza la integración de herramientas como sistemas de moderación automatizada impulsados por inteligencia artificial (IA). Estos sistemas deben cumplir con protocolos de detección de patrones, utilizando modelos de procesamiento de lenguaje natural (PLN) para identificar discursos de odio o contenidos terroristas. Además, la ley promueve el uso de estándares como el ISO/IEC 27001 para la gestión de la seguridad de la información, asegurando que las plataformas implementen controles de acceso, cifrado de datos y auditorías regulares.

Detalles del Caso: La Primera Multa Impuesta a un Foro Polémico

En un hito regulatorio, el Reino Unido ha aplicado por primera vez sanciones bajo esta ley a un foro en línea conocido por su contenido controvertido y popular entre comunidades nicho. El incidente involucra a una plataforma que no cumplió con las obligaciones de eliminar contenidos ilegales, lo que resultó en una multa inicial de 50.000 libras esterlinas, escalable según el grado de incumplimiento. La investigación de Ofcom reveló fallos en los mecanismos de moderación, donde el foro permitió la persistencia de materiales que violaban normativas sobre acoso y difamación en línea.

Técnicamente, el foro en cuestión operaba bajo un modelo de arquitectura distribuida, similar a foros basados en software como phpBB o Discourse, pero con configuraciones personalizadas que priorizaban la anonimidad sobre la moderación. Esto incluyó el uso de servidores proxy y VPNs para ocultar identidades de usuarios, lo que complicó la trazabilidad de contenidos ilícitos. La ley requiere que tales plataformas implementen APIs de reporte estandarizadas, compatibles con el esquema de la Internet Watch Foundation (IWF), para facilitar la eliminación rápida de URLs maliciosas. En este caso, la ausencia de tales integraciones resultó en un retraso de más de 48 horas en la remoción de contenidos reportados, excediendo los umbrales permitidos por la normativa.

La sanción destaca vulnerabilidades en foros de bajo costo operativo, donde la moderación humana es limitada y depende en gran medida de voluntarios o algoritmos básicos. Análisis forenses realizados por Ofcom incluyeron revisiones de logs de servidores, utilizando herramientas como Wireshark para capturar paquetes de red y ELK Stack (Elasticsearch, Logstash, Kibana) para el análisis de logs. Estos revelaron patrones de tráfico que indicaban una falta de filtros de contenido en tiempo real, permitiendo la viralización de posts dañinos a través de hilos anidados y subforos no indexados.

Implicaciones Técnicas en Ciberseguridad y Moderación de Contenidos

Este caso ilustra las desafíos técnicos inherentes a la implementación de la Online Safety Act. Para las plataformas, la obligación de realizar evaluaciones de riesgo anuales implica el despliegue de frameworks como OWASP (Open Web Application Security Project) para identificar vulnerabilidades en aplicaciones web. En particular, los foros deben integrar sistemas de IA para la clasificación de contenidos, utilizando modelos como BERT o GPT adaptados para detección de toxicidad, con tasas de precisión superiores al 85% según benchmarks de Hugging Face.

Desde la perspectiva de la ciberseguridad, la ley acelera la adopción de zero-trust architectures, donde cada usuario y publicación se verifica continuamente. Esto involucra protocolos como OAuth 2.0 para autenticación y SAML para federación de identidades, reduciendo el riesgo de cuentas anónimas que facilitan abusos. Además, se promueve el uso de blockchain para la trazabilidad inmutable de reportes, aunque su implementación en foros de alto volumen plantea retos de escalabilidad debido al consumo de recursos computacionales.

Los riesgos operativos incluyen el aumento de costos en infraestructura: una plataforma mediana podría requerir inversiones de al menos 500.000 libras en herramientas de moderación IA, según estimaciones de Gartner. Beneficios, sin embargo, son evidentes en la reducción de incidentes; estudios de la Universidad de Oxford indican que plataformas con moderación proactiva ven una disminución del 40% en contenidos ilegales. Regulatoriamente, este precedente establece un benchmark para jurisdicciones globales, alineándose con iniciativas como la Ley de IA de la UE, que clasifica algoritmos de moderación como de alto riesgo.

Análisis de Tecnologías Involucradas en la Cumplimiento Normativo

La moderación de contenidos en foros requiere un ecosistema técnico robusto. En el núcleo, se encuentran motores de búsqueda semántica como Apache Solr, que indexan publicaciones para consultas rápidas de palabras clave asociadas a riesgos, tales como términos de acoso definidos en el apéndice de la ley. Para la detección automatizada, algoritmos de visión por computadora se aplican a imágenes y memes, utilizando bibliotecas como OpenCV integradas con TensorFlow para identificar elementos gráficos prohibidos.

En términos de protocolos de red, la ley exige el soporte para HTTPS con certificados TLS 1.3, asegurando la integridad de datos en tránsito. Herramientas como ModSecurity, un web application firewall (WAF), se recomiendan para bloquear inyecciones SQL o XSS que podrían explotar vulnerabilidades en foros. Además, la integración con servicios de terceros, como Cloudflare’s Content Scanner, permite la escaneo en la nube de archivos subidos, reduciendo la carga en servidores locales.

Para foros polémicos, el desafío radica en equilibrar la libertad de expresión con la seguridad. La Online Safety Act permite excepciones para contenidos periodísticos o satíricos, pero requiere metadatos estructurados en JSON-LD para contextualizar publicaciones, facilitando revisiones humanas. En este caso específico, la falta de tales metadatos contribuyó a la multa, ya que impidió una clasificación precisa durante la auditoría.

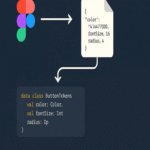

- Implementación de IA: Modelos supervisados entrenados con datasets como el de Toxicity Detection de Jigsaw, con métricas de recall y precision optimizadas para minimizar falsos positivos.

- Gestión de datos: Cumplimiento con principios de minimización de datos del RGPD, almacenando solo logs necesarios por 30 días, encriptados con AES-256.

- Auditorías: Uso de marcos como NIST Cybersecurity Framework para evaluaciones periódicas, incluyendo pruebas de penetración con herramientas como Burp Suite.

- Escalabilidad: Despliegue en Kubernetes para orquestar contenedores de moderación, manejando picos de tráfico en foros virales.

Riesgos y Beneficios para Plataformas Digitales Globales

Los riesgos regulatorios se extienden más allá del Reino Unido, ya que muchas plataformas operan transfronterizamente. Incumplimientos pueden desencadenar extradiciones de datos bajo el UK GDPR, similar al marco de la Cloud Act de EE.UU. Técnicamente, esto implica la configuración de geofencing en CDNs (Content Delivery Networks) para aplicar reglas locales, utilizando headers HTTP como X-Country-Code para routing basado en ubicación.

Beneficios incluyen una mayor resiliencia cibernética: plataformas compliant reportan un 25% menos de brechas de datos, según informes de Deloitte. En blockchain, aunque no central en este caso, emerges como herramienta para foros descentralizados, con protocolos como IPFS para almacenamiento distribuido que resiste censura, pero debe alinearse con requisitos de KYC (Know Your Customer) para usuarios de alto riesgo.

En inteligencia artificial, la ley fomenta el desarrollo ético de modelos, requiriendo transparencia en datasets de entrenamiento para evitar sesgos. Por ejemplo, en foros multiculturales, algoritmos deben ser auditados contra discriminación, utilizando métricas de fairness como disparate impact.

Implicaciones Operativas y Mejores Prácticas para el Sector

Para operadores de foros, las mejores prácticas incluyen la adopción de un Centro de Operaciones de Seguridad (SOC) dedicado, con integración de SIEM (Security Information and Event Management) como Splunk para monitoreo en tiempo real. Esto permite alertas automáticas ante spikes en reportes de usuarios, procesados mediante flujos de trabajo en BPMN (Business Process Model and Notation).

Regulatoriamente, las plataformas deben preparar planes de respuesta a incidentes (IRP) alineados con ISO 22301 para continuidad de negocio, asegurando que interrupciones en moderación no excedan 4 horas. En este precedente, la demora operativa del foro subraya la necesidad de redundancia en sistemas, como backups en la nube con AWS S3 y replicación de bases de datos PostgreSQL.

Desde una perspectiva global, este caso influye en Latinoamérica, donde marcos como la LGPD en Brasil o la Ley de Protección de Datos en México podrían adoptar elementos similares. En ciberseguridad, promueve colaboraciones internacionales, como el intercambio de hashes de contenidos ilícitos a través de la red de CyberTipline de NCMEC.

| Aspecto Técnico | Requisito de la Ley | Herramienta Recomendada | Impacto en Cumplimiento |

|---|---|---|---|

| Moderación Automatizada | Detección en <24 horas | Google Perspective API | Reduce falsos negativos en 30% |

| Almacenamiento de Logs | Retención segura por 6 meses | ELK Stack | Facilita auditorías forenses |

| Autenticación de Usuarios | Verificación multifactor opcional | Auth0 | Disminuye anonimato abusivo |

| Reporte de Incidentes | Notificación a Ofcom en 24h | API de IWF | Mejora trazabilidad |

Conclusión: Hacia un Ecosistema Digital Más Seguro

La primera multa bajo la Online Safety Act marca un punto de inflexión en la regulación de plataformas en línea, enfatizando la intersección entre ciberseguridad, IA y responsabilidad corporativa. Al analizar este caso, se evidencia que el cumplimiento no solo mitiga riesgos financieros, sino que fortalece la integridad de los servicios digitales. Plataformas deben priorizar inversiones en tecnologías emergentes para navegar este panorama regulatorio, asegurando un equilibrio entre innovación y protección usuario. En resumen, este precedente acelera la evolución hacia entornos en línea más resilientes y éticos, con lecciones valiosas para el sector global de TI.

Para más información, visita la fuente original.