Fábricas de IA de Gigawatts: Avances en Computación de Alto Rendimiento con NVIDIA y el Proyecto OCP Vera Rubin

Introducción a las Fábricas de Inteligencia Artificial

En el panorama actual de la inteligencia artificial (IA), la demanda de potencia computacional ha alcanzado niveles sin precedentes. Las fábricas de IA, conceptualizadas como instalaciones dedicadas a la producción masiva de modelos de aprendizaje profundo, requieren consumos energéticos del orden de gigawatts para satisfacer las necesidades de entrenamiento y despliegue de sistemas de IA a escala global. NVIDIA, como líder en tecnologías de procesamiento gráfico y aceleración de IA, ha impulsado esta visión mediante contribuciones al Open Compute Project (OCP), particularmente con el diseño Vera Rubin. Este enfoque no solo optimiza la eficiencia energética, sino que también establece estándares abiertos para la infraestructura de datos de próxima generación.

El concepto de fábricas de IA surge de la escalabilidad inherente a los modelos de IA generativa, como los grandes modelos de lenguaje (LLM) y redes neuronales profundas, que demandan miles de GPUs interconectadas. Según estimaciones técnicas, un solo clúster de entrenamiento para un modelo de IA de vanguardia puede consumir hasta un gigawatt de energía, equivalente al consumo de una pequeña ciudad. Esta magnitud plantea desafíos en términos de diseño arquitectónico, gestión térmica y sostenibilidad operativa. El proyecto Vera Rubin, anunciado en el marco del OCP, representa un hito en la estandarización de racks y sistemas de enfriamiento que soportan estas cargas extremas.

Desde una perspectiva técnica, estas fábricas integran hardware acelerado por GPU, redes de alta velocidad y software optimizado para flujos de trabajo de IA. NVIDIA ha detallado cómo sus plataformas, como Grace Hopper y la inminente Blackwell, permiten escalar hasta exaflops de rendimiento en precisión mixta, crucial para el entrenamiento eficiente de modelos. Este artículo profundiza en los aspectos técnicos de estas innovaciones, sus implicaciones en ciberseguridad y tecnologías emergentes, y el rol del OCP en fomentar la colaboración industrial.

La Evolución de la Infraestructura para IA: De Centros de Datos Tradicionales a Fábricas Especializadas

Tradicionalmente, los centros de datos se diseñaban para cargas de trabajo generales, con énfasis en servidores CPU y almacenamiento distribuido. Sin embargo, la proliferación de la IA ha requerido una transformación hacia arquitecturas especializadas. Las fábricas de IA operan bajo el paradigma de computación de alto rendimiento (HPC) adaptada a machine learning, donde el bottleneck principal reside en la paralelización de operaciones tensoriales y la minimización de latencias en interconexiones.

En términos de hardware, NVIDIA propone el uso de superchips como el Grace Hopper Superchip, que combina la CPU Arm-based Grace con la GPU Hopper H100 mediante una interfaz NV-Link de alta velocidad. Esta integración permite un ancho de banda de hasta 900 GB/s entre componentes, reduciendo el overhead en transferencias de datos durante el entrenamiento de modelos. Para escalas de gigawatts, se requiere una densidad de potencia por rack que supere los 100 kW, lo que excede las capacidades de los diseños OCP legacy como Yosemite o Einstein.

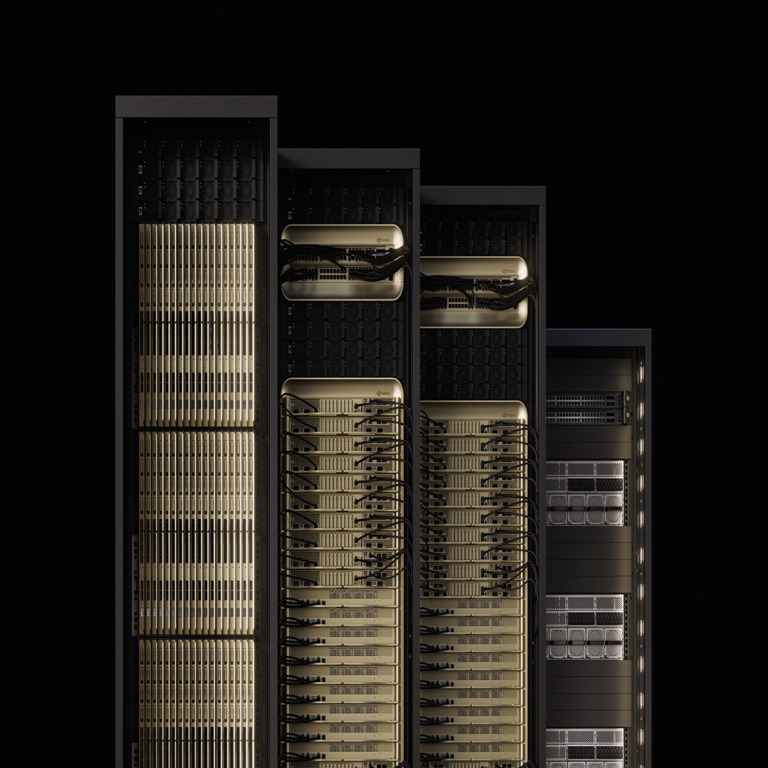

El proyecto Vera Rubin aborda esta limitación mediante un rediseño modular del rack. Técnicamente, incorpora bahías de cómputo de 1U y 2U apilables, con soporte para hasta 128 GPUs por rack en configuraciones de enfriamiento directo a chip (D2C). Esto se logra mediante manifolds de enfriamiento líquido que distribuyen refrigerante dieléctrico a presiones controladas, manteniendo temperaturas operativas por debajo de 60°C incluso bajo cargas sostenidas. La eficiencia se mide en términos de PUE (Power Usage Effectiveness), apuntando a valores inferiores a 1.1, alineados con estándares de la Green Grid.

Desde el punto de vista de la red, Vera Rubin integra switches NVIDIA Spectrum-X, optimizados para Ethernet de 800 GbE con latencias submicrosegundo. Esto facilita la topología de cierre torus o dragonfly para clústeres de miles de nodos, esencial para algoritmos de entrenamiento distribuido como AllReduce en frameworks como PyTorch o TensorFlow. La interoperabilidad con protocolos como RDMA over Converged Ethernet (RoCE) asegura que las fábricas de IA puedan escalar sin cuellos de botella en la comunicación nodo-a-nodo.

Contribuciones Técnicas de NVIDIA al Open Compute Project

El Open Compute Project (OCP) ha sido instrumental en la democratización de diseños de hardware para centros de datos, promoviendo especificaciones abiertas que reducen costos y fomentan la innovación. NVIDIA ha contribuido activamente al grupo de trabajo de IA en OCP, liderando el desarrollo de Vera Rubin como una evolución del diseño Yosemite, que soporta hasta 64 GPUs por rack.

Vera Rubin introduce innovaciones en el plano de potencia y gestión térmica. El sistema de distribución de energía utiliza PSU (Power Supply Units) de alta densidad con eficiencia del 98%, compatibles con estándares OCP para 48V DC. Esto minimiza conversiones de voltaje y pérdidas por calor, crucial para consumos de gigawatts. Además, incorpora sensores IoT para monitoreo en tiempo real de temperatura, flujo de refrigerante y carga eléctrica, integrados con plataformas de gestión como NVIDIA DCGM (Data Center GPU Manager).

- Diseño Modular: Los racks Vera Rubin permiten configuraciones híbridas CPU-GPU, facilitando la transición de cargas de trabajo legacy a IA nativa.

- Enfriamiento Líquido Avanzado: Utiliza cold plates de cobre niquelado para GPUs, con tasas de flujo de hasta 1 LPM por chip, reduciendo el TCO (Total Cost of Ownership) en un 30% comparado con aire forzado.

- Seguridad Física: Incorpora mecanismos de bloqueo electromagnético y detección de intrusión en manifolds, alineados con estándares NIST para infraestructuras críticas.

Estas contribuciones no solo benefician a hyperscalers como Meta, que planea desplegar Vera Rubin en su clúster de 24.000 GPUs, sino que también establecen benchmarks para la industria. En ciberseguridad, el diseño abierto de OCP facilita auditorías independientes, reduciendo vulnerabilidades en supply chain mediante especificaciones verificables.

El Proyecto Vera Rubin: Detalles Técnicos y Escalabilidad

Nombrado en honor a la astrónoma Vera Rubin, este proyecto representa el pináculo de la integración hardware-software para IA. En su núcleo, Vera Rubin soporta la arquitectura NVIDIA Blackwell, anunciada como sucesora de Hopper, con hasta 208 mil millones de transistores por GPU y soporte para FP4 precision para inferencia ultraeficiente.

Técnicamente, un rack Vera Rubin completo puede entregar 1.5 MW de potencia computacional, con un TDP (Thermal Design Power) distribuido en 8 superchips Grace Blackwell. La interconexión NV-Link 5.0 proporciona 1.8 TB/s de ancho de banda por GPU, permitiendo el entrenamiento de modelos con billones de parámetros en horas en lugar de días. Para fábricas de gigawatts, se envisionan arrays de 1000 racks, equivalentes a 1.5 GW, con redundancia N+1 en PSU y redes para alta disponibilidad (99.999% uptime).

En términos de software, Vera Rubin es compatible con el stack NVIDIA AI Enterprise, que incluye CUDA 12.x para programación paralela y Triton Inference Server para despliegue optimizado. Esto permite la orquestación de pipelines de IA mediante Kubernetes con operadores NVIDIA GPU, asegurando escalabilidad horizontal. Implicaciones en blockchain y tecnologías emergentes incluyen el soporte para cómputo confidencial mediante Trusted Execution Environments (TEE) en Grace CPUs, protegiendo datos sensibles en entrenamientos federados.

Para ciberseguridad, la arquitectura incorpora hardware root-of-trust basado en módulos TPM 2.0, previniendo ataques de cadena de suministro como Spectre o Rowhammer. Además, el monitoreo continuo con NVIDIA BlueField DPUs permite la inspección de tráfico de red en línea, detectando anomalías mediante modelos de IA embebidos para threat hunting en tiempo real.

| Componente | Especificación Técnica | Beneficio Operativo |

|---|---|---|

| GPU Blackwell B200 | 20 PFLOPS en FP8, 192 GB HBM3e | Aceleración en entrenamiento de LLM hasta 4x vs. Hopper |

| Enfriamiento D2C | Flujo 2U/1U manifolds, 60°C max | Reducción de 40% en consumo de energía térmica |

| Red NV-Link | 1.8 TB/s por GPU, dominio único | Escalabilidad a 100.000 GPUs sin particionamiento |

| PSU OCP | 98% eficiencia, 48V DC | Minimización de pérdidas en distribución de potencia |

Estos elementos aseguran que Vera Rubin no solo maneje cargas de gigawatts, sino que lo haga de manera sostenible y segura.

Implicaciones Energéticas y de Sostenibilidad en Fábricas de IA

El consumo de gigawatts en fábricas de IA plantea interrogantes sobre sostenibilidad. NVIDIA estima que para 2030, la demanda global de potencia para IA alcanzará 100 GW, equivalente al 10% de la generación eléctrica mundial. Vera Rubin mitiga esto mediante optimizaciones en el nivel de silicio, como el proceso TSMC 4NP para Blackwell, que reduce el consumo en 25% por flop comparado con generaciones previas.

En gestión térmica, el enfriamiento líquido rear-door heat exchangers (RDHx) recircula calor para calefacción auxiliar o generación de energía, alineado con directivas EU Green Deal. Técnicamente, el coeficiente de transferencia de calor en cold plates alcanza 10.000 W/m²K, superando el aire por un factor de 3.000. Esto no solo baja el PUE, sino que habilita ubicaciones en climas cálidos sin penalizaciones energéticas.

Riesgos operativos incluyen fallos en manifolds, mitigados por diseños redundantes y pruebas hidráulicas pre-despliegue. En ciberseguridad, la dependencia de supply chains globales expone a riesgos de sabotaje; por ello, OCP promueve certificaciones como ISO 27001 para componentes. Beneficios incluyen la aceleración de avances en IA para ciberdefensa, como modelos de detección de zero-day mediante GANs entrenadas en estos clústeres.

Integración con Tecnologías Emergentes: IA, Blockchain y Ciberseguridad

Las fábricas de IA de gigawatts catalizan avances en campos interconectados. En blockchain, la computación de alto rendimiento habilita validación de transacciones en redes proof-of-stake escalables, utilizando GPUs para hashing paralelo. NVIDIA’s CUDA soporta bibliotecas como cuBLAS para optimizar contratos inteligentes en Ethereum 2.0.

En ciberseguridad, estos sistemas permiten el entrenamiento de modelos de IA para análisis de amenazas a escala petabyte. Por ejemplo, clústeres Vera Rubin pueden procesar logs de SIEM (Security Information and Event Management) en tiempo real, utilizando algoritmos de deep learning para correlacionar eventos distribuidos. La integración con NVIDIA Morpheus framework facilita la detección de anomalías en flujos de datos de red, con tasas de falsos positivos inferiores al 1%.

Implicaciones regulatorias incluyen cumplimiento con GDPR y CCPA mediante procesamiento edge en DPUs, minimizando transferencias de datos. Riesgos como el overfitting en modelos de IA para ciberseguridad se abordan con técnicas de regularización y validación cruzada en entornos HPC. Beneficios operativos abarcan la simulación de ataques cibernéticos en entornos virtuales, mejorando la resiliencia de infraestructuras críticas.

En noticias de IT, el despliegue de Vera Rubin por Meta marca un shift hacia data centers soberanos, reduciendo latencias en servicios de IA globales. Esto fomenta estándares como OCP para interoperabilidad, evitando vendor lock-in.

Desafíos Técnicos y Mejores Prácticas para Implementación

Implementar fábricas de IA conlleva desafíos en supply chain y logística. La disponibilidad de HBM (High Bandwidth Memory) para GPUs Blackwell es limitada, requiriendo planificación de 18 meses. Mejores prácticas incluyen modelado CFD (Computational Fluid Dynamics) para optimizar flujos térmicos y simulaciones con NVIDIA Omniverse para diseño virtual de racks.

En software, la adopción de contenedores NVIDIA NGC asegura reproducibilidad en pipelines de IA. Para ciberseguridad, implementar zero-trust architecture con autenticación mutua en NV-Link previene insider threats. Monitoreo con Prometheus y Grafana integrado permite alertas predictivas basadas en ML para fallos hardware.

- Optimización Energética: Uso de DVFS (Dynamic Voltage and Frequency Scaling) en Grace CPUs para ajustar consumo dinámicamente.

- Escalabilidad de Red: Despliegue de InfiniBand NDR para latencies críticas en entrenamiento sincronizado.

- Gestión de Datos: Integración con Ceph para almacenamiento distribuido, soportando IOPS de millones en lecturas aleatorias.

Estas prácticas alinean con frameworks como NIST SP 800-53 para seguridad en HPC.

Conclusión: Hacia un Futuro de IA Sostenible y Segura

Las fábricas de IA de gigawatts, impulsadas por innovaciones como el proyecto OCP Vera Rubin de NVIDIA, redefinen los límites de la computación. Con avances en hardware, enfriamiento y redes, estas instalaciones no solo habilitan el entrenamiento de modelos de IA a escala masiva, sino que también abordan desafíos energéticos y de seguridad. En un ecosistema donde la IA intersecta con ciberseguridad y blockchain, Vera Rubin establece un estándar abierto para la colaboración industrial, prometiendo eficiencia operativa y resiliencia. Finalmente, la adopción generalizada de estas tecnologías acelerará innovaciones en sectores clave, asegurando un desarrollo responsable de la IA. Para más información, visita la Fuente original.