Sistemas de Recomendación en Plataformas de Video: El Caso del Desarrollo en VK Video

Introducción a los Sistemas de Recomendación

Los sistemas de recomendación representan un pilar fundamental en las plataformas digitales modernas, especialmente en entornos de video streaming donde la personalización del contenido es clave para retener a los usuarios. Estos sistemas utilizan algoritmos de inteligencia artificial y aprendizaje automático para analizar patrones de comportamiento, preferencias y contextos, generando sugerencias que maximizan la engagement y la satisfacción del usuario. En el contexto de VK Video, una plataforma rusa de video social, el desarrollo de tales sistemas implica la integración de tecnologías avanzadas de procesamiento de datos masivos, modelado predictivo y optimización en tiempo real.

Desde un punto de vista técnico, un sistema de recomendación típico se basa en enfoques colaborativos, basados en contenido y híbridos. Los métodos colaborativos aprovechan similitudes entre usuarios para predecir preferencias, mientras que los basados en contenido analizan atributos del ítem recomendado. En plataformas como VK Video, que maneja millones de interacciones diarias, la escalabilidad es crítica, requiriendo infraestructuras distribuidas como Apache Kafka para el streaming de datos y TensorFlow o PyTorch para el entrenamiento de modelos.

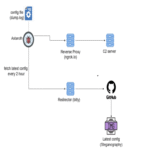

Arquitectura Técnica del Sistema en VK Video

La arquitectura de un sistema de recomendación en VK Video se diseña para manejar volúmenes masivos de datos en entornos de alta concurrencia. En primer lugar, se implementa una capa de recolección de datos que captura eventos como visualizaciones, likes, shares y tiempos de retención mediante APIs RESTful y WebSockets. Estos datos se almacenan en bases de datos NoSQL como Cassandra o MongoDB, optimizadas para lecturas y escrituras rápidas en escenarios de big data.

El procesamiento se realiza en dos etapas: offline y online. En la etapa offline, se utilizan frameworks como Apache Spark para el ETL (Extract, Transform, Load), donde se limpian y agregan datos históricos. Aquí, algoritmos de factorización de matrices, como Singular Value Decomposition (SVD) o Alternating Least Squares (ALS), descomponen matrices usuario-ítem para identificar factores latentes. Por ejemplo, un modelo podría representar a un usuario como un vector de 100 dimensiones que captura preferencias por géneros como comedia o documentales.

En la etapa online, se despliegan modelos en contenedores Docker con Kubernetes para orquestación, permitiendo inferencias en milisegundos. Se emplean técnicas de embedding, como Word2Vec adaptado a secuencias de videos, para generar representaciones vectoriales de contenidos. La integración con motores de búsqueda como Elasticsearch facilita la recuperación de candidatos, filtrados posteriormente por un ranker basado en redes neuronales profundas, como Multi-Layer Perceptrons (MLP) o Transformer models inspirados en BERT.

Algoritmos y Modelos de Aprendizaje Automático Utilizados

En el desarrollo de VK Video, se priorizan modelos que equilibren precisión y eficiencia computacional. Un enfoque común es el uso de Collaborative Filtering (CF) con k-Nearest Neighbors (k-NN), donde se calculan distancias coseno entre vectores de usuarios para encontrar vecinos similares. Sin embargo, para mitigar el problema de cold start —donde nuevos usuarios o videos carecen de datos—, se incorporan técnicas de content-based filtering que analizan metadatos como títulos, descripciones y tags mediante procesamiento de lenguaje natural (NLP).

Los modelos híbridos combinan CF con deep learning. Por instancia, un modelo como Neural Collaborative Filtering (NCF) integra embeddings de usuarios e ítems en una red neuronal que aprende interacciones no lineales. En términos matemáticos, dado un usuario u y un ítem i, el puntaje predicho ŷ_ui se computa como:

ŷ_ui = f(θ, u, i) = σ(MLP(concat(emb_u, emb_i)))

donde emb_u y emb_i son embeddings, MLP es la red neuronal y σ la función de activación sigmoid para normalizar entre 0 y 1.

Adicionalmente, se aplican técnicas de reinforcement learning para optimizar recomendaciones secuenciales, modelando el problema como un Markov Decision Process (MDP). El agente (recomendador) recibe recompensas basadas en métricas como click-through rate (CTR) o tiempo de visualización, utilizando algoritmos como Deep Q-Networks (DQN) para explorar-explorar en recomendaciones.

Desafíos en el Procesamiento de Datos Masivos

Uno de los principales desafíos en sistemas como el de VK Video es el manejo de datos masivos y heterogéneos. Con millones de videos subidos diariamente, el volumen de datos supera los petabytes, requiriendo particionamiento horizontal y sharding. Herramientas como Hadoop Distributed File System (HDFS) se utilizan para almacenamiento distribuido, mientras que Apache Flink procesa streams en tiempo real, detectando patrones emergentes como tendencias virales.

La privacidad de datos es otro aspecto crítico, alineado con regulaciones como GDPR o la ley rusa de protección de datos personales. Se implementan técnicas de anonimización, como k-anonymity o differential privacy, agregando ruido gaussiano a los datos durante el entrenamiento para prevenir inferencias sobre individuos específicos. En el entrenamiento de modelos, se aplica federated learning para mantener datos en dispositivos edge, reduciendo riesgos de brechas.

La escalabilidad se aborda mediante microservicios, donde cada componente —como el generador de candidatos o el ranker— se escala independientemente. Monitoreo con Prometheus y Grafana permite detectar bottlenecks, como latencias en inferencia superiores a 100ms, ajustando recursos dinámicamente via autoscaling en la nube.

Evaluación y Métricas de Desempeño

La evaluación de estos sistemas se realiza mediante métricas estándar en recommendation systems. La precisión se mide con Precision@K y Recall@K, donde K es el número de recomendaciones mostradas. Por ejemplo, Precision@10 indica la fracción de los top-10 ítems recomendados que el usuario interactúa. El NDCG (Normalized Discounted Cumulative Gain) penaliza recomendaciones irrelevantes en posiciones altas, calculado como:

NDCG@K = (DCG@K) / (IDCG@K)

donde DCG suma relevancias descontadas por posición, e IDCG es el ideal.

En VK Video, se complementan con métricas de negocio como session depth (profundidad de sesión) y churn rate. Pruebas A/B se despliegan para comparar variantes de modelos, utilizando banderas de feature flags en herramientas como LaunchDarkly. Resultados típicos muestran mejoras del 15-20% en CTR al integrar modelos híbridos versus baselines colaborativos puros.

Integración con Otras Tecnologías Emergentes

La evolución de los sistemas de recomendación en VK Video incorpora blockchain para transparencia en recomendaciones, aunque de manera limitada. Por ejemplo, se podrían usar smart contracts en Ethereum para auditar sesgos en modelos, asegurando que las recomendaciones no discriminen por demografía. Sin embargo, el foco principal permanece en IA, con exploraciones en generative AI para crear thumbnails personalizados o resúmenes de videos usando modelos como GPT variants adaptados.

En ciberseguridad, se implementan defensas contra ataques como shilling, donde usuarios falsos inflan ratings. Técnicas de detección de anomalías con Isolation Forests identifican patrones inusuales en interacciones, bloqueando IPs sospechosas via firewalls como iptables o WAF (Web Application Firewall).

La integración con edge computing, mediante CDNs como Akamai, reduce latencia al cachear recomendaciones cerca del usuario, mejorando la experiencia en redes móviles de baja bandwidth en regiones remotas de Rusia.

Implicaciones Operativas y Regulatorias

Operativamente, el despliegue de estos sistemas requiere DevOps practices robustas. CI/CD pipelines con Jenkins automatizan pruebas unitarias en modelos —usando bibliotecas como scikit-learn para validación cruzada— y despliegues blue-green para zero-downtime. El costo computacional es significativo; entrenamiento de un modelo en GPUs NVIDIA A100 puede tomar horas, optimizado con distributed training via Horovod.

Regulatoriamente, en el contexto ruso, se alinea con la Ley Federal 152-FZ sobre datos personales, requiriendo consentimiento explícito para tracking. Implicaciones globales incluyen compliance con CCPA en audiencias internacionales, promoviendo explainable AI (XAI) con técnicas como SHAP para interpretar predicciones y justificar recomendaciones a usuarios.

Riesgos incluyen sesgos algorítmicos, donde modelos entrenados en datos históricos perpetúan preferencias mayoritarias, excluyendo minorías. Mitigaciones involucran dataset augmentation y fairness constraints en la función de pérdida, como agregar términos de demographic parity.

Beneficios y Casos de Estudio