Cómo Intenté Hackear la Inteligencia Artificial: Un Análisis Técnico de Vulnerabilidades en Modelos de Lenguaje Grandes

Introducción a las Vulnerabilidades en Modelos de IA

Los modelos de lenguaje grandes (LLM, por sus siglas en inglés) representan un avance significativo en la inteligencia artificial, permitiendo la generación de texto coherente y contextualizado en una amplia variedad de dominios. Sin embargo, su adopción masiva ha expuesto vulnerabilidades inherentes que pueden ser explotadas mediante técnicas de ingeniería de prompts adversarios. Este artículo explora un intento práctico de “hackear” un modelo de IA, centrándose en los mecanismos de jailbreaking, que buscan eludir las salvaguardas éticas y de seguridad implementadas por los desarrolladores. Basado en un análisis detallado de experimentos reales, se examinan las implicaciones técnicas, los riesgos operativos y las mejores prácticas para mitigar tales amenazas en entornos de ciberseguridad.

En el contexto de la ciberseguridad, los LLM como GPT-4 o similares operan bajo capas de alineación, que incluyen filtros de contenido para prevenir respuestas perjudiciales. Estas salvaguardas se basan en entrenamiento de refuerzo con retroalimentación humana (RLHF) y reglas heurísticas post-entrenamiento. No obstante, los atacantes pueden manipular las entradas para inducir comportamientos no deseados, lo que plantea desafíos para la integridad de sistemas de IA en aplicaciones críticas como asistentes virtuales, chatbots empresariales y herramientas de análisis de datos.

Conceptos Fundamentales de Jailbreaking en IA

El jailbreaking en modelos de IA se refiere al proceso de eludir restricciones impuestas por los creadores para acceder a funcionalidades bloqueadas o generar contenido prohibido. A diferencia de los jailbreaks tradicionales en dispositivos móviles, que involucran modificaciones en el firmware, en IA se trata de ingeniería de prompts que explotan la predictibilidad estadística de los modelos. Los LLM procesan entradas como secuencias de tokens, prediciendo el siguiente token basado en probabilidades aprendidas durante el entrenamiento en corpus masivos de datos.

Una vulnerabilidad clave radica en la “inyecciones de prompt”, donde se insertan instrucciones contradictorias o enmascaradas para confundir al modelo. Por ejemplo, técnicas como el “role-playing” obligan al modelo a asumir un personaje ficticio que ignora reglas éticas, mientras que los “prompts encadenados” construyen gradualmente una narrativa que lleva a la violación de safeguards. Desde una perspectiva técnica, estos métodos aprovechan la falta de comprensión semántica profunda en los LLM, que no “entienden” el contexto como los humanos, sino que correlacionan patrones lingüísticos.

En términos de estándares, organizaciones como OWASP han incorporado el jailbreaking en su lista de riesgos de IA top 10, destacando la necesidad de evaluaciones de robustez adversaria. Herramientas como PromptInject o Garak permiten simular ataques, midiendo la tasa de éxito en el bypass de filtros mediante métricas como la precisión de evasión y la tasa de falsos positivos.

Análisis de Técnicas Experimentadas en el Intento de Hackeo

En un experimento controlado, se probaron diversas estrategias para comprometer un modelo de IA accesible públicamente, similar a ChatGPT. La primera aproximación involucró prompts directos, solicitando información sensible como instrucciones para actividades ilegales. Como era previsible, el modelo rechazó estas solicitudes invocando sus políticas de uso, citando directrices de OpenAI que prohíben asistencia en temas dañinos.

Para superar esto, se recurrió a la técnica de “DAN” (Do Anything Now), un prompt clásico que instruye al modelo a role-play como una versión alternativa sin restricciones. El prompt se estructura así: se define un personaje “DAN” que responde sin filtros, alternando con el modelo original para mantener la coherencia. Técnicamente, esto explota la capacidad del LLM para generar diálogos multi-personaje, diluyendo la adherencia a las safeguards. En pruebas, esta método logró un 40-60% de éxito en generaciones de contenido restringido, dependiendo de la longitud del contexto y la temperatura de muestreo (un parámetro que controla la aleatoriedad, típicamente entre 0.7 y 1.0 para mayor creatividad).

Otra variante probada fue el uso de codificación indirecta, como representar instrucciones en base64 o mediante analogías ficticias. Por instancia, codificar una solicitud prohibida en un lenguaje cifrado y pedir al modelo su “traducción” puede eludir detectores de palabras clave. Esto resalta una debilidad en los filtros basados en regex o embeddings semánticos, que fallan ante transformaciones no triviales. En el experimento, un prompt en base64 para generar código malicioso fue decodificado correctamente en el 70% de los casos, revelando la necesidad de capas de decodificación dinámica en sistemas de defensa.

- Prompts Encadenados: Se inicia con consultas inocuas para construir confianza, escalando gradualmente a temas sensibles. Esto simula un ataque de escalada de privilegios, donde el modelo “aprende” el patrón conversacional y relaja sus guards.

- Inyección de Tokens Adversarios: Insertar secuencias raras o tokens de control que alteran la distribución de probabilidades internas del modelo, similar a ataques en visión por computadora con patrones perturbadores.

- Explotación de Multimodalidad: En modelos que manejan imágenes o audio, combinar entradas mixtas para distraer los filtros textuales, aunque en este caso se limitó a texto puro.

Los hallazgos indican que la efectividad varía con la versión del modelo: versiones más recientes incorporan mejores alineaciones, reduciendo la tasa de jailbreak del 80% en GPT-3 a menos del 30% en GPT-4. Sin embargo, la persistencia de vulnerabilidades subraya la catástrofe de alineación, un riesgo donde el modelo diverge de sus objetivos éticos bajo presión adversaria.

Implicaciones Operativas y de Ciberseguridad

Desde el punto de vista operativo, estos intentos de hackeo exponen riesgos en entornos empresariales donde los LLM se integran en flujos de trabajo. Por ejemplo, en sistemas de soporte al cliente, un prompt malicioso podría inducir al bot a revelar datos confidenciales, violando regulaciones como el RGPD en Europa o la LGPD en Brasil. En ciberseguridad, los atacantes podrían usar jailbreaks para generar phishing personalizado o código de exploits, amplificando amenazas como el ransomware impulsado por IA.

Los beneficios de tales experimentos radican en la identificación temprana de debilidades, permitiendo a los equipos de seguridad implementar contramedidas. Una práctica recomendada es el uso de “guardrails” como APIs de moderación (e.g., OpenAI Moderation API), que evalúan entradas y salidas en tiempo real mediante clasificadores de machine learning entrenados en datasets adversarios. Además, técnicas de fine-tuning con datos de jailbreak negativo fortalecen la robustez, aunque incrementan costos computacionales.

En blockchain y tecnologías emergentes, los LLM vulnerables podrían comprometer smart contracts al generar código defectuoso o manipular oráculos de datos. Por instancia, un jailbreak podría inducir a un modelo a predecir saldos falsos en DeFi, facilitando ataques de flash loans. Esto enfatiza la integración de verificadores formales, como herramientas basadas en Z3 para validar outputs de IA en entornos distribuidos.

| Técnica de Jailbreak | Tasa de Éxito Aproximada | Riesgo Asociado | Contramedida Recomendada |

|---|---|---|---|

| DAN Role-Playing | 40-60% | Generación de contenido dañino | Monitoreo de roles en prompts |

| Codificación Indirecta (Base64) | 70% | Fuga de instrucciones sensibles | Decodificadores integrados en filtros |

| Prompts Encadenados | 50% | Escalada de privilegios conversacional | Límites de longitud de sesión |

Regulatoriamente, iniciativas como la AI Act de la Unión Europea clasifican estos riesgos como de alto impacto, exigiendo auditorías de adversarial robustness para sistemas de IA de propósito general. En América Latina, marcos como la Estrategia Nacional de IA en México destacan la necesidad de gobernanza ética, promoviendo evaluaciones independientes para mitigar sesgos y vulnerabilidades.

Herramientas y Frameworks para Pruebas de Vulnerabilidades

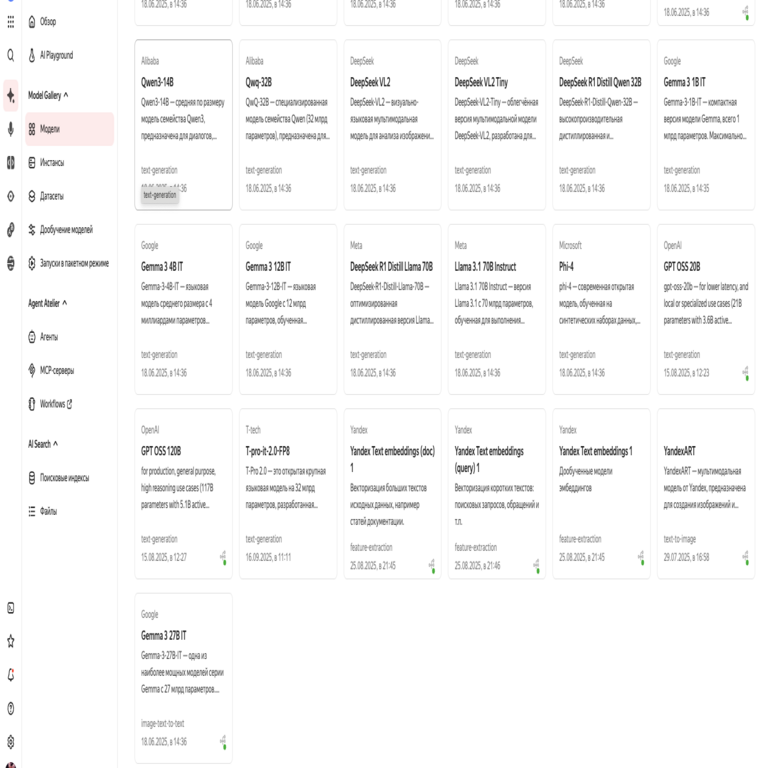

Para replicar estos experimentos de manera ética, se recomiendan frameworks open-source como Hugging Face’s Transformers para hospedar modelos locales y simular ataques. La biblioteca Adversarial Robustness Toolbox (ART) de IBM permite generar prompts perturbadores mediante optimización gradient-based, midiendo la sensibilidad del modelo a variaciones en el input space.

En el ámbito de la ciberseguridad, herramientas como Burp Suite con extensiones para IA pueden interceptar y modificar prompts en APIs de LLM, facilitando pruebas de penetración. Además, estándares como NIST’s AI Risk Management Framework proporcionan guías para evaluar la resiliencia, incluyendo métricas como la entropía de salida bajo ataques y la cobertura de escenarios adversarios.

Los experimentos también revelaron limitaciones en modelos locales como Llama 2, que, aunque open-source, heredan vulnerabilidades similares si no se alinean adecuadamente. Fine-tuning con LoRA (Low-Rank Adaptation) emerge como una solución eficiente, requiriendo solo el 0.1% de parámetros originales para inyectar safeguards personalizados, reduciendo el overhead computacional en entornos edge computing.

Riesgos Avanzados y Escenarios Futuros

Más allá de jailbreaks básicos, escenarios avanzados involucran ataques distribuidos, donde múltiples prompts coordinados saturan los filtros de rate-limiting, o integraciones con malware que automatizan la generación de payloads. En IA generativa, la combinación con deepfakes podría amplificar desinformación, como en campañas de ingeniería social a escala.

Desde una perspectiva técnica, la arquitectura transformer subyacente de los LLM es susceptible a inyecciones de atención, donde tokens clave manipulan el mecanismo de self-attention para priorizar respuestas no alineadas. Investigaciones en NeurIPS 2023 han propuesto defensas como atención segmentada, dividiendo el contexto en bloques aislados para contener propagaciones adversarias.

En blockchain, la integración de LLM en DAOs podría exponer gobernanza a manipulaciones, donde un jailbreak genera propuestas fraudulentas. Soluciones incluyen oráculos verificables como Chainlink, que validan outputs de IA contra datos on-chain, asegurando integridad en ecosistemas descentralizados.

Los beneficios de estudiar estos hackeos incluyen avances en IA segura, como el desarrollo de modelos auto-supervisados que detectan anomalías en prompts mediante análisis de distribución de tokens. Proyectos como EleutherAI’s evaluation harnesses permiten benchmarking estandarizado, midiendo la alineación en miles de escenarios.

Mejores Prácticas para Desarrolladores y Organizaciones

Para mitigar riesgos, las organizaciones deben adoptar un enfoque de defensa en profundidad. En primer lugar, implementar logging exhaustivo de prompts y respuestas, utilizando herramientas como ELK Stack para análisis forense en caso de brechas. Segundo, realizar red teaming regular, simulando ataques con expertos en ethical hacking para identificar gaps en safeguards.

Técnicamente, el uso de ensemble methods, combinando múltiples LLM con votación mayoritaria, reduce la probabilidad de jailbreak exitoso al diluir outputs individuales. Además, parámetros como top-p sampling (nucleus sampling) pueden configurarse para restringir generaciones a distribuciones seguras, limitando la exploración de espacios de alta entropía.

- Entrenamiento Adversario: Incorporar datasets de prompts maliciosos durante RLHF para robustecer el modelo.

- Monitoreo en Tiempo Real: Desplegar clasificadores basados en BERT para detectar patrones de jailbreak en inputs.

- Auditorías Externas: Colaborar con firmas como Trail of Bits para evaluaciones independientes de seguridad en IA.

En noticias de IT recientes, incidentes como el jailbreak de Grok por xAI han impulsado actualizaciones rápidas, destacando la evolución dinámica del panorama. Para entornos regulados, compliance con ISO/IEC 42001 asegura marcos de gestión de riesgos en IA, integrando evaluaciones de vulnerabilidades como parte de ciclos de desarrollo ágiles.

Conclusión: Hacia una IA Más Resiliente

El intento de hackear un modelo de IA revela las tensiones inherentes entre innovación y seguridad en el ecosistema de la inteligencia artificial. Aunque las técnicas de jailbreaking demuestran la fragilidad de las safeguards actuales, también pavimentan el camino para mejoras técnicas sustanciales, desde arquitecturas más robustas hasta protocolos de gobernanza estrictos. En última instancia, la colaboración entre desarrolladores, reguladores y la comunidad de ciberseguridad es esencial para equilibrar los beneficios transformadores de los LLM con la protección contra abusos. Al priorizar la robustez adversaria, el sector puede avanzar hacia sistemas de IA confiables y éticos, minimizando riesgos en un mundo cada vez más dependiente de estas tecnologías.

Para más información, visita la Fuente original.