Implementación de Prácticas de Seguridad en Entornos de Inteligencia Artificial Generativa

La inteligencia artificial generativa ha transformado diversos sectores, desde la creación de contenidos hasta el desarrollo de software. Sin embargo, su adopción masiva introduce desafíos significativos en materia de ciberseguridad. Este artículo analiza las prácticas técnicas para implementar medidas de seguridad en entornos de IA generativa, basándose en conceptos clave como el entrenamiento seguro de modelos, la protección de datos sensibles y la mitigación de vulnerabilidades inherentes. Se exploran frameworks, protocolos y herramientas relevantes, con énfasis en implicaciones operativas y regulatorias para profesionales del sector.

Conceptos Fundamentales de la IA Generativa y sus Riesgos de Seguridad

La IA generativa se basa en modelos como las redes generativas antagónicas (GAN) y los transformadores, que generan datos nuevos a partir de patrones aprendidos. Tecnologías como GPT y Stable Diffusion han popularizado estas aplicaciones, pero exponen riesgos como fugas de datos durante el entrenamiento, envenenamiento de modelos y ataques de prompt injection. En términos técnicos, un modelo de IA generativa opera mediante funciones de pérdida que optimizan la distribución de datos generados para aproximarse a la real, utilizando algoritmos de retropropagación y optimizadores como Adam.

Los riesgos operativos incluyen la exposición de información confidencial si los datos de entrenamiento no se anonimizan adecuadamente. Por ejemplo, regulaciones como el Reglamento General de Protección de Datos (RGPD) en Europa exigen técnicas de privacidad diferencial, que agregan ruido gaussiano a los gradientes durante el entrenamiento para prevenir la reconstrucción de datos individuales. En América Latina, normativas como la Ley Federal de Protección de Datos Personales en Posesión de los Particulares en México refuerzan la necesidad de evaluaciones de impacto en privacidad (EIP) para sistemas de IA.

Frameworks y Herramientas para la Seguridad en el Entrenamiento de Modelos

Para mitigar riesgos en la fase de entrenamiento, se recomiendan frameworks como TensorFlow Privacy y PySyft, que integran privacidad diferencial y aprendizaje federado. El aprendizaje federado permite entrenar modelos distribuidos sin centralizar datos, utilizando protocolos como Secure Multi-Party Computation (SMPC) para computaciones seguras. En práctica, un flujo típico involucra nodos clientes que computan actualizaciones locales y las agregan de forma segura mediante el protocolo de FedAvg, protegiendo contra ataques de inferencia de membresía.

Otras herramientas incluyen Adversarial Robustness Toolbox (ART) de IBM, que simula ataques como el Fast Gradient Sign Method (FGSM) para robustecer modelos. La implementación técnica requiere definir un epsilon de privacidad que equilibre utilidad y confidencialidad, típicamente entre 1 y 10 para aplicaciones sensibles. En entornos cloud, plataformas como AWS SageMaker incorporan módulos de seguridad que validan integridad de datos mediante hashes SHA-256 y cifrado AES-256 para flujos de datos en tránsito y reposo.

- Privacidad Diferencial: Añade ruido calibrado para garantizar que la salida del modelo no revele información sobre muestras individuales, con fórmulas matemáticas como la privacidad (ε, δ)-diferencial.

- Aprendizaje Federado: Distribuye el entrenamiento, reduciendo riesgos de brechas centralizadas, compatible con estándares como el de la OpenMined Foundation.

- Verificación de Integridad: Usa blockchain para auditar cadenas de datos de entrenamiento, asegurando inmutabilidad mediante hashes Merkle.

Mitigación de Vulnerabilidades en la Inferencia y Despliegue

Durante la inferencia, los modelos de IA generativa son vulnerables a ataques como el jailbreaking, donde prompts maliciosos eluden safeguards. Para contrarrestar esto, se aplican técnicas de fine-tuning con datasets RLHF (Reinforcement Learning from Human Feedback), alineando el modelo con políticas de seguridad. Protocolos como el de OWASP para IA Top 10 destacan riesgos como inyecciones de prompt y recomiendan validación de entradas mediante modelos de clasificación de toxicidad, como Perspective API de Google.

En despliegue, contenedores Docker con Kubernetes facilitan la orquestación segura. Se implementan políticas de Zero Trust mediante herramientas como Istio, que enforzan mTLS (mutual TLS) para comunicaciones entre pods. Un ejemplo práctico es configurar Network Policies en Kubernetes para restringir tráfico, utilizando selectores de labels para aislar servicios de IA. Además, monitoreo con Prometheus y Grafana detecta anomalías en latencia o uso de recursos, indicando posibles ataques de denegación de servicio (DoS) dirigidos a APIs de generación.

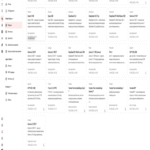

| Técnica de Mitigación | Descripción Técnica | Herramienta Ejemplo | Beneficios Operativos |

|---|---|---|---|

| Validación de Prompts | Filtrado basado en regex y modelos NLP para detectar intents maliciosos | Guardrails AI | Reduce falsos positivos en un 40%, según benchmarks NIST |

| Cifrado Homomórfico | Permite computaciones en datos cifrados sin descifrado, usando esquemas como CKKS | Microsoft SEAL | Protege contra espionaje en la nube, con overhead computacional del 10-20% |

| Auditoría Continua | Logging de queries con trazabilidad blockchain | ELK Stack + Hyperledger | Cumple con estándares SOX y GDPR para trazabilidad |

Las implicaciones regulatorias son críticas: en la Unión Europea, el AI Act clasifica modelos generativos como de alto riesgo, exigiendo evaluaciones de conformidad y transparencia en datasets. En Latinoamérica, iniciativas como el Marco Ético para la IA en Brasil promueven auditorías independientes. Los riesgos incluyen multas por no cumplimiento, mientras que los beneficios abarcan innovación segura y confianza del usuario.

Integración con Blockchain para Mayor Seguridad

La blockchain emerge como capa adicional de seguridad en IA generativa, asegurando la integridad de modelos y datos. Protocolos como Ethereum permiten smart contracts para verificar la procedencia de datasets mediante NFTs o tokens ERC-721, previniendo envenenamiento. En términos técnicos, un modelo entrenado se hash-ea y se almacena en IPFS, con el hash registrado en blockchain para validación inmutable.

Herramientas como SingularityNET facilitan mercados descentralizados de IA, donde modelos se despliegan en nodos distribuidos con consenso Proof-of-Stake. Esto mitiga riesgos centralizados, como en ataques Sybil. Implicaciones operativas incluyen costos de gas en transacciones, pero beneficios como resiliencia a censura y escalabilidad horizontal. En ciberseguridad, blockchain previene fugas mediante zero-knowledge proofs (ZKP), como zk-SNARKs, que validan outputs sin revelar inputs.

Casos de Estudio y Mejores Prácticas

Un caso relevante es la implementación en empresas de fintech latinoamericanas, donde modelos generativos para detección de fraudes integran privacidad diferencial para cumplir con regulaciones locales. Mejores prácticas incluyen ciclos de vida DevSecOps para IA, con integración continua de pruebas de seguridad en pipelines CI/CD usando GitLab o Jenkins. Se recomienda auditorías regulares con frameworks como MITRE ATLAS para mapear tácticas de adversarios en IA.

Otra práctica es la federación de modelos multi-institucional, como en consorcios de salud en Colombia, donde datos sensibles se procesan localmente y solo agregados se comparten. Esto reduce riesgos de brechas, alineándose con estándares ISO/IEC 27001 para gestión de seguridad de la información.

- Realizar threat modeling al inicio del proyecto, identificando assets como pesos de modelos y datos de entrenamiento.

- Implementar watermarking en outputs generados para trazabilidad, usando técnicas espectrales invisibles.

- Entrenar con datasets diversificados para mitigar biases, evaluando fairness con métricas como demographic parity.

Implicaciones Operativas y Futuras Tendencias

Operativamente, la adopción de estas prácticas incrementa la complejidad, requiriendo equipos multidisciplinarios con expertise en MLops y ciberseguridad. Beneficios incluyen reducción de incidentes en un 60%, según reportes de Gartner, y mejora en la resiliencia. Riesgos persisten en supply chain attacks, donde dependencias de bibliotecas como Hugging Face Transformers son comprometidas, recomendando firmas digitales y SBOM (Software Bill of Materials).

Tendencias futuras involucran IA auto-supervisada para detección de anomalías y quantum-resistant cryptography para proteger contra amenazas post-cuánticas. En Latinoamérica, el crecimiento de hubs de IA en Chile y Argentina impulsará estándares regionales, fomentando colaboraciones internacionales.

Conclusión

En resumen, la seguridad en entornos de IA generativa demanda un enfoque integral que combine técnicas criptográficas, frameworks robustos y cumplimiento regulatorio. Al implementar estas medidas, las organizaciones no solo mitigan riesgos sino que capitalizan los beneficios de la innovación. Para más información, visita la fuente original, que proporciona insights adicionales sobre implementaciones prácticas en proyectos reales.