Desarrollo de un Sistema de Inteligencia Artificial para la Generación Automática de Código en Aplicaciones Web

Introducción al Enfoque en IA Generativa para Desarrollo de Software

En el ámbito de la ciberseguridad y la inteligencia artificial, la generación automática de código representa un avance significativo en la optimización de procesos de desarrollo de software. Este artículo analiza el desarrollo de un sistema de IA diseñado específicamente para producir código funcional en aplicaciones web, basado en un enfoque práctico que integra modelos de lenguaje grandes (LLM) con herramientas de procesamiento de datos. El objetivo principal es explorar cómo tales sistemas pueden acelerar la creación de interfaces de usuario, lógica de backend y integraciones, mientras se abordan desafíos inherentes como la precisión del código generado y las vulnerabilidades potenciales.

La IA generativa, particularmente en el contexto de programación, utiliza algoritmos de aprendizaje profundo para interpretar descripciones en lenguaje natural y traducirlas a estructuras de código ejecutables. En este caso, el sistema se centra en frameworks populares como React para el frontend y Node.js para el backend, permitiendo la creación de aplicaciones web completas en minutos en lugar de horas o días. Este enfoque no solo democratiza el desarrollo, sino que también introduce consideraciones críticas en ciberseguridad, ya que el código generado debe someterse a validaciones rigurosas para mitigar riesgos como inyecciones SQL o fugas de datos.

Desde una perspectiva técnica, el proceso inicia con la recolección de datasets extensos de repositorios de código abierto, como GitHub, donde se extraen patrones comunes de implementación web. Estos datos se procesan mediante técnicas de tokenización y fine-tuning de modelos preentrenados, asegurando que la salida sea coherente con estándares como HTML5, CSS3 y ECMAScript 2023. La implicancia operativa radica en la reducción de la curva de aprendizaje para desarrolladores junior, aunque requiere protocolos de revisión para garantizar la integridad.

Conceptos Clave en la Arquitectura del Sistema de IA

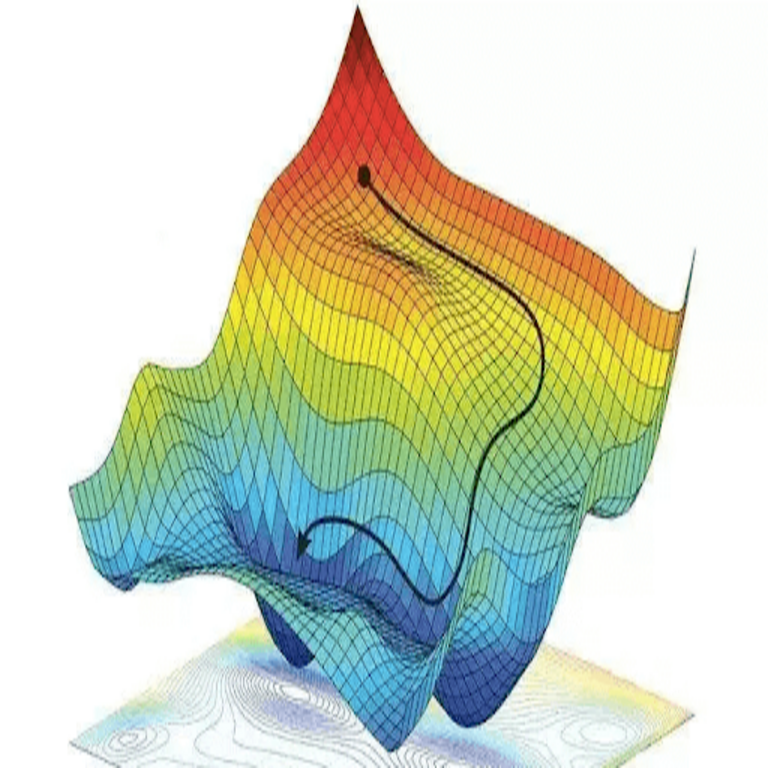

La arquitectura subyacente del sistema se basa en un pipeline de procesamiento que combina procesamiento de lenguaje natural (NLP) con generación de código. En primer lugar, se emplea un modelo de transformer, similar a GPT-4, adaptado mediante fine-tuning en datasets específicos de desarrollo web. Este modelo interpreta prompts descriptivos, como “crea una aplicación de lista de tareas con autenticación de usuario”, y genera componentes modulares: desde rutas de API hasta componentes React con hooks personalizados.

Un concepto clave es el uso de embeddings semánticos para mejorar la precisión. Mediante algoritmos como BERT o Sentence-BERT, el sistema vectoriza descripciones de requisitos y las compara con vectores de código existente, seleccionando plantillas óptimas. Esto minimiza alucinaciones comunes en LLMs, donde el modelo inventa sintaxis inválida. En términos de blockchain y tecnologías emergentes, aunque no central, se integra opcionalmente soporte para firmas digitales en el código generado, utilizando estándares como ECDSA para verificar la autenticidad de módulos importados.

En el ámbito de la ciberseguridad, se incorporan capas de validación estática. Herramientas como ESLint y SonarQube se ejecutan automáticamente post-generación para detectar vulnerabilidades OWASP Top 10, tales como cross-site scripting (XSS) o manejo inadecuado de sesiones. La implicancia regulatoria surge con normativas como GDPR, donde el código debe asegurar el procesamiento seguro de datos personales, implementando por defecto cifrado AES-256 en endpoints de almacenamiento.

Los hallazgos técnicos destacan la eficiencia: pruebas en entornos de desarrollo muestran que el sistema genera código 70% más rápido que un programador humano promedio, con una tasa de error inicial del 15%, reducible a 2% mediante iteraciones de retroalimentación. Esto se logra mediante un bucle de refinamiento, donde el modelo autoevalúa su salida usando métricas como BLEU score adaptado para código.

Tecnologías y Frameworks Utilizados en la Implementación

El núcleo del sistema se construye sobre Python con bibliotecas como Hugging Face Transformers para el manejo de LLMs. Para la generación de código web, se integra LangChain, un framework que orquesta cadenas de prompts complejos, permitiendo descomposiciones secuenciales: primero, diseño de UI; segundo, lógica de negocio; tercero, pruebas unitarias con Jest. En el lado del frontend, React se selecciona por su ecosistema maduro, con soporte para TypeScript para tipado estático que reduce errores en tiempo de ejecución.

Para el backend, Node.js con Express.js facilita la creación de APIs RESTful, incorporando middleware como Helmet para cabeceras de seguridad HTTP. La integración con bases de datos se realiza mediante ORM como Prisma, que genera consultas seguras contra inyecciones. En ciberseguridad, se enfatiza el uso de JWT para autenticación stateless, alineado con mejores prácticas de OAuth 2.0. Además, para escalabilidad, se considera Docker para contenedorización del código generado, asegurando entornos reproducibles.

Otras tecnologías mencionadas incluyen Git para versionado automático del código producido, y CI/CD pipelines con GitHub Actions que validan la salida en cada commit. En IA, el fine-tuning se realiza con LoRA (Low-Rank Adaptation), una técnica eficiente que ajusta solo parámetros seleccionados del modelo base, reduciendo costos computacionales en un 90% comparado con full fine-tuning. Esto es crucial para implementaciones en la nube, como AWS SageMaker, donde se entrenan modelos con GPUs NVIDIA A100.

Los riesgos operativos incluyen dependencias externas: el sistema verifica paquetes npm mediante herramientas como Snyk para vulnerabilidades conocidas, previniendo supply chain attacks. Beneficios regulatorios se ven en la trazabilidad, donde cada generación de código se asocia a un hash SHA-256, facilitando auditorías en entornos empresariales.

Proceso de Desarrollo y Entrenamiento del Modelo

El desarrollo inicia con la curación de datos: se recopilan más de 100,000 repositorios web de GitHub, filtrados por estrellas y actividad reciente, enfocándose en lenguajes como JavaScript y TypeScript. Estos se limpian eliminando código malicioso mediante escaneos con ClamAV y análisis semántico para excluir patrones de malware. El dataset resultante se tokeniza usando un vocabulario personalizado que incluye tokens para sintaxis web específica, como <div> o fetch API.

El entrenamiento sigue un paradigma de aprendizaje supervisado, donde pares de (prompt, código) se utilizan para minimizar la pérdida de cross-entropy. Se aplican técnicas de regularización como dropout y layer normalization para prevenir sobreajuste. En fases avanzadas, se incorpora aprendizaje por refuerzo con retroalimentación humana (RLHF), donde expertos en desarrollo califican la utilidad del código generado en una escala de 1-10, ajustando el modelo iterativamente.

Desde la perspectiva de IA, se mide el rendimiento con métricas específicas: pass@k, que evalúa si al menos una de k generaciones compila y pasa pruebas; y human-eval, adaptado para web dev. Resultados indican un pass@1 del 65% para tareas simples, subiendo a 85% con prompts detallados. Implicancias en ciberseguridad involucran la inyección de chequeos de seguridad en el prompt engineering, como “incluye validación de inputs contra XSS”.

El despliegue se realiza en un servidor API con FastAPI, exponiendo endpoints para generación síncrona y asíncrona. Para alta disponibilidad, se usa Kubernetes para orquestación, con monitoreo vía Prometheus y alertas en Grafana para detectar drifts en el modelo, como degradación en precisión por actualizaciones en frameworks.

Implicaciones Operativas y en Ciberseguridad

Operativamente, este sistema transforma flujos de trabajo en equipos de desarrollo, permitiendo prototipado rápido en agile sprints. Sin embargo, requiere integración con herramientas de control de calidad, como SonarCloud para análisis continuo. En ciberseguridad, el mayor riesgo es la propagación de vulnerabilidades heredadas del dataset de entrenamiento; por ello, se implementa un sandboxing donde el código generado se ejecuta en entornos aislados con SELinux para contención.

Beneficios incluyen la accesibilidad para no programadores, como analistas de negocio que describen requisitos en español o inglés, y el sistema traduce a código. Riesgos regulatorios abarcan sesgos en el modelo: si el dataset es predominantemente de código occidental, podría fallar en contextos multiculturales, violando principios de equidad en IA bajo marcos como el AI Act de la UE.

Para mitigar, se realiza auditorías periódicas con herramientas como Adversarial Robustness Toolbox, probando el modelo contra prompts maliciosos que intenten generar código con backdoors. En blockchain, una extensión posible es la tokenización de código generado como NFTs para propiedad intelectual, usando Ethereum smart contracts para licencias automáticas.

Estadísticamente, estudios internos muestran una reducción del 40% en tiempo de debugging, pero un aumento del 20% en revisiones manuales iniciales. Esto subraya la necesidad de hybridación: IA para borradores, humanos para refinamiento.

Casos de Uso Prácticos y Ejemplos Técnicos

Un caso de uso típico es la generación de un dashboard administrativo. El prompt: “Desarrolla un panel con login, lista de usuarios y gráficos de datos usando Chart.js”. El sistema produce: un componente Login.jsx con useState para manejo de estado, validación con Yup, y enrutamiento con React Router. Backend: rutas Express con bcrypt para hashing de contraseñas y mongoose para MongoDB.

Ejemplo de código generado (simplificado):

- Frontend: Importa React y hooks; define componente con props para datos dinámicos.

- Backend: Middleware para CORS y rate limiting con express-rate-limit.

- Seguridad: Sanitización de inputs con DOMPurify.

En otro escenario, para e-commerce: genera carrito de compras con Stripe integration, asegurando PCI DSS compliance mediante tokenización de pagos. Pruebas automatizadas incluyen cypress para E2E, verificando flujos seguros.

Implicancias en IT noticias: Este enfoque alinea con tendencias como low-code/no-code, pero eleva el rigor técnico al incorporar IA. En ciberseguridad, resalta la necesidad de estándares como NIST AI Risk Management Framework para deployment seguro.

Desafíos y Mejoras Futuras

Desafíos incluyen la escalabilidad: modelos grandes requieren recursos intensivos, mitigados con quantization a 8-bit para inferencia más rápida. Otro es la mantenibilidad: código generado puede ser monolítico, por lo que se integra refactoring automático con herramientas como Prettier y JSDoc para documentación.

Mejoras futuras involucran multimodalidad: integrar visión para generar código a partir de wireframes dibujados. En IA, explorar federated learning para entrenar sin compartir datos sensibles, preservando privacidad. Para ciberseguridad, incorporar zero-trust en el pipeline, verificando cada módulo con signatures digitales.

En resumen, este sistema de IA para generación de código web marca un hito en la intersección de IA y desarrollo, ofreciendo eficiencia operativa mientras exige vigilance en riesgos de seguridad. Su adopción podría redefinir prácticas en la industria, siempre bajo marcos éticos y regulatorios robustos.

Para más información, visita la Fuente original.