Aumento de Ciberataques Impulsados por Inteligencia Artificial Vinculados a Actores de Amenazas Rusos en Ucrania

Introducción al Contexto Geopolítico y Cibernético

En el marco del conflicto prolongado entre Rusia y Ucrania, los ciberataques han emergido como una herramienta estratégica clave para los actores de amenazas estatales. Recientemente, se ha observado un incremento significativo en el empleo de inteligencia artificial (IA) por parte de grupos vinculados al gobierno ruso, dirigidos principalmente contra infraestructuras críticas ucranianas. Este fenómeno no solo representa una evolución en las tácticas de guerra cibernética, sino que también plantea desafíos inéditos para la ciberseguridad global. La integración de IA en operaciones ofensivas permite a los atacantes automatizar procesos complejos, mejorar la precisión de los ataques y evadir mecanismos de detección tradicionales.

Según informes de inteligencia cibernética, grupos como Sandworm, atribuido al Servicio de Seguridad Federal de Rusia (FSB), han incorporado herramientas de IA para potenciar campañas de phishing avanzado, generación de deepfakes y desarrollo de malware adaptable. Este artículo analiza en profundidad los aspectos técnicos de estos ataques, sus implicaciones operativas y las estrategias de mitigación recomendadas para organizaciones expuestas a amenazas similares. El enfoque se centra en la comprensión técnica de cómo la IA transforma las operaciones de amenaza persistente avanzada (APT), destacando protocolos, frameworks y estándares relevantes en el campo de la ciberseguridad.

Evolución de las Amenazas Cibernéticas en el Conflicto Ruso-Ucraniano

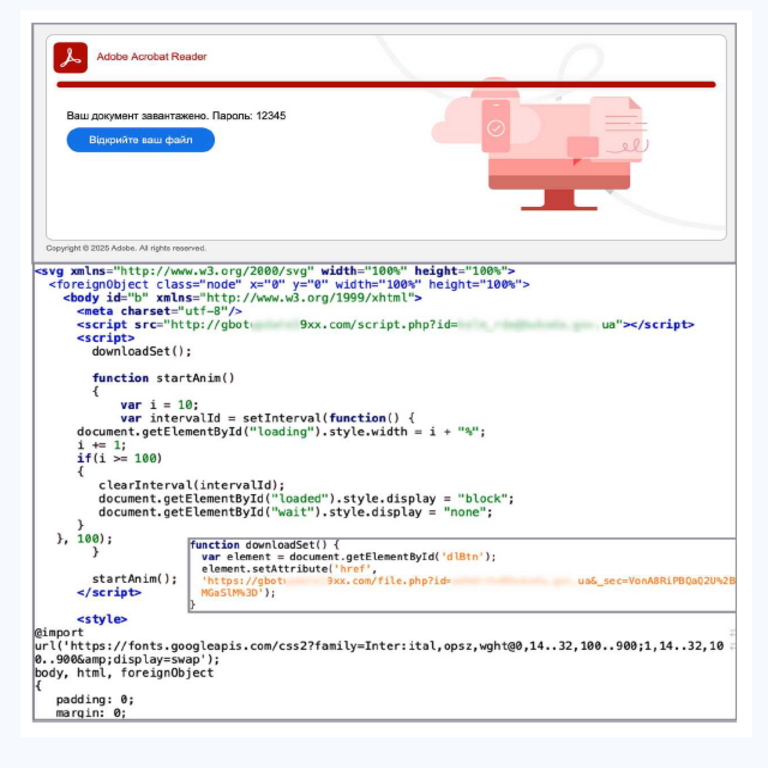

Desde la invasión rusa a Ucrania en 2022, el panorama cibernético ha experimentado una intensificación de actividades maliciosas. Inicialmente, los ataques se centraban en disrupciones de servicios públicos, como el ransomware NotPetya en 2017, que afectó sistemas globales pero tuvo un impacto inicial en Ucrania. Con el avance del conflicto, los actores de amenazas han adoptado IA para escalar sus capacidades. Por ejemplo, el uso de modelos de lenguaje grandes (LLM) como variantes de GPT ha permitido la creación de correos electrónicos de spear-phishing personalizados que imitan estilos de comunicación auténticos de ejecutivos o entidades gubernamentales.

Técnicamente, estos ataques aprovechan frameworks de machine learning abiertos, como TensorFlow o PyTorch, para entrenar modelos en datasets de comunicaciones ucranianas recolectadas previamente mediante espionaje digital. El proceso implica el preprocesamiento de datos con técnicas de procesamiento de lenguaje natural (NLP), donde algoritmos como BERT o transformers generan texto coherente y contextualizado. Esto contrasta con métodos tradicionales de phishing, que dependen de plantillas genéricas y son fácilmente detectables por filtros basados en reglas.

Además, la IA facilita la evasión de sistemas de detección de intrusiones (IDS). Mediante aprendizaje por refuerzo, los malware impulsados por IA pueden mutar su código en tiempo real, adaptándose a firmas antivirus conocidas. Un ejemplo es el empleo de redes neuronales generativas antagónicas (GAN) para alterar payloads maliciosos, manteniendo su funcionalidad mientras evaden escaneos heurísticos. En el contexto ucraniano, estos vectores han sido dirigidos contra sectores como energía, finanzas y defensa, alineándose con doctrinas de guerra híbrida que combinan operaciones cinéticas y cibernéticas.

Grupos de Amenazas Específicos y sus Herramientas de IA

Entre los actores principales se encuentra Sandworm, un grupo APT conocido por operaciones como el ataque a la red eléctrica ucraniana en 2015 y el despliegue de Industroyer en 2016. Recientes análisis indican que Sandworm ha integrado IA en sus toolkits para automatizar la reconnaissance y la explotación de vulnerabilidades. Por instancia, bots impulsados por IA realizan escaneos de red masivos, utilizando algoritmos de clustering para identificar activos críticos en entornos OT (tecnología operativa), como plantas de generación eléctrica.

Otro grupo relevante es Gamaredon, también ligado a inteligencia rusa, que ha empleado IA para generar deepfakes en campañas de desinformación. Estos deepfakes, creados con herramientas como DeepFaceLab o Faceswap, involucran modelos de IA que sintetizan videos y audios falsos de funcionarios ucranianos, propagados a través de redes sociales para socavar la moral pública. Técnicamente, el proceso comienza con la recolección de datos biométricos públicos, seguida de entrenamiento de autoencoders para mapear rostros y voces. El resultado son artefactos multimedia convincentes que superan verificaciones manuales, requiriendo contramedidas avanzadas como análisis forense de IA.

En términos de malware, variantes como WhisperGate, utilizado en ataques iniciales de 2022, han evolucionado con componentes de IA. Estos incluyen módulos de toma de decisiones autónomas, donde el malware evalúa entornos en runtime usando modelos de decisión basados en árboles o redes bayesianas para priorizar objetivos. Frameworks como scikit-learn facilitan la implementación de estos elementos, permitiendo que el malware se propague lateralmente en redes segmentadas, explotando debilidades en protocolos como Modbus o DNP3 en sistemas ICS (sistemas de control industrial).

- Reconocimiento impulsado por IA: Uso de crawlers web con NLP para mapear perfiles de empleados y vulnerabilidades zero-day en software ucraniano.

- Phishing avanzado: Generación de correos con LLM, incorporando datos de OSINT (inteligencia de fuentes abiertas) para personalización.

- Deepfakes y desinformación: Síntesis multimedia con GAN para campañas psicológicas.

- Malware adaptable: Mutación dinámica mediante aprendizaje automático para evadir EDR (detección y respuesta en endpoints).

Estos grupos operan bajo marcos como MITRE ATT&CK, donde tácticas como TA0001 (Reconocimiento) y TA0002 (Ejecución Inicial) se potencian con IA, elevando la sofisticación de las cadenas de ataque.

Implicaciones Técnicas y Operativas de los Ataques con IA

La adopción de IA en ciberataques introduce riesgos operativos multifacéticos. En primer lugar, la velocidad de ejecución: mientras un analista humano podría tardar horas en crafting un phishing, un modelo de IA lo hace en segundos, permitiendo campañas a escala masiva. Esto sobrecarga centros de operaciones de seguridad (SOC), donde herramientas tradicionales como SIEM (gestión de eventos e información de seguridad) luchan por procesar volúmenes de alertas generados por IA.

Desde una perspectiva técnica, los ataques con IA explotan asimetrías en recursos computacionales. Los atacantes, respaldados por estados, acceden a clústeres de GPU para entrenar modelos, mientras las defensas ucranianas dependen de infraestructuras limitadas. Implicaciones regulatorias incluyen la necesidad de actualizar marcos como el NIST Cybersecurity Framework para incorporar evaluaciones de riesgos de IA, o la GDPR en Europa para manejar datos biométricos en deepfakes.

Riesgos adicionales abarcan la propagación transfronteriza: un deepfake ucraniano podría influir en opiniones globales, afectando mercados financieros o alianzas NATO. Beneficios para los atacantes incluyen la denegabilidad plausible, ya que la IA genera contenido que parece orgánico, complicando la atribución bajo estándares como los de la convención de Budapest sobre cibercrimen.

En entornos ICS, la IA permite ataques de denegación de servicio adaptativos (DDoS), donde algoritmos predictivos ajustan flujos de tráfico para maximizar disrupciones en protocolos como IEC 61850 en subestaciones eléctricas. Esto requiere defensas como segmentación de red basada en zero-trust y monitoreo con IA defensiva, utilizando modelos de anomalía detection como isolation forests.

Estrategias de Mitigación y Mejores Prácticas

Para contrarrestar estos ataques, las organizaciones deben adoptar un enfoque multicapa. En primer lugar, la implementación de autenticación multifactor (MFA) basada en hardware, como tokens YubiKey, reduce la efectividad del phishing de credenciales. Técnicamente, integrar MFA con protocolos como FIDO2 asegura que incluso correos generados por IA no comprometan accesos.

En el ámbito de la detección, herramientas de IA defensiva son esenciales. Plataformas como Darktrace o Vectra AI emplean aprendizaje no supervisado para identificar patrones anómalos en tráfico de red, superando limitaciones de firmas estáticas. Para deepfakes, soluciones forenses como Microsoft Video Authenticator analizan inconsistencias en frames de video mediante detección de manipulación digital, basada en métricas como PSNR (relación señal-ruido pico).

Entrenamiento y concienciación son pilares clave. Programas de simulación de phishing con IA, como los ofrecidos por KnowBe4, preparan a usuarios para reconocer artefactos sutiles en comunicaciones generadas por máquinas. A nivel operativo, adherirse a estándares como ISO 27001 para gestión de seguridad de la información, con énfasis en auditorías de IA, mitiga riesgos internos.

Colaboración internacional es crucial. Iniciativas como el Cyber Threat Alliance permiten compartir inteligencia sobre campañas de IA, utilizando formatos estandarizados como STIX/TAXII para intercambio de indicadores de compromiso (IoC). En Ucrania, alianzas con firmas como ESET y Cisco han fortalecido capacidades, implementando honeypots con IA para atraer y estudiar atacantes.

| Componente de Ataque | Técnica de IA Utilizada | Estrategia de Mitigación |

|---|---|---|

| Phishing | LLM para generación de texto | Filtros NLP y MFA |

| Deepfakes | GAN para síntesis multimedia | Análisis forense y verificación blockchain |

| Malware | Aprendizaje por refuerzo para mutación | EDR con ML y sandboxing |

| DDoS | Algoritmos predictivos | Scrubbers de tráfico y rate limiting |

Estas estrategias no solo protegen activos inmediatos, sino que fomentan resiliencia a largo plazo en entornos de alta amenaza.

Análisis de Casos Específicos y Lecciones Aprendidas

Un caso emblemático es el ataque de 2023 contra el Ministerio de Defensa ucraniano, donde spear-phishing con IA generó correos que imitaban órdenes clasificadas, llevando a clics en enlaces maliciosos. El malware desplegado, una variante de Cobalt Strike con módulos de IA, exfiltró datos sensibles mediante compresión adaptativa para evadir límites de ancho de banda. Análisis post-mortem reveló el uso de embeddings de texto para contextualizar payloads, destacando la necesidad de segmentación de datos sensibles bajo marcos como GDPR.

Otro incidente involucró deepfakes de Zelenskyy, creados con herramientas de IA accesibles, que circularon en Telegram para sembrar confusión. La respuesta ucraniana incluyó despliegue de bots de verificación basados en IA, que cruzan referencias con fuentes oficiales usando grafos de conocimiento. Lecciones incluyen la importancia de diversidad en datasets de entrenamiento para defensas de IA, evitando sesgos que podrían ser explotados por atacantes.

En el sector energético, ataques a Ukrenergo utilizaron IA para predecir patrones de mantenimiento, timing exploits en SCADA systems. Esto subraya la integración de IA en simulaciones de respuesta a incidentes, como ejercicios de tabletop con escenarios generados por Monte Carlo methods para modelar impactos.

Desafíos Éticos y Regulatorios en la Guerra Cibernética con IA

La weaponización de IA plantea dilemas éticos, como el potencial para escalada autónoma en ataques, donde sistemas de IA toman decisiones sin supervisión humana. Regulaciones emergentes, como la propuesta EU AI Act, clasifican aplicaciones de IA en ciberseguridad como de alto riesgo, exigiendo transparencia en modelos y auditorías. En contextos geopolíticos, tratados como el de Tallin Manual 2.0 extienden leyes de guerra a dominios cibernéticos, pero carecen de especificidad para IA.

Beneficios incluyen avances en ciberdefensa: Ucrania ha desarrollado herramientas de IA open-source para detección de amenazas, compartidas vía GitHub bajo licencias MIT. Sin embargo, riesgos de proliferación son altos, ya que herramientas de IA dual-use (civil-militar) pueden ser cooptadas por actores no estatales.

Conclusión

El surge de ciberataques impulsados por IA en Ucrania ilustra una nueva era en la guerra híbrida, donde la tecnología acelera tanto ofensivas como defensas. Los actores vinculados a Rusia, mediante grupos como Sandworm, han demostrado cómo la IA amplifica impactos en infraestructuras críticas, demandando innovaciones en detección y respuesta. Organizaciones globales deben priorizar inversiones en IA ética y colaborativa para mitigar estos riesgos, asegurando que la ciberseguridad evolucione al ritmo de las amenazas. Finalmente, la resiliencia depende de una integración holística de tecnologías, políticas y entrenamiento, transformando desafíos en oportunidades para fortalecer la soberanía digital.

Para más información, visita la fuente original.