Asociación Estratégica entre AMD y OpenAI: Avances en Infraestructura de Inteligencia Artificial

La reciente anuncio de una asociación estratégica entre Advanced Micro Devices (AMD) y OpenAI marca un hito significativo en el desarrollo de la infraestructura para la inteligencia artificial (IA). Esta colaboración busca optimizar el entrenamiento y la ejecución de modelos de IA generativa mediante la integración de aceleradores de hardware especializados de AMD en los centros de datos de OpenAI. En un contexto donde la demanda de cómputo de alto rendimiento para IA crece exponencialmente, esta alianza no solo fortalece la posición competitiva de AMD en el mercado de procesadores para IA, sino que también diversifica las opciones de hardware disponibles para una de las empresas líderes en el sector, reduciendo la dependencia de proveedores dominantes como NVIDIA.

Contexto Técnico de la Asociación

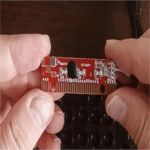

AMD, conocida por sus procesadores de propósito general y gráficos, ha invertido fuertemente en el desarrollo de unidades de procesamiento gráfico (GPU) optimizadas para cargas de trabajo de IA. La asociación con OpenAI se centra en el uso de los chips Instinct MI300X, una familia de aceleradores diseñados específicamente para tareas de machine learning y deep learning. Estos chips incorporan la arquitectura CDNA 3, que proporciona un rendimiento superior en operaciones de punto flotante de precisión mixta, esencial para el entrenamiento de modelos grandes como los de la serie GPT de OpenAI.

Los Instinct MI300X cuentan con hasta 192 GB de memoria HBM3 por GPU, lo que permite manejar datasets masivos sin cuellos de botella en la transferencia de datos. Esta capacidad es crítica en escenarios de IA generativa, donde los modelos requieren acceso rápido a terabytes de información durante el entrenamiento. Además, AMD soporta estas GPUs con su plataforma de software ROCm (Radeon Open Compute), un stack abierto que facilita la programación paralela y la optimización de algoritmos de IA. ROCm es compatible con frameworks populares como PyTorch y TensorFlow, lo que asegura una transición suave para desarrolladores que migran desde entornos basados en CUDA de NVIDIA.

Detalles Técnicos de los Aceleradores AMD Instinct

Para comprender la relevancia de esta integración, es necesario examinar las especificaciones técnicas de los chips involucrados. El AMD Instinct MI300X se basa en un diseño de chiplet modular, que combina múltiples núcleos de cómputo en un solo paquete. Cada GPU posee 304 unidades de cómputo, capaces de entregar hasta 2.1 PFLOPS en operaciones FP16, un estándar clave para el entrenamiento de redes neuronales. Esta arquitectura aprovecha la interconexión Infinity Fabric de AMD, que permite escalabilidad horizontal en clústeres de servidores, alcanzando configuraciones con miles de GPUs interconectadas mediante protocolos como RoCE (RDMA over Converged Ethernet) para minimizar la latencia.

En términos de eficiencia energética, los MI300X destacan por su consumo optimizado, con un TDP (Thermal Design Power) de alrededor de 750W por unidad, pero con un rendimiento por vatio superior en comparación con generaciones anteriores. Esto es particularmente importante para OpenAI, cuya infraestructura de IA consume cantidades masivas de energía. Estudios independientes, como los publicados por MLPerf, han demostrado que los sistemas basados en MI300X logran tiempos de entrenamiento reducidos en un 20-30% para benchmarks como BERT y ResNet en entornos multi-nodo.

La integración con OpenAI implica no solo el hardware, sino también colaboraciones en el nivel de software. AMD y OpenAI trabajarán en optimizaciones específicas para modelos de lenguaje grande (LLM), incluyendo técnicas de cuantización y pruning para reducir el footprint computacional sin sacrificar la precisión. Por ejemplo, el soporte para operaciones de baja precisión como FP8 en ROCm permite acelerar inferencias en tiempo real, crucial para aplicaciones como ChatGPT.

Implicaciones para el Ecosistema de IA

Esta asociación tiene ramificaciones profundas en el ecosistema de IA. Históricamente, NVIDIA ha dominado el mercado de GPUs para IA con su plataforma CUDA, que cuenta con una madurez superior y una comunidad extensa. Sin embargo, la apertura de AMD a través de ROCm representa una alternativa viable, promoviendo la diversidad en la cadena de suministro. Para OpenAI, esto mitiga riesgos de escasez de chips, como los experimentados durante la pandemia, y potencialmente reduce costos a largo plazo, ya que AMD ha prometido precios competitivos para volúmenes enterprise.

Desde una perspectiva operativa, la adopción de hardware AMD en los data centers de OpenAI requerirá actualizaciones en la infraestructura de red y almacenamiento. Protocolos como NVLink de NVIDIA serán reemplazados por equivalentes en AMD, como la interconexión XGMI (Infinity Fabric para GPUs), que soporta anchos de banda de hasta 1.5 TB/s entre GPUs adyacentes. Esto asegura que los clústeres de entrenamiento mantengan alta escalabilidad, permitiendo el procesamiento distribuido de modelos con miles de millones de parámetros.

En cuanto a riesgos, una transición a hardware mixto podría introducir desafíos en la portabilidad de código. Desarrolladores deberán adaptar bibliotecas para ROCm, aunque AMD ha invertido en herramientas de conversión automática como HIP (Heterogeneous-compute Interface for Portability), que mapea código CUDA a ROCm con mínima intervención manual. Benchmarks preliminares indican una compatibilidad del 90% para workloads estándar de IA.

Comparación con Otras Plataformas de Hardware para IA

Para contextualizar, es útil comparar los Instinct MI300X con competidores directos. La GPU NVIDIA H100, por ejemplo, ofrece 80 GB de HBM3 y 3.0 PFLOPS en FP16, superando ligeramente al MI300X en rendimiento bruto. Sin embargo, AMD compensa con mayor capacidad de memoria, ideal para modelos que superan los 100B parámetros, como GPT-4. En términos de costo, estimaciones del mercado sugieren que un nodo MI300X podría costar un 20-30% menos que su contraparte NVIDIA, haciendo atractiva la opción para despliegues a gran escala.

Otras alternativas, como los TPUs de Google o los chips de Intel Habana, también compiten, pero la asociación con OpenAI posiciona a AMD como un jugador clave en IA generativa. Intel, por instancia, enfoca en Gaudi3 con énfasis en eficiencia para inferencia, pero carece del ecosistema maduro de AMD en gráficos de alto rendimiento.

| Característica | AMD Instinct MI300X | NVIDIA H100 | Intel Gaudi3 |

|---|---|---|---|

| Memoria HBM | 192 GB HBM3 | 80 GB HBM3 | 128 GB HBM2e |

| Rendimiento FP16 (PFLOPS) | 2.1 | 3.0 | 1.8 |

| Interconexión | Infinity Fabric / XGMI | NVLink | Ethernet / Ethernet |

| Software Stack | ROCm | CUDA | Habana SynapseAI |

Esta tabla ilustra las fortalezas relativas: AMD excelsa en memoria y escalabilidad de bajo costo, mientras NVIDIA prioriza rendimiento pico.

Aspectos Regulatorios y de Sostenibilidad

La expansión de la IA conlleva consideraciones regulatorias. En la Unión Europea, el AI Act clasifica modelos como los de OpenAI como de alto riesgo, exigiendo transparencia en el hardware subyacente. Esta asociación podría facilitar el cumplimiento mediante auditorías en la cadena de suministro de AMD, que adhiere a estándares como ISO 26262 para seguridad en sistemas críticos.

En sostenibilidad, los data centers de IA contribuyen significativamente a las emisiones de CO2. AMD promueve diseños eficientes, y OpenAI ha comprometido metas de carbono neutral. La integración de MI300X podría reducir el consumo energético global en un 15% para workloads similares, según simulaciones de AMD, alineándose con directrices de la ONU para computación verde.

Beneficios Operativos para OpenAI

Para OpenAI, los beneficios son multifacéticos. Primero, diversificación reduce vulnerabilidades geopolíticas, especialmente con tensiones en el suministro de semiconductores. Segundo, el rendimiento de MI300X acelera el ciclo de desarrollo de modelos, permitiendo iteraciones más rápidas en IA multimodal. Tercero, la colaboración fomenta innovaciones en software, como extensiones a la API de OpenAI para optimizaciones AMD-specific.

- Escalabilidad: Soporte para clústeres de exaescala, integrando con sistemas de orquestación como Kubernetes y Slurm.

- Seguridad: Chips AMD incluyen características como Secure Encrypted Virtualization (SEV) para proteger datos en tránsito durante entrenamiento distribuido.

- Innovación: Posibilidad de co-desarrollo de chips personalizados, similar a las ASICs de Google, pero con flexibilidad de GPU.

Desafíos Técnicos en la Implementación

A pesar de los avances, la implementación presenta desafíos. La madurez de ROCm, aunque mejorada en la versión 6.0, aún enfrenta bugs en workloads edge cases comparado con CUDA 12.x. OpenAI deberá invertir en testing exhaustivo para asegurar estabilidad en producción. Además, la latencia en inferencia para aplicaciones en tiempo real, como asistentes virtuales, requerirá tuning fino de kernels en HIP.

Otro aspecto es la interoperabilidad con hardware existente. OpenAI opera clústeres híbridos; migrar selectivamente a AMD mientras mantiene NVIDIA exige middleware como ONNX para portabilidad de modelos. Pruebas de rendimiento en entornos mixtos serán esenciales para evitar degradaciones.

Perspectivas Futuras y Evolución del Mercado

Mirando hacia el futuro, esta asociación podría catalizar más alianzas en IA. AMD planea la serie MI400 para 2025, con mejoras en memoria 3D y eficiencia cuántica, potencialmente integrándose en roadmaps de OpenAI. El mercado de IA hardware, valorado en 50 mil millones de dólares en 2023, se proyecta crecer a 200 mil millones para 2030, según Gartner, con AMD capturando una cuota del 20% gracias a partnerships como este.

En blockchain y tecnologías emergentes, aunque no directo, la IA optimizada en AMD podría habilitar aplicaciones como verificación de transacciones en redes distribuidas, combinando cómputo de IA con consenso proof-of-stake. Para ciberseguridad, modelos de detección de amenazas basados en LLM entrenados en hardware eficiente acelerarán respuestas a incidentes.

Conclusión

En resumen, la asociación estratégica entre AMD y OpenAI representa un paso pivotal hacia una infraestructura de IA más diversa y eficiente. Al integrar los avanzados aceleradores Instinct MI300X, OpenAI no solo potencia sus capacidades de entrenamiento y ejecución de modelos generativos, sino que también contribuye a un ecosistema más resiliente. Esta colaboración subraya la importancia de la innovación en hardware para el avance de la IA, prometiendo beneficios en rendimiento, costo y sostenibilidad. Para más información, visita la Fuente original.